神奇贴纸骗过AI!人类被“隐形”,智能监控的危机来了?

转自 心缘 智东西

看点:AI被骗?解密神奇贴纸背后的算法,如何让人类躲过智能监控。

智东西4月24日消息,摄像头用AI识别图像和视频中的人脸和身体正变得越来越常见,小到超市、办公室,大到自动驾驶、智慧城市,能够快速抓取人体、识别人脸的智能摄像头正变得无处不在。

不过,最近,一组研究团队设计了一张特别的彩色图案,只要你将这块40cmx40cm的神奇贴纸挂在身上,就可以避开AI摄像头的监控。

这个团队来自比利时鲁汶大学(Katholieke Universiteit Leuven),他们发表了一篇论文,名为《欺骗自动监控摄像头:针对攻击人类监控的对抗补丁(Fooling automated surveillance cameras: adversarial patches to attack person detection)》。

论文上署名的三位研究人员Simen Thys、Wiebe Van Ranst和Toon Goedeme使用了流行的YOLOv2开源对象识别探测器进行了演示,他们通过用一些技巧成功骗过了探测器。

论文链接:https://arxiv.org/pdf/1904.08653.pdf

他们已经在论文中公布了源代码:

https://gitlab.com/EAVISE/adversarial-yolo。

宛如“隐形斗篷”的神器贴纸

我们先来看看这个研究小组究竟做了个什么东西。

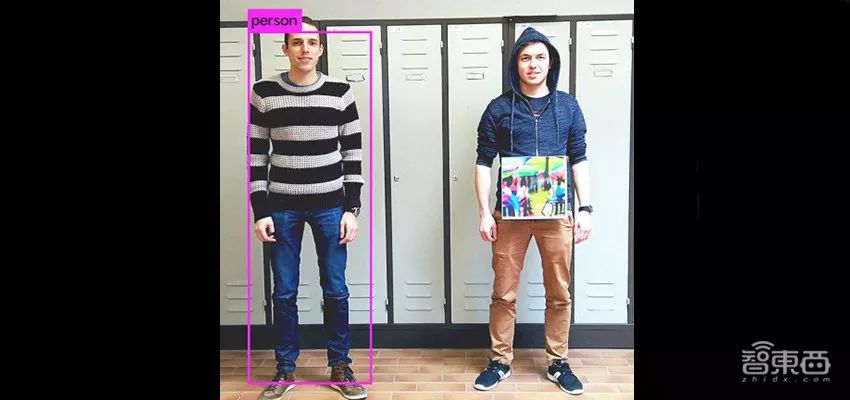

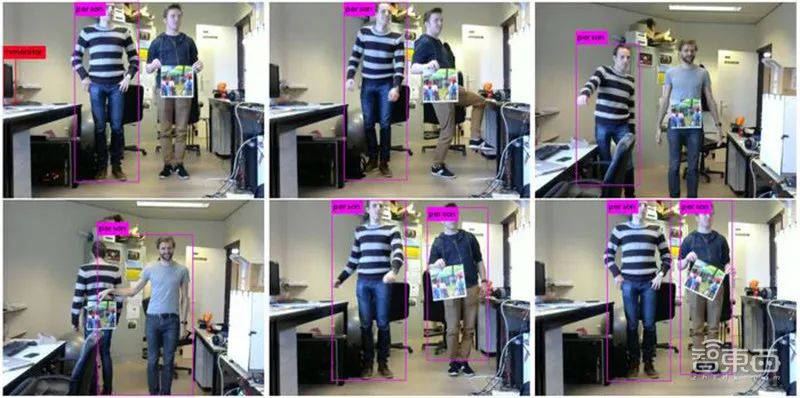

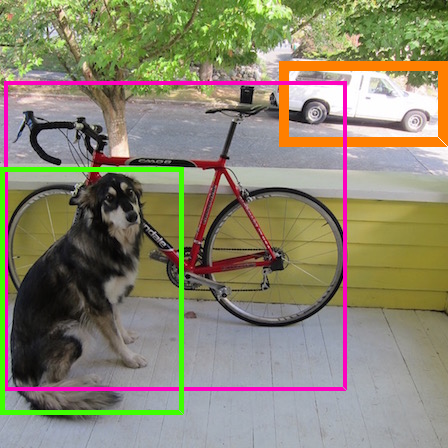

如图,右边的人身上挂了一块彩色贴纸,这张贴纸成功欺骗了AI系统,使他即便正面摄像头,也没有像左边的人那样被AI系统检测出来(粉色框)。

右边的人将贴纸反转过来,立即被检测出。

等右边的人将贴纸交给左边的人后,AI瞬间就检测不出左边的人。

研究人员指出,该技术可用于“恶意绕过监视系统”,允许入侵者“通过在他们的身体前面拿着一块小纸板朝向监控摄像头做些偷偷摸摸的行为(而不被发现)”。

据外媒报道,论文作者之一Van Ranst透露,采用现成的视频监控系统来解决这个问题应该不会太难。“目前我们还需要知道哪个探测器正在使用中。我们今后想要做的是生成一个同时适用于多个探测器的补丁”,“如果这样有效,那么补丁也可能对监控系统中使用的探测器起作用。”

▲贴片的角度和位置对AI检测人的能力有所不同

该小组现在正计划将补丁应用于服装。

好比著名的威廉·吉布森(William Gibson)科幻小说《零历史(Zero History)》所描述的情节,研究人员写道:“我们相信,如果我们将这种技术与精致的服装模拟结合起来,我们就可以设计出一种T恤印花,可以让一个人对自动监控相机几乎不可见。”

未来他们的工作将侧重于使补丁更加健壮和可迁移,因为它们不能很好地适用于不同的检测架构,如Faster R-CNN 。

“对抗补丁”是怎样炼成的?

这项研究的核心目的是创造一个系统,能够生成可打印的对抗补丁,用于“愚弄”人类探测器。

研究人员写道:“我们通过优化图像来实现这一目标,以最大限度地减少与探测器输出中人物外观相关的不同概率。在我们的实验中,我们比较了不同的方法,发现最小化对象丢失创造了最有效的补丁。”

然后他们打印出经过优化的补丁,并通过拍摄持有他们的人来测试它们。

研究人员发现,只要定位正确,补丁就能很好地工作。

“根据我们的结果,我们可以看到我们的系统能够显著降低人体探测器的准确性……在大多数情况下,我们的补丁能够成功地将人员隐藏在探测器之外。在不是这种情况下,补丁与人的中心不对齐。”研究人员说。

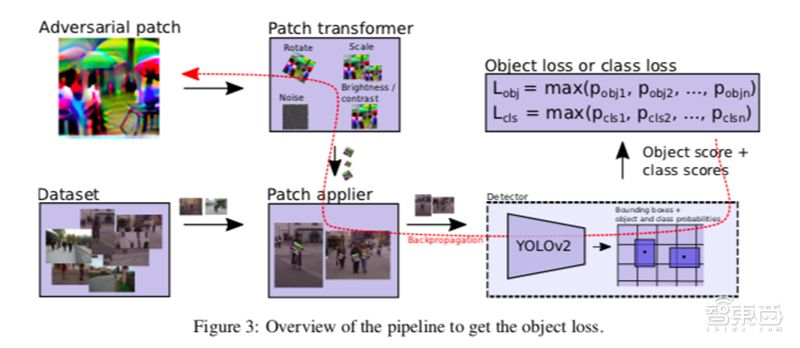

优化器的目标就是最小化总损失函数L。具体优化目标包括三个损失函数:Lnps(非可打印性得分)、Ltv(图像总变化)、Lobj(图像中的最大对象分数)。

Lnps代表贴纸中的颜色在多大程度上可由普通打印机打印出来;

Ltv确保优化器支持平滑颜色过渡的图像并防止图像噪声;

Lobj用于对探测器输出的目标或类别分数实现最小化。

上述三个损失函数相加即可得到总损失函数:

YOLOv2探测器输出一个单元网格,每个单元格包含一系列锚点,每个锚点包含边界框的位置、对象概率和类别得分。

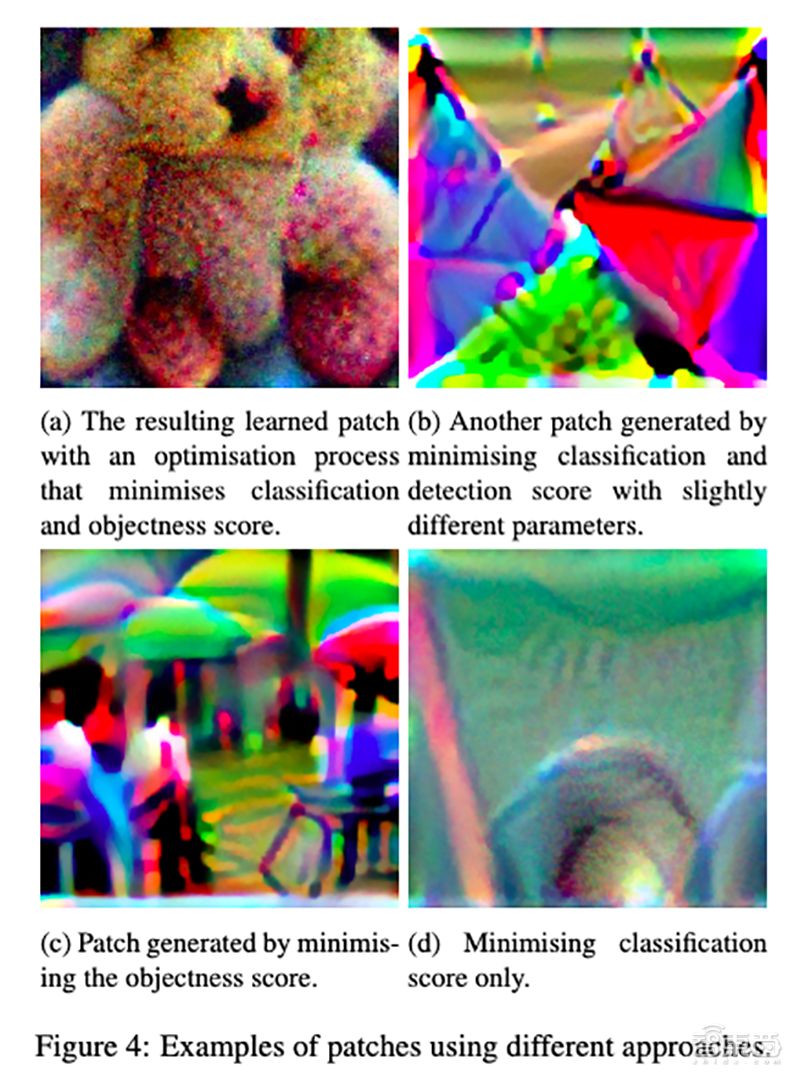

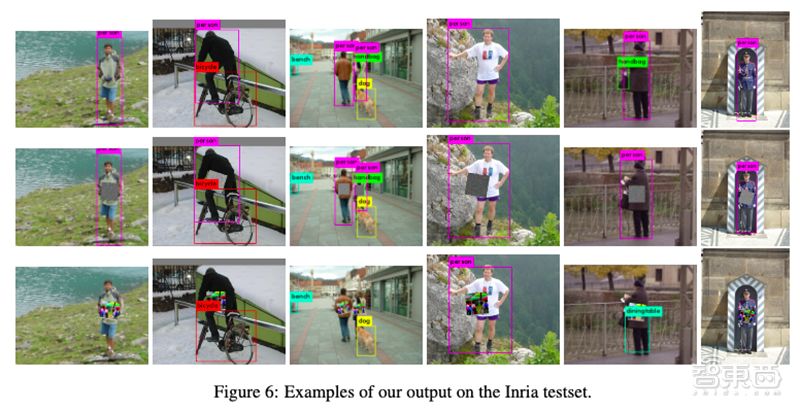

为了让探测器忽略图像中的人,研究人员使用MS COCO数据集进行训练,尝试了三种不同的方法:最小化类人的分类得分(图4d),最小化对象得分(图4c),或两者的组合(图4b和4a)。

其中,第一种方法可能致使生成的补丁被检测成COCO数据集的另一个类,第二种方法不存在这一问题,但生成贴纸针对某个类的特定性比其他方法低。

通过对各类“补丁”做实验,最后研究人员发现,经过多次图像处理的随机物体的照片效果最好,他们尝试了多种随机转换,包括图像旋转、随机放大和缩小、随机添加随机噪声、随机修改正确率和对比度等处理。

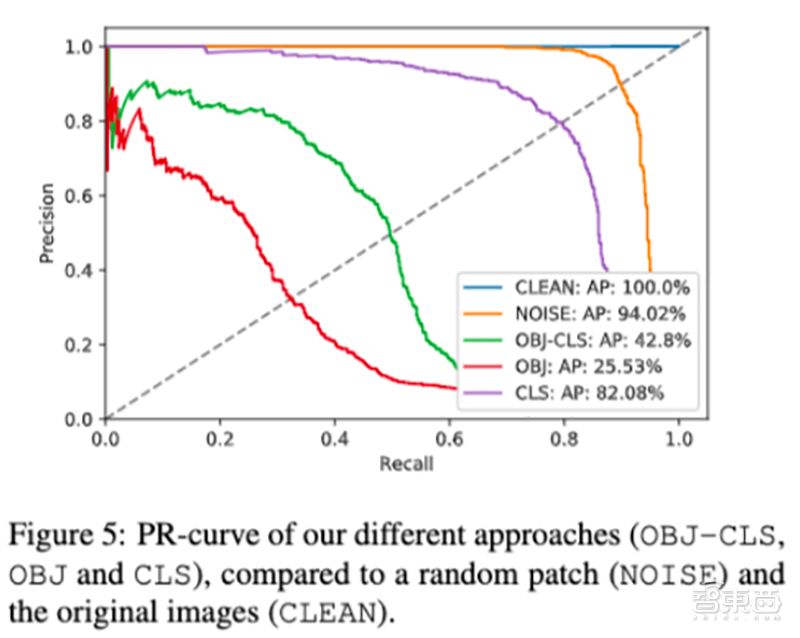

最终,研究人员将获得的几个补丁和NOISE(随机添加噪声)、CLEAN(无补丁baseline)一起放在Inria测试集上做评估,重点评估这些补丁能避开多少监控系统产生的警报。

结果表明,OBJ补丁触发的警报数量最低(25.53%)。

不同补丁的测试效果对比如下:

第1行没有补丁,第2行使用随机补丁,第3行使用最佳补丁,效果很明显,最佳补丁在多数情况下能成功让人类躲过AI的检测。

不过,这个补丁并不是完美的,效果不好时可能是因为它没和人对齐。

对抗攻击并非新鲜事

随着AI的快速发展,视频监控、自动驾驶、无人机和机器人、语音识别、文本筛查等多个AI细分领域都涉及到了越来越多的安全问题。

精确度日益增长的深度学习网络,被发现极容易受到对抗攻击的影响。

比如向原图像添加一点精心设计的干扰,就有可能会使得一个分类模型做出错误的判断,致使它将被修改后的图像标注为完全不同的其他物体。

基于这一背景,越来越多的研究人员正在对真实世界的对抗攻击感兴趣。

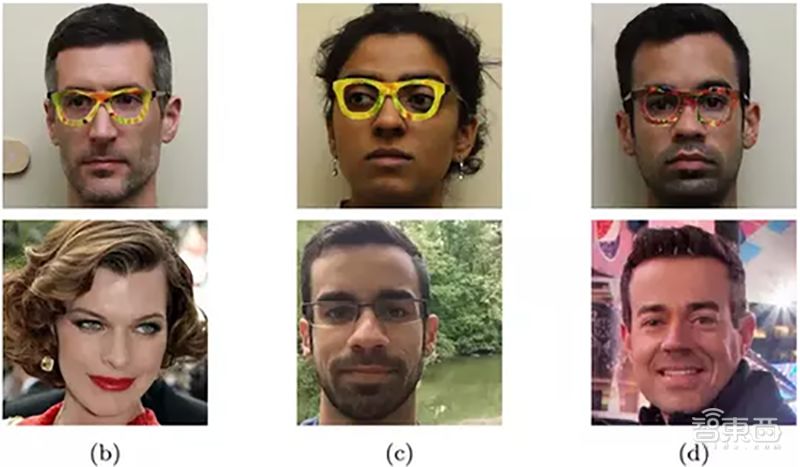

2016年11月,来自卡内基梅隆大学和北卡罗来纳大学的研究人员展示了如何使用一对打印的眼镜架来击败面部识别系统。

研究人员称:“当它的图像提供给一个国家的最先进的面部识别算法的攻击者戴,眼镜让她逃避被认可或假冒他人”。

据称,戴上镜框后识别错误率高达100%,坏人可以利用这种识别漏洞躲过软件的检测,进而轻易伪装成他人,成功用面部识别完成设备解锁。

▲上面为真人,下面为系统识别出的人

2017年10月,日本九州大学的Su Jiawei等人提出了黑箱DNN攻击,通过使用差分进化(differential evolution)扰乱少数像素(1024个像素中只扰乱1、3、5个像素)的方式,只需修改图片中的几个像素,即可让深度神经网络完全判断错误。

2018年,伯克利人工智能研究实验室(BAIR))演示了针对 YOLO 检测器的实体对抗样本,同样采用贴纸扰动的形式,在“STOP”路标上粘贴了一些精心设计过的贴纸。

结果YOLO 网络在几乎所有帧中都无法感知识别出「停止」标志。同样,其为 YOLO 检测器生成的实体对抗样本也可以骗过标准的 Faster-RCNN。

我们可以想象一下,假使一辆在道路上行驶的自动驾驶汽车,看见被贴了这样贴纸的路标,一旦它被贴纸误导,没看懂路标,就有可能发生难以挽回的交通惨案。

结语:最优防御策略还在探索中

长期以来,对抗攻击一直是机器学习领域有趣又非常重要的课题。

如今AI逐渐大面积应用于日常监控摄像头和软件中,出现在零售、工作空间、社区、交通等诸多场景。

而对抗样本有可能会钻神经网络的漏洞,比如使得一些小偷可以避开监控摄像头在无人商店自由偷东西,或者使得入侵者成功进入某栋建筑。

当前,研究人员们还远未找到针对这些对抗样本的最优防御策略,我们不妨期待对这一激动人心的研究领域会在不久之后出现突破性的进展。

本账号系网易新闻·网易号“各有态度”签约帐号