Google DeepMind最新报告—深度神经网络压缩进展(附PPT下载)

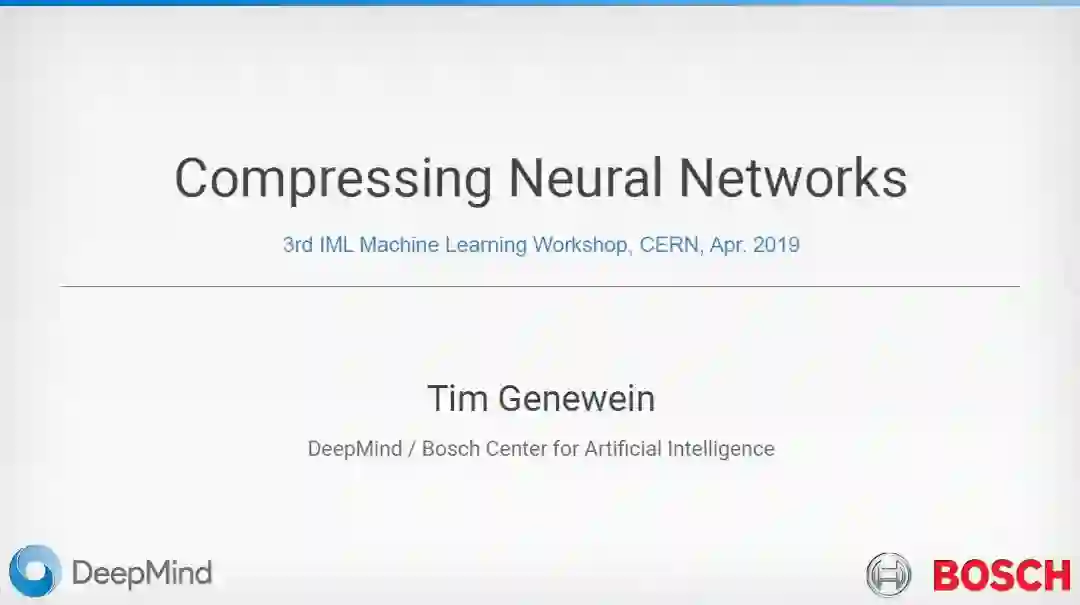

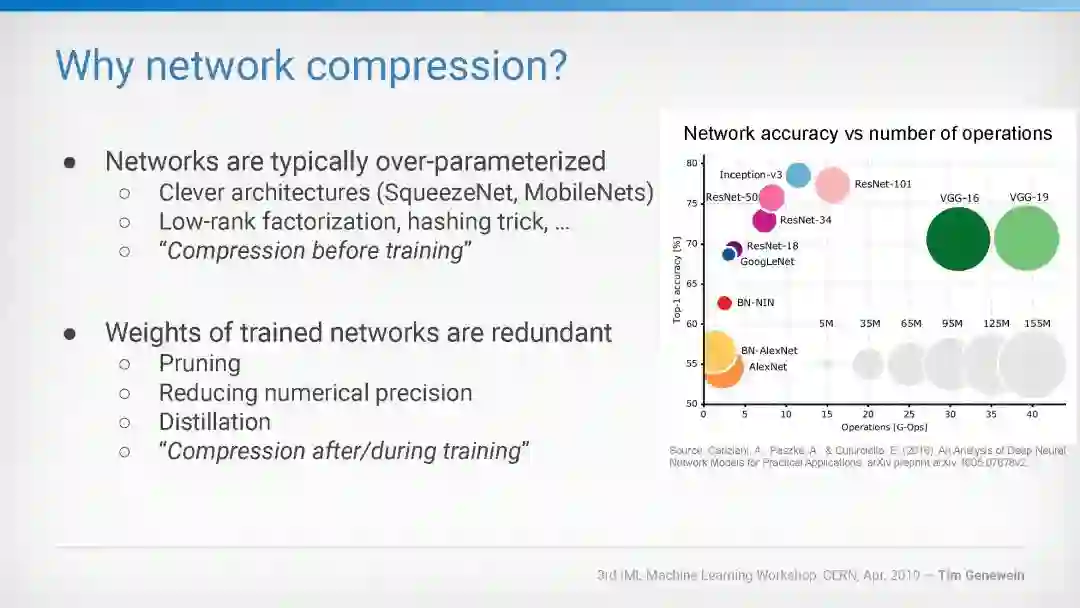

【导读】在人工智能领域,近几年来,深度神经网络的性能获得大幅度提升,同时网络的存储和计算复杂度也随之增长。如何对深度神经网络进行加速与压缩,提高深度神经网络的运行效率,成为深度学习领域的研究热点。针对该问题,在学术界和工业界共同的努力下,一系列的方法被相继提出。但该领域中仍存在着很多急需解决的关键问题,本文为大家带来了Google DeepMind 的最新报告,概述了神经网络压缩方法的研究现状和最新的一些压缩方法。

介绍:

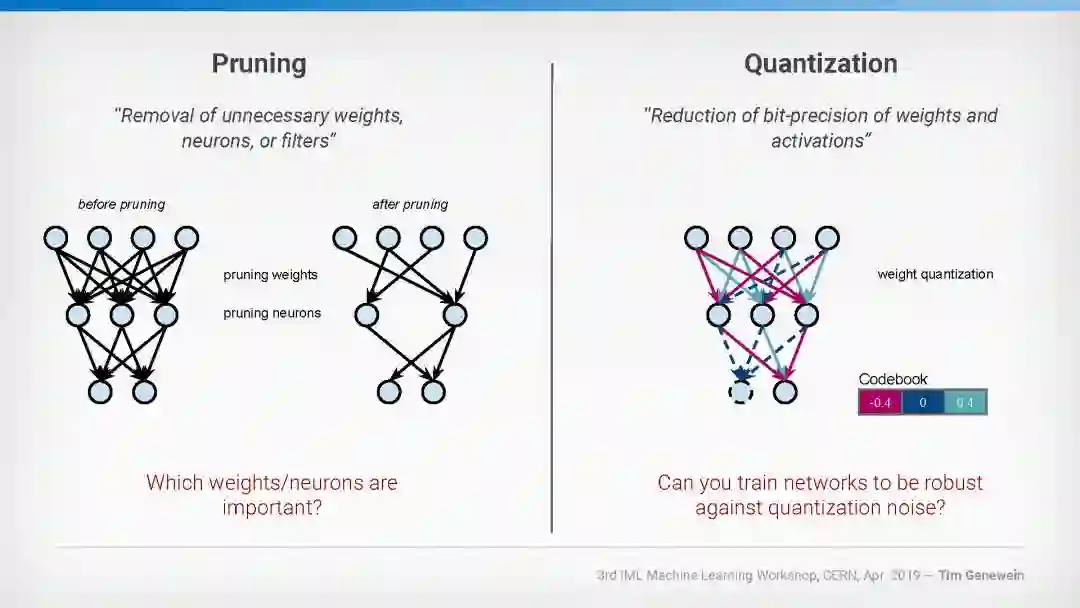

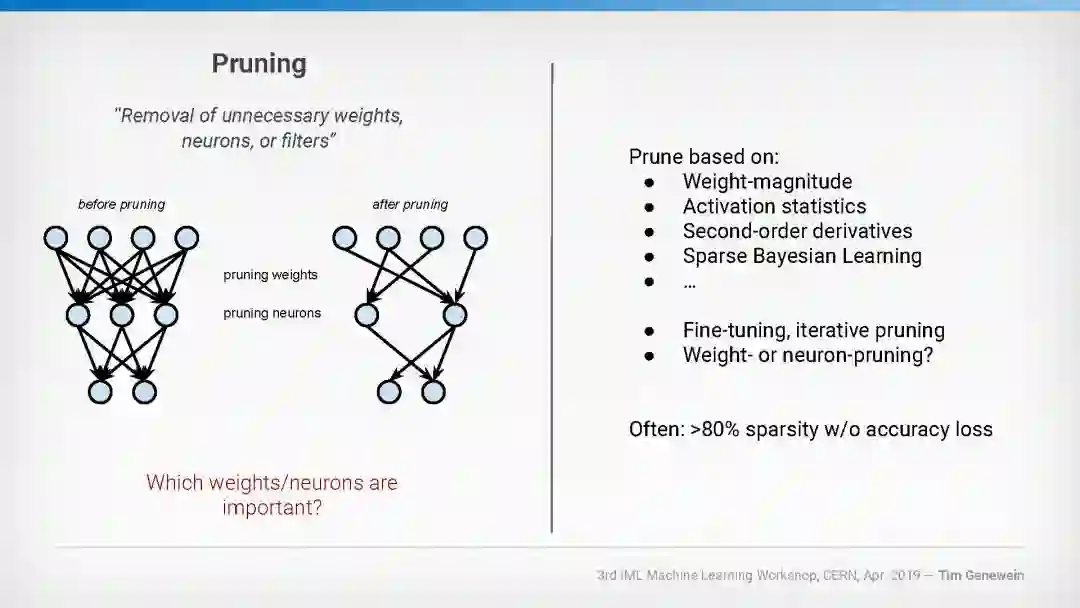

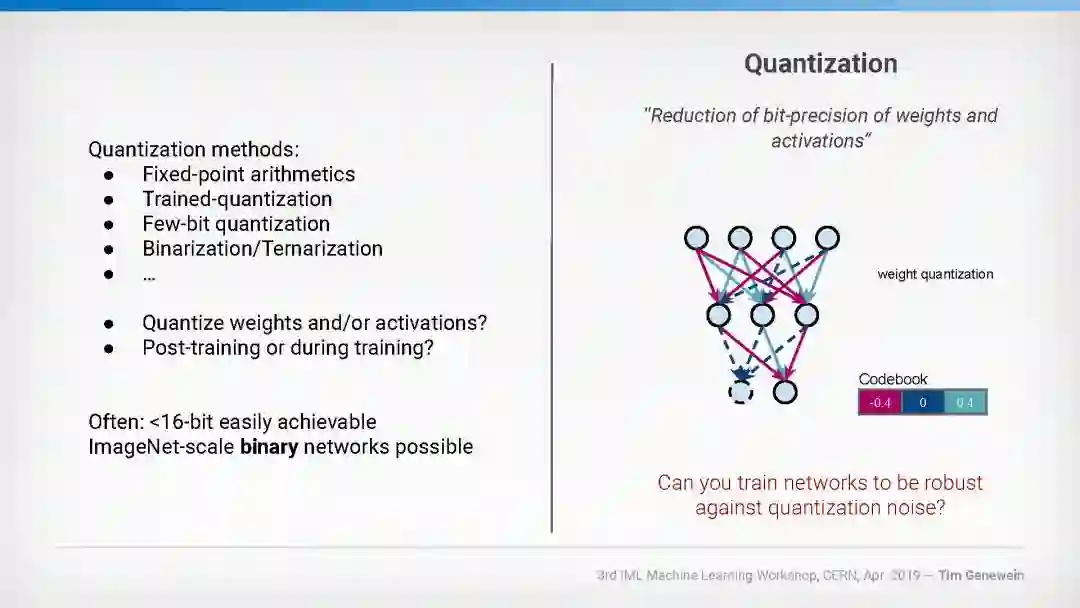

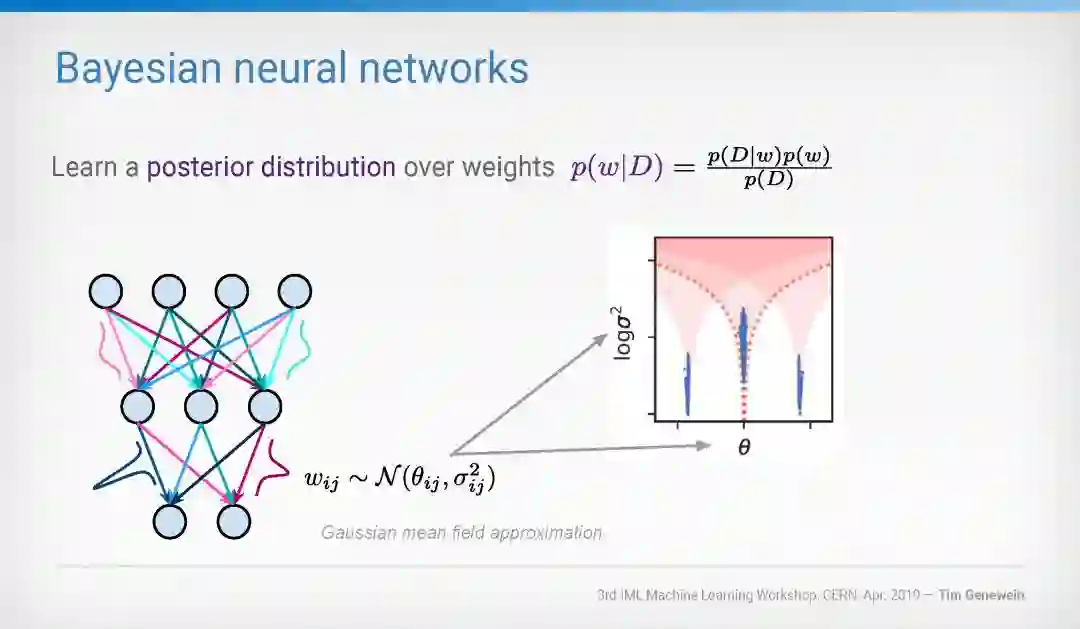

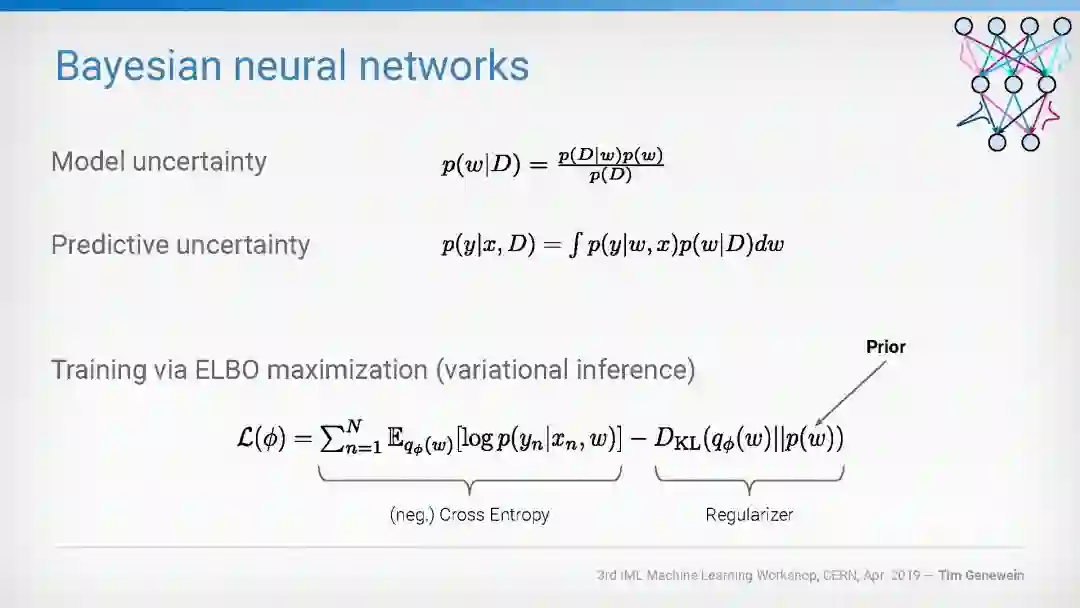

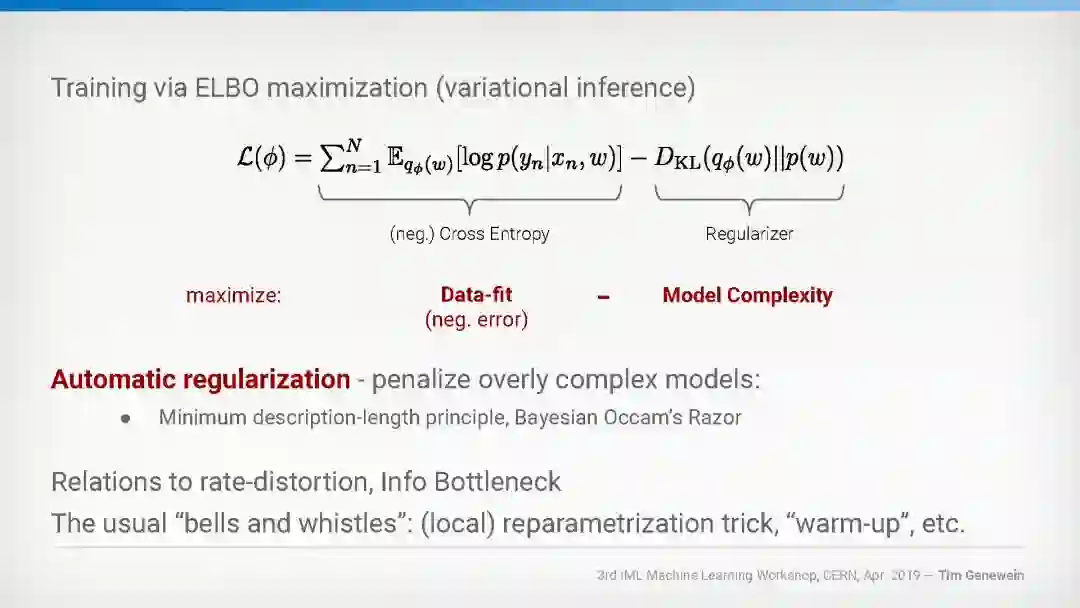

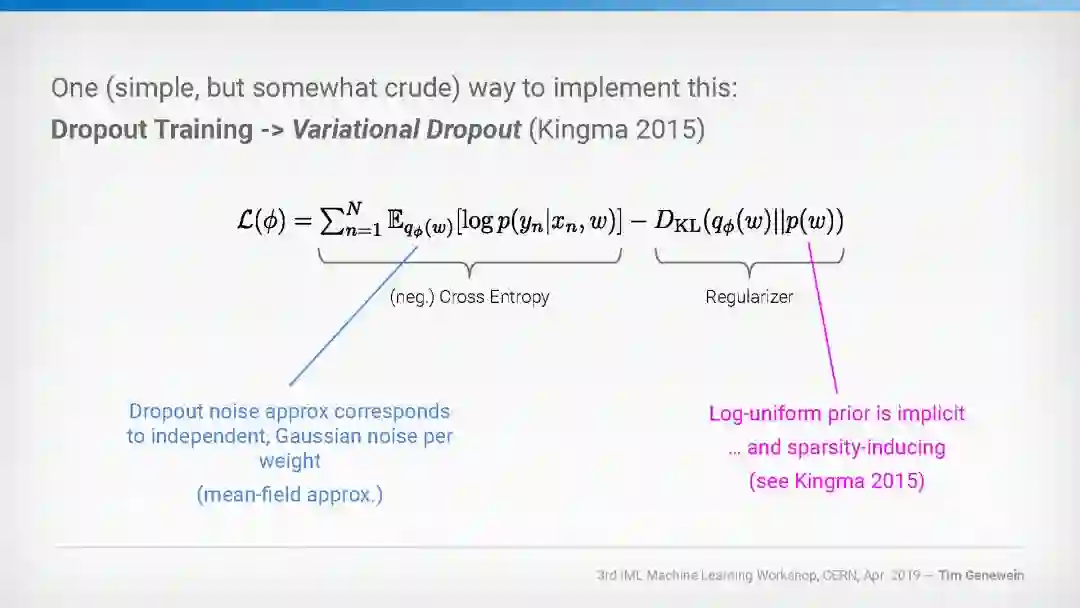

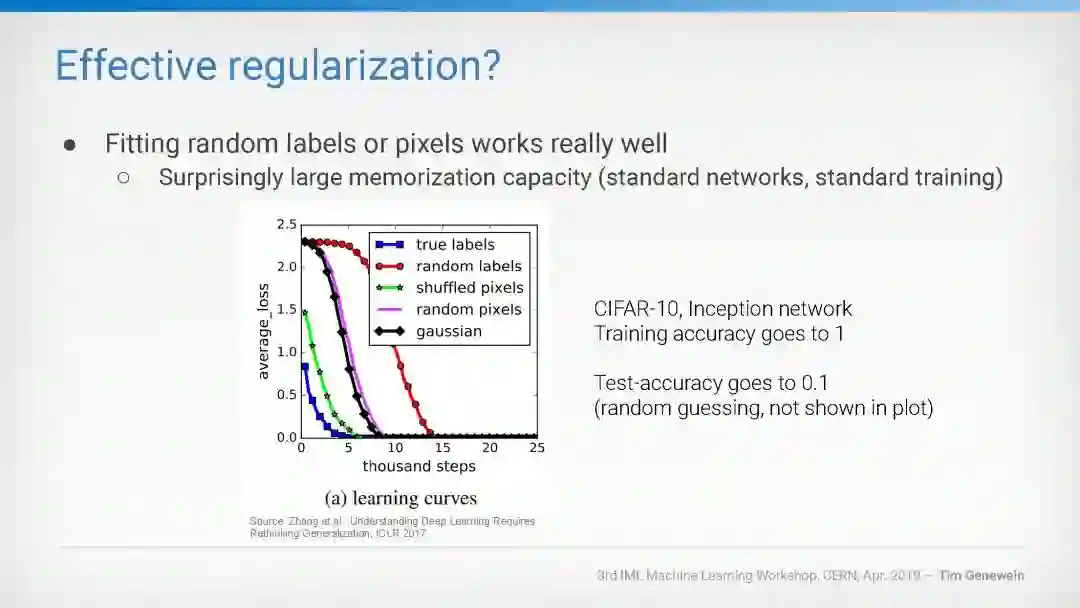

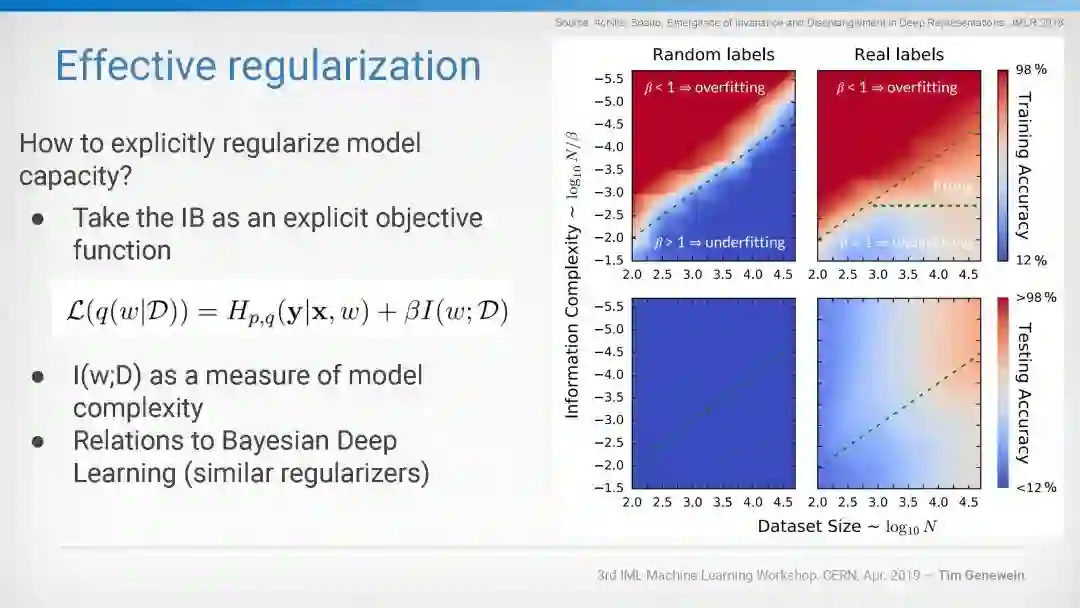

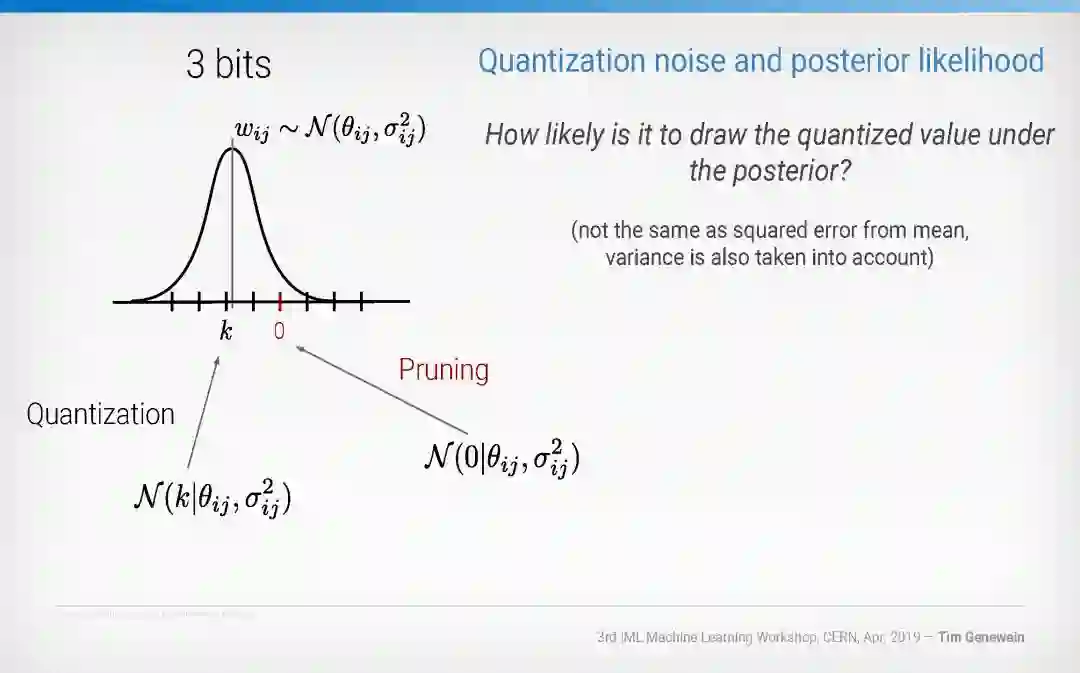

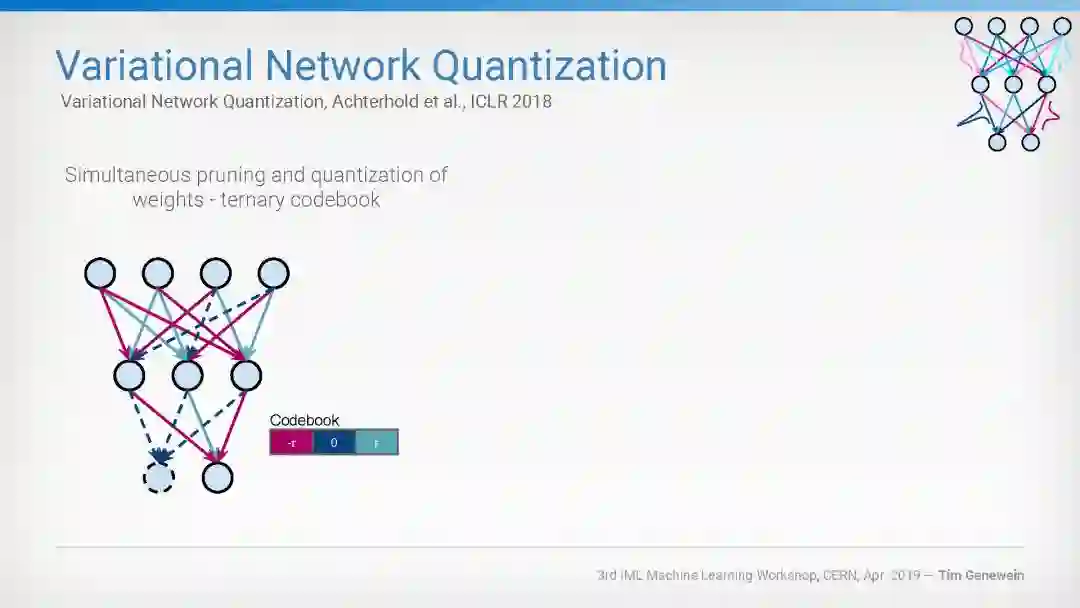

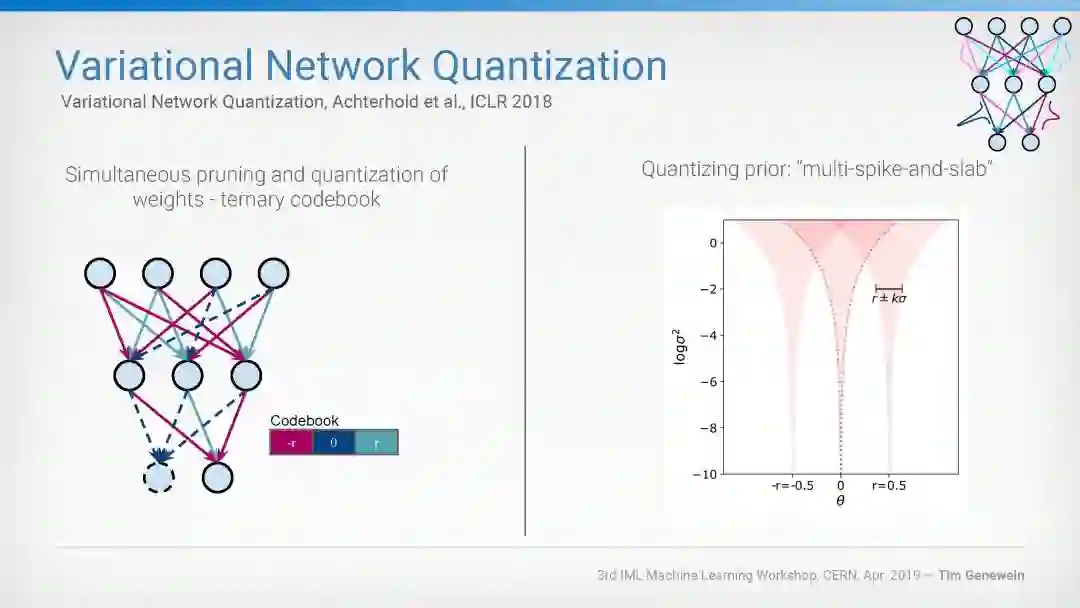

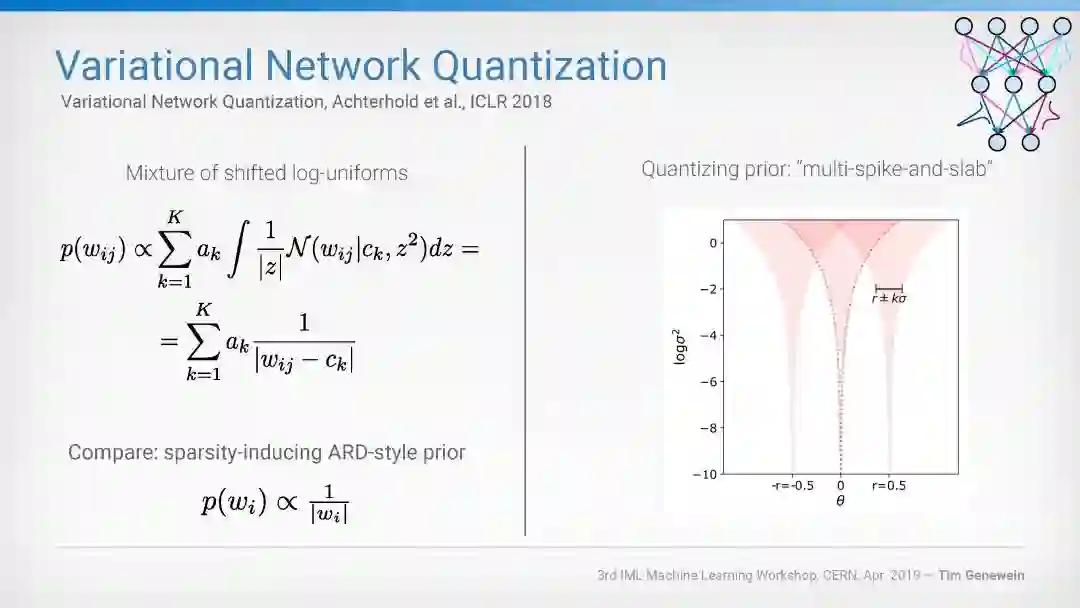

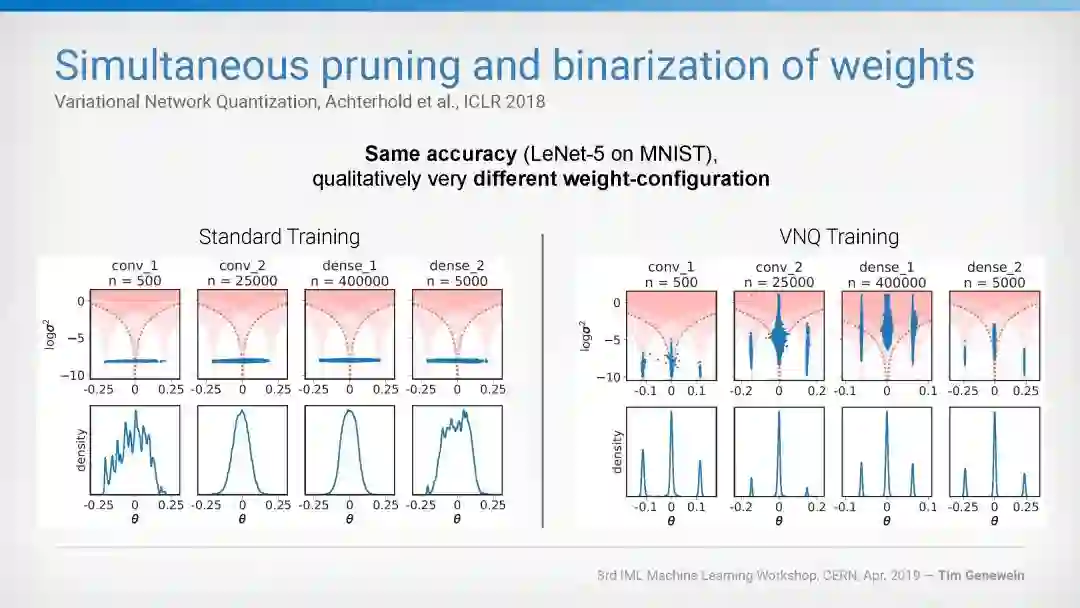

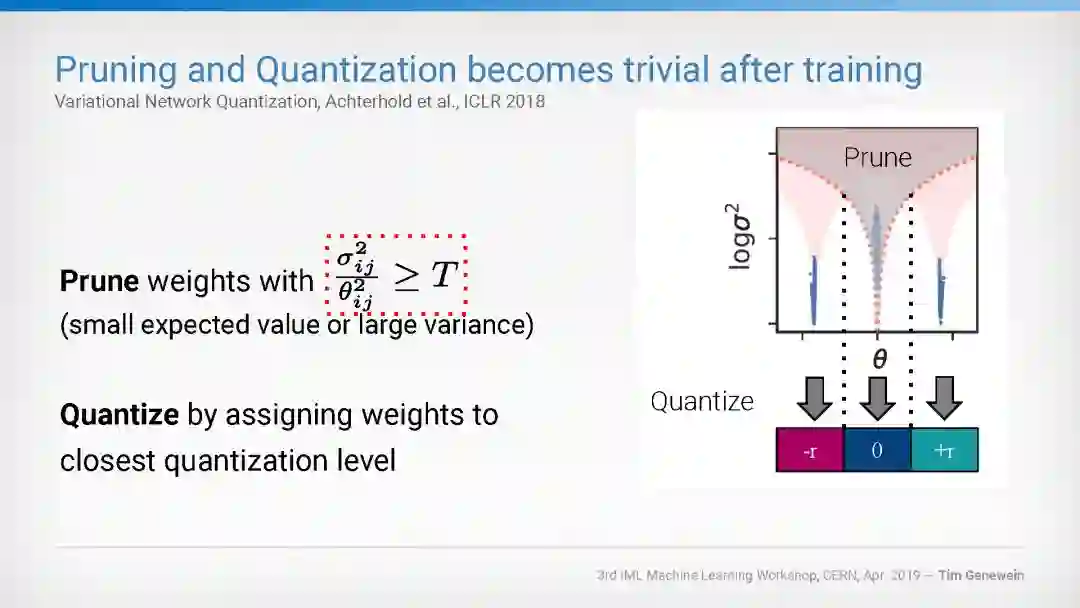

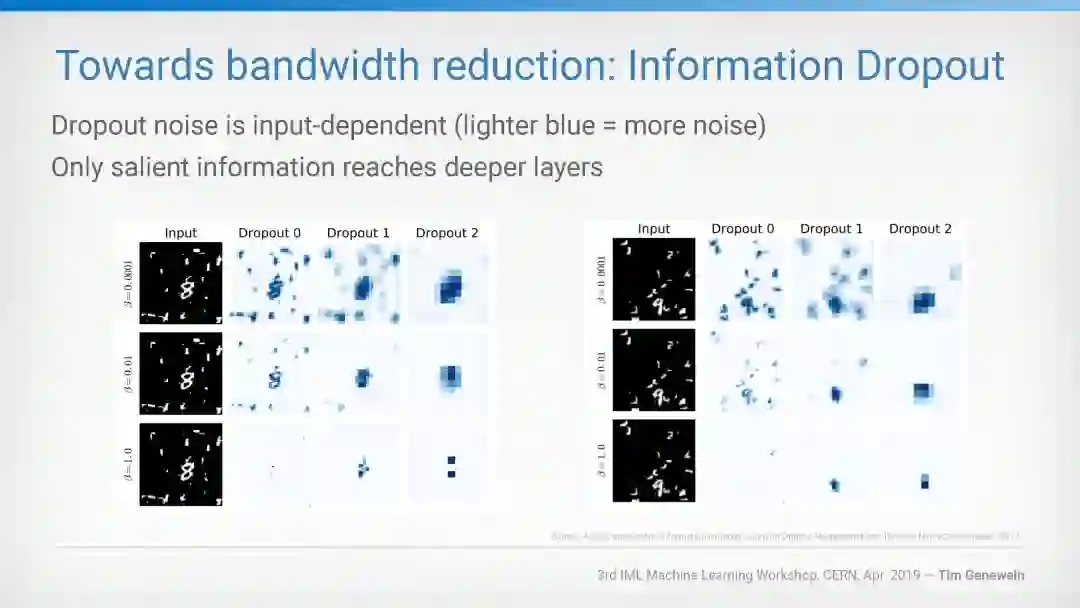

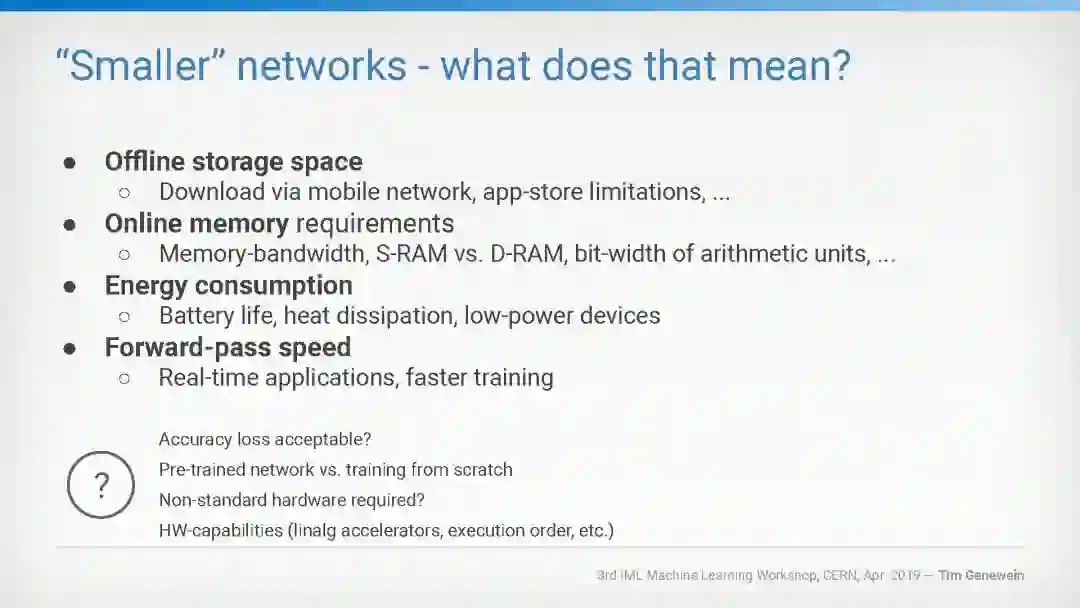

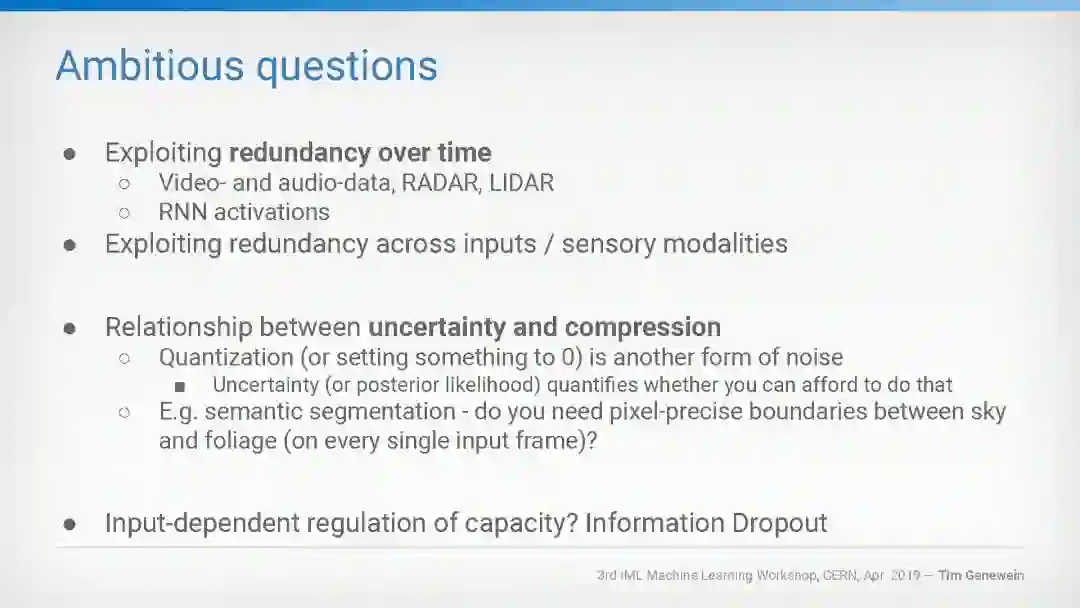

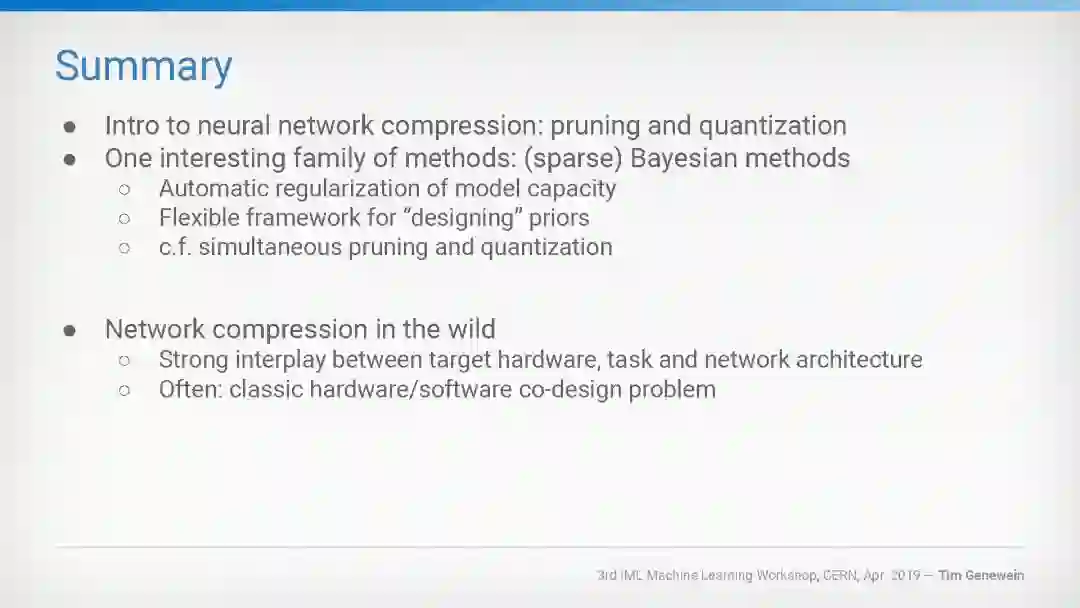

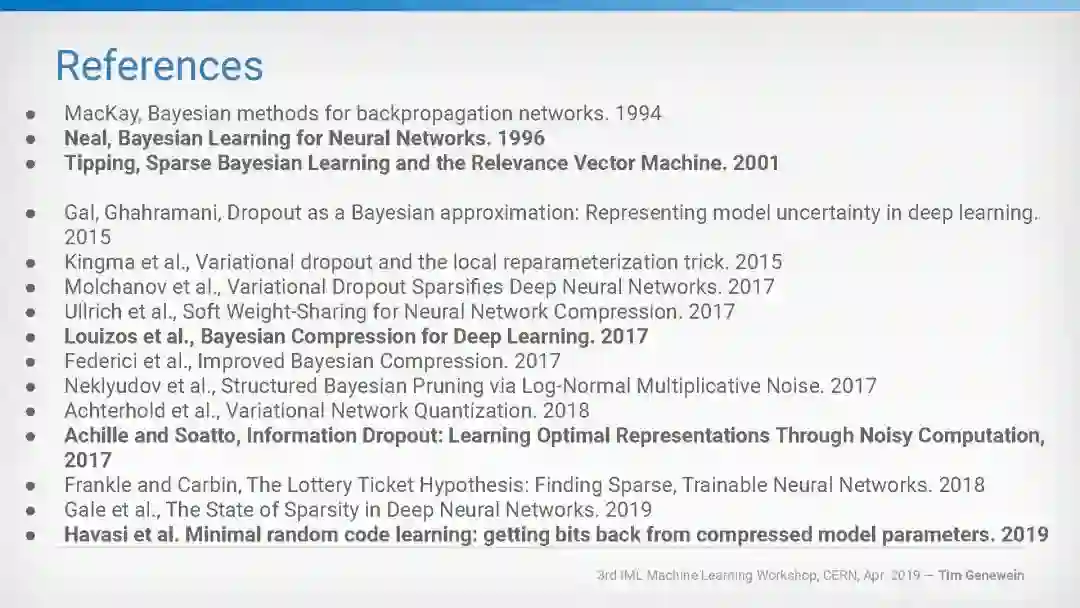

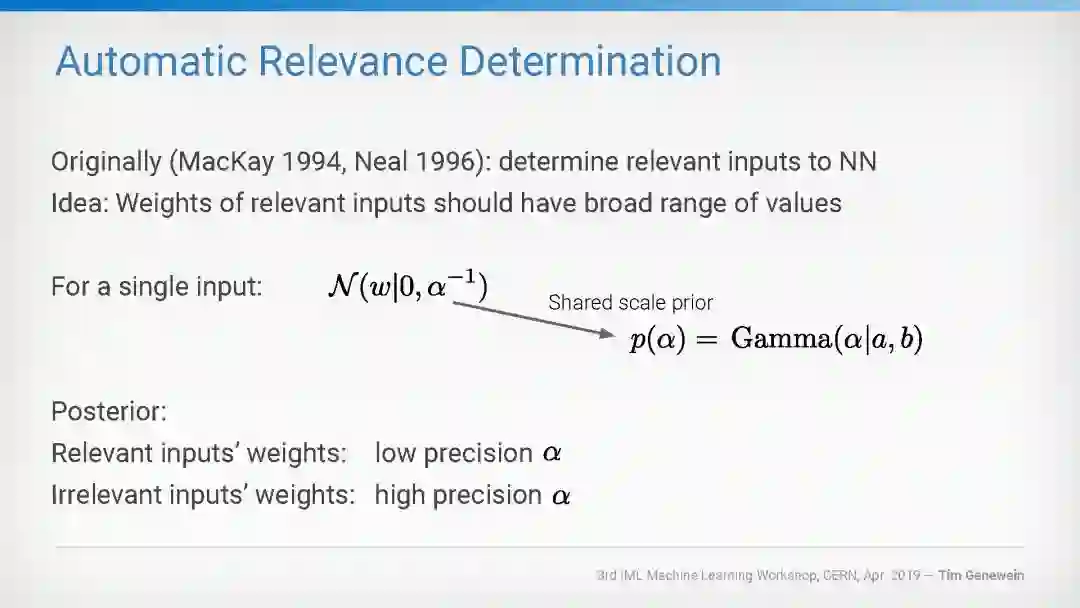

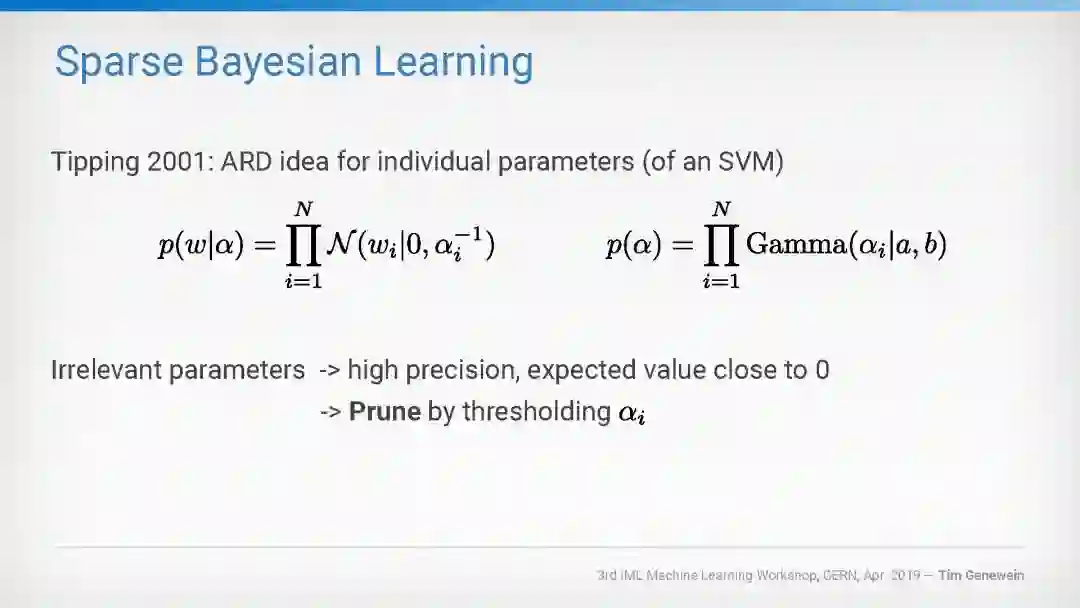

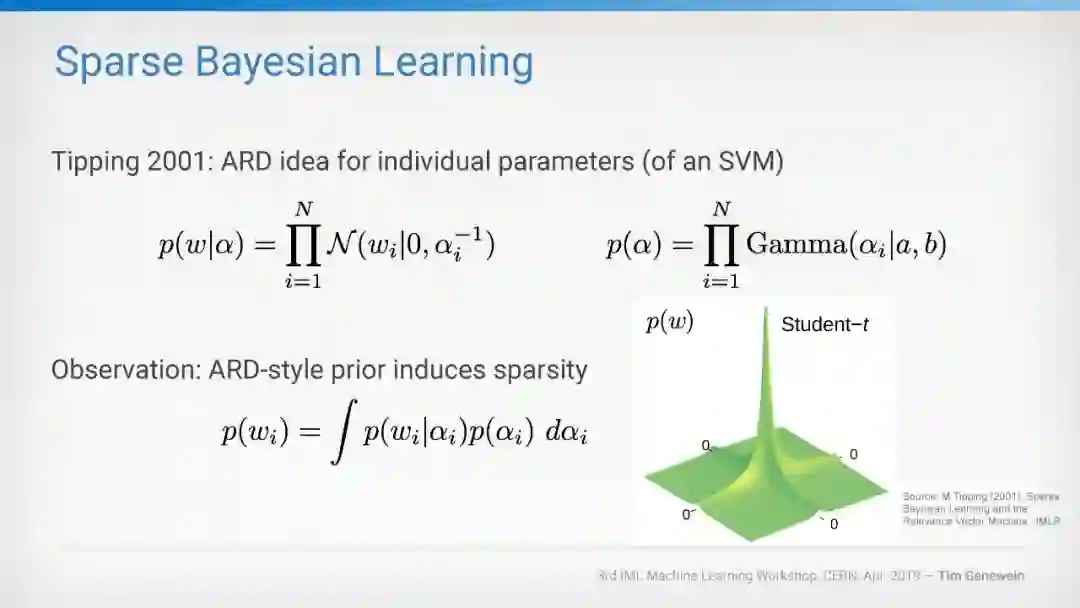

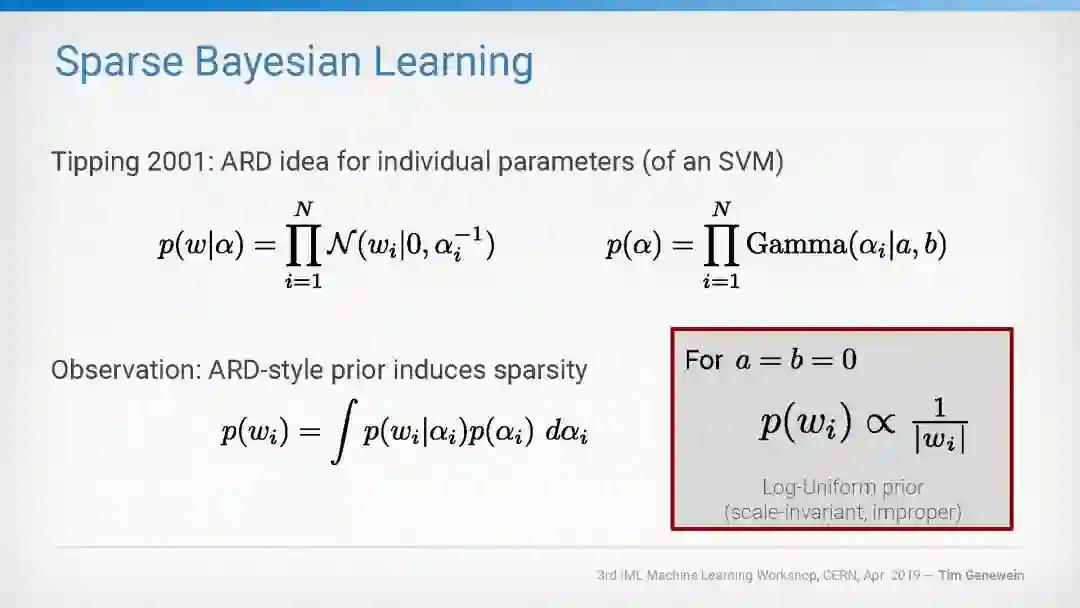

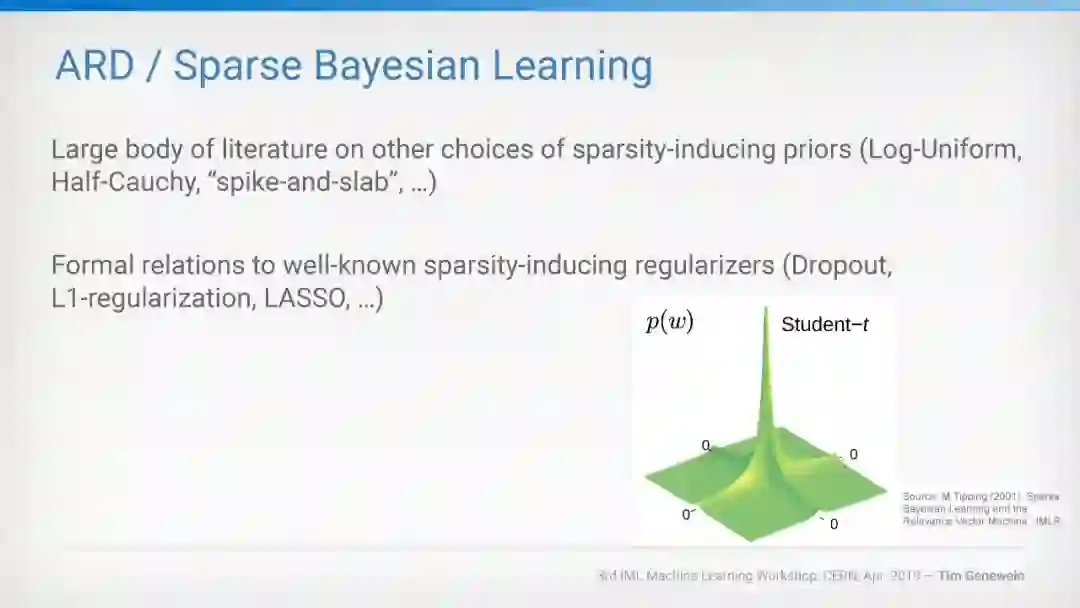

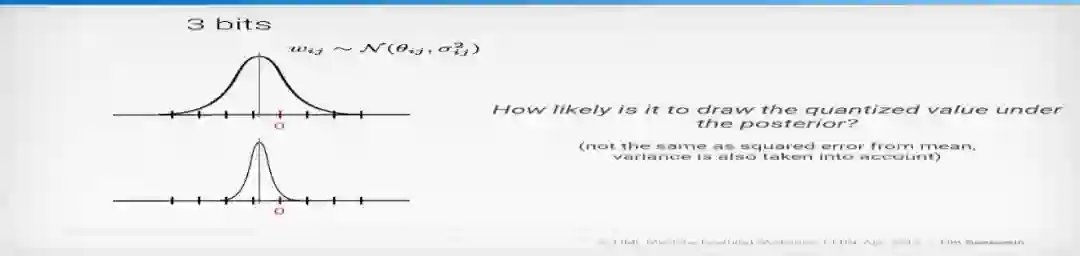

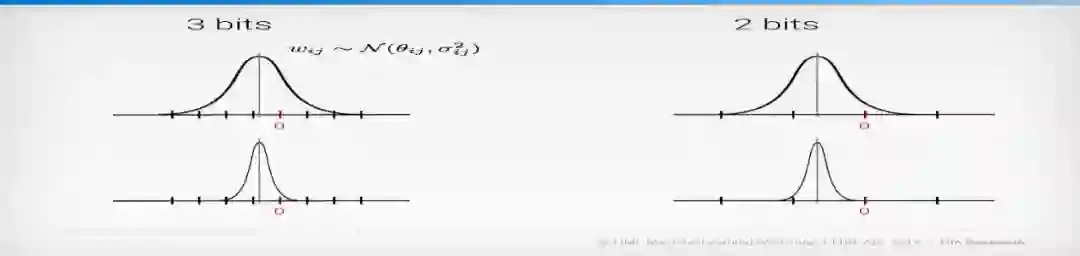

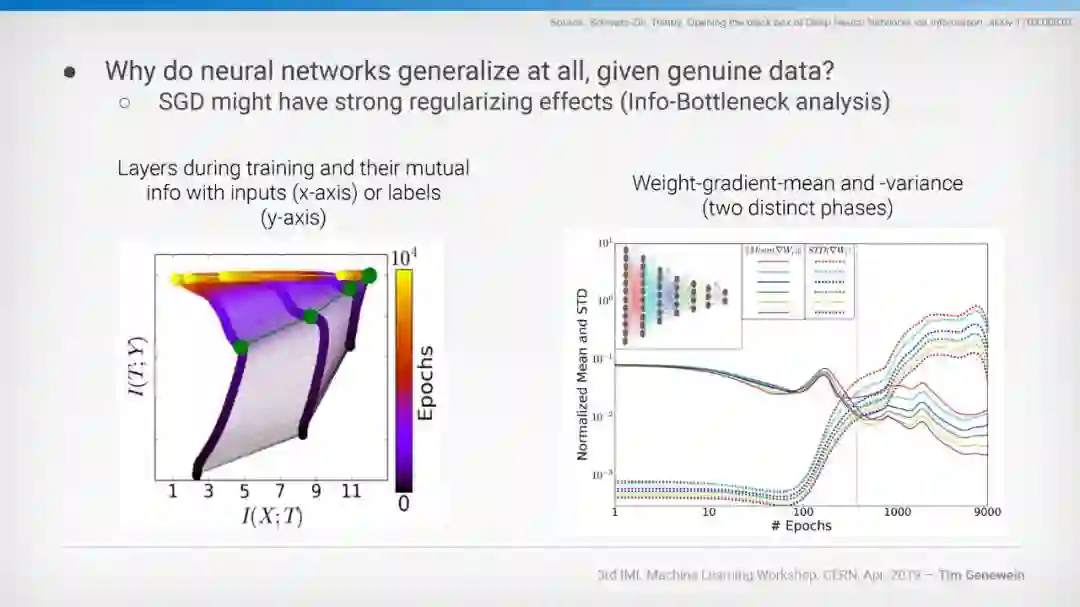

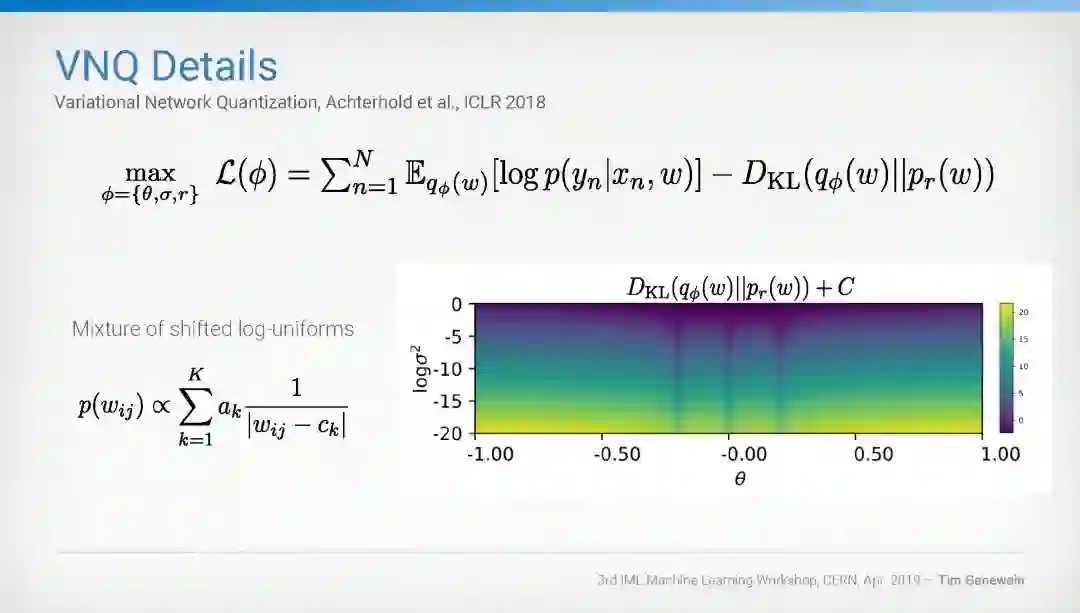

经验表明,训练后的神经网络具有较高的参数冗余度。为什么在训练前不能使用较小的神经网络减少参数冗余,这仍然是一个有待解决的理论问题。另一方面,最近的科学文献报道了大量的实用方法来“压缩”神经网络,这些方法在训练期间或训练后(几乎)对任务性能做出很小的牺牲,同时显著降低了神经网络模型的计算需求。本文概述了神经网络压缩方法的研究现状,介绍了一种基于贝叶斯神经网络的压缩方法。讨论了贝叶斯神经网络压缩方法的一些吸引人的理论特性,并概述了神经网络训练的实际实现。最后讨论了神经网络压缩在实际应用中的困难,并展望了如何利用数据中的噪声和冗余来提高神经网络的计算效率。

原始链接

https://indico.cern.ch/event/766872/contributions/3287971/attachments/1829603/2995870/CERN_IML_Workshop_talk_Genewein.pdf

请关注专知公众号(点击上方蓝色专知关注)

后台回复“神经网络压缩” 就可以获取《DeepMind: Compressing neural networks》的下载链接~

附PPT全文:

-END-

专 · 知

专知,专业可信的人工智能知识分发,让认知协作更快更好!欢迎登录www.zhuanzhi.ai,注册登录专知,获取更多AI知识资料!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程视频资料和与专家交流咨询!

请加专知小助手微信(扫一扫如下二维码添加),加入专知人工智能主题群,咨询技术商务合作~

专知《深度学习:算法到实战》课程全部完成!530+位同学在学习,现在报名,限时优惠!网易云课堂人工智能畅销榜首位!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程