更丰富的卷积特征用于目标边缘检测(文末附有论文及源码下载)

【导读】边缘检测是计算机视觉中的一个基本问题。近年来,卷积神经网络(CNNs)的出现极大地推动了这一领域的发展。现有的方法采用特定的深层CNN,但由于尺度和纵横比的变化,可能无法捕捉到复杂的数据结构。今天分享的paper提出了一种利用更丰富的卷积特征(RCF)来精确的边缘检测方法。

引言

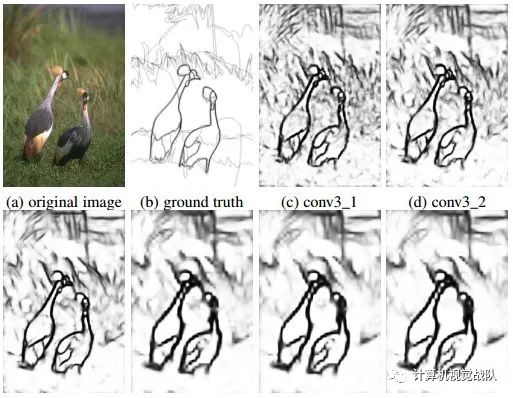

如下图所示,构建了一个简单的网络,使用带有HED架构(S. Xie and Z. Tu, “Holistically-nested edge detection,” Int. J. Comput. Vis., vol. 125, no. 1-3, pp. 3–18, 2017.)的VGG-16生成中间层的输出,可以看出不同卷积层所获得的信息逐渐变粗。

从上图可以得到更重要的是,中间Conv层包含重要的细节。然而以往的CNN体系结构只使用最终的Conv层或在神经网络的池化层之前的层,而忽略了中间层。另一方面,由于更丰富的卷积特征对于许多视觉任务是非常有效的,许多研究人员致力于开发更深层次的网络。然而,由于渐变/爆炸梯度的消失和训练数据的不足,很难使网络在更深的范围内收敛。

那么,我们为什么不充分利用现在的CNN特征呢???在此基础上,提出了一种充分利用CNN特征的新深层结构-更丰富的卷积特征(RCF),以图像对图像的方式对边缘检测进行像素级预测。RCF可以自动学习将来自CNN的所有层的互补信息组合起来,从而能够获得不同尺度上的目标价或目标部件的精确表示。

亮点

RCF将所有卷积特征封装成更有区分性的表示,从而很好地利用了丰富的特征层次结构,并且可以通过反向传播进行训练。RCF充分利用对象的多尺度和多层次信息,全面地进行图像到图像的预测。利用VGG-16网络,在几个可用的数据集上实现了最先进的性能。

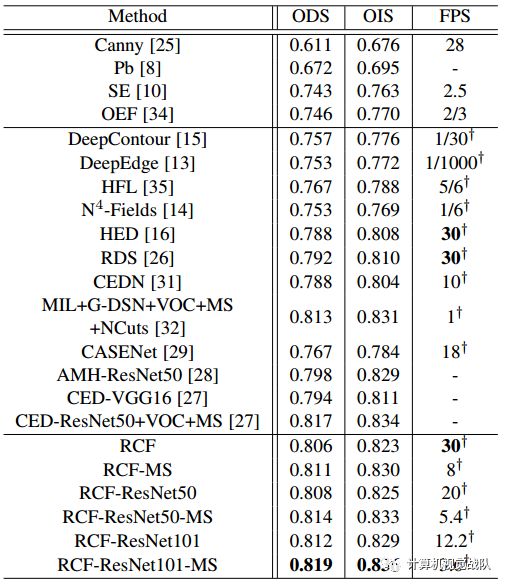

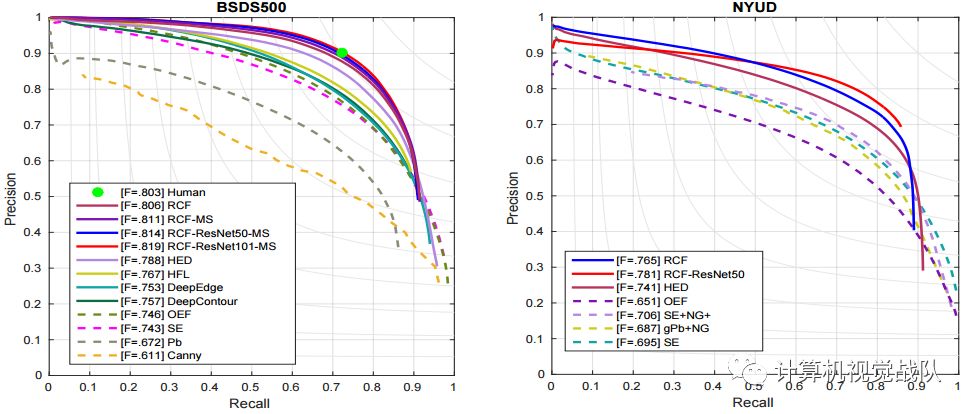

在对著名的BSDS 500基准进行评估时,在保持快速速度(8 FPS)的同时,实现了ODS F-measure为0.811。此外,提出的方法还有一个快速版本,其达到了ODS F-measure为为0.806与30 fps。通过将RCF边缘应用于经典图像分割,验证了该方法的通用性。

RCF

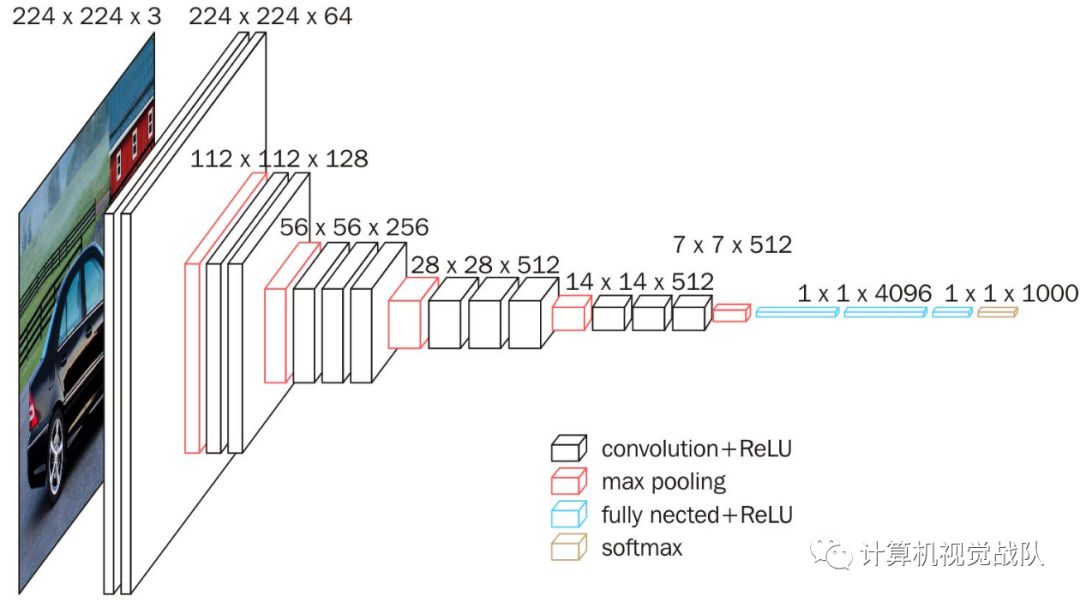

借鉴了现有工作HED、FCN并开始VGG-16网络。VGG-16网络由13个Conv层和3个全连接层组成。将其Conv层划分为五个阶段,在这五个阶段中,在每个阶段之后连接池化层。由每个Conv层捕获的有用信息随着其感受野大小的增加变得更粗。在HED文献中中可以找到不同层的详细感受野大小。假设使用这种丰富的分层信息来帮助边缘检测,网络设计的出发点就是在这里。

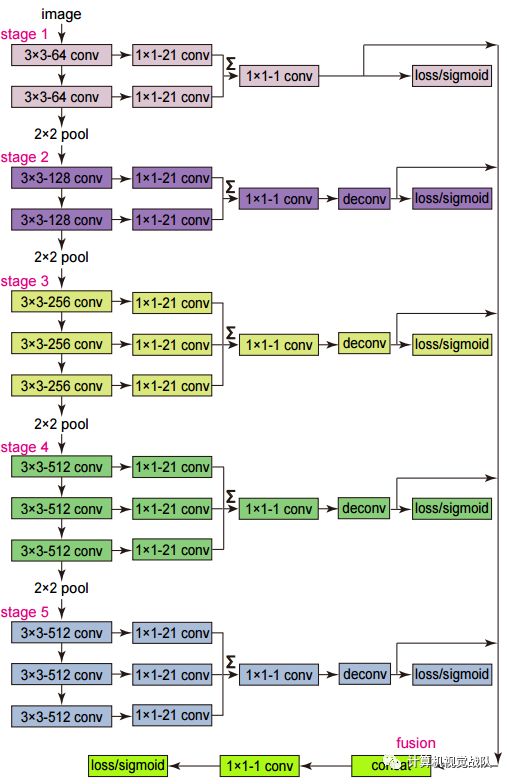

上图显示了提出的新网络。与VGG-16相比,主要的修改可以概括为:

-

切割了所有全连接的层和池化层。一方面,去除了全连接的图层,形成一个全卷积的网络来进行图像到图像的预测;另一方面,增加池化层会使步长增加两倍,往往导致边缘定位的退化;

-

VGG-16中的每个Conv层连接到内核大小为1×1、深度为21的Conv层。并在每一阶段的结果特征映射被累积使用一个eltwise层来获得混合特征;

-

一个1×1−1 Conv层在每个电子层后面。然后,用反卷积层对该特征映射进行采样;

-

在每个阶段,交叉熵损失/sigmoid层连接到上采样层;

-

所有上采样层都连接在一起,然后用1×1 Conv层对每个阶段的特征映射进行融合。最后,采用交叉熵损失/sigmoid层来获得融合损失/输出。

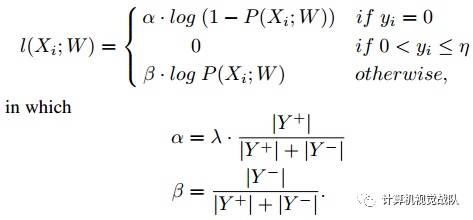

Annotator-robust损失函数

这个边缘数据集通常由几个注释者使用他们关于对象或对象部分的存在的知识来标记。虽然人类的认知能力不同,但对于同一幅图像,这些人标记的边缘具有很高的一致性。对于每幅图像,平均所有的Ground Truth,生成一幅从0到1的边缘概率图。

多尺度分层边缘检测

在单尺度边缘检测中,将原始图像传送到微调的RCF网络中,然后输出是边缘概率图。

为了进一步提高边缘质量,在测试阶段使用图像棱锥。具体地,我们调整图像的大小以构造图像金字塔,并且这些图像中的每一个分别传送到单个比例检测器。然后,使用双线性插值将所有得到的边缘概率映射调整为原始图像大小。最后对这些图进行融合得到最终的预测图。

在本研究中采用简单的平均融合,尽管其他先进的策略也适用。通过这种方式,初步版本首先证明了多尺度测试仍然有利于边缘检测,尽管RCf本身能够。

实验分析

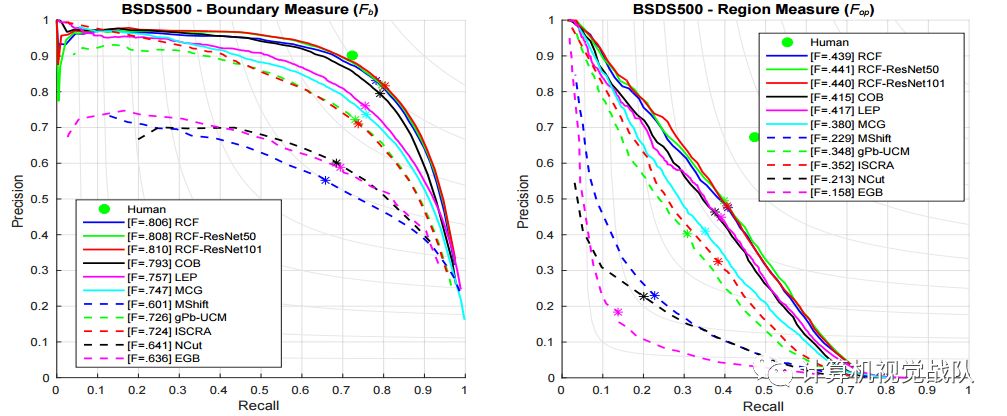

表1 在BSDS500数据集上的比较

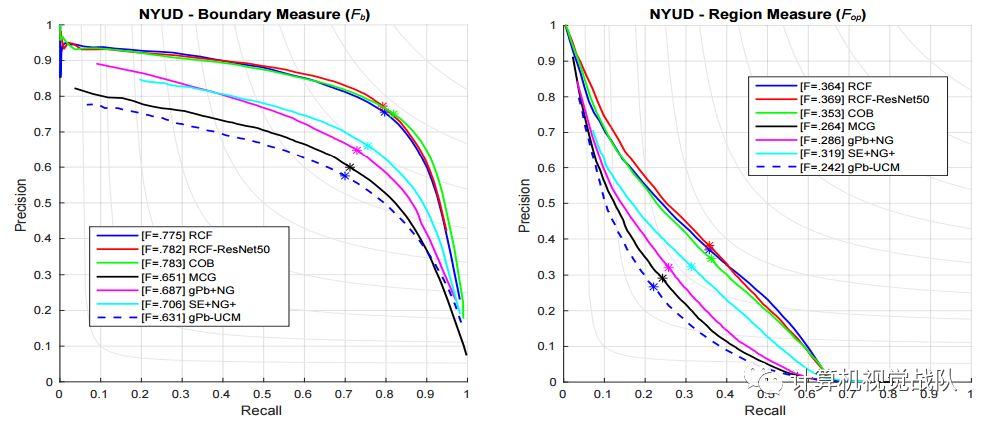

图 在BSDS500和NYUD数据集上的评估结果

图 RCf的一些可视化案例

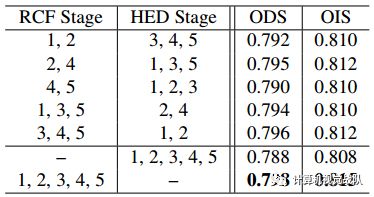

表 不同融合的结果

图 在不同数据集上边缘检测的评估PR曲线

如果想加入我们“计算机视觉战队”,请扫二维码加入学习群。计算机视觉战队主要涉及机器学习、深度学习等领域,由来自于各校的硕博研究生组成的团队,主要致力于人脸检测、人脸识别,多目标检测、目标跟踪、图像分割等研究方向。

我们开创一段时间的“计算机视觉协会”知识星球,也得到很多同学的认可,我们定时会推送实践型内容与大家分享,在星球里的同学可以随时提问,随时提需求,我们都会及时给予回复及给出对应的答复。

微信学习讨论群也可以加入,我们会第一时间在该些群里预告!

论文地址:http://mftp.mmcheng.net/Papers/19PamiEdge.pdf

源码:https://github.com/yun-liu/rcf