【Bengio高徒演讲】深度学习三板斧:网络架构、学习算法和时空层级(48PPT)

新智元编译

来源:YouTube

作者:Kyunghyun Cho

编译:四叠半

【新智元导读】Kyunghyun Cho是纽约大学计算机科学与数据科学助理教授。他是蒙特利尔大学博士后,导师是 Yoshua Bengio。他于2014年初在阿尔托大学获得博士和硕士学位。本次演讲题是:深度学习路在何方?它从网络架构、可学习的算法和时间/空间层级三个方面介绍了目前和未来深度学习的发展。

全部PPT下载地址:https://drive.google.com/file/d/0B16RwCMQqrtdVno2b1lxM3E0UHc/view

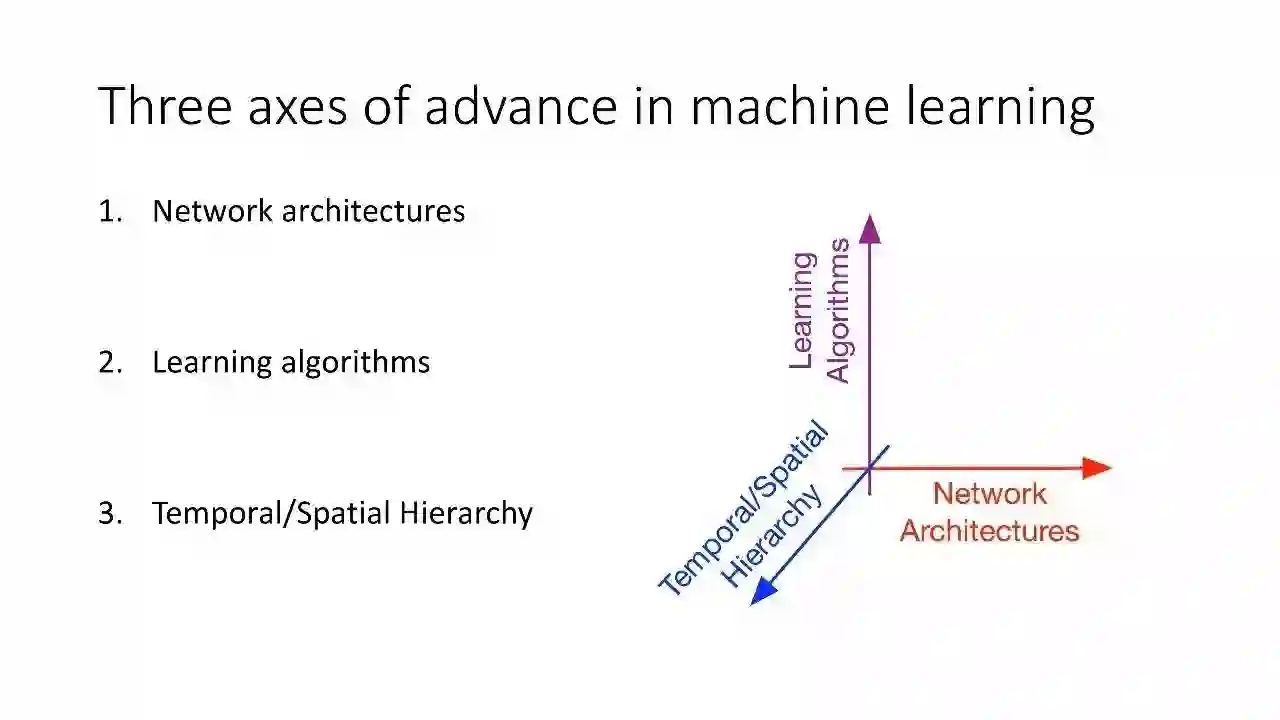

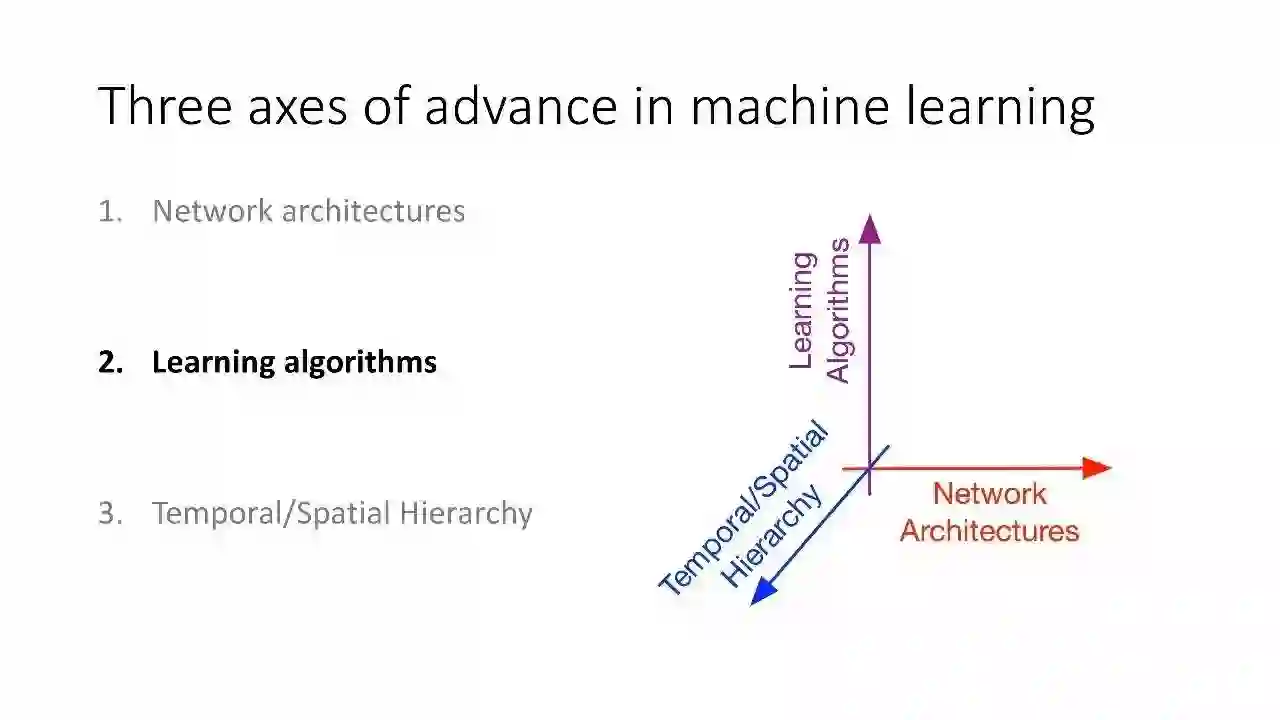

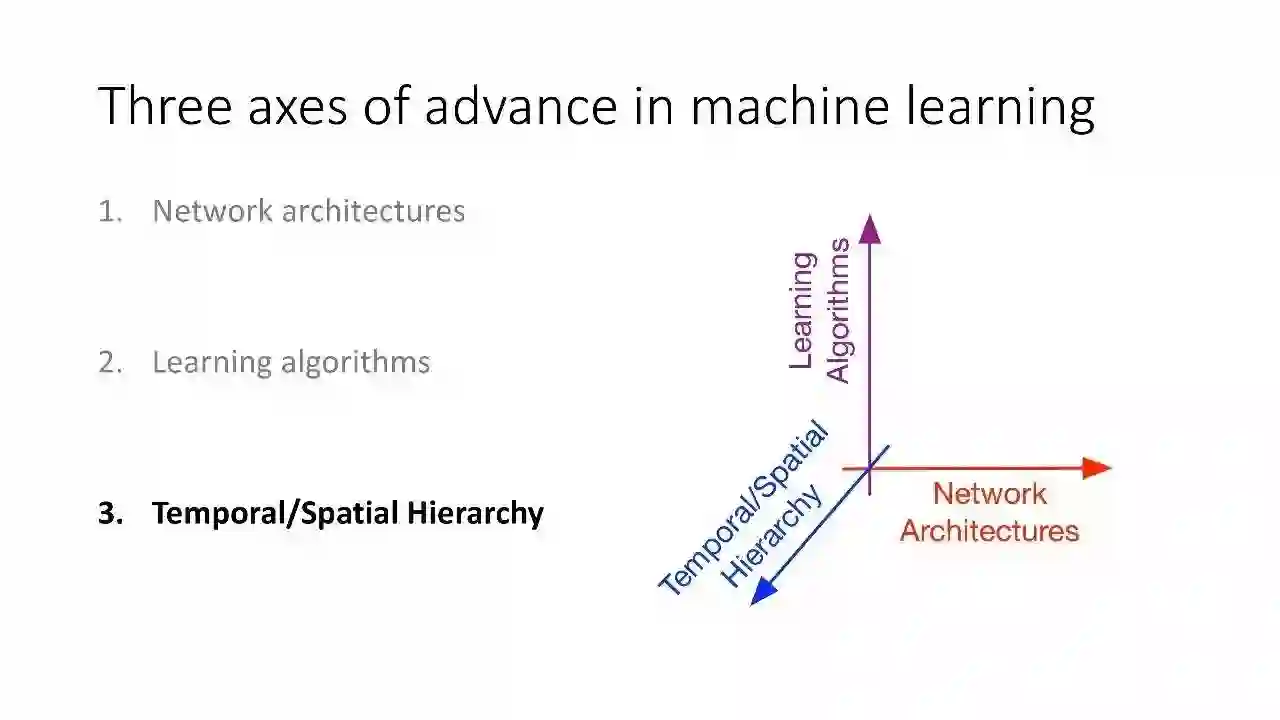

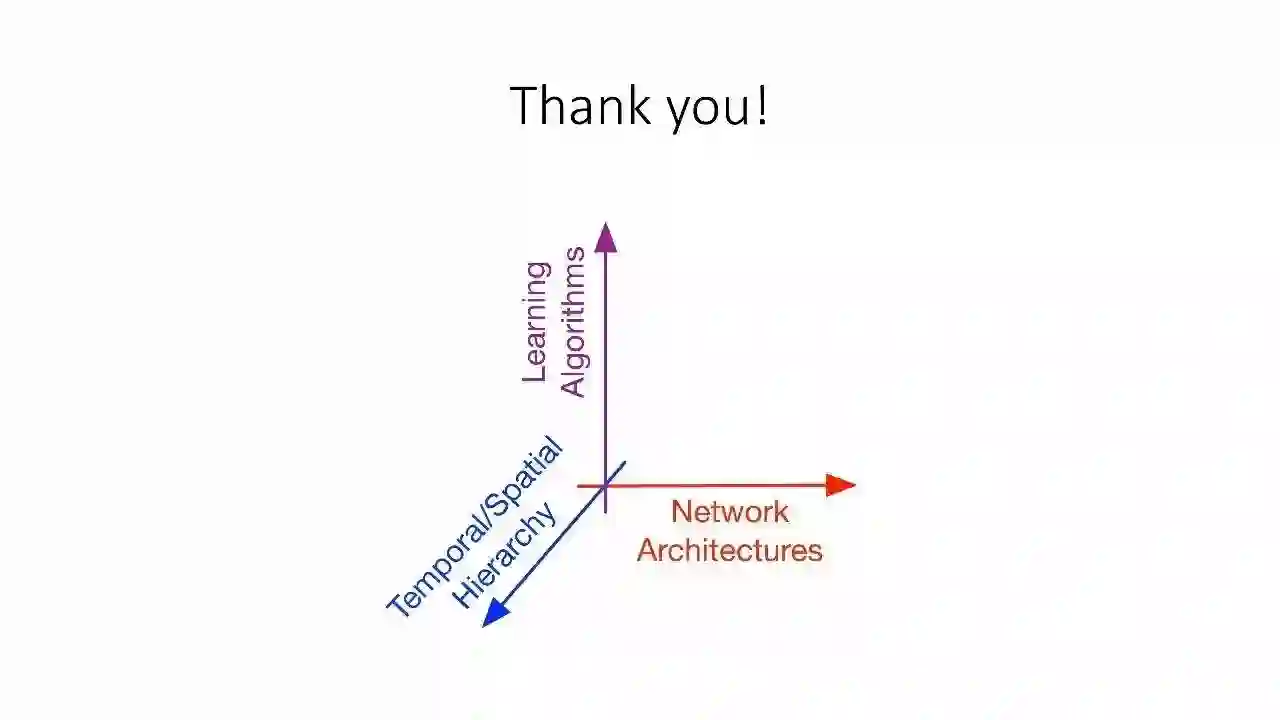

机器学习的三个坐标轴

网络架构

学习算法

时间/空间层级

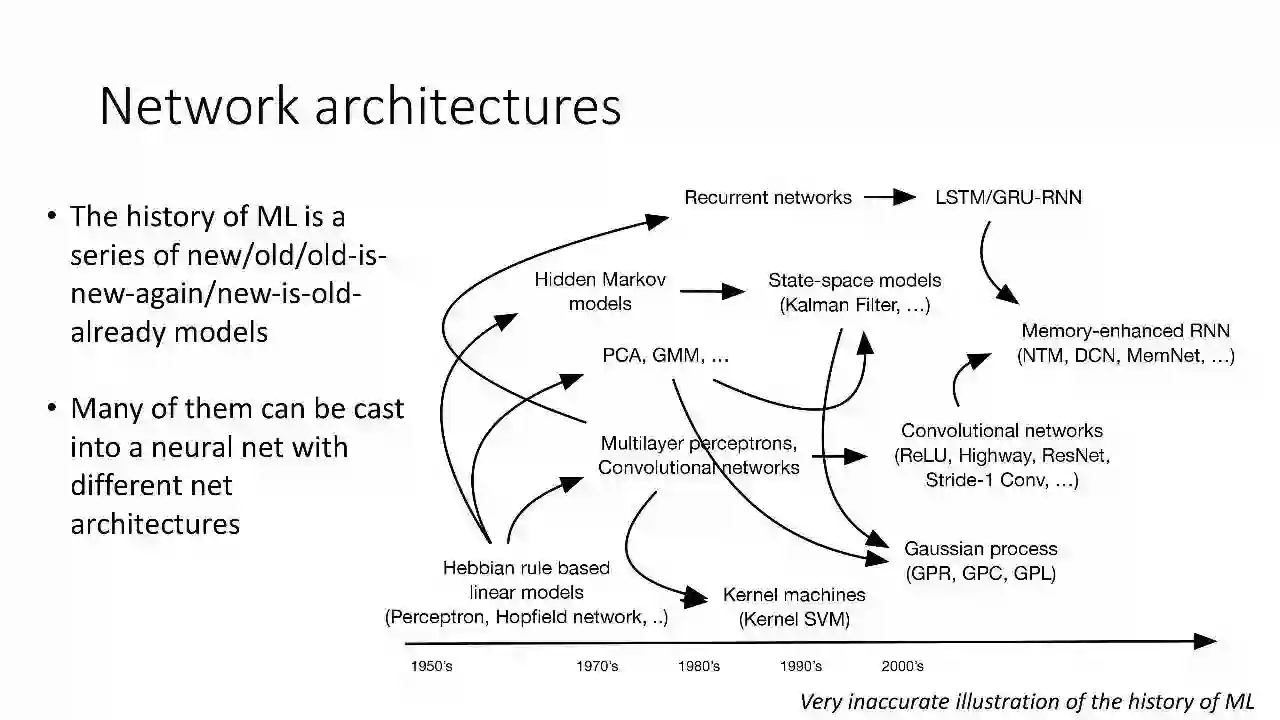

网络架构

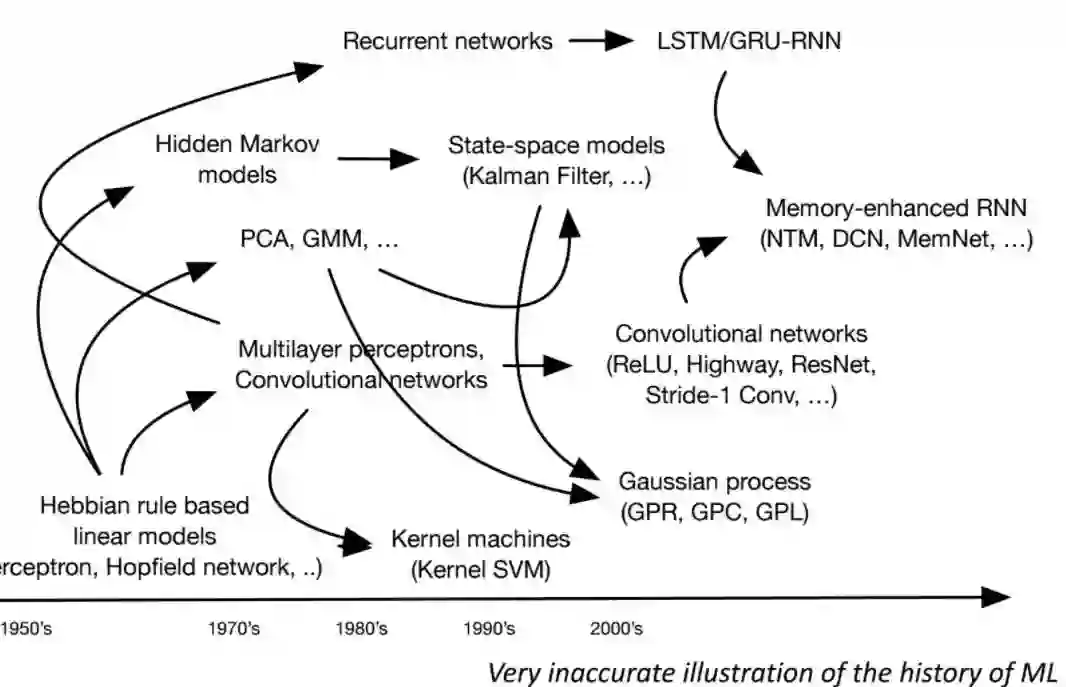

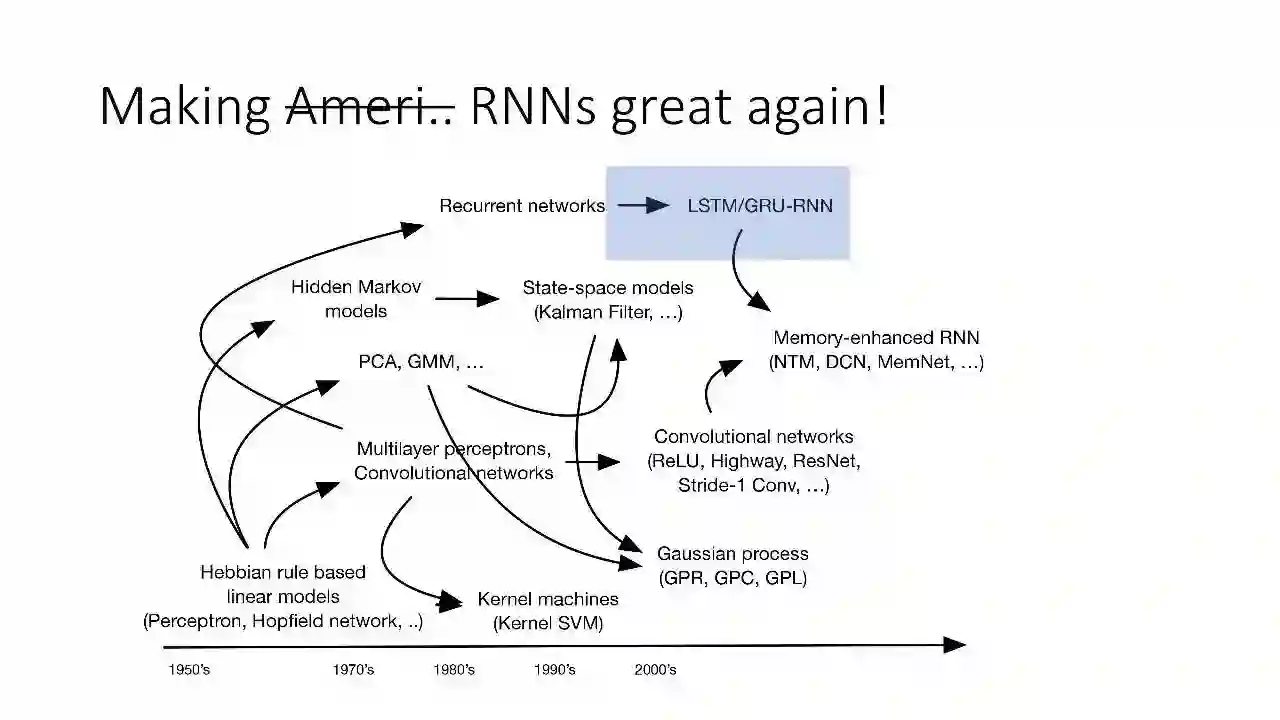

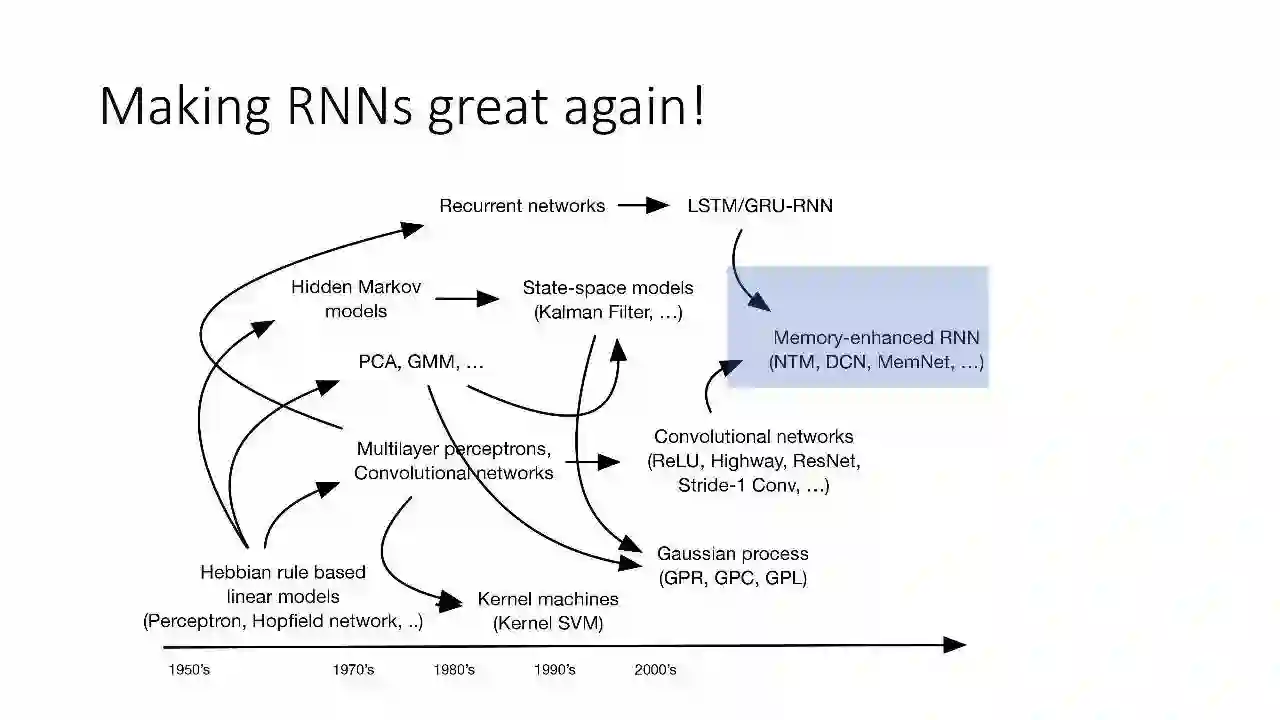

ML的历史就是一系列新的/旧的/旧瓶换新酒的/新的变旧的模型

其中很多都可以作为具有不同网络架构的神经网络

放大看看:

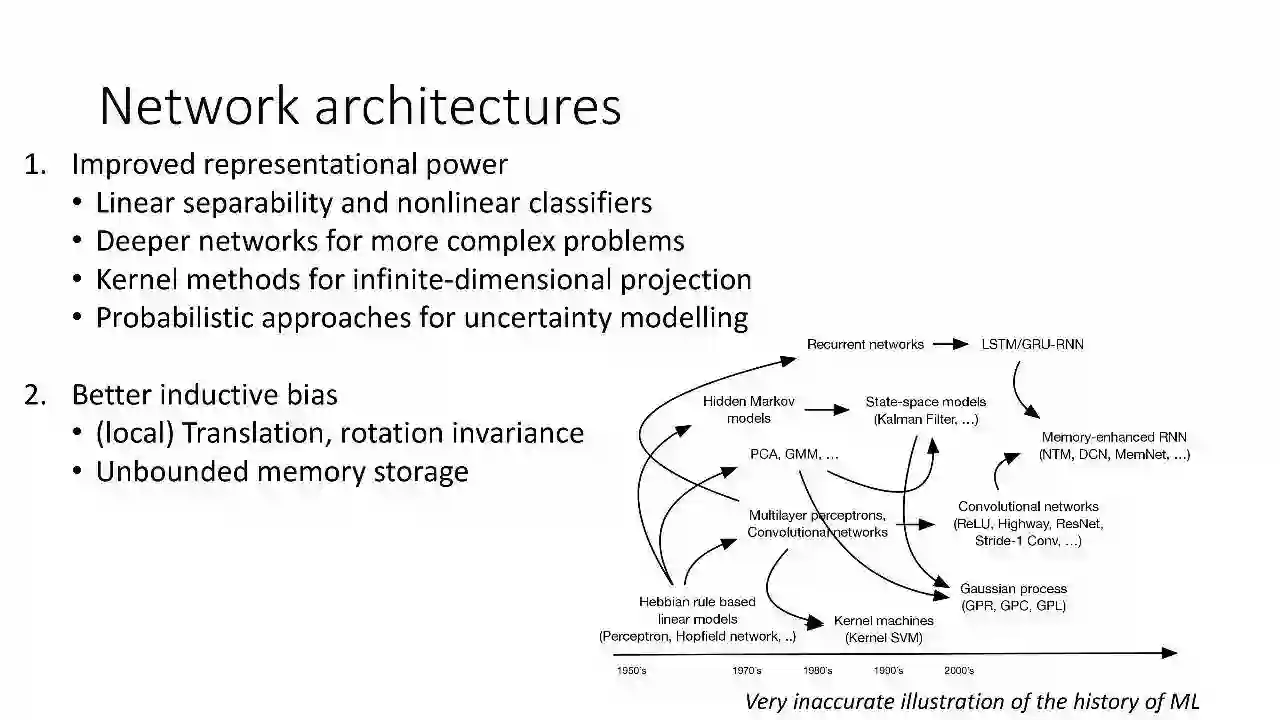

1. 提高再现能力

线性可分性和非线性分类器

更复杂问题的更深的网络

无限维度投影的核方法

不确定性模型的概率方法

2. 更好的归纳偏置

(本地)翻译,旋转不变性

无界存储器

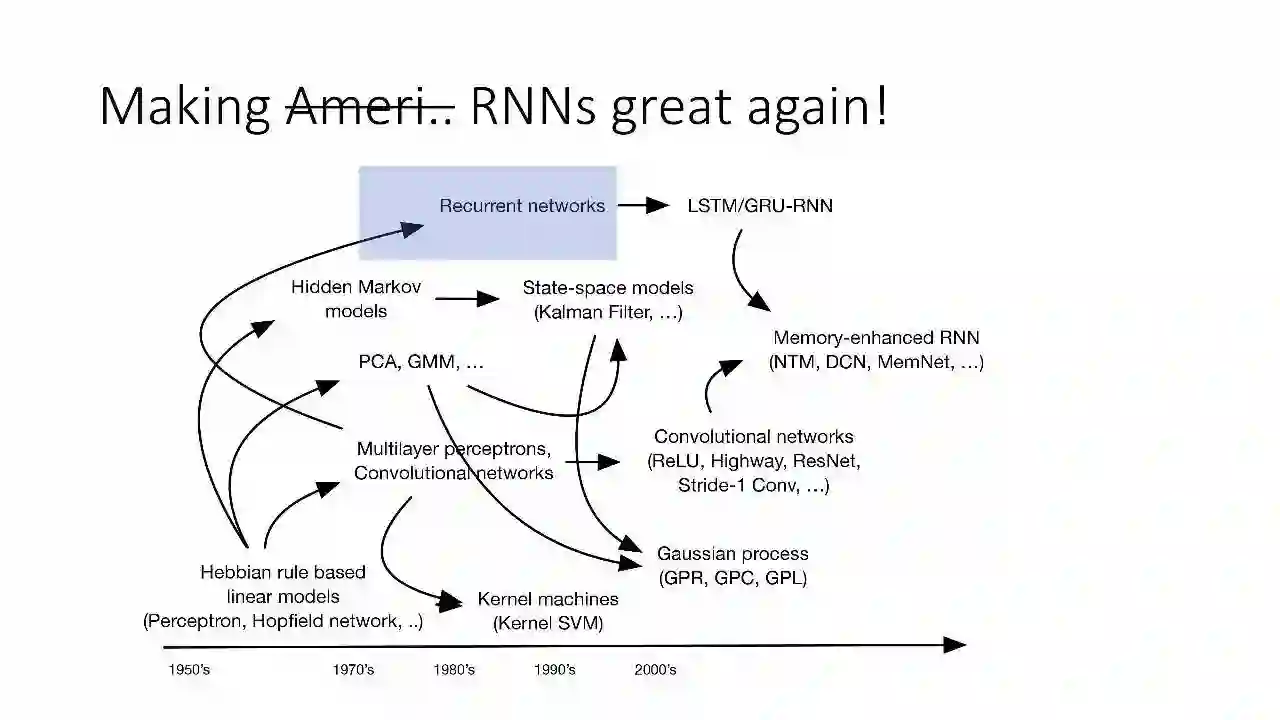

让CNN再次伟大!

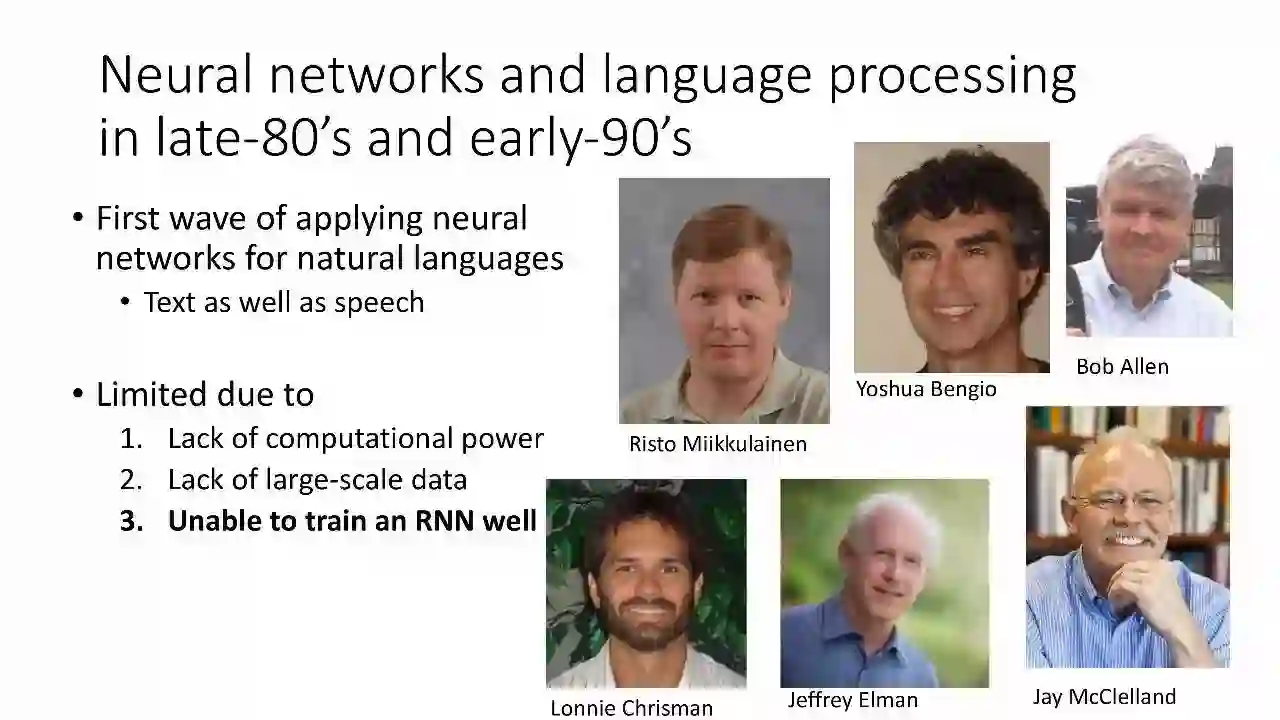

80年代末90年代初的神经网络和自然语言处理研究

第一波在自然语言中应用神经网络的研究

文字和话语

受到限制,因为:

缺乏计算力

缺乏大规模数据

没法很好第训练RNN

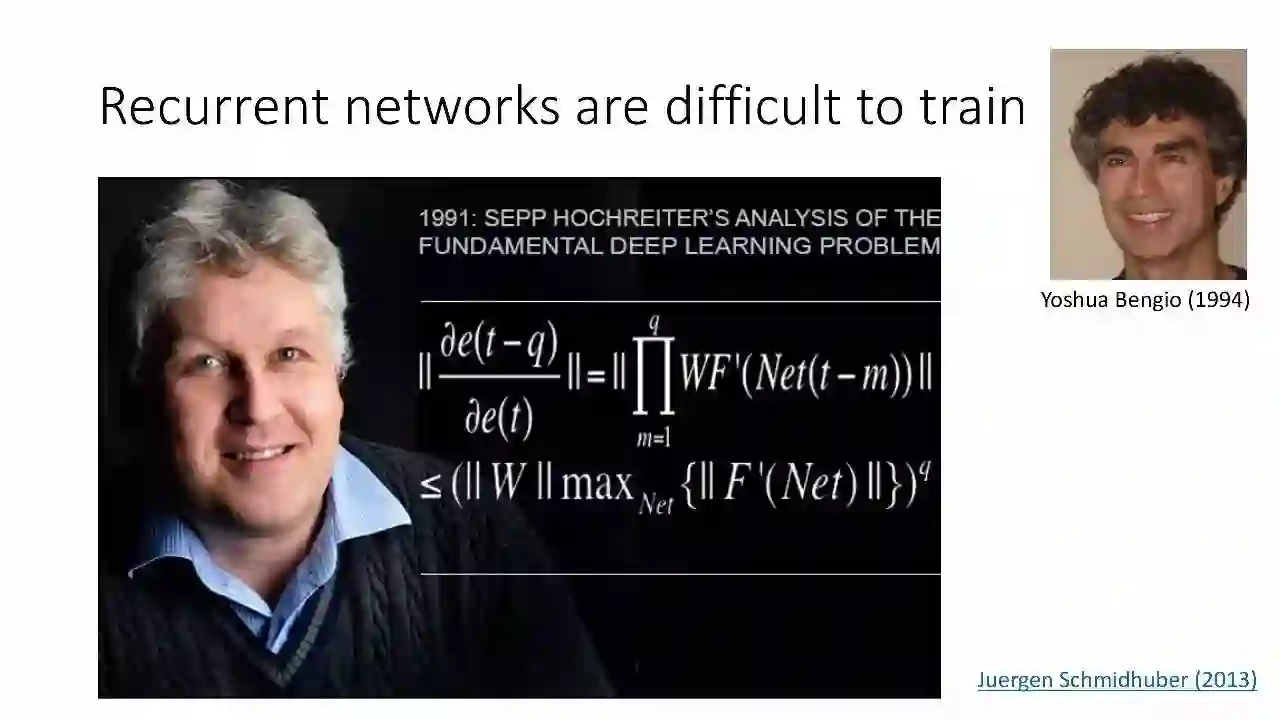

循环神经网络很难训练

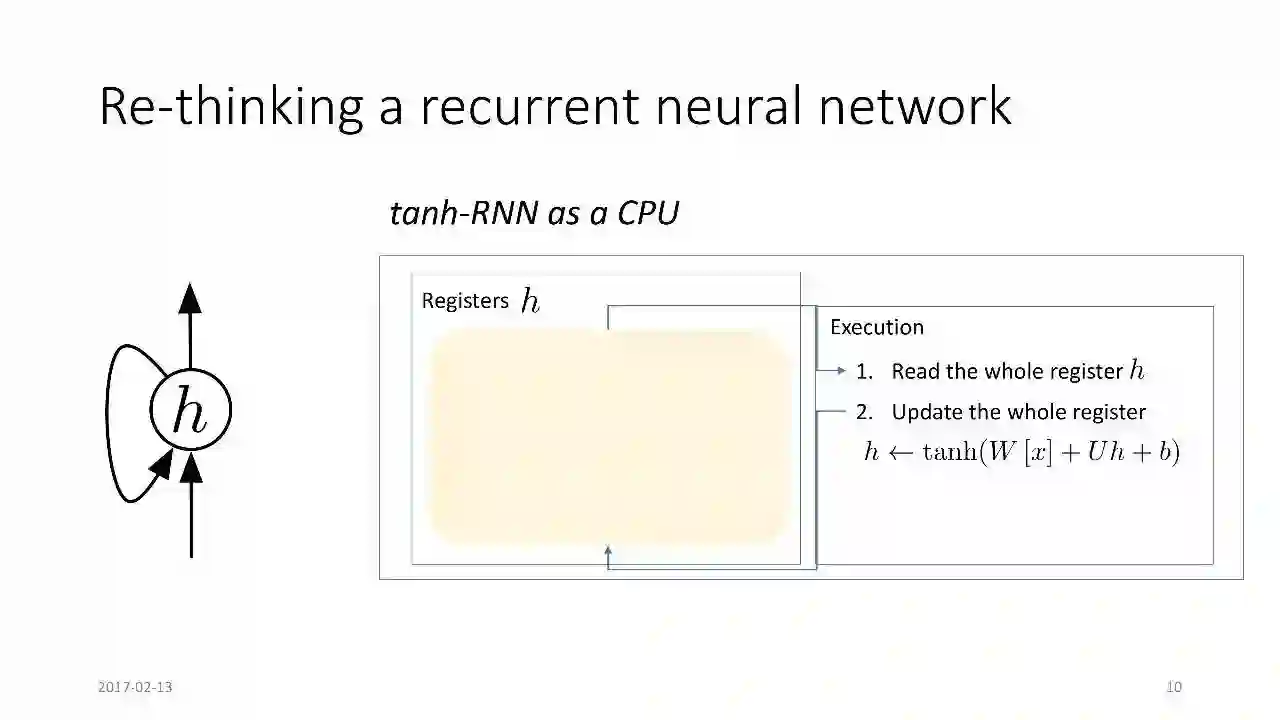

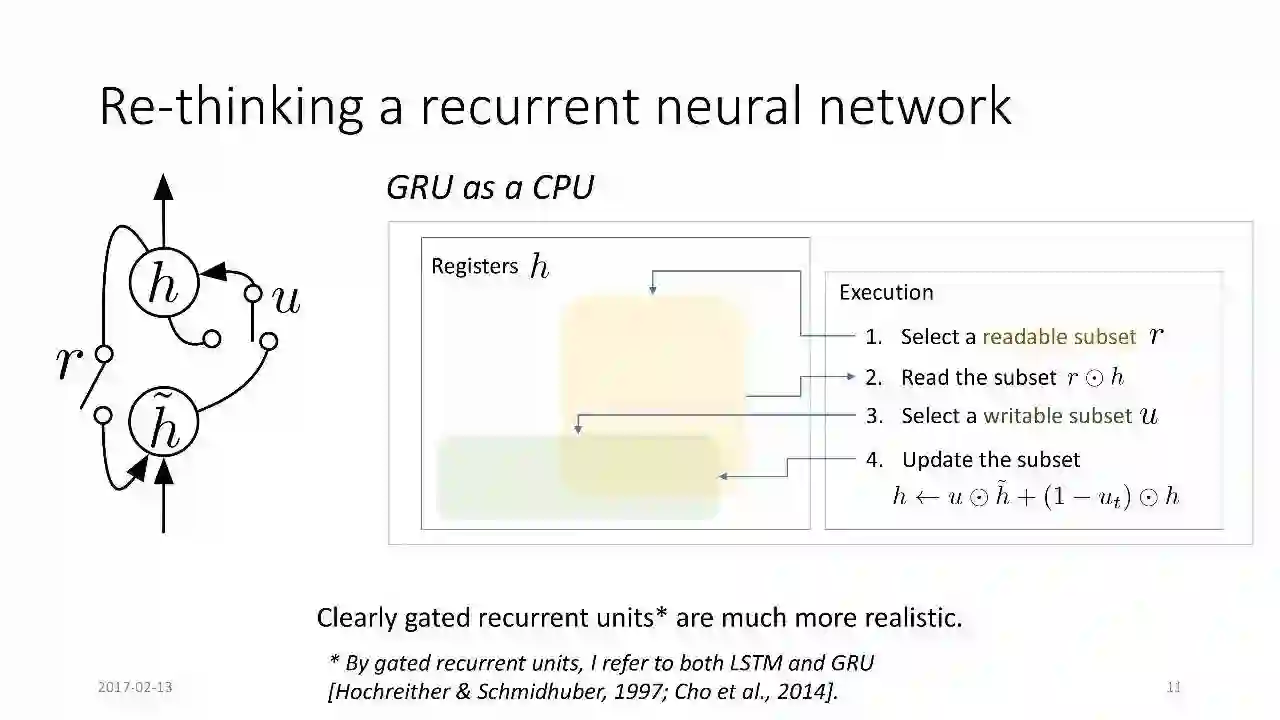

重新思考循环神经网络

在实践中,GRU或LSTM RNN更容易训练,并且在广泛的超参数下工作很好

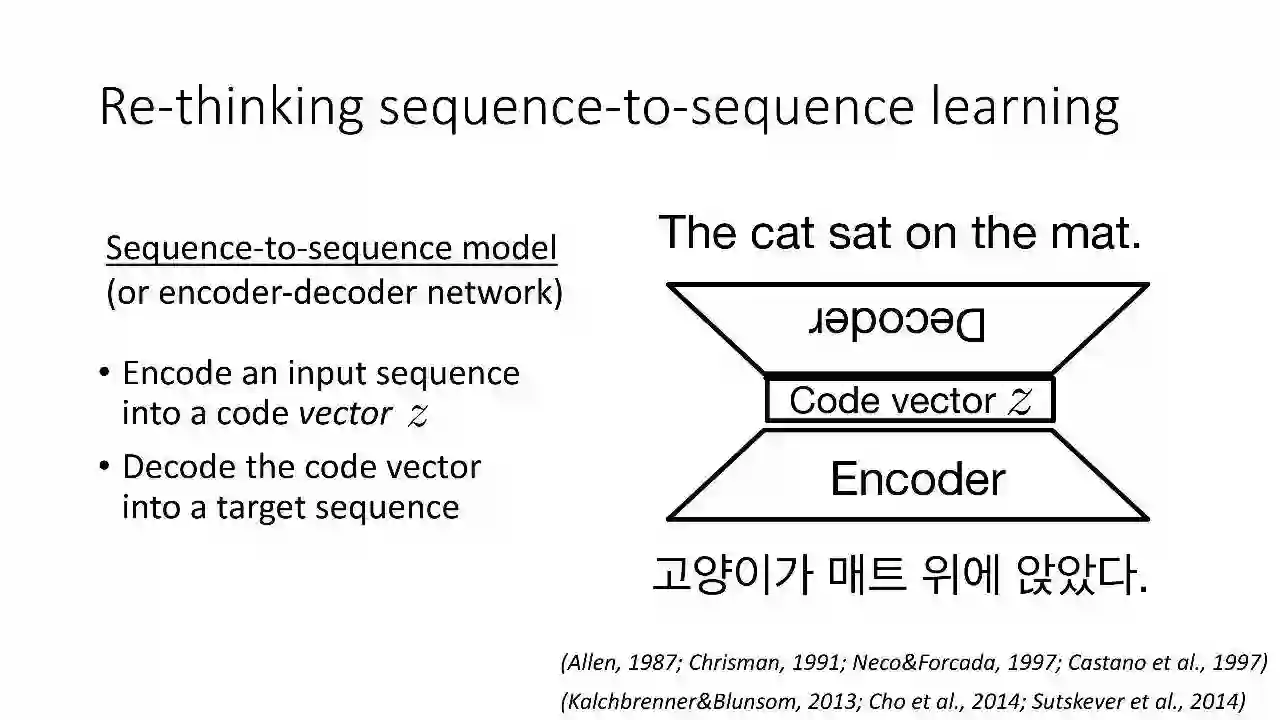

序列到序列模型(或编码器-解码器网络)

编码一个输入序列为一个代码向量 z

解码这个代码向量为一个目标序列

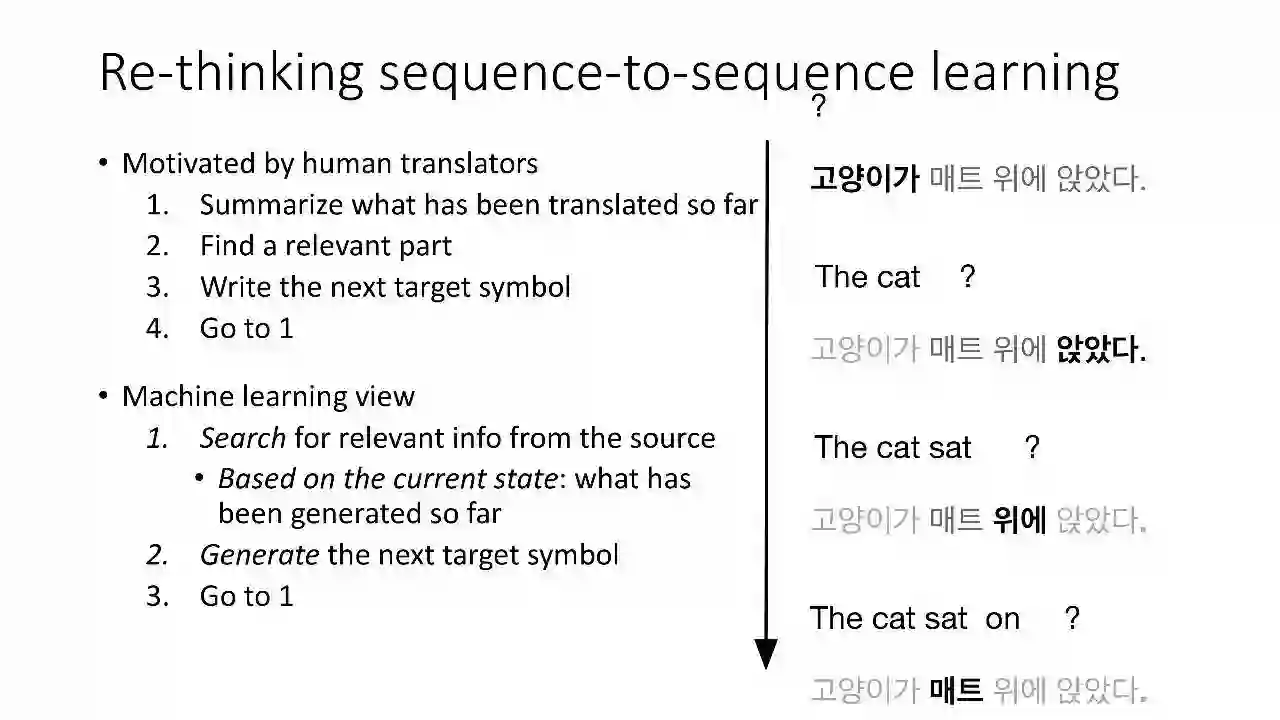

启发自人类的翻译过程

总结迄今已翻译的内容

找到相关的部分

写出下一个目标字符

返回步骤1

机器学习的过程:

在源文本中查找相关信息

生成下一个目标字符

返回步骤1

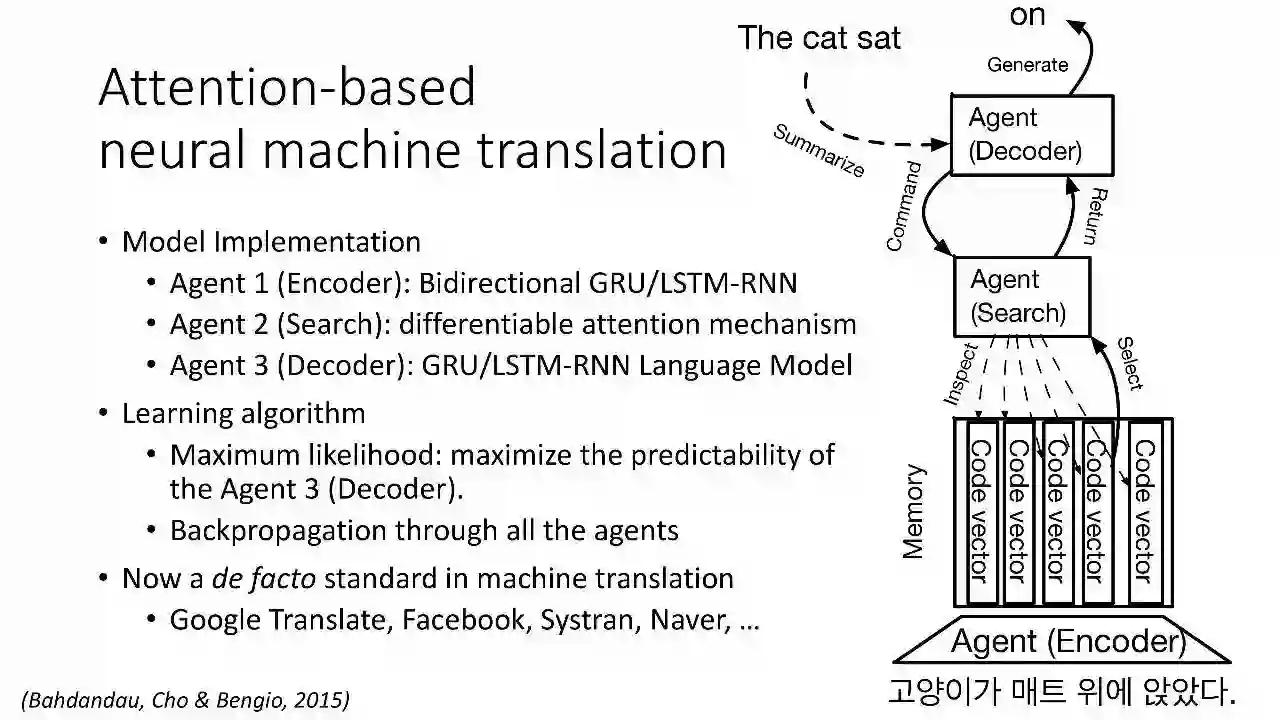

三个智能体(agents)之间的合作

Agent 1(编码器):将源句子在内存中转变为一系列的代码向量

Agent 2(搜索):根据Agent 3的命令,在内存中搜索相关代码向量,并将它们返回给Agent 3

Agent 3(解码器):观察当前状态(先前解码的符号),命令Agent 2去搜索相关的代码向量并基于它们生成下一个符号。

基于注意力的神经机器翻译

模型实现

Agent 1(编码器):双向GRU/LSTM-RNN

Agent 2(搜索):可微分注意力机制

Agent 3(解码器):GRU/LSTM-RNN语言模型

学习算法

最大似然:最大化Agent 3(解码器)的可预测性

所有agents中反向传播

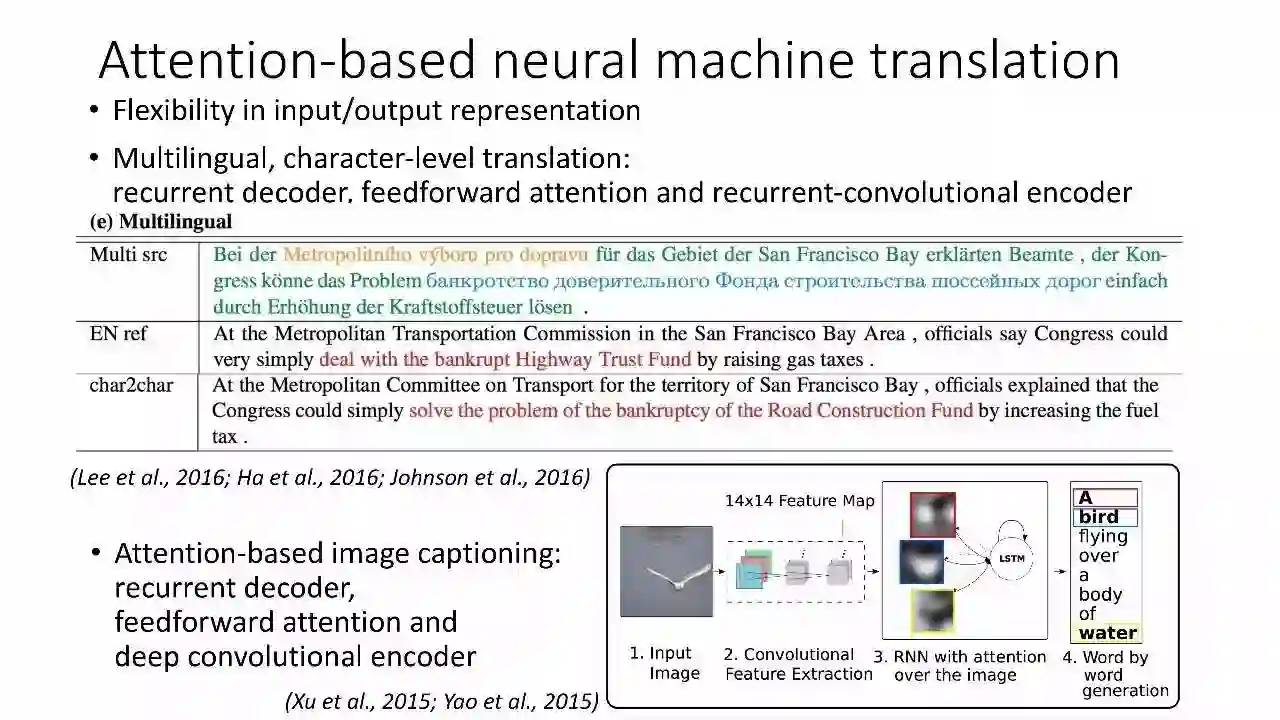

输入/输出表示的灵活性

多语言、character-level的翻译:recurrent decoder、feedforward attention、 recurrent-convolutional encoder

基于注意力的图像说明:recurrent decoder、feedforward attention、 recurrent-convolutional encoder

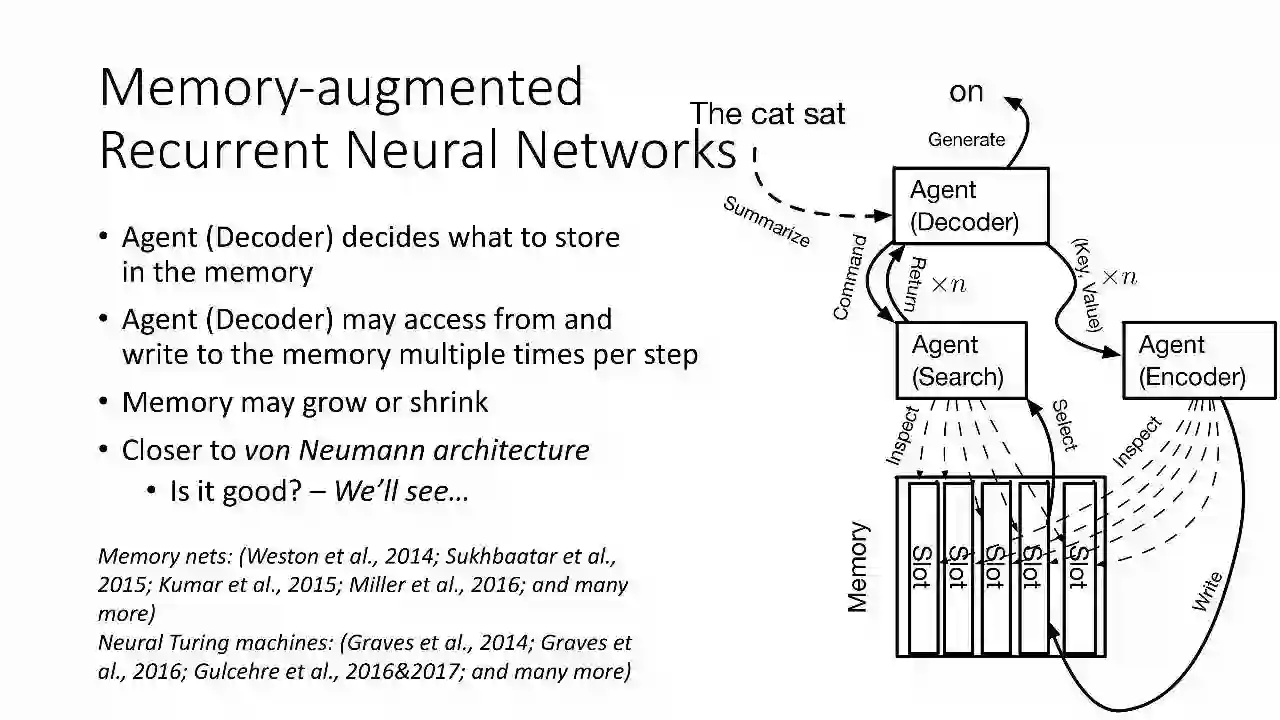

记忆增强循环神经网络

Agent(编码器)决定在内存中存储什么

Agent(编码器)每个步骤可以多次访问和写入内存

内存可能会增长或缩小

更接近冯诺依曼结构

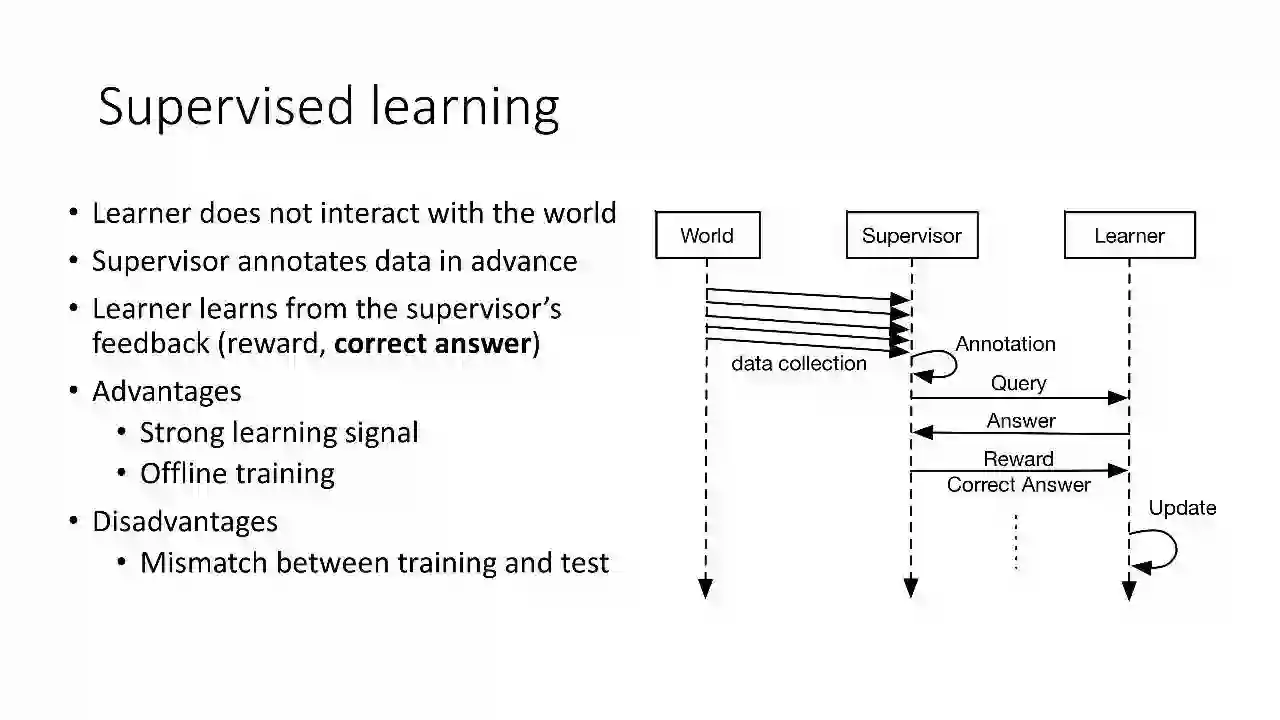

监督学习

学习者不与现实世界产生互动

监督者提前对数据进行注释

学习者从监督者的反馈(奖励,正确答案)中学习

优点

强大的学习信号

离线训练

缺点

训练与测试不匹配

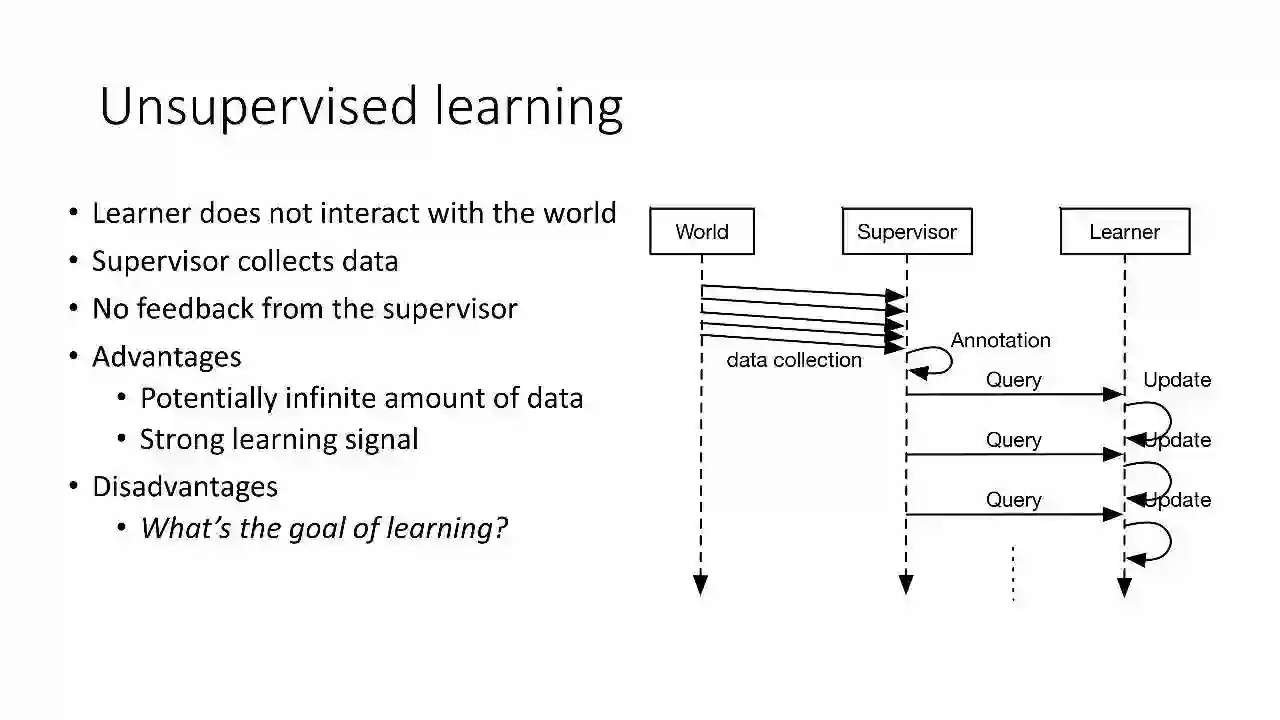

无监督学习

学习者不与现实世界产生互动

监督者收集数据

不从监督者那里得到反馈

优点

潜在的无限的数据量

强大的学习信号

缺点

学习的目标是什么?

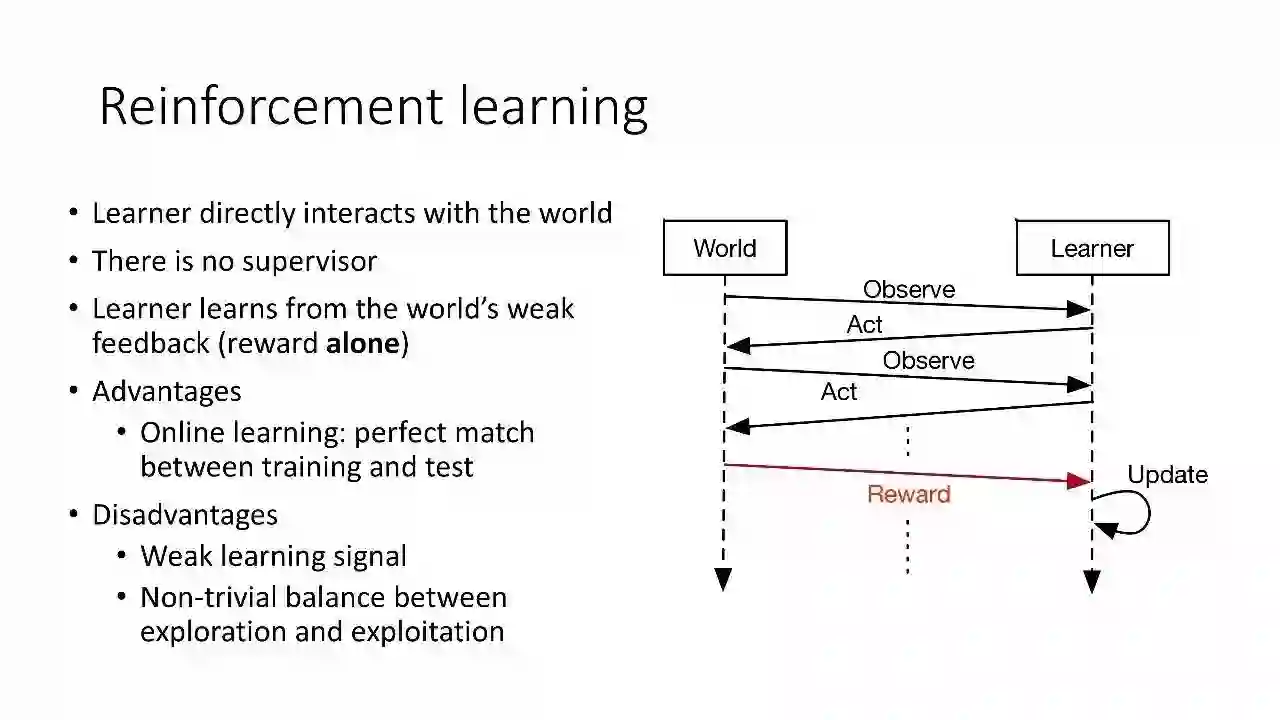

强化学习

学习者直接与世界互动

没有监督者

学习者从世界的弱反馈(只有奖励)中学习

优点

在线学习:训练和测试完美匹配

缺点

学习信号弱

Exploration和Exploitation之间的权衡

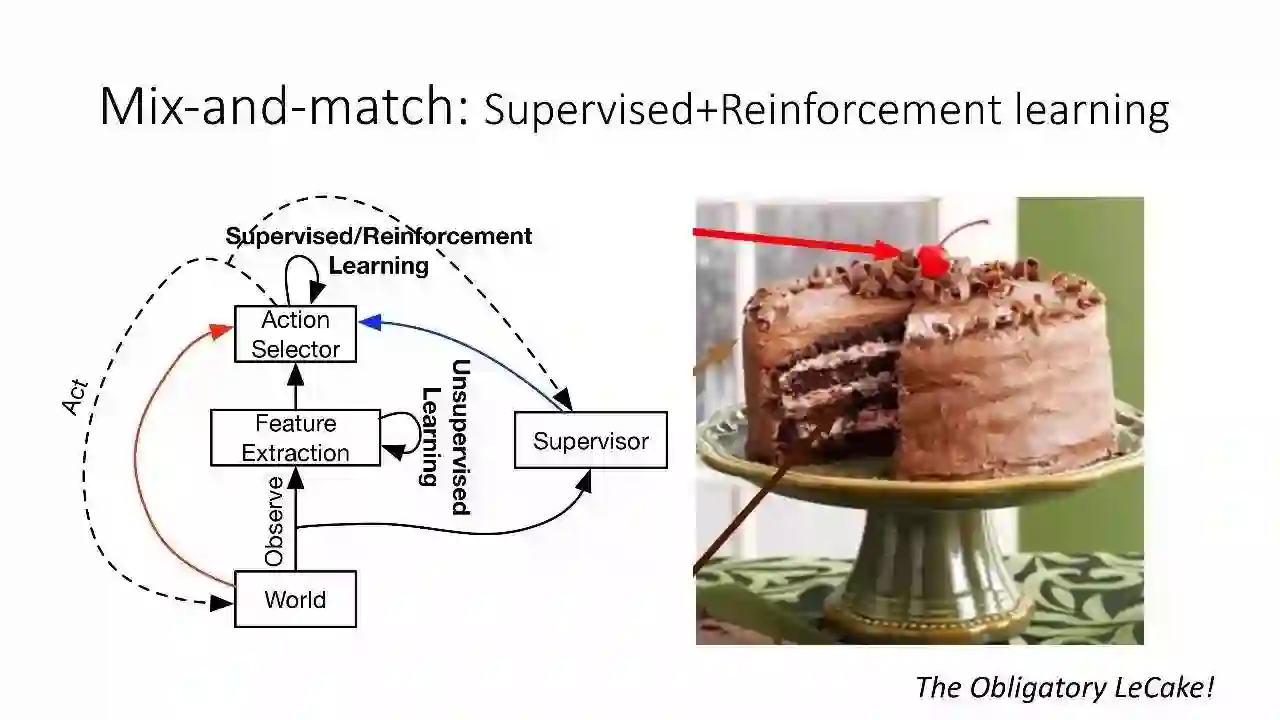

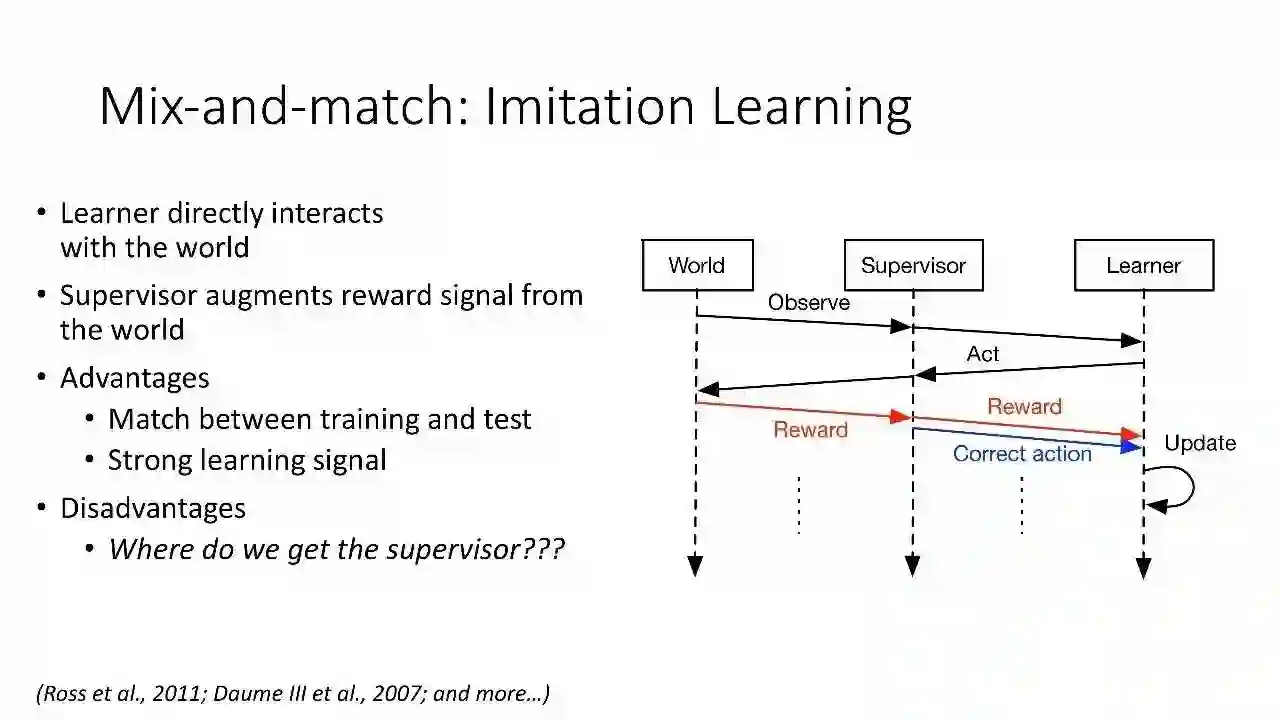

Mix-and-match:监督学习+强化学习

学习者直接与世界产生互动

优点:

训练和测试匹配

强学习信号

缺点:

从哪里得到supervisor?

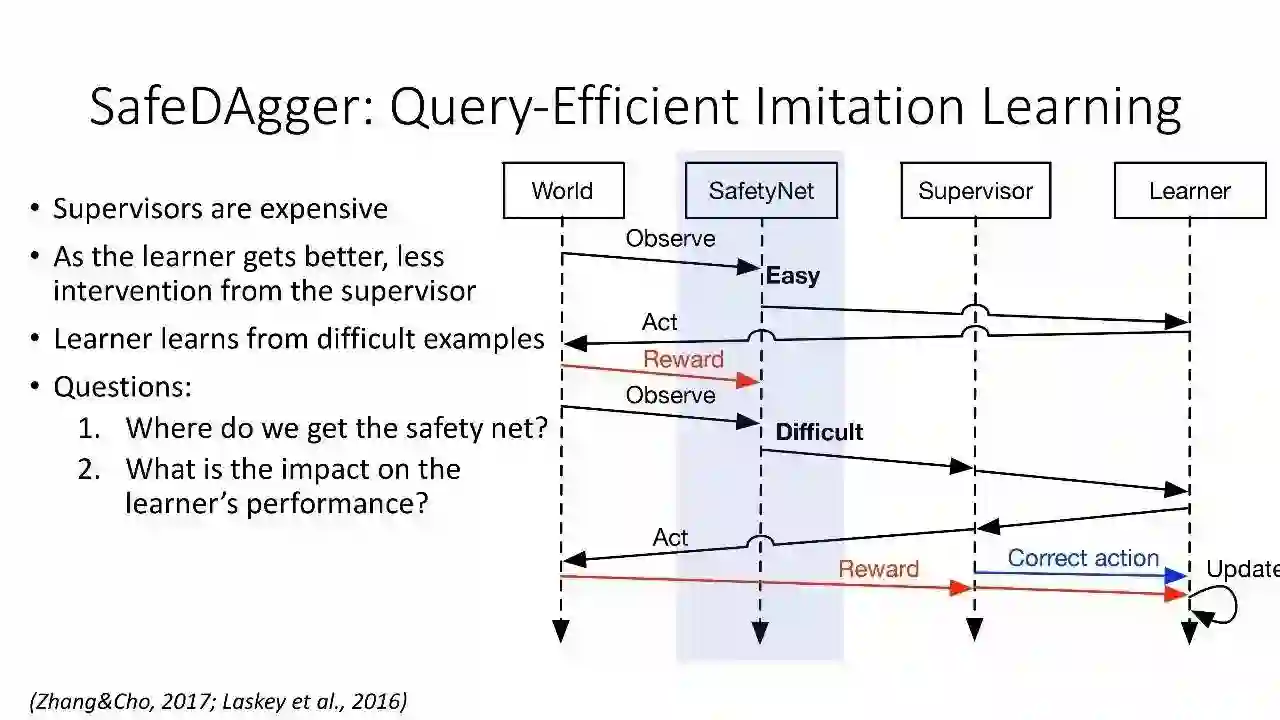

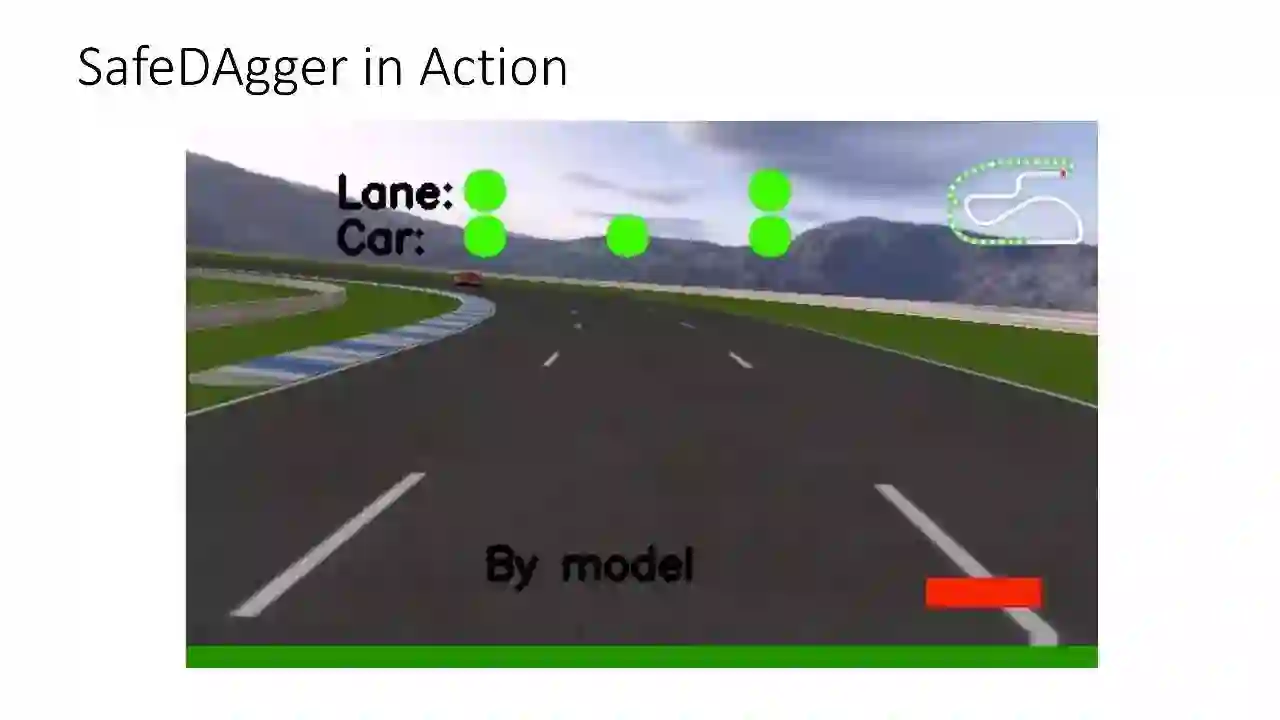

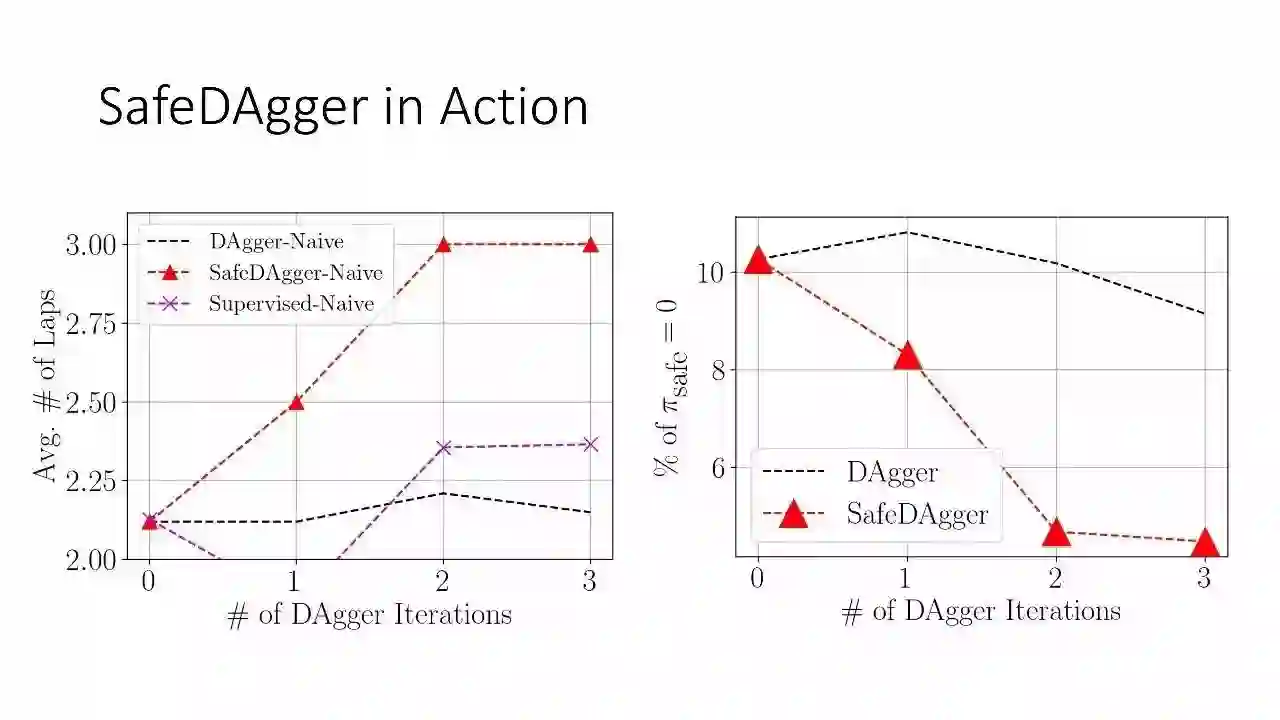

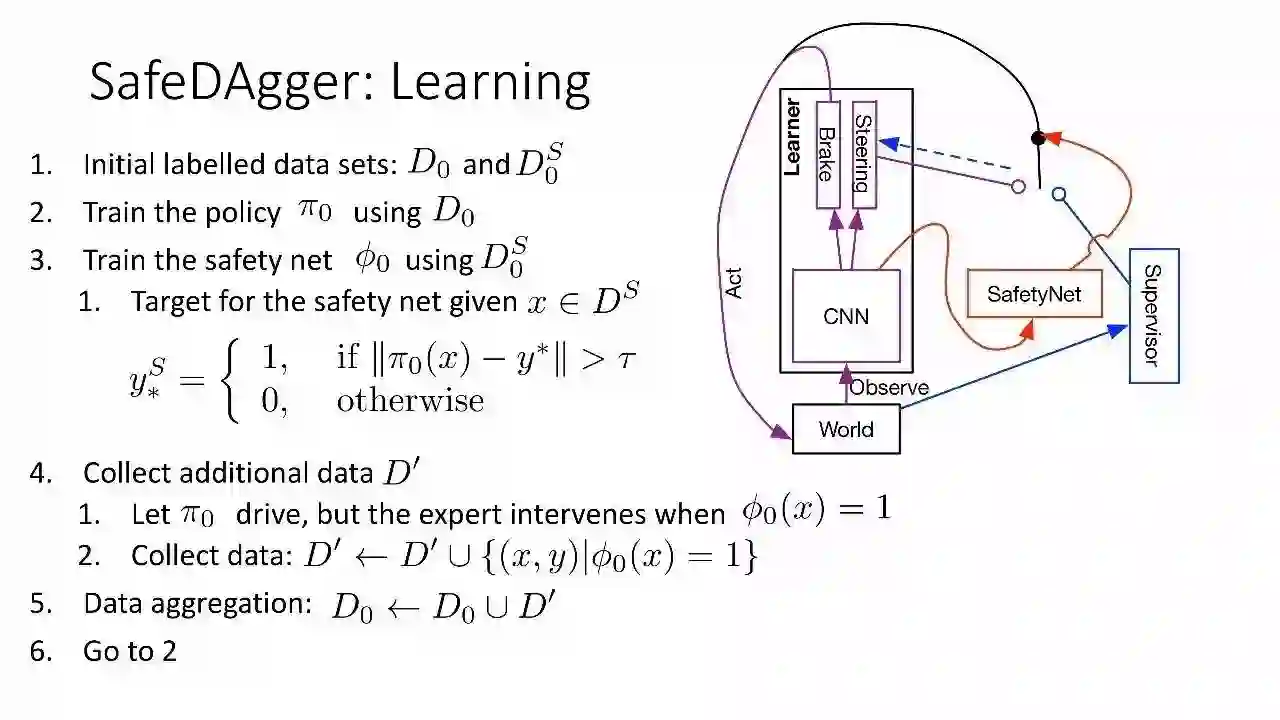

SafeDAgger: Query-Efficient 的模仿学习

supervisor的成本高

随着学习者变得越来越好,监督者的干预减少

学习者从困难的例子中学习

问题:

1. 从哪里得到安全的网络?

2. 对学习者的表现有什么影响?

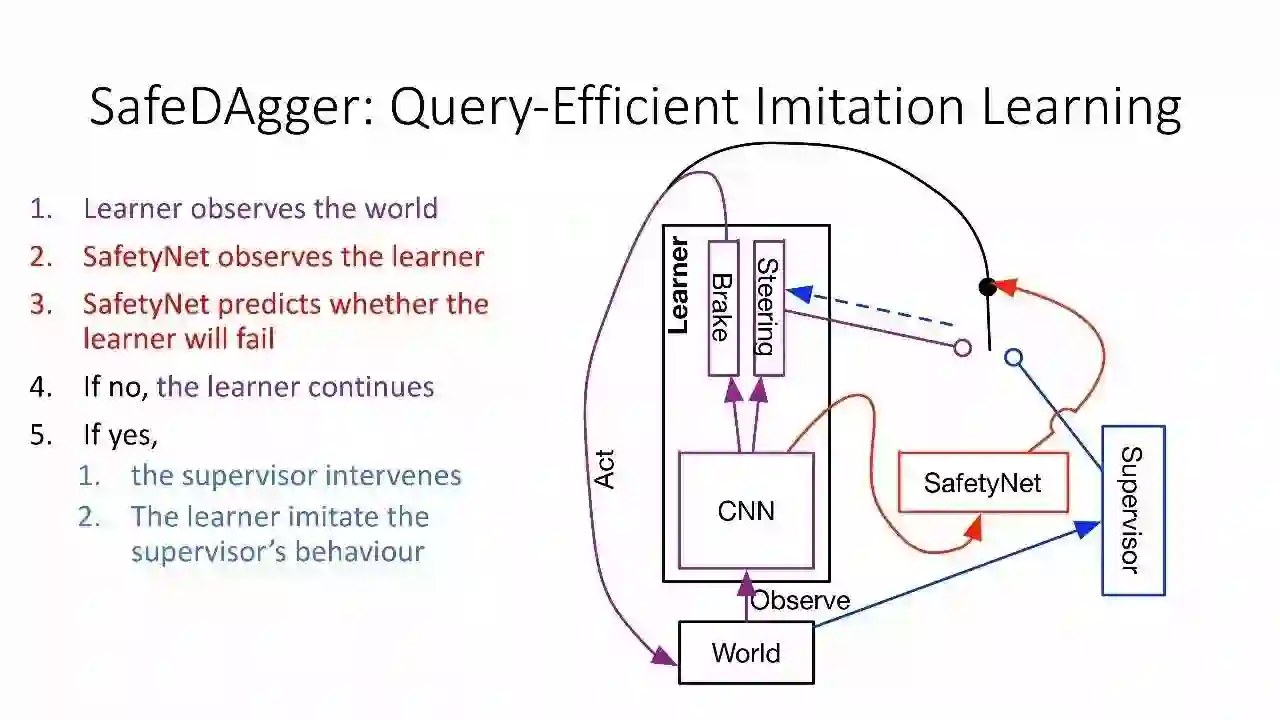

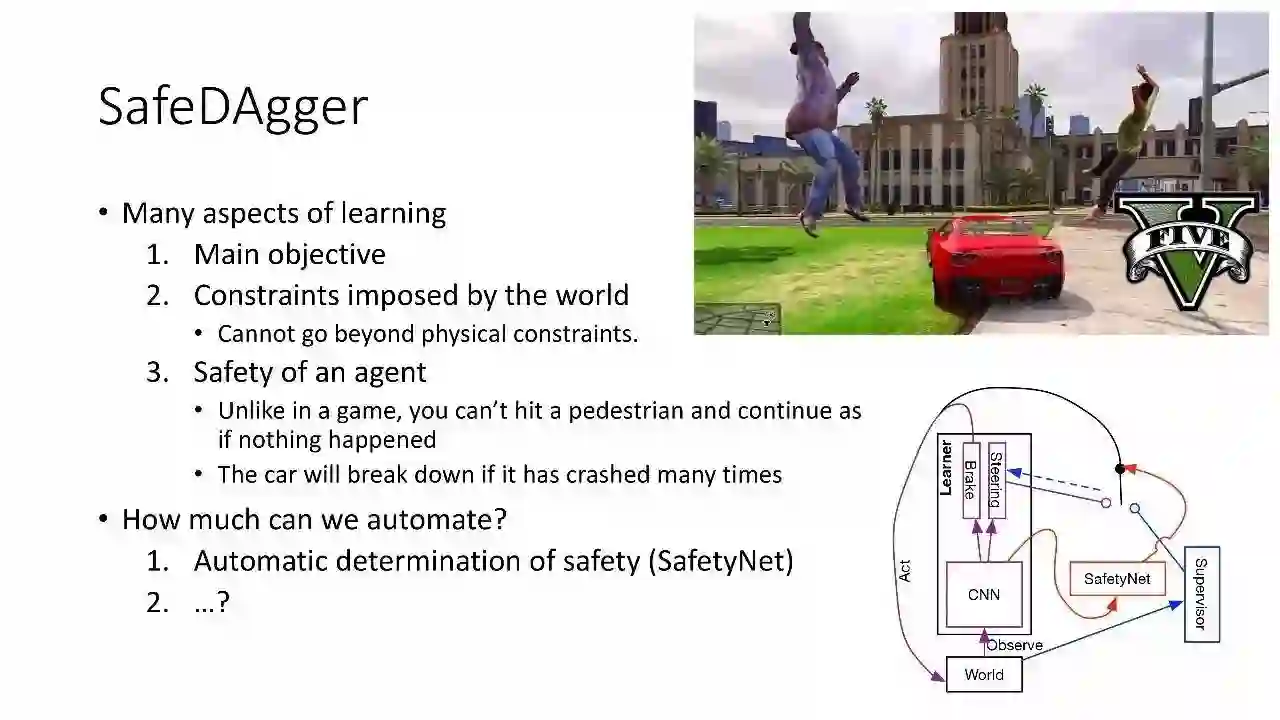

学习者观察世界

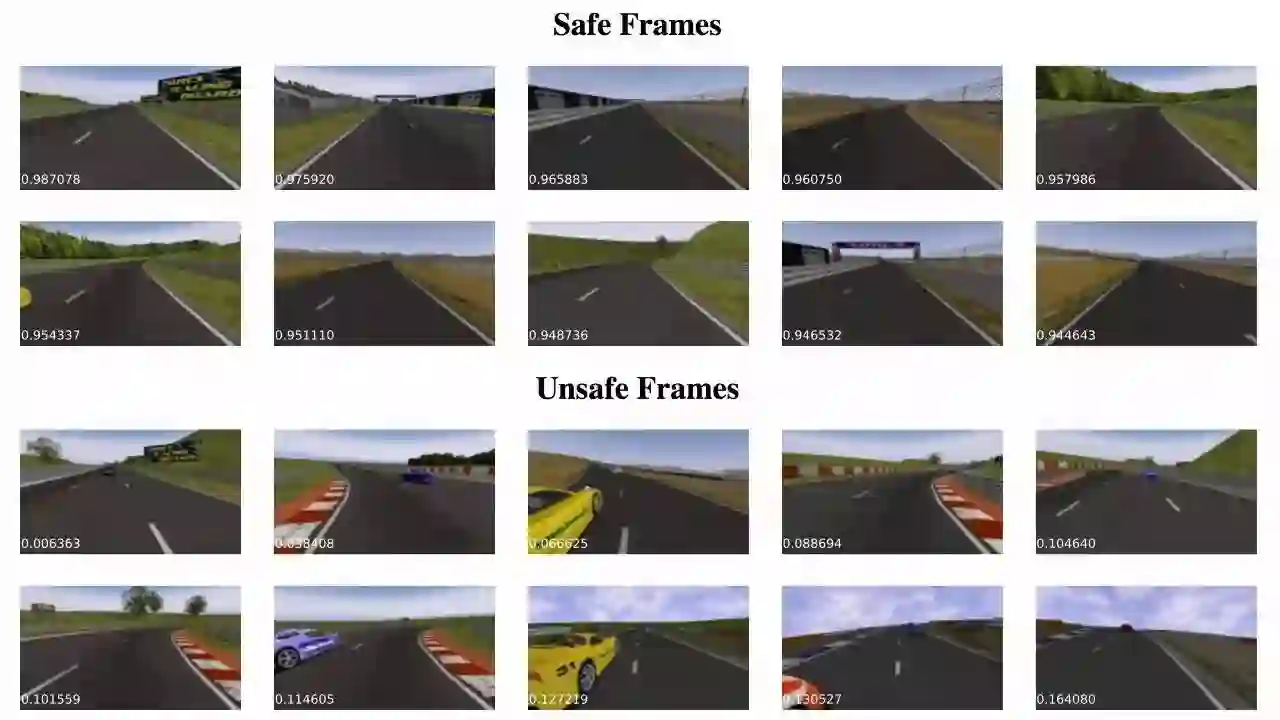

SafetyNet 观察学习者

SafetyNet 预测学习者是否会失败

如果没有失败,学习者会继续下去

如果失败了,①监督者会干预②学习者会模仿监督者的行为

小结:

学习的多个方面

1. 主要目标

2. 世界强加的制约因素

不能超出物理限制

3. agent的安全

这不是在游戏中,你不能撞倒一个行人,然后像什么也没发生一样继续

如果撞到太多次,汽车会爆炸

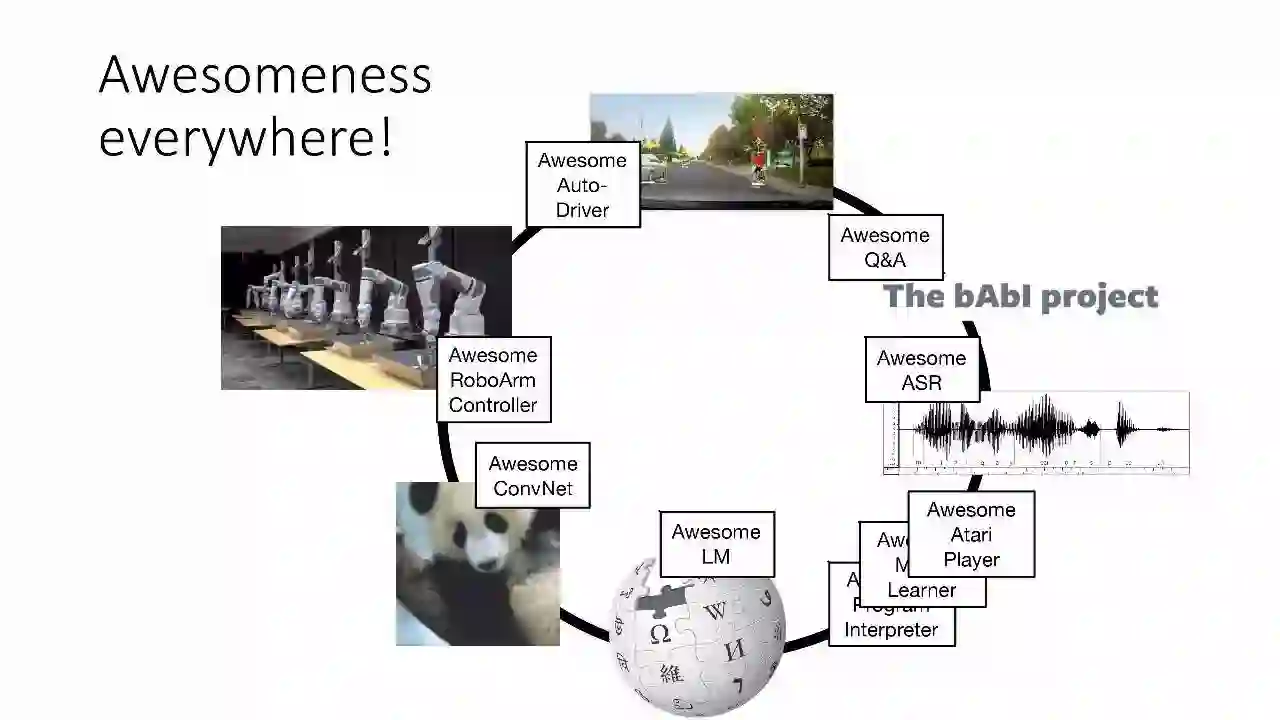

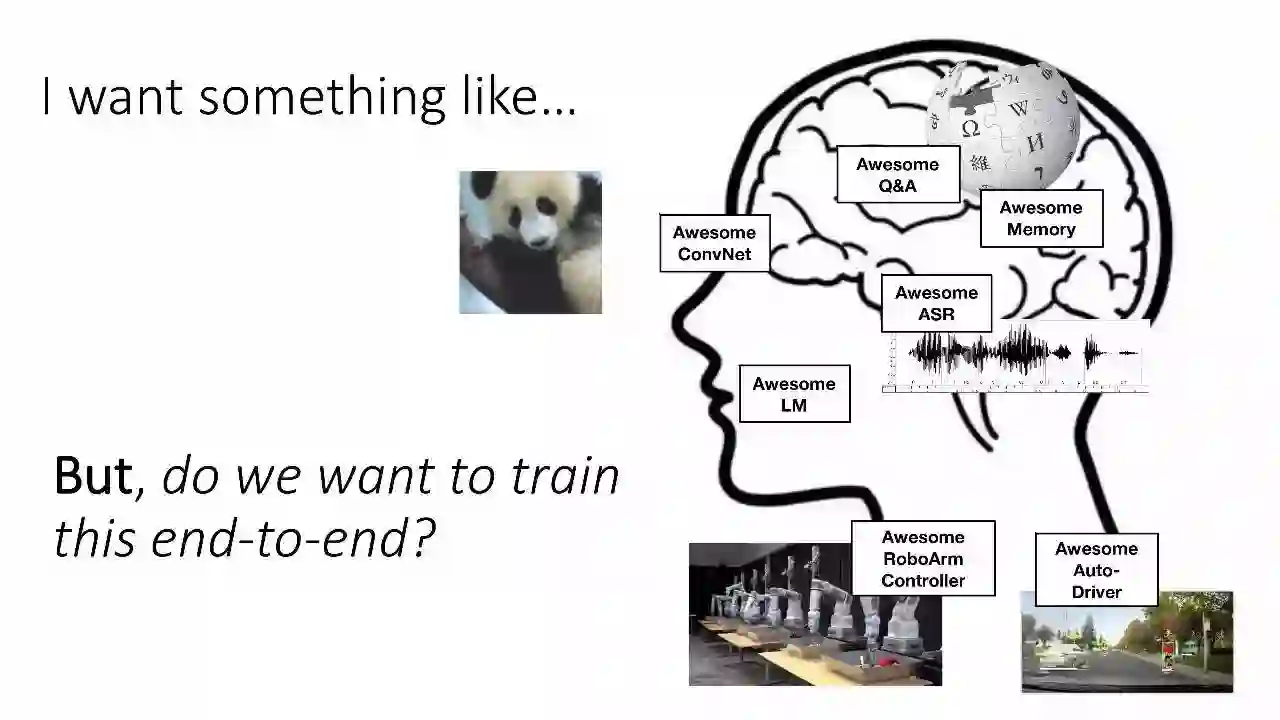

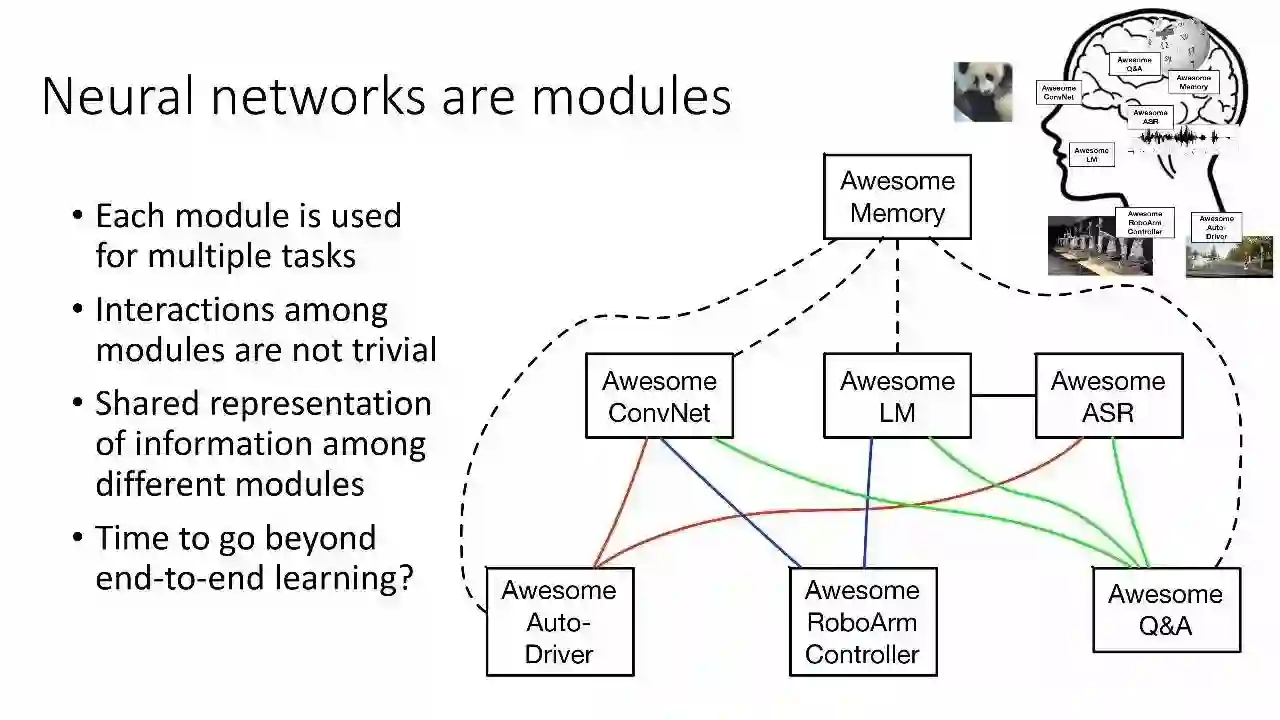

神经网络是模块化的

每个模块都用于多个任务

模块之间的相互作用并不是微不足道的

在不同模块之间共享信息表示

是时候超越端到端学习了?

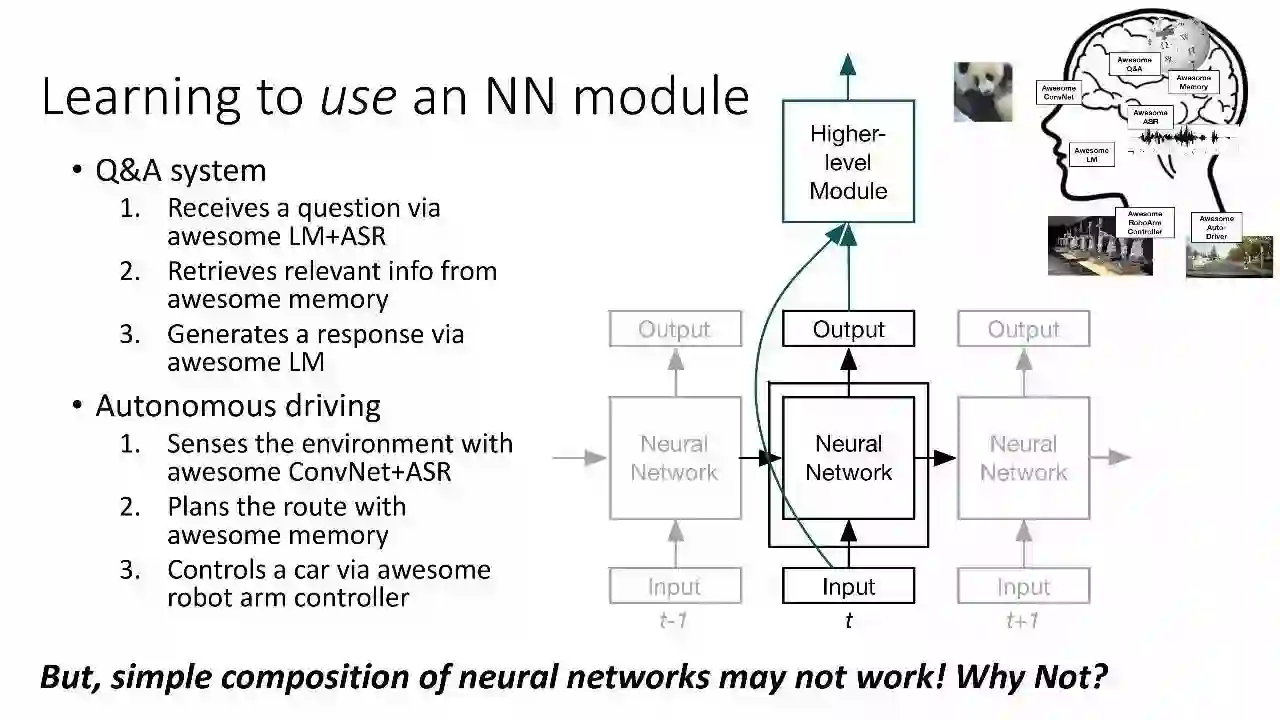

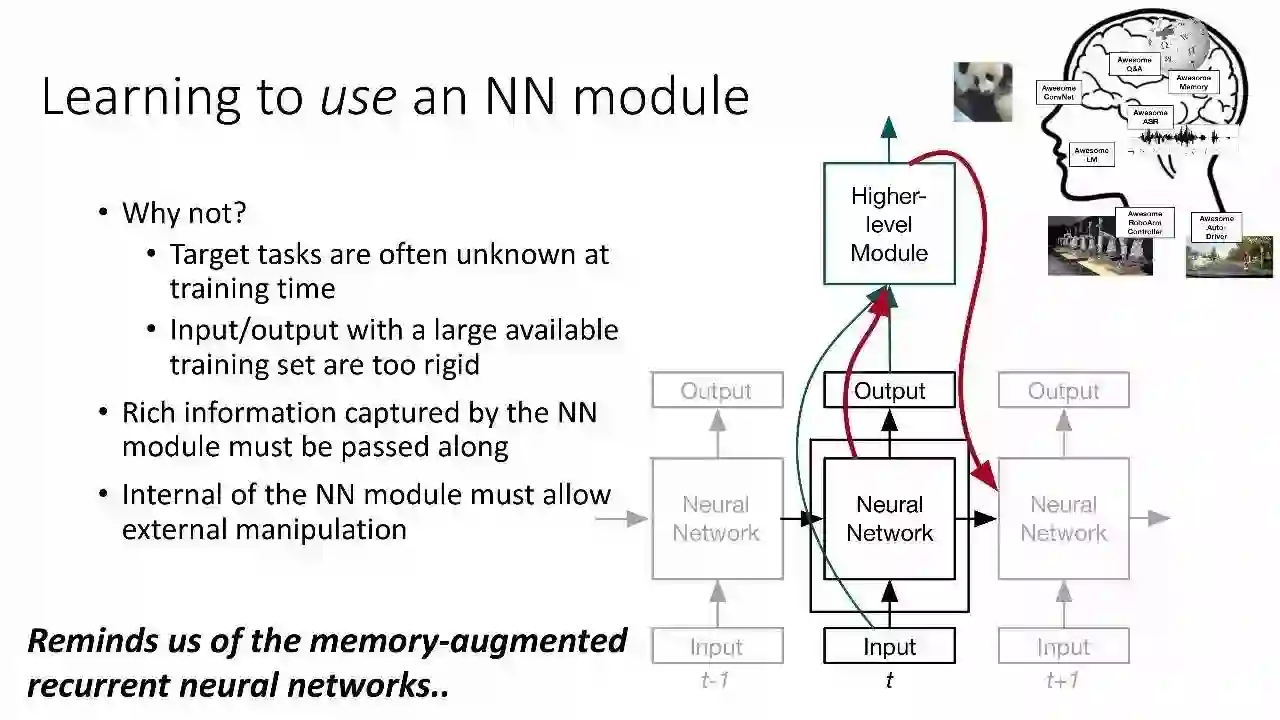

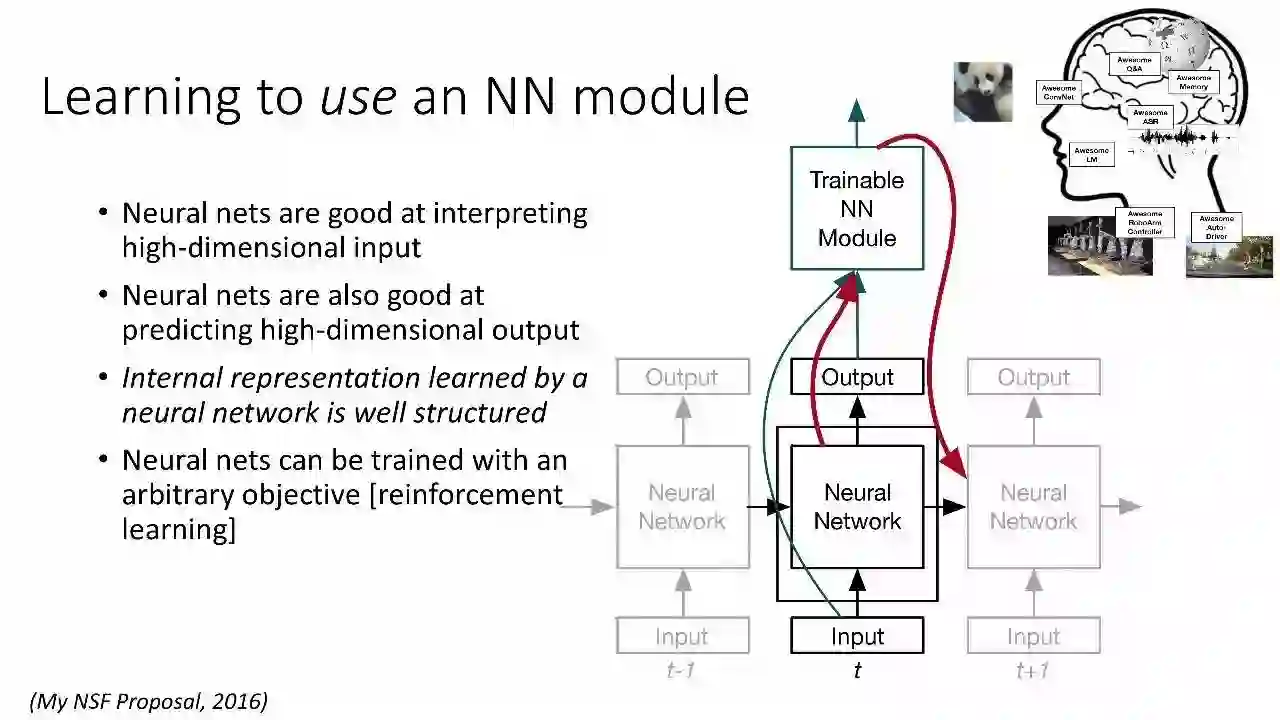

学习使用NN模块

Q&A系统

通过LM + ASR接收到一个问题

在内存中检索相关信息

通过LM生成回应

自主驾驶

通过ConvNet + ASR感受环境

计划路线

通过机器臂控制器控制汽车

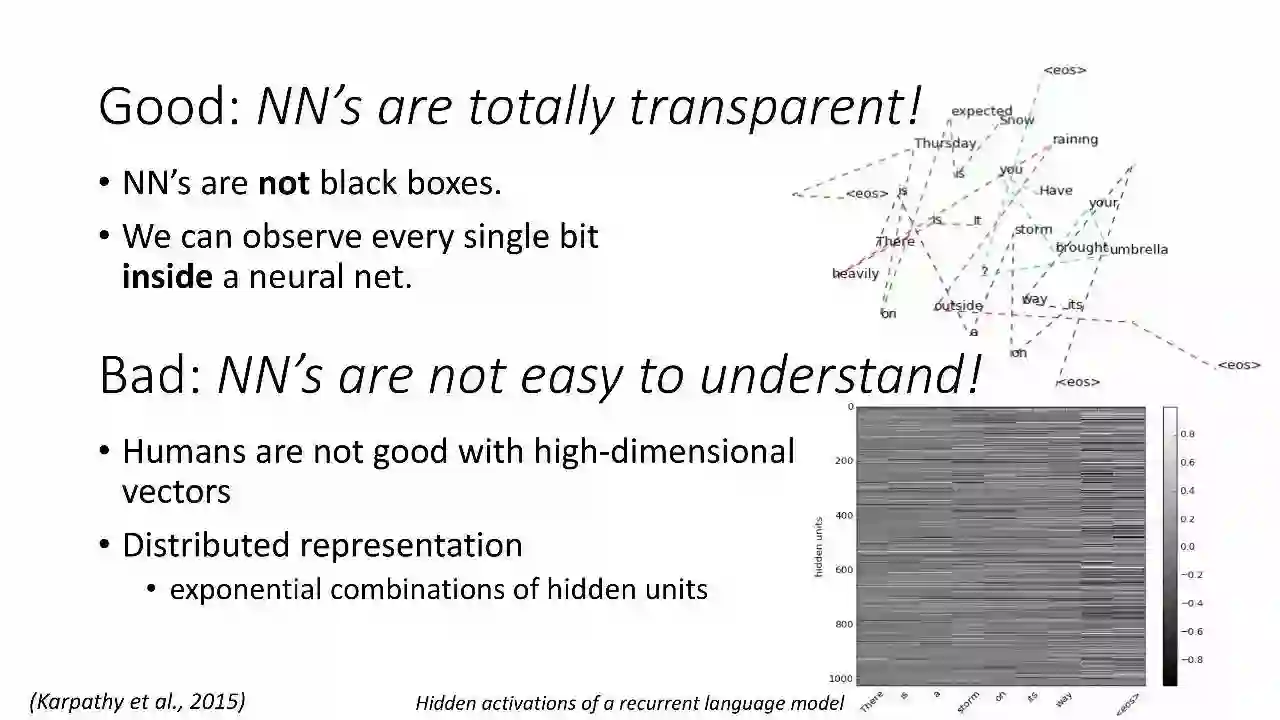

优势:NN是完全透明的!

NN不是黑箱

我们能看到神经网络内部每一个比特

劣势:NN不容易理解!

人类对高维向量的理解不是很好

分布式表示

隐藏单元的指数级组合

学习使用NN模块

神经网络很好地解释了高维输入

神经网络也有利于预测高维输出

由神经网络学习的内部表征结构良好

神经网络可以用任意的目标进行训练[强化学习]

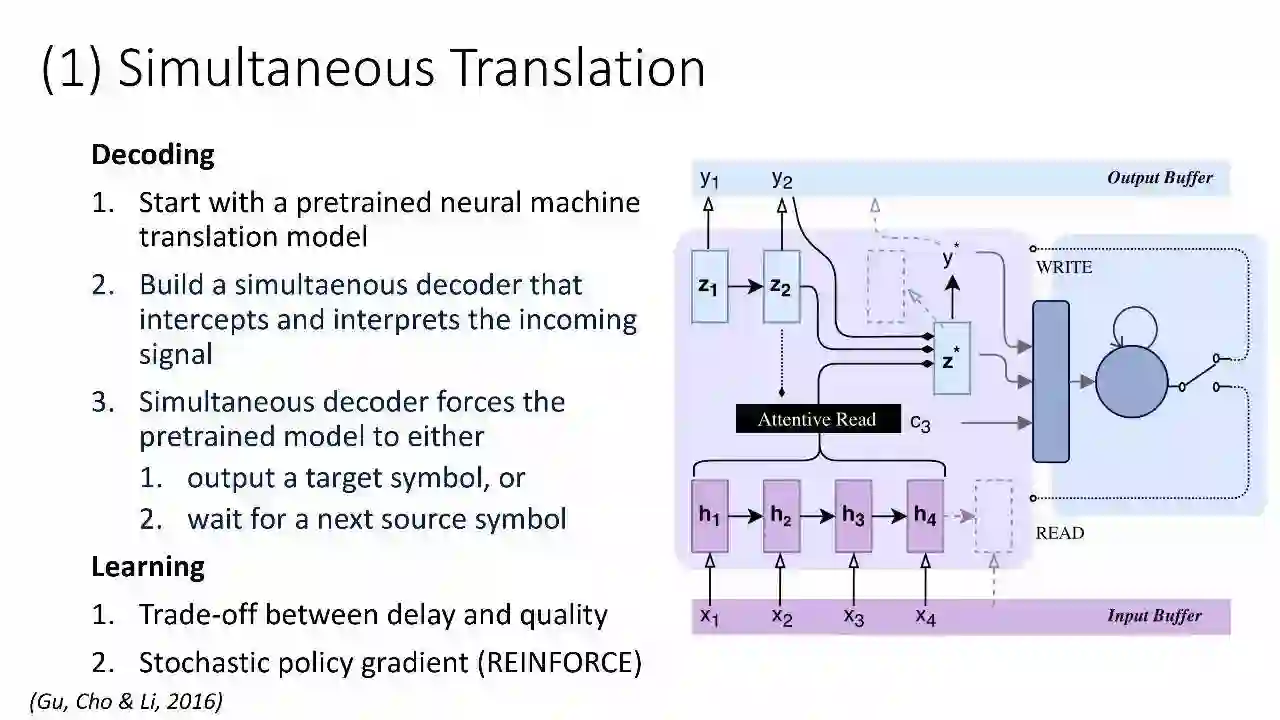

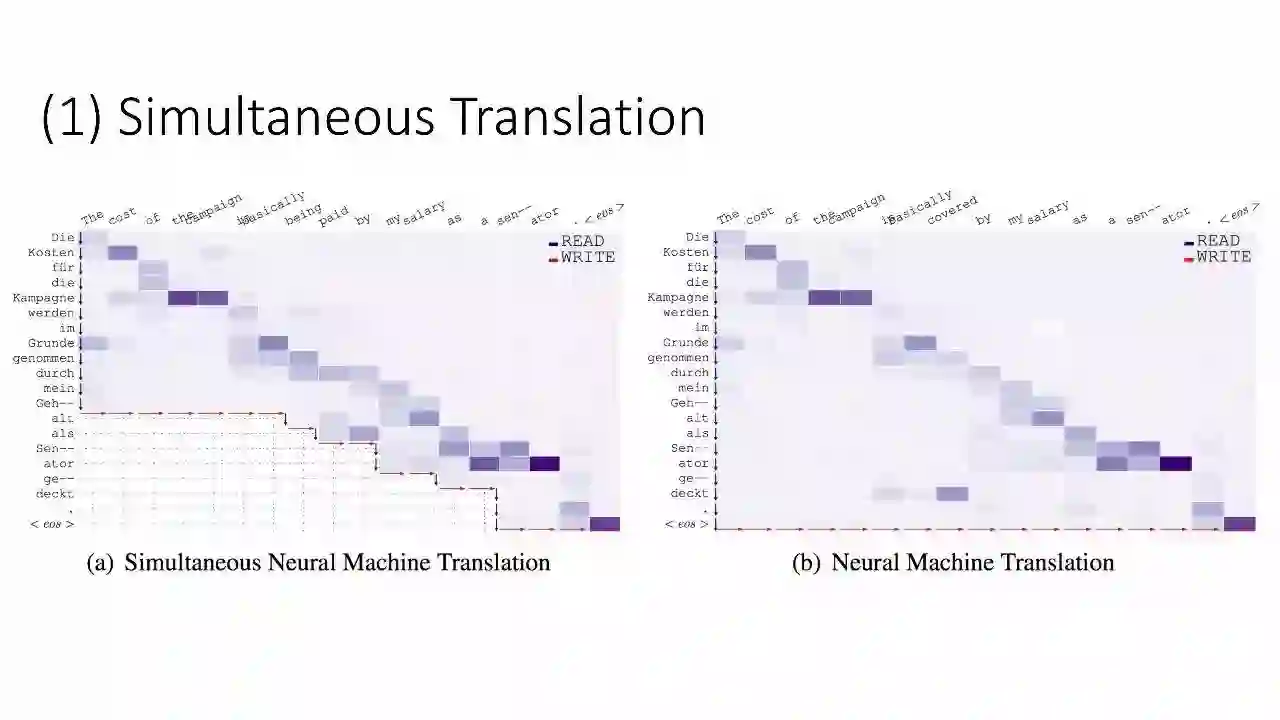

同声传译

解码

1. 从预训练的神经机器翻译模型开始

2.构建一个对输入信号进行拦截和解释的同步解码器

3. 同声传译解码器也强制预培训模型①输出目标符号,或②等待下一个源符号

学习

1. 延迟与质量之间的权衡

2. 随机策略梯度(REINFORCE)

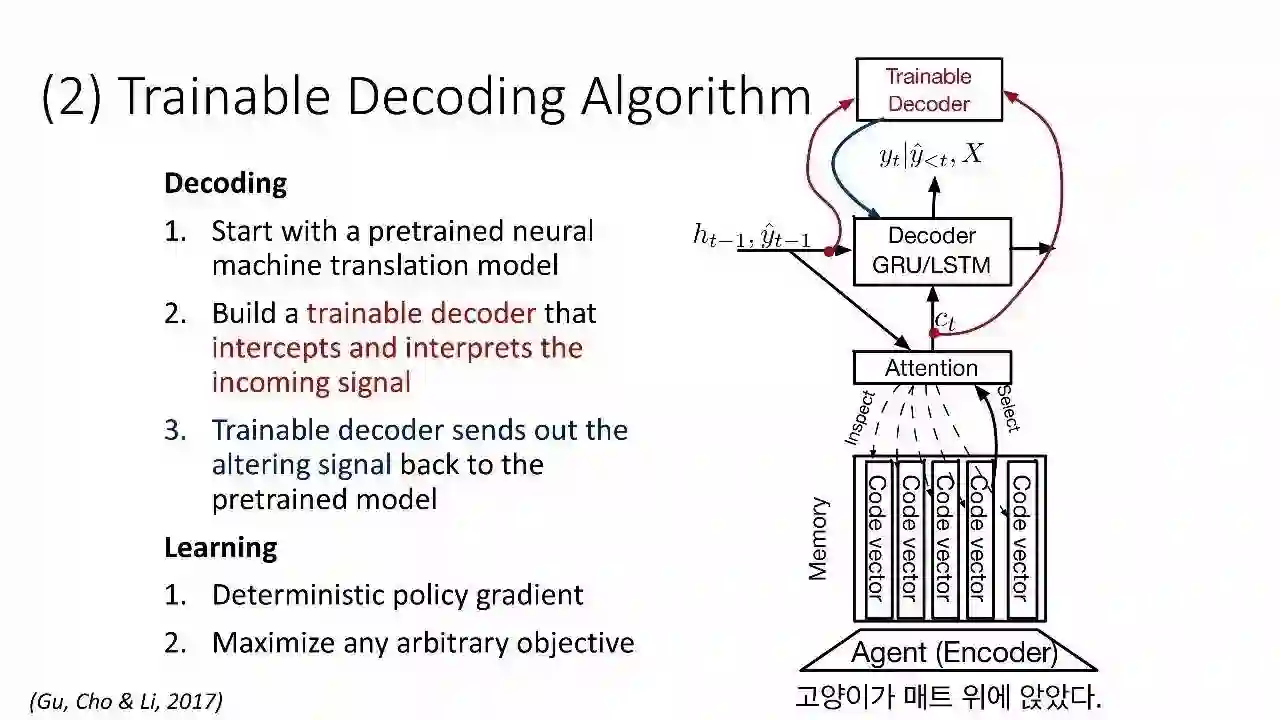

可训练的解码算法

解码

1. 从预训练的神经机器翻译模型开始

2. 构建一个对输入信号进行拦截和解释的可训练解码器

3. 可训练的解码器将已改变的信号返回预训练的模型

学习

1. 确定性政策梯度

2. 最大化任意目标

【号外】新智元正在进行新一轮招聘,飞往智能宇宙的最美飞船,还有N个座位

点击阅读原文可查看职位详情,期待你的加入~