多Agent深度强化学习综述(中文版),21页pdf

近年来, 深度强化学习(Deep reinforcement learning, DRL)在诸多复杂序贯决策问题中取得巨大突破.由于融合了深度学习强大的表征能力和强化学习有效的策略搜索能力, 深度强化学习已经成为实现人工智能颇有前景的学习范式.然而, 深度强化学习在多Agent系统的研究与应用中, 仍存在诸多困难和挑战, 以StarCraft Ⅱ为代表的部分观测环境下的多Agent学习仍然很难达到理想效果.本文简要介绍了深度Q网络、深度策略梯度算法等为代表的深度强化学习算法和相关技术.同时, 从多Agent深度强化学习中通信过程的角度对现有的多Agent深度强化学习算法进行归纳, 将其归纳为全通信集中决策、全通信自主决策、欠通信自主决策3种主流形式.从训练架构、样本增强、鲁棒性以及对手建模等方面探讨了多Agent深度强化学习中的一些关键问题, 并分析了多Agent深度强化学习的研究热点和发展前景.

http://www.aas.net.cn/cn/article/doi/10.16383/j.aas.c180372

强化学习(Reinforcement learning, RL)是机器学习的一个子领域, 学习如何将场景(环境状态)映射到动作的策略, 以获取能够反映任务目标的最大数值型奖赏信号, 即在给定的环境状态下, 决策选择何种动作去改变环境, 使得获得的收益最大[1].同监督式的机器学习过程不同, 在强化学习过程中Agent1不被告知应该采用哪个动作, 而是通过不断与环境交互, 从而试错学习到当前任务最优或较优的策略.这一学习范式能够有效地解决在自然科学、社会科学以及工程应用等领域中存在的序贯决策问题.在强化学习的发展历史中, 强化学习和神经网络的结合已有较长的历史[2], 但是在复杂序列决策问题中始终没有显著的突破.然而, 随着深度学习(Deep learning, DL)在复杂数据驱动任务中展现出的卓越性能[3-4], 一种融合了深度学习强大的特征表示能力和强化学习高效策略搜索能力的学习范式—深度强化学习(Deep reinforcement learning, DRL)逐渐引起学者的广泛关注, DRL是将DL引入到RL, 将深度神经网络引入到RL的值函数、策略函数或者环境模型的参数估计中. DRL在游戏、机器人、自然语言处理等问题中, 取得了令人瞩目的成果[5-12]. AlphaGo的主要贡献者David Silver更是将现代人工智能定义为RL + DL[13], 即DRL才是人工智能的理想范式[14].赵冬斌等[7]认为人工智能将会是各国竞相争夺的下一科技高地.

1Agent:是学习者和决策者, 能够获取自身之外的环境信息, 采用学习算法, 对环境变化做出合适响应.

伴随着DRL在一些复杂单Agent任务中的有效应用, 人们又将DRL的研究成果转移到了多Agent系统(Multi-agent system, MAS)的应用中, 以期获得同样的突破. MAS由一组利用传感器感知共享环境的自治、交互的Agent组成, 每个Agent独立地感知环境, 根据个人目标采取行动, 进而改变环境[15].在现实世界中, 存在许多MAS的实例, 例如资源调度管理[16]、拥塞处理[17-19]、通信传输[20]、自动驾驶[21]、集群规划[22-25]等.

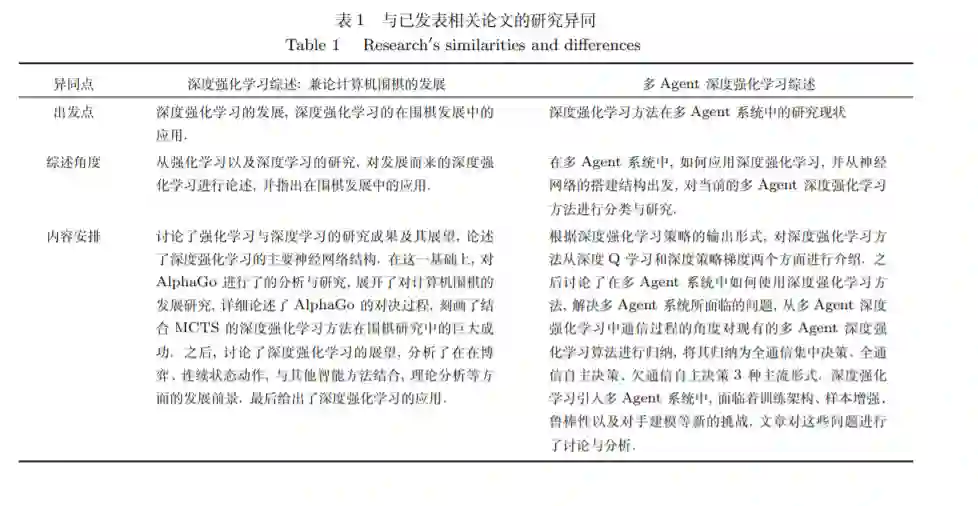

多Agent DRL (Multi-agent DRL, MADRL)是DRL在MAS中应用的研究分支, 理论基础源于DRL.虽然将DRL应用于MAS中有着许多研究, 但据我们所知, 尚没有关于多Agent DRL研究的综述性报告, 赵冬斌等[7]对DRL以及围棋的发展进行了综述, 但其出发点、综述角度以及内容安排与本文有较大不同, 如表 1所示.本文在对近些年国内外的研究现状进行分析与研究后, 从MADRL设计与实践的角度出发, 对这一领域进行归纳总结.

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“MARL” 可以获取《多Agent深度强化学习综述(中文版),21页pdf》专知下载链接索引