ICLR2021有什么值得关注的GNN论文?

ICLR2021投稿的3篇值得关注的图相关论文:

1.图-图相似网络——将图分类问题转化为一个经典的节点分类问题2.如何找到你的友好邻里:自监督的图注意设计——提出了一种改进的噪声图的图注意模型——自监督图注意网络(SuperGAT)

3.基于边割的图神经网络汇聚——提出了一种基于图的边割的池层来提高分类精度

1. GRAPH-GRAPH SIMILARITY NETWORK

当GNN显式聚合邻域信息并隐式捕捉图的拓扑结构时,它们忽略了图之间的关系。此文提出了一种图-图相似网络,通过学习图之间的关系来构造超图来解决图的分类问题。 超图中的每个节点代表一个输入图,边的权重表示图之间的相似性。通过这种方法,将图分类问题转化为一个经典的节点分类问题。

-

使用对抗自动编码器将所有图的嵌入对齐到相同的分布。 -

对齐后,设计图-图相似度网络来学习图之间的相似度,作为超图的邻接矩阵。通过在超图上运行节点分类算法,可以预测图的标签。

在五个广泛使用的基准上的公平设置下的实验证明了该方法的有效性。

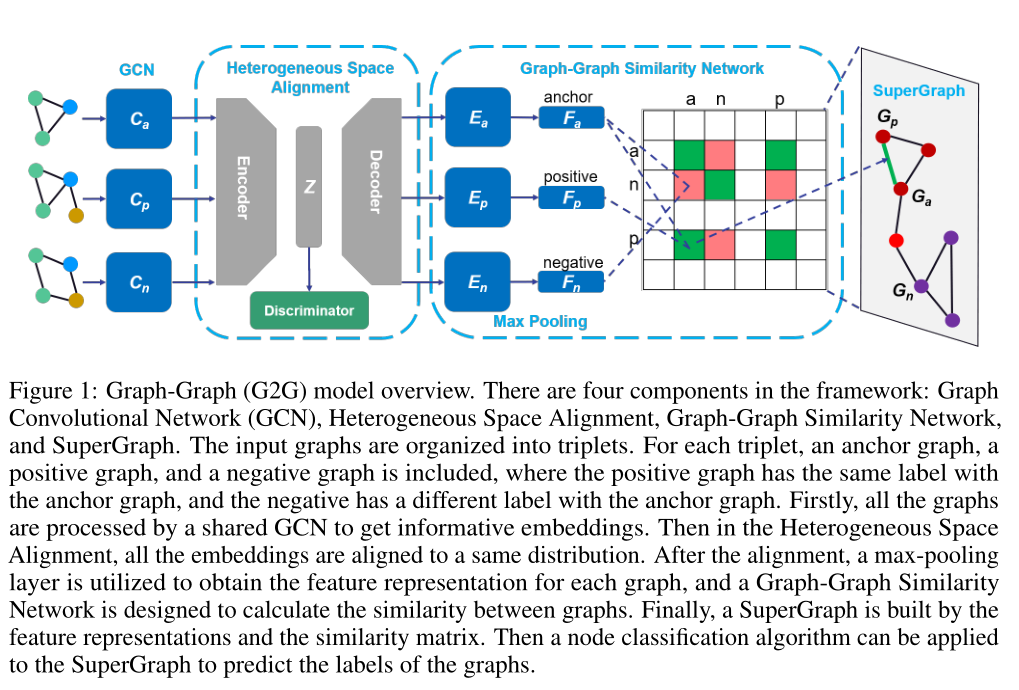

模型图

该框架由四个部分组成:图卷积网络(GCN)、异构空间对齐、图-图相似网络和超图。输入图被组织成三元组。对于每个三元组,包括锚图、正图和负图,其中正图具有与锚图相同的标签,而负图具有与锚图不同的标签。

首先,所有的图都由一个共享的GCN进行处理,以获得信息嵌入。然后,在异构空间对齐中,所有的嵌入都对齐到相同的分布。对齐后,利用最大汇聚层来获取每个图的特征表示,并设计图-图相似度网络来计算图之间的相似度。最后,利用特征表示和相似度矩阵构造超图。然后,可以将节点分类算法应用于超图,以预测图的标签。

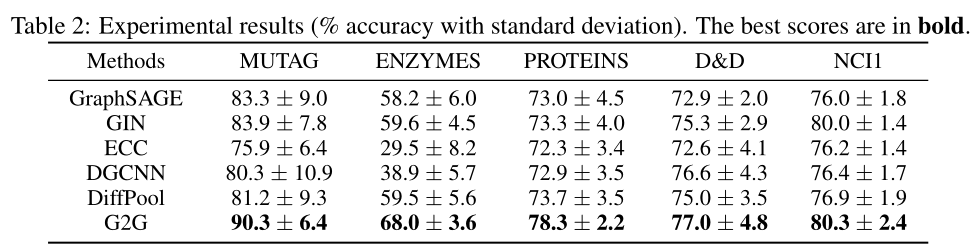

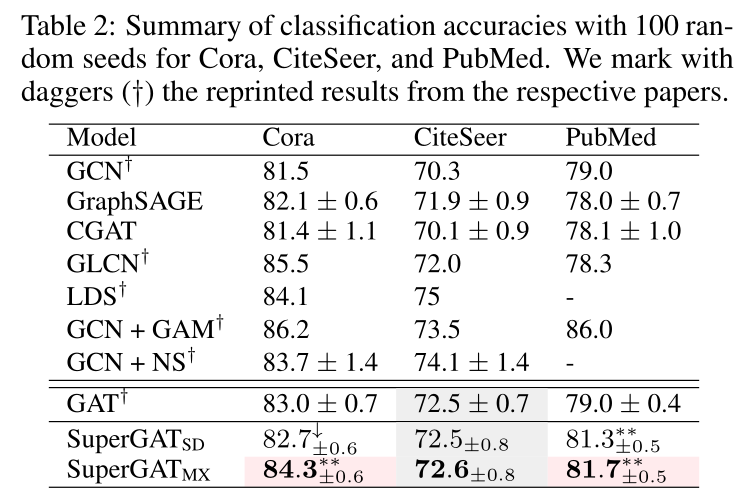

实验结果

2. HOW TO FIND YOUR FRIENDLY NEIGHBORHOOD:GRAPH ATTENTION DESIGN WITH SELF-SUPERVISION

图神经网络中的注意力机制被设计为给重要的邻居节点分配较大的权重,以便更好地表示。然而,图注意力学到的东西并没有被很好地理解,特别是当图是有噪音的时候。此文提出了一种改进的噪声图的图注意模型——自监督图注意网络(SuperGAT)。

-

利用两个与自监督任务兼容的注意力表格来预测边,它们的存在和不存在包含了关于节点之间关系重要性的内在信息。 -

通过对边进行编码,SuperGAT在区分错误链接的邻居时学习了更多的表达注意力。

作者发现两个图特征影响注意形式和自我监督的有效性:同质性和平均度。因此,提出的方法提供了在这两个图特征已知时使用哪种注意设计的说明。在17个真实世界数据集上的实验表明,所提方法适用于其中15个数据集,并且由它设计的模型显示出比基线更高的性能。

实验结果

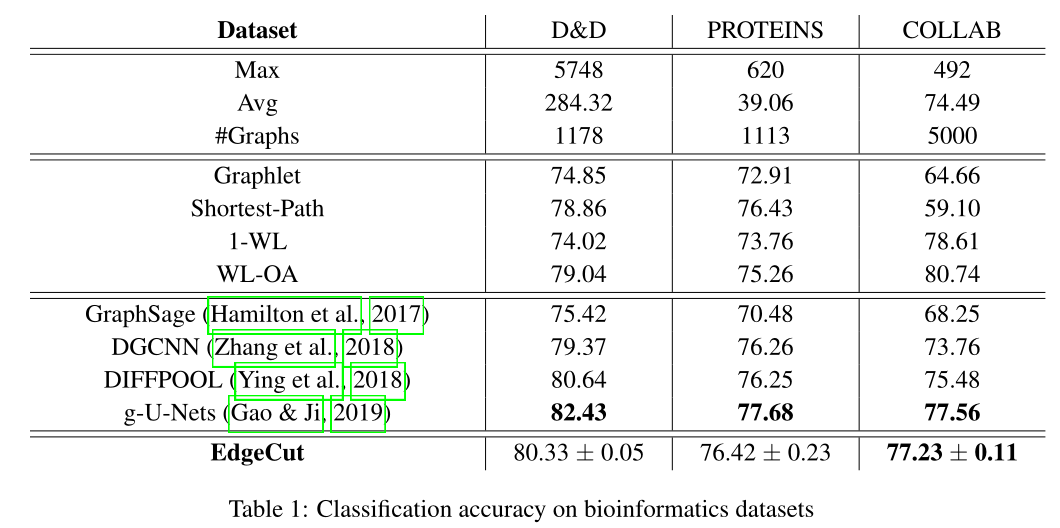

3. GRAPH NEURAL NETOWRK POOLING BY EDGE CUT

图神经网络(GNNs)在解决图中的节点分类或图分类等问题时非常有效。它们来自于图像上的卷积神经网络到图结构数据的扩展。这些模型在图像识别中非常有效。导致他们成功的另一个方面是他们发现等级结构的能力。这来自于以不同的比例生成不同尺度的输入图像的池操作。同样,为了提高分类精度,我们希望在图中识别不同尺度的模式。 与图像的情况相比,在图上开发池层并不是一件容易的事。这主要是因为在图中,节点是无序的,并且具有不规则的邻域。

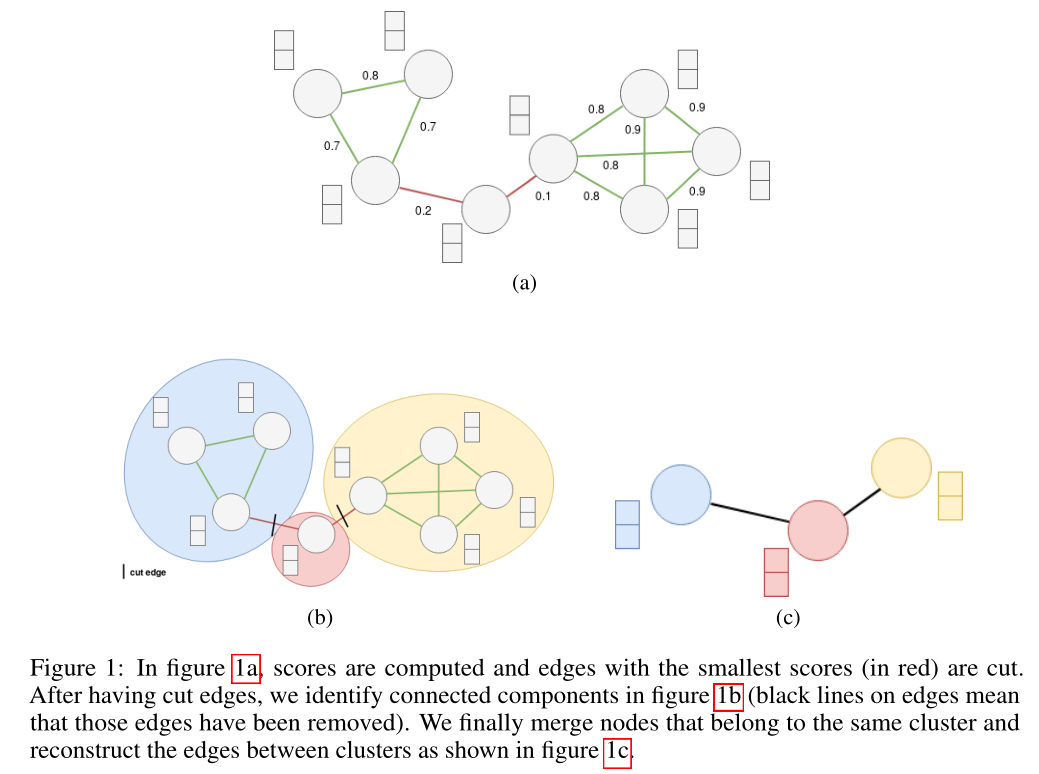

为了解决这个问题,此文提出了一种基于图的边割的池层。该汇聚层通过计算与GNN的信息传播过程中的边的重要性相对应的边分数来工作。此外,作者定义了一个正则化函数,目的是产生最小化minCUT问题的边缘分数。最后,通过大量的实验证明了该体系结构可以与最先进的方法相抗衡。

模型图

实验结果

由于微信平台算法改版,公号内容将不再以时间排序展示,如果大家想第一时间看到我们的推送,强烈建议星标我们和给我们多点点【在看】。星标具体步骤为:

(1)点击页面最上方"AINLP",进入公众号主页。

(2)点击右上角的小点点,在弹出页面点击“设为星标”,就可以啦。

感谢支持,比心

推荐阅读

征稿启示| 200元稿费+5000DBC(价值20个小时GPU算力)

完结撒花!李宏毅老师深度学习与人类语言处理课程视频及课件(附下载)

模型压缩实践系列之——bert-of-theseus,一个非常亲民的bert压缩方法

文本自动摘要任务的“不完全”心得总结番外篇——submodular函数优化

斯坦福大学NLP组Python深度学习自然语言处理工具Stanza试用

关于AINLP

AINLP 是一个有趣有AI的自然语言处理社区,专注于 AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括文本摘要、智能问答、聊天机器人、机器翻译、自动生成、知识图谱、预训练模型、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLPer(id:ainlper),备注工作/研究方向+加群目的。

阅读至此了,分享、点赞、在看三选一吧🙏