IJCAI 2022 | 图结构学习最新综述:研究进展与未来展望

©作者 | Dream

单位 | 浙江大学

研究方向 | 图表示学习

论文标题:

A Survey on Graph Structure Learning: Progress and Opportunities

论文链接:

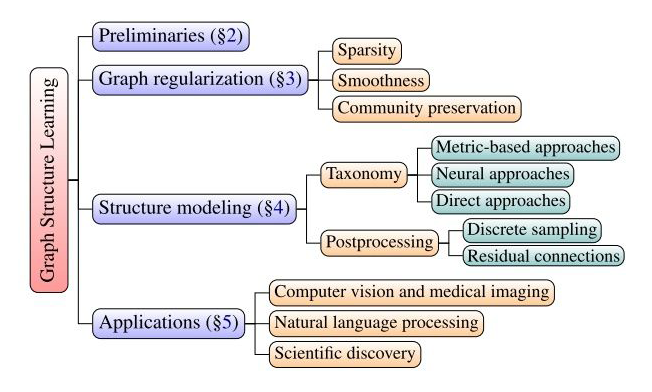

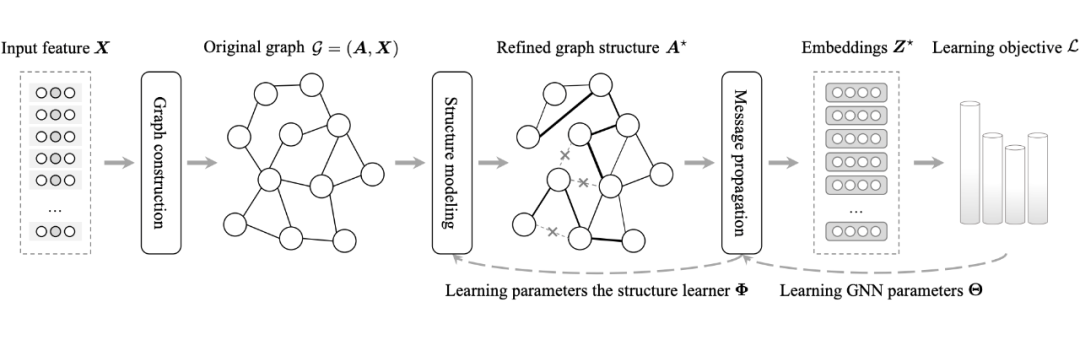

Please kindly note that GSL, although conceptually related, is fundamentally distinct to related problems such as graph generation that target at generating novel, diversified graphs [Du et al., 2021], or graph learning that aims to recover the Laplacian matrix of a homophilous graph corresponding to given node features.

-

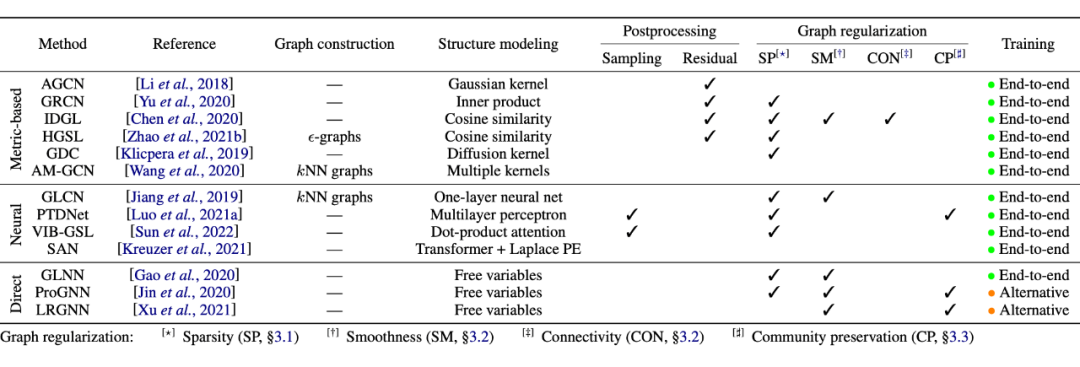

Metric-based approaches: 利用一些度量函数(将节点对表征作为输入)来获得节点对的边权。

-

Neural approaches:给定节点表征,利用神经网络推理边权。

Direct approaches:将邻接矩阵看作是自由学习矩阵,通过 GNN 的参数来优化它们。

Structure Learnig

1.1 Metric-based Approaches

1.2 Neural Approaches

1.3 Direct Approaches

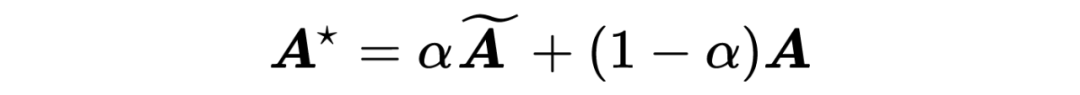

Postprocessing Graph Structures

2.1 离散采样

2.2 Residual Connections

挑战和未来展望

总结

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧