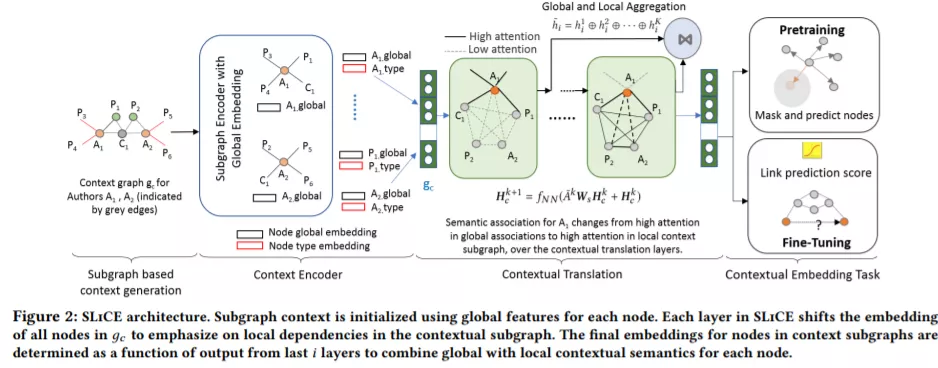

异构网络的表示学习方法为每个节点产生一个低维向量嵌入,通常在所有涉及节点的任务中都是固定的。许多现有的方法关注于以一种与下游应用程序无关的方式获取节点的静态向量表示。然而,在实践中,下游任务(如链接预测)需要特定的上下文信息,这些信息可以从与节点相关的子图中提取出来,作为任务的输入。为了解决这一挑战,我们提出了SLiCE,这是一个使用整个图的全局信息和局部注意驱动机制来学习上下文节点表示的静态表示学习方法的框架。我们首先通过引入高阶语义关联和屏蔽节点以自监督的方式预训练我们的模型,然后针对特定的链接预测任务微调我们的模型。我们不再通过聚合所有通过元路径连接的语义邻居的信息来训练节点表示,而是自动学习不同元路径的组合,这些元路径表征了特定任务的上下文,而不需要任何预先定义的元路径。SLiCE在几个公开可用的基准网络数据集上显著优于静态和上下文嵌入学习方法。通过广泛的评价,我们也证明了上下文学习的可解释性、有效性和SLiCE的可扩展性。

成为VIP会员查看完整内容

相关内容

Arxiv

14+阅读 · 2021年1月29日