文本分类是自然语言处理领域中常见的任务,机器学习和深度学习在该任务中已有较多研究并取得了很大进展,然而,这些传统方法只能处理欧氏空间的数据,不能完全有效地表达出文本的语义信息。为了打破传统的学习模式,诸多研究开始尝试用图表示文本中各实体间的丰富关系,并利用图卷积神经网络学习文本表示。文中对基于图卷积神经网络的文本分类方法进行了综述,首先概述了图卷积神经网络的背景与原理;其次,利用不同类型的图网络详细阐述了基于图卷积神经网络的文本分类方法,同时分析了图卷积神经网络在网络深度上的局限性,并介绍了深层网络在文本分类任务上的最新进展;最后,通过实验比较了各模型的分类性能,并探讨了该领域的难点与未来的发展方向。

文本分类是自然语言处理领域中的一个重要且具有挑战 性的应用分支,该任务是利用文本处理技术对一段给定的文 本内容进行分析,进而对其进行分类,并为其分配一个或多个 类别标签.常见的应用场景有文档主题分类[1]、垃圾邮件识 别[2]、情感分析[3]等.文本分类的处理流程大致分为文本预 处理、文本特征提取以及模型的构建等,其难点在于文本特征 的提取,即如何在保留文本语义信息的前提下对文本信息进 行向量化表示. 传统的文本 分 类 方 法 主 要 分 为 两 种,一 种 是 基 于 机 器 学习的文本分类方法[4],另一种是基于深度学习的文本分类 方法[5].机器学习方法在发展初期常被用于解决文本分类问 题,常见 的 分 类 器 有 支 持 向 量 机 (SupportVector Machine, SVM)、朴素贝叶斯(NaiveBayes,NB)、K 近邻算法(KGNeaG restNeighbor,KNN)[6]等.其基本思路是利用特征工程进行 文本表示,再通过分类器训练预测文本的类别.其中,特征工 程主要包括特征提取和特征选择两种操作,例如,Joachims [7] 提出将SVM 模型应用于文本分类任务,其原理是采用词袋 模型将文本映射成固定长度的向量,再通过信息增益准则选 择特征以实现降维,最后利用 SVM 分类器对处理后的特征 向量进行迭代训练,达到了不错的分类效果.除词袋模型外,nGgrams模型[8]也常被用于特征提取.然而传统的特征提取 方法存在很多弊端:其一,在大型语料库中容易产生较多的参 数;其二,最终映射的向量过于稀疏. 相较于机器学习,深度学习的优势在于其利用自身的网 络结构可以自动学习数据的特征表示,而无须人工进行特征 工程.常 用 的 模 型 有 卷 积 神 经 网 络 (ConvolutionalNeural Networks,CNNs)[9]、循 环 神 经 网 络 (RecurrentNeuralNetG works,RNNs)[10]等.例如,TextCNN 模型[11]解决了句子级 别的文本分类任务,该方法将句子视为由多个词向量构成的 特征矩阵,并利用不同大小的卷积核对其进行一维卷积,随后 通过最大池化层提取每个特征图中最重要的特征.而 Zhang 等[12]使用了字符级别的 CNN 结构,也取得了可观的分类效 果.Liu等[13]实现了 RNN 模型在文本分类上的应用.TexG tRNN 与 CNN 不同,TextRNN 模型将文本看成一段时间序 列,并结合上下文信息学习文本的特征表示.HAN(HierarG chicalAttentionNetworks)模型[14]在 TextRNN 模型的基础 上引入注意力机制[15],提出“单词G句子G文本”的文本层次化 结构,并分别给予其不同的注意力权重,从而具有不同程度的 表达能力.

然而,机器学习和传统的神经网络只能处理欧几里得数 据.例如,图像和视频就属于欧氏空间的数据,前者是由像素 点构成的规则的二维数据,而后者则是时间序列上的图像数 据.传统神经网络如 CNN 通常将这类数据作为输入,利用 其平移不变性有效地获取数据的局部特征信息.对于文本这 种非欧几里得数据而言,传统方法也是先将文本数据转化为 由词、短语或句子等语言单位组成的二维向量矩阵,再利用网 络模型加以训练,但是非网格化结构的数据常常限制了神经 网络的表达能力,尤其是包含复杂语法结构的文本.在这样 的背景下,图卷积神经网络(GraphConvolutionalNetworks, GCNs)[16]的出现引起了文本分类领域的广泛关注.图卷积 神经网络以图的形式表示文本,图可以很直观地表达出文本 中各元素间的丰富关系,并且图网络能够利用节点间的连接 关系保留全局的图信息.近年来,大量研究利用该特点努力 探索将图卷积神经网络应用于文本分类任务,以表达文本中 的语义关系.

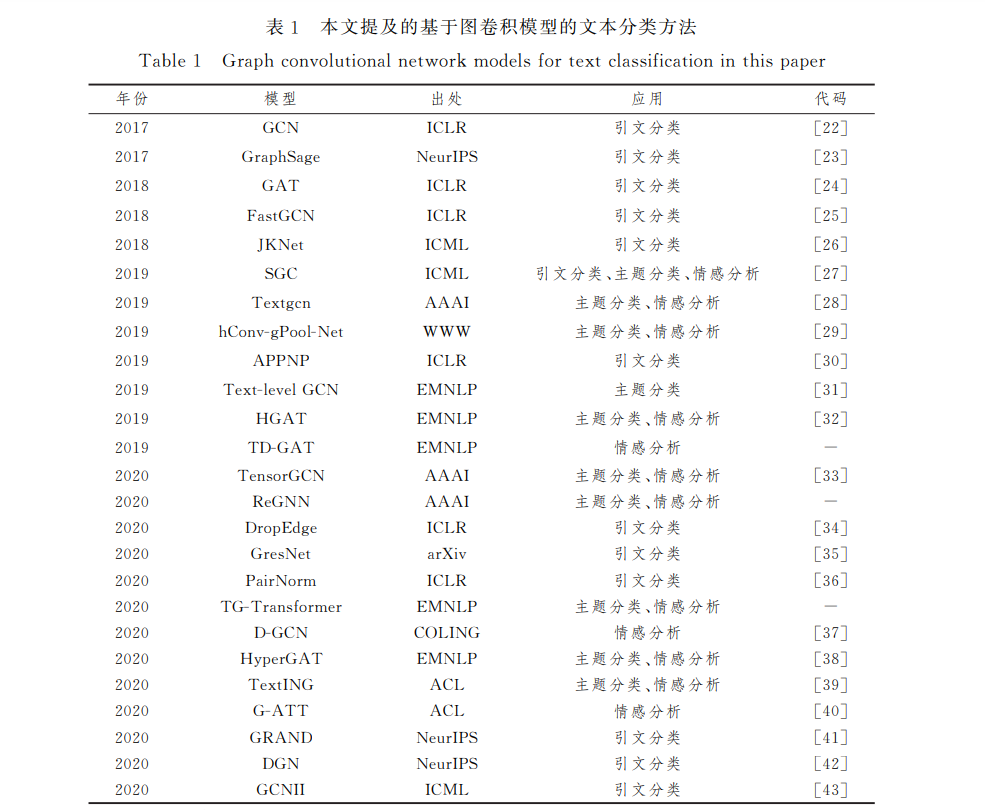

虽然目 前 已 有 一 些 综 述 文 章 分 别 围 绕 图 卷 积 神 经 网 络[17G19]和文本分类研究领域[20G21]展开,但目前缺少对这两者 结合的综述.为此,本文总结并分析了近5年内图卷积神经 网络在文本分类任务上的发展和趋势,并通过实验分析比较 了它们的分类性能.所提及的主流方法均出自水平较高的人 工智能期刊或会议,其相关模型信息如表1所列,包括发表年 份、模型名称、发表的出处、具体的应用场景以及代码链接.

本文第2节详细介绍了图 卷 积 神 经 网 络 的 演 变 过 程; 第 3 节 主 要 从 4 种 不 同 类 型 的 图 模 型 分 别 阐 述 近 年 来 图 卷积神经网络在文本分类领域中的 发 展 与 改 进;第 4节 主 要概述图卷积神经网络的 深 度 局 限 性 以 及 改 进 方 法;第 5 节主要通过实验对一些相关模型进 行 分 析 对 比;第 6节 探 讨了未来的发展方向.