![]()

导读

2020年5月23日,有幸受邀在中国中文信息学会青年工作委员会主办的

AIS(ACL-IJCAI-SIGIR)

2020顶会论文预讲会上介绍了ACL会议近年来的研究趋势,特整理成幻灯片配文字版,希望对相关领域的研究者有所帮助。由于视野所限,时间仓促,特别是ACL 2020的录用论文列表刚发布不久,因此统计的数据和得出的结论难免有失偏颇,如有不当之处,还敬请指出。另外,特别感谢组内的多位博士生帮助进行数据整理。

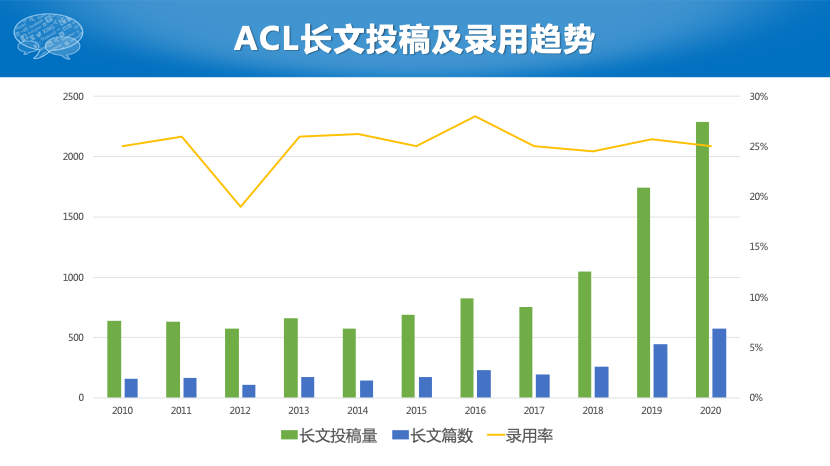

首先来看一下2010年到2020年这11年来,ACL长文的录用情况和趋势,可以看出从2018年开始,投稿和录用的数量急剧上升,说明作为人工智能皇冠上的明珠,自然语言处理领域越来越受到研究界的关注。另外,ACL的录用率多年来基本保持稳定,一直在25%左右。

再来看一下今年录用文章标题的词云,从中可以看出大家关注比较多的任务有生成、翻译、对话、问答、抽取、句法等方向,用到的方法多涉及到神经、网络、注意力、图等。另外,从文章作者的词云可以看出前几名的基本都是中国的大姓,这也反应出华人作者在ACL顶会上已经占据非常大的比例。

为了更直观的了解近年来ACL各个研究领域的变化趋势,我们做了一个领域趋势竞赛图,帮助大家更好地看出各个研究领域此消彼长的变化过程。特别说明的是,我们的领域是参考ACL 2019进行划分的,由于其它年份的领域划分方式不尽相同,我们采用人工的方式进行了映射。另外,由于2020年目前只有文章列表,还没有领域数据,所以也是人工逐篇文章分的类,因此具有一定的主观性,有可能不是特别准确。

从这段视频中,我们可以看到几个非常明显的趋势,比如人机对话等新兴领域上升势头迅猛,而句法分析、机器翻译等传统领域有所衰落。下面,就几个变化比较明显的领域分别加以介绍。

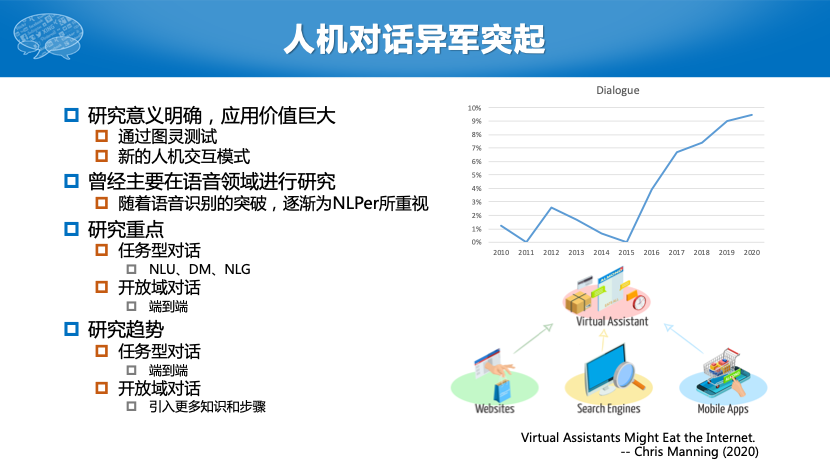

人机对话异军突起

2015年之前,ACL上几乎没有人机对话的文章发表,但是从2016年开始,随着语音识别技术的突破,NLPer开始重视人机对话的研究,今年ACL该方向上的研究重点和研究趋势如下图所示。

机器学习持续热门

可以看到近10年来,机器学习的热度一直居高不下,特别是随着预训练模型的成功,NLP模型大有被大一统的趋势。下面的一些机器学习研究方向为今年ACL所重点关注。

严格来讲自然语言处理应被分为自然语言处理和自然语言生成两个方向,然而受到技术的限制,传统的文本生成多采用基于模板的方法,因此在研究上并没有引起太多的关注。随着序列到序列模型的产生,人们意识到可以采用类似的方法进行逐词的文本生成,从而产生了大量的研究和应用问题,因此文本生成也成为了目前自然语言处理的热门研究领域。今年ACL上的研究热点如下图所示。

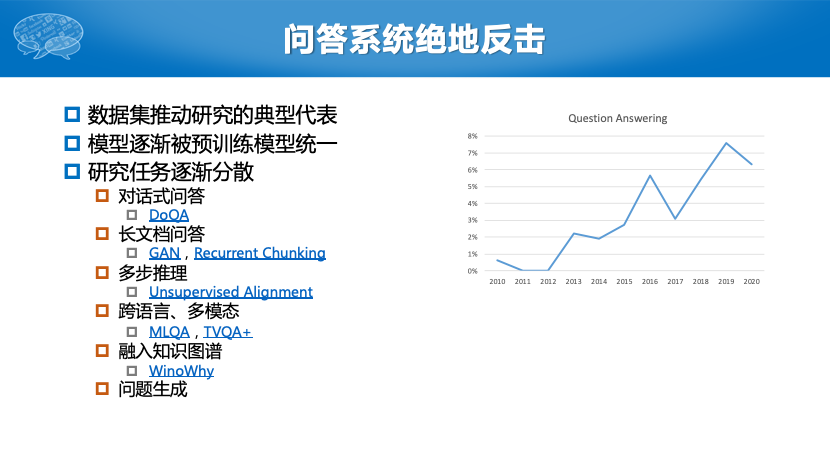

问答系统绝地反击

随着斯坦福大学SQuAD数据集的诞生,以抽取式阅读理解为代表的问答系统近年来引起了大量的关注。但是为什么说是“绝地反击”呢?主要是因为在更久之前,问答系统就曾经是信息检索和自然语言处理领域的热门研究方向,但是受限于当时的技术手段,答案准确率并不是很高,因此该研究方向曾一度被人们所冷落。经过这几年的发展,问答系统的模型逐渐被预训练模型所统一,因此今年ACL上的相关文章更关注问答系统的各个子任务或引入更多资源。

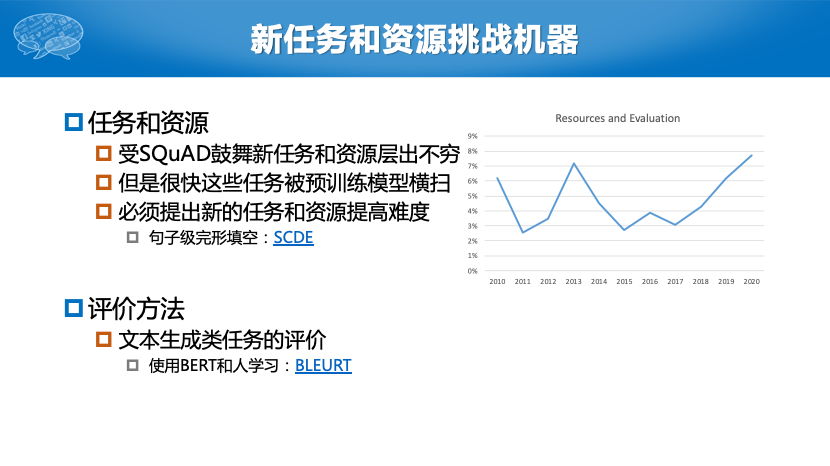

新任务和资源挑战机器

仍然是受预训练模型的影响,在很多刚被提出不久的自然语言处理任务上,机器的表现很快超过人类。因此最近有大量的研究工作试图提出对机器更具有挑战性的任务和资源,从而逼迫机器更像人一样“思考”。

机器翻译有所衰落

几家欢乐几家愁,由于上述领域的快速崛起,更重要的是由于模型逐渐为Transformer所统一,使得机器翻译这一“老牌”自然语言处理任务受关注的程度有所降低。今年ACL的相关研究也分散到不同的翻译场景设置上。

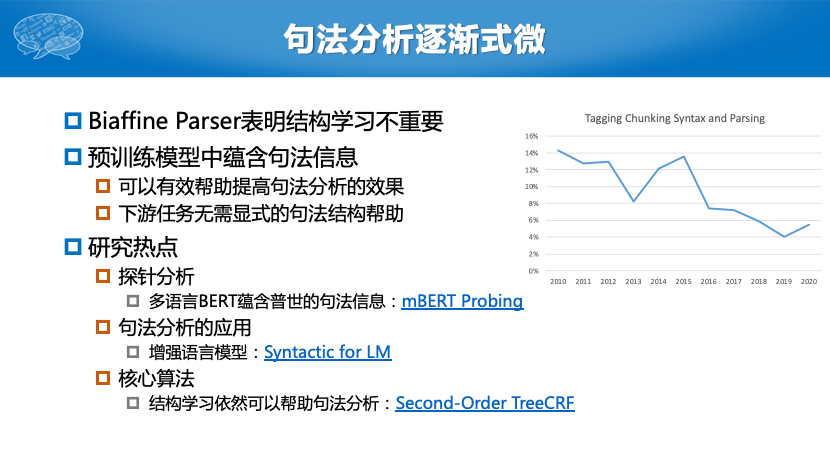

句法分析逐渐式微

和机器翻译类似,句法分析这一曾经自然语言处理领域的当家任务也逐渐式微。其背后的原因有两个:一方面是因为Biaffine Parser的出现证明了结构学习这一自然语言处理的特色问题,对于句法分析并不重要;另一方面,预训练模型的出现使得句法分析的处境更是雪上加霜。预训练模型不但能大幅提高句法分析的效果,更重要的是其内部已经蕴含了句法结构信息,因此就无需为下游任务提供显式的句法结构了。由于这些原因,今年ACL上句法分析的热点也主要集中在了研究探针任务和句法分析的应用上了。不过苏州大学李正华老师所提出的高阶TreeCRF模型还是能进一步提升句法分析的效果,这一点非常难得。

![]()

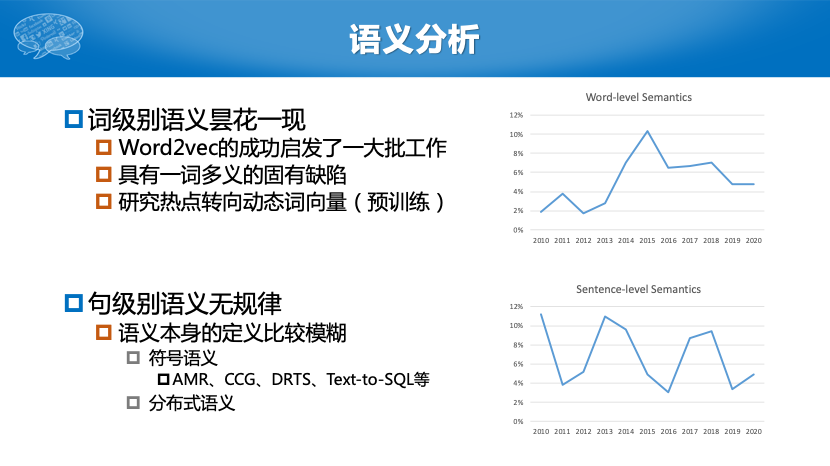

语义分析

语义分析领域的情况稍显复杂,对于词级别的语义分析,当年受到Word2vec模型的启发,产生了一大批相关的研究,其影响力甚至超出了自然语言处理的范围,在知识图谱、推荐系统等领域都广受关注。而近年的预训练模型让大家将研究重点从之前这种静态词向量转移到了动态词向量等方向。至于句级别语义分析,本身的定义就比较模糊,很多任务都可以归为语义分析,如AMR、CCG Parsing等,当然它们也可以被归为结构分析(Parsing)类任务,所以趋势上有所波动。

![]()

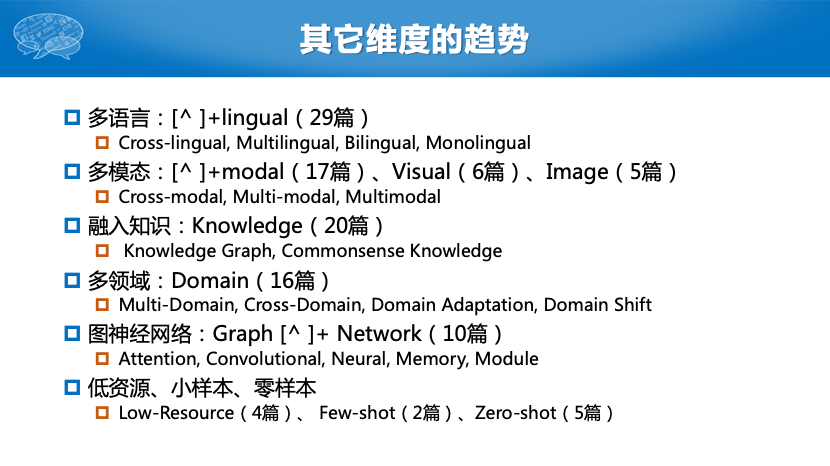

上面这些分析主要是从研究领域的趋势变化展开的,我们还可以从其它维度进行分析,来帮助我们更全面了解自然语言处理的研究。如下图所示,我们总结了今年ACL上几个热门的研究方向,如对多语言、多模态、多领域和低资源的研究,融入知识的方法,图神经网络的应用等。

最后给出我在调研过程中的一些杂想,仅供参考,欢迎大家一起讨论,碰撞更多的火花。谢谢!

本期责任编辑:丁 效

本期编辑:赖勇魁

推荐阅读

AINLP年度阅读收藏清单

薅当当羊毛的机会又!双!!叒!!!叕!!!来了

中文命名实体识别工具(NER)哪家强?

学自然语言处理,其实更应该学好英语

斯坦福大学NLP组Python深度学习自然语言处理工具Stanza试用

太赞了!Springer面向公众开放电子书籍,附65本数学、编程、机器学习、深度学习、数据挖掘、数据科学等书籍链接及打包下载

数学之美中盛赞的 Michael Collins 教授,他的NLP课程要不要收藏?

自动作诗机&藏头诗生成器:五言、七言、绝句、律诗全了

模型压缩实践系列之——bert-of-theseus,一个非常亲民的bert压缩方法

这门斯坦福大学自然语言处理经典入门课,我放到B站了

征稿启示 | 稿费+GPU算力+星球嘉宾一个都不少

关于AINLP

AINLP 是一个有趣有AI的自然语言处理社区,专注于 AI、NLP、机器学习、深度学习、推荐算法等相关技术的分享,主题包括文本摘要、智能问答、聊天机器人、机器翻译、自动生成、知识图谱、预训练模型、推荐系统、计算广告、招聘信息、求职经验分享等,欢迎关注!加技术交流群请添加AINLPer(id:ainlper),备注工作/研究方向+加群目的。

![]()