![]()

©PaperWeekly 原创 · 作者 | 陈凯

单位 | 复旦大学以人为本人工智能研究中心

研究方向 | 对抗攻防

本文中,来自复旦大学以人为本人工智能研究中心的研究者提出了一种新型的对抗弹幕攻击,通过在干净视频上添加少量弹幕便能误导视频识别模型,同时添加的弹幕不会影响人们对视频内容的理解。

![]()

论文标题:

AttackingVideo Recognition Models with Bullet-Screen Comments

https://arxiv.org/pdf/2110.15629.pdf

https://github.com/kay-ck/BSC-attack

![]()

深度神经网络已经在视频识别、视频目标检测等各类视频理解相关任务中表现出优越的性能。然而,最近的工作表明,深度神经网络极易受到视频对抗样本的干扰从而产生错误的预测结果。这些视频对抗样本是通过对干净的输入样本添加难以察觉的扰动而生成的。视频对抗样本的存在给部署在实际应用中的视频模型带来了严重安全隐患。因此,针对对抗样本的研究引起了研究人员的广泛关注。

然而,大多数视频对抗样本相关的工作都集中在基于扰动的攻击上。其中基于扰动的攻击是指在视频上添加限制在Lp范数的扰动,在不引起人眼察觉的情况下实现的对抗攻击。尽管基于扰动的攻击能够有效攻击视频识别模型,但它们通常难以应用于物理世界中的攻击。相比之下,补丁攻击则通过无限制的修改有限区域内像素来生成对抗样本,能够有效应用于物理世界中。然而,目前基于补丁攻击的研究主要集中在图像上,针对视频的补丁攻击鲜少被探索。

对此,我们研究了在黑盒设置下基于补丁的视频模型攻击。这项任务的挑战主要来自两个方面。首先,视频是相邻帧内容密切相关的图像序列。如果像基于扰动的视频攻击那样仅选择视频中的几帧来添加对抗补丁,则会增加攻击的可感知性。其次,相较于图片,视频的维度要高很多。如果将对抗补丁添加到视频的每一帧,将会显着增加计算成本。因此,如何在黑盒场景下高效地为视频模型生成不显眼的对抗补丁是主要挑战。

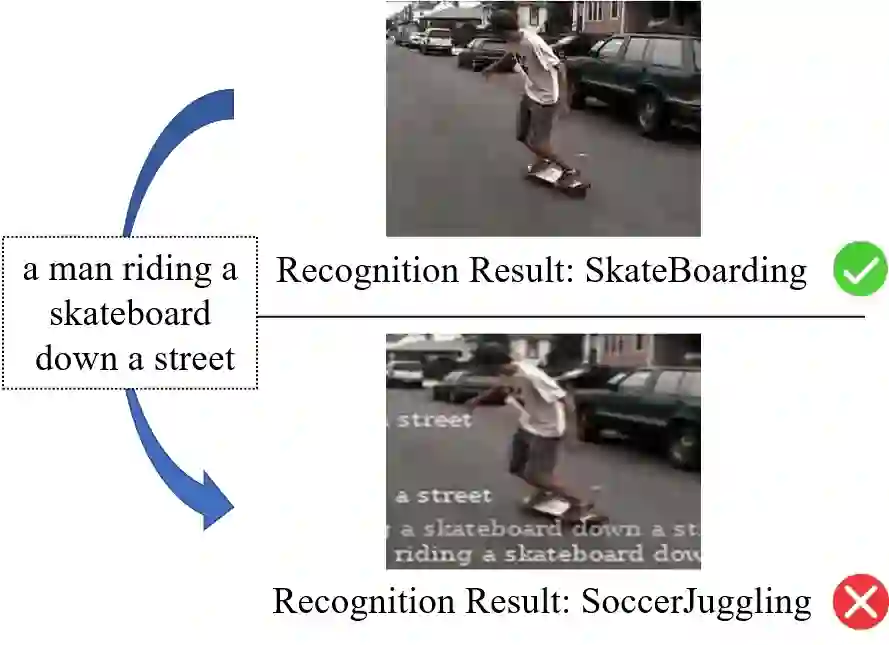

为了解决上述问题,我们提出了一种针对视频识别模型的新型对抗弹幕攻击方法。由于弹幕直播视频中比较常见,因此与传统的矩形补丁相比,人们对弹幕这种有意义的补丁相对不敏感。下图展示了对抗弹幕攻击的示例。可以看出,添加少量的弹幕不会影响人们对于视频的理解,但是却能成功地欺骗视频识别模型。

![]()

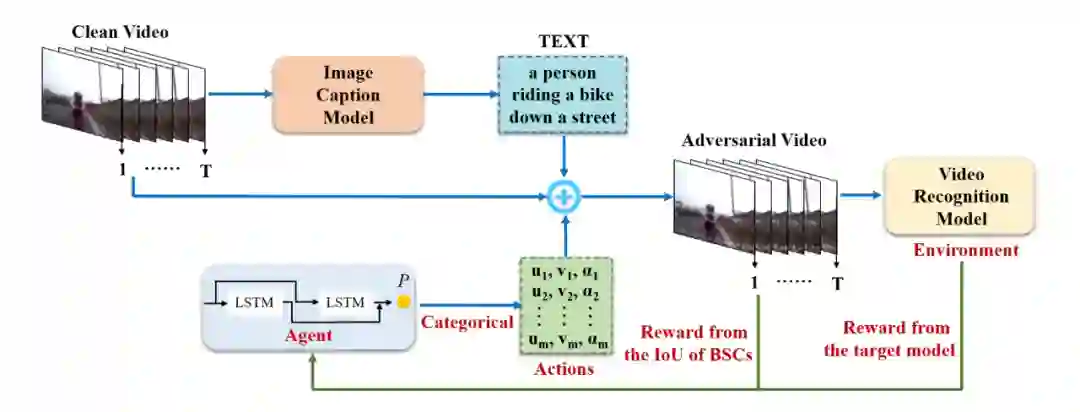

为了使得添加到每个视频的弹幕在有意义的同时彼此不同,我们在对抗弹幕攻击使用了一个图像字幕 (image caption) 生成模型来自动生成弹幕内容。然后基于高攻击成功率以及弹幕位置不重叠这两个目标函数来选择对抗弹幕的位置和透明度。其中弹幕位置不重叠这一目标主要是为了避免重叠造成的视频内容模糊。为了实现这两个目标,我们在对抗弹幕攻击使用强化学习来搜索弹幕的位置和透明度。具体来说,在强化学习中,环境 (environment) 被定义为目标模型,代理 (agent) 充当选择弹幕的位置和透明度的角色。通过不断查询目标模型并接收反馈,代理逐渐调整其选择策略,以实现上述的两个目标。我们方法的框架图如下图所示。

![]()

![]()

使用

表示视频识别模型,其中

表示模型参数。使用

表示干净的视频样本,

表示其对应真实标签,其中

表示视频空间,

分别表示帧数,帧高,帧宽和通道数,

表示标签空间,

表示类别数量。使用

表示视频识别模型对于视频输入的预测。针对视频模型的对抗攻击的目标是产生可以欺骗视频识别模型的视频对抗样本

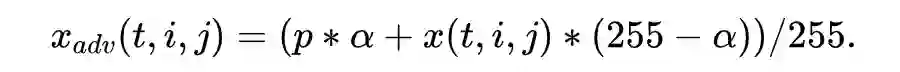

。在非目标攻击的情况下,优化以下目标函数:

![]()

其中

表示真实标签的独热编码,

计算预测和真实标签之间的损失。

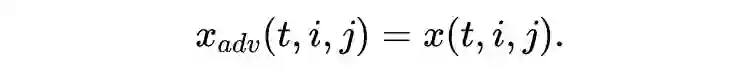

为了进一步减轻弹幕对视频内容的影响,使用 alpha 混合技术来生成弹幕。当

时,

的生成过程被表示为:

![]()

![]()

其中

表示视频中像素的位置,

表示弹幕区域的填充,就是弹幕的颜色,

表示弹幕 alpha 通道的值,也就是弹幕区域相对于视频背景的透明度。

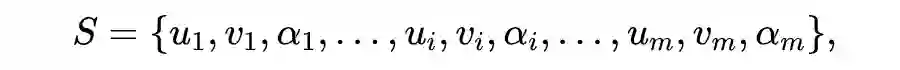

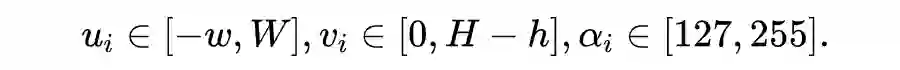

对抗弹幕攻击中视频对抗样本的生成只与弹幕的位置和透明度有关,并使用强化学习来搜索弹幕的位置和透明度。在强化学习框架中,代理通过与环境互动,来学习选择对抗弹幕的位置和透明度,并更新其生成的动作(action)以最大化总预期奖励。其中,环境由

和

组成,代理

被训练去依次搜索弹幕的位置和透明度。弹幕潜在位置和透明度的搜索空间被定义为:

![]()

![]()

其中

是弹幕的宽度,其取决于弹幕的内容。从上式可以看出,

有

个维度,代理

依次生成

个动作从而得到

,其中

。代理

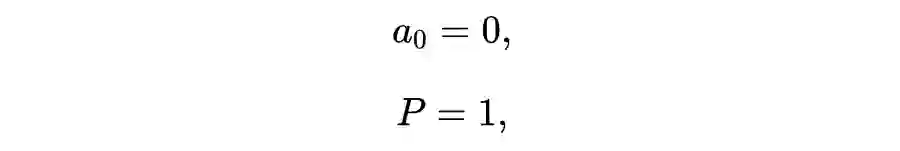

被定义为一个 LSTM 和一个 FC 层的组合,其中

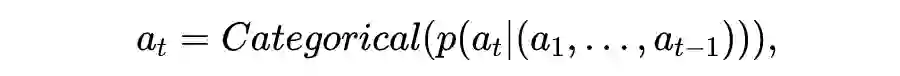

表示代理参数。动作的生成过程被表示为:

![]()

![]()

![]()

![]()

![]()

其中初始输入

为 0,LSTM 的隐状态

,

表示 FC 层的权重。sigmoid 函数预测了第

个动作的概率分布

,然后通过 Categorical 函数采样得到动作

,并用

记录行动的概率。生成的

在下一步输入 LSTM,驱使 LSTM 的隐状态从

到

转换。这个过程重复进行,直到生成所有的

个动作。

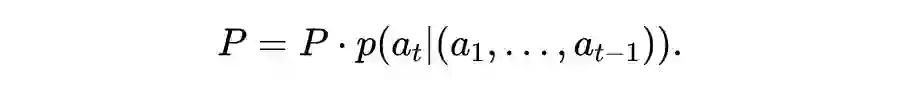

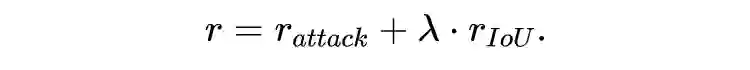

为了产生对抗和不重叠的弹幕,定义了一个包含两部分的奖励:来自目标模型反馈的损失

和来自不同弹幕之间的交并比

。奖励

和

彼此互补,共同指导代理的学习:

![]()

其中,

是超参数。奖励

使代理产生对目标模型损失较大的动作,其被定义为:

![]()

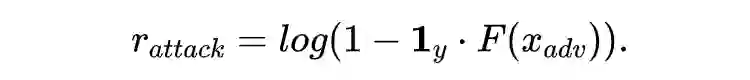

奖励

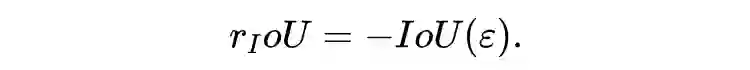

避免了由于弹幕重叠而严重遮挡视频的细节,其被定义为:

![]()

其中

计算了弹幕之间的交并比。通过将有重叠弹幕的视频对抗样本视为攻击失败,

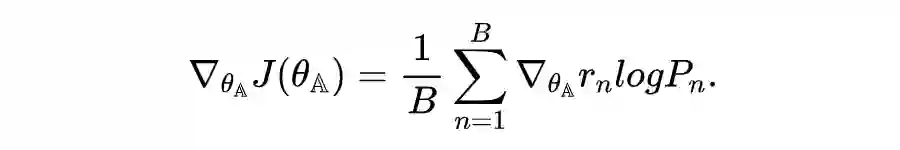

还能够来隐式地限制弹幕的数量。最后,使用 REINFORCE 算法,通过最大化预期奖励来优化代理

的参数

:

![]()

![]()

![]()

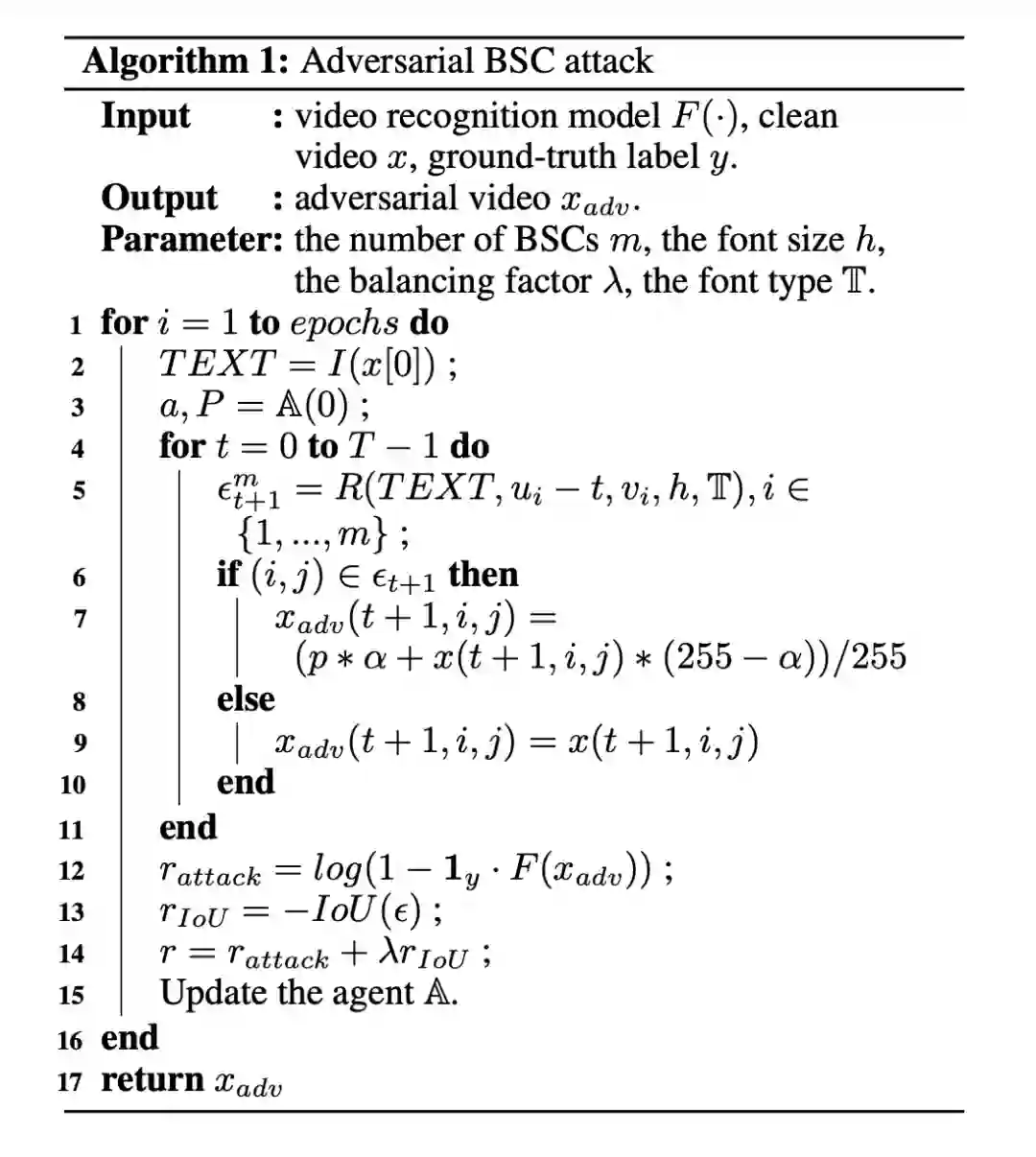

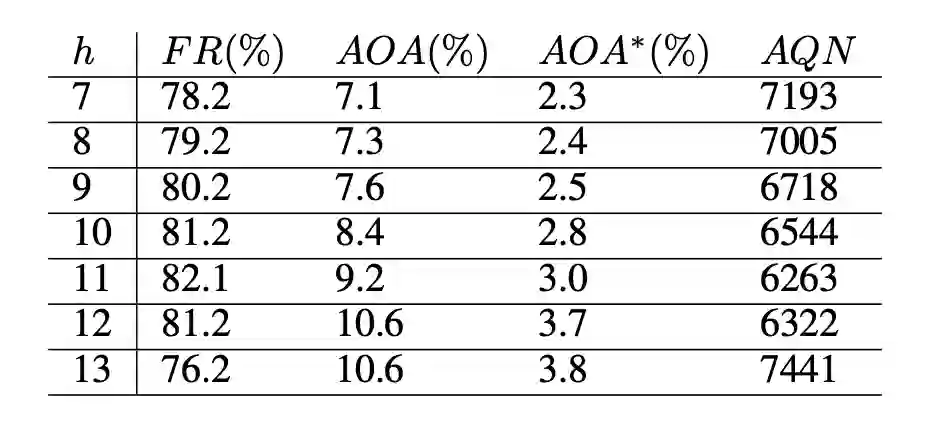

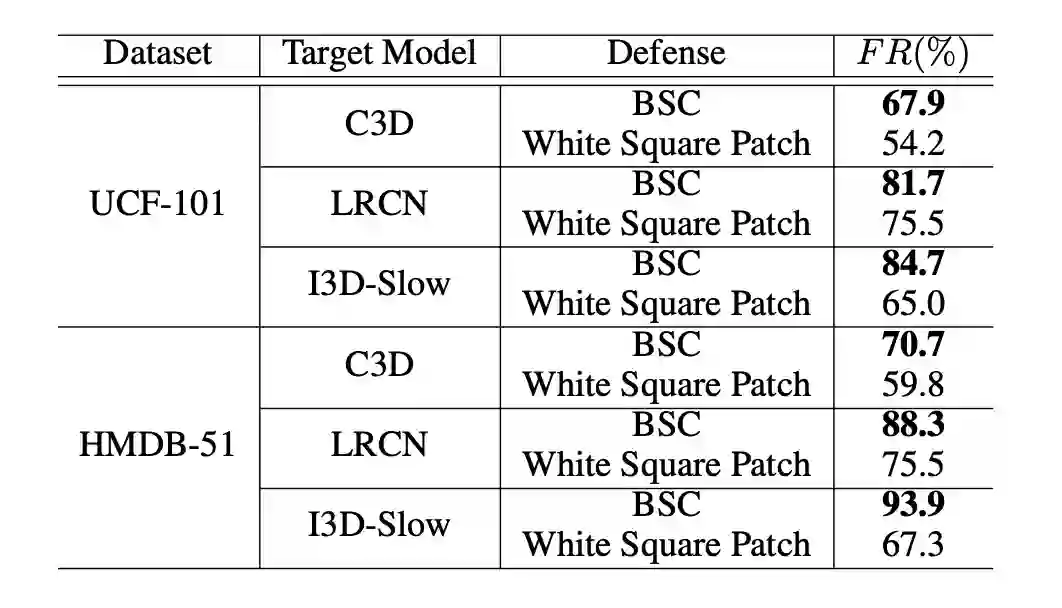

我们选择 UCF-101 和 HMDB51 两个数据集,C3D、LRCN 和 I3D-Slow 三种不同结构的视频识别模型来进行实验。除此之外,我们还使用了三个评价指标,1)欺骗率(Fooling rate, FR):视频对抗样本被成功误分类的比率;2)平均遮挡面积(Average occluded area, AOA):视频中被弹幕遮挡的平均面积百分比,AOA*表示视频中的显著区域被弹幕遮挡的平均面积百分比;3)平均查询次数(Average query number, AQN):攻击过程中,查询目标模型的平均次数。

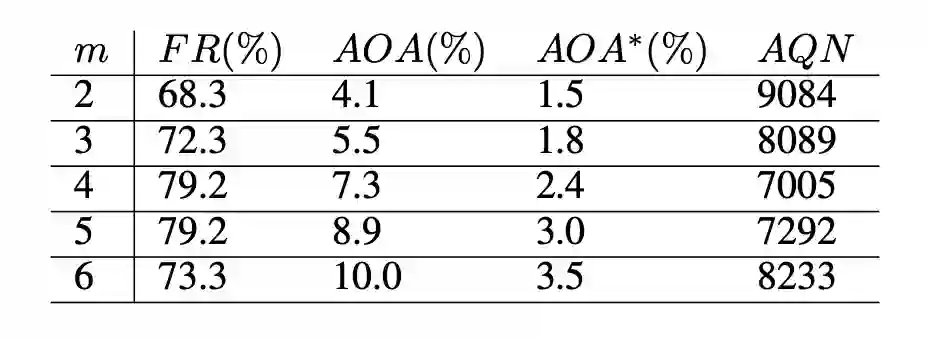

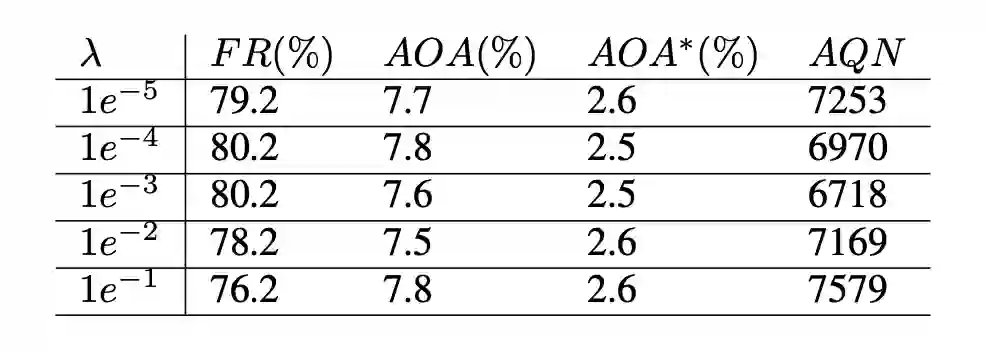

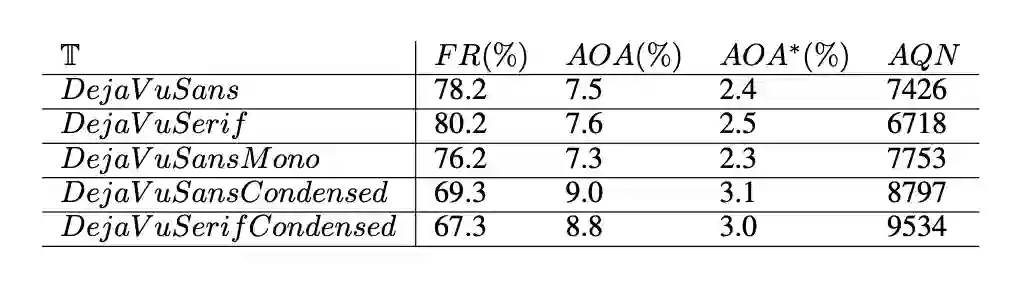

我们通过网格搜索来确定对抗弹幕攻击中的四个超参数,包括弹幕数量

、字体大小

、奖励中的平衡因子

和字体类型

最合适的值。从下表可以看出,当

或

增加时,AOA 一直增加,而FR先增加后降低。这是因为随着弹幕数量或字体大小的增加,视频中更多的区域被遮挡,从而取得更高的欺骗率。

然而,由于我们将有重叠弹幕的视频对抗样本视为攻击失败,而当弹幕太多或字体太大时,弹幕之间就更有可能发生重叠。当

,

,

,

=DejaVuSerif 时,对抗弹幕攻击在 FR, AOA 和 AQN 之间取得了平衡。

![]()

![]()

![]()

![]()

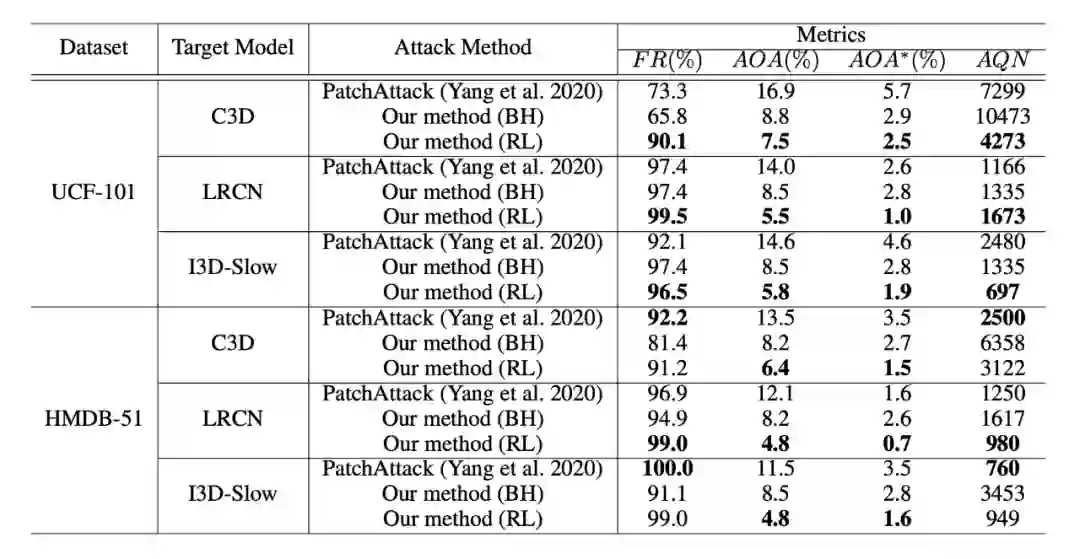

我们将对抗弹幕攻击与 1)使用相同大小的矩形补丁的 PatchAttack、2)使用盆地跳跃(BasinHopping, BH)算法搜索弹幕位置和透明度的策略、3)随机选择弹幕位置和透明度的策略进行比较。

从下表可以看出,在大多数情况下,对抗弹幕攻击取得了更好的性能:与 PatchAttack 相比,对抗弹幕攻击的 AOA 和 AOA*显著减少了,我们认为这是因为弹幕比矩形补丁更加分散;与 BH 相比,使用强化学习搜索弹幕的位置和透明度更加高效;在相同的 AQN 下,使用强化学习比随机选择取得了更好的性能。

![]()

▲ 不同攻击方法在两个数据集上针对不同视频识别模型的性能对比

我们还评估了弹幕和矩形补丁针对局部梯度平滑(Local Gradient Smoothing, LGS)防御方法的性能,从下表可以看出,弹幕对 LGS 防御方法的鲁棒性比矩形补丁更强。

![]()

▲ 两种对抗补丁类型针对 LGS 防御方法的性能对比

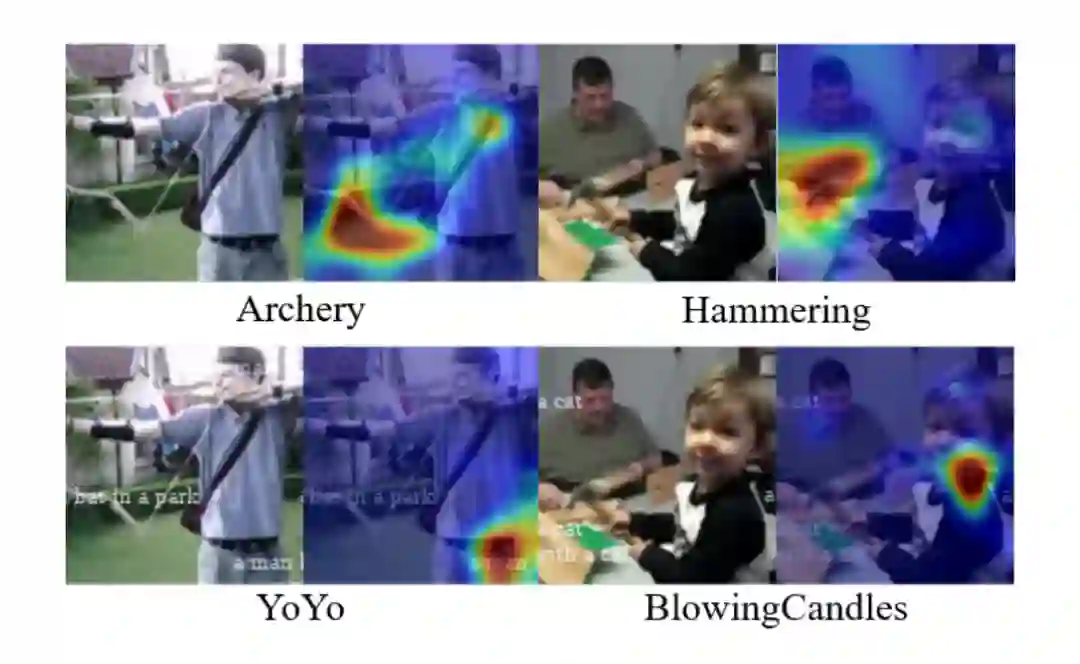

通过 Grad-CAM 可以看出,弹幕改变了视频识别模型对于视频帧的注意力分布。

![]()

▲ 通过 Grad-CAM 生成的热力图

感谢 TCCI 天桥脑科学研究院对于 PaperWeekly 的支持。TCCI 关注大脑探知、大脑功能和大脑健康。

![]()

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

![]()

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧

![]()