【泡泡图灵智库】基于Gamma分布的精确双目视觉里程计(ICRA)

泡泡图灵智库,带你精读机器人顶级会议文章

标题:Accurate Stereo Visual Odometry with Gamma Distributions

作者:Ruben Gomez-Ojeda, Francisco-Angel Moreno, Javier Gonzalez-Jimenez

来源:ICRA 2017

编译:杨小育

审核:皮燕燕

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——基于Gamma分布的精确双目视觉里程计,该文章发表ICRA 2017。

基于点特征的双目视觉里程计通常会通过最小化连续帧之间的关于投影误差的损失函数来估计相机运动。在一些假设下,这种最小化相当于是关于一个给定姿态变化的测量误差的概率最大化,为此,合适的传感器模型变得具有重要意义,以便获得准确的结果。在本文中我们基于现实世界数据,提出了一种非常鲁棒的投影误差概率模型。我们认为投影误差服从Gamma分布,以便在运动估计过程中引入概率公式来提高模型的准确度。通过在一系列合成和实际数据集上进行测试后,可以看出视觉里程计的精度提高了,同时又不提升计算复杂度。

主要贡献

1、提出重投影误差服从Gamma分布

2 、将1中的假设应用到双目视觉里程计中,的确提高了精度,同时并不增加计算量

算法流程

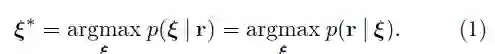

首先定义该数学问题

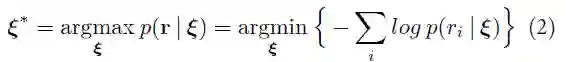

在ri(ξ)独立的假设下,估计(1)式相当于最小化残差的负对数

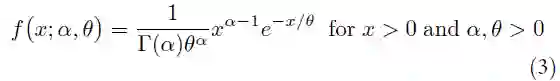

假设r(ξ)服从Gamma分布,即r(ξ)~(α,θ),其概率密度函数为:

其中α和θ决定改概率密度函数形状的参数,可以得到各残差的大小满足(4)式的关系

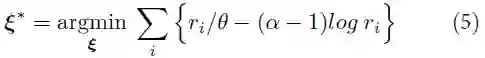

将(4)式代入(2)式可得:

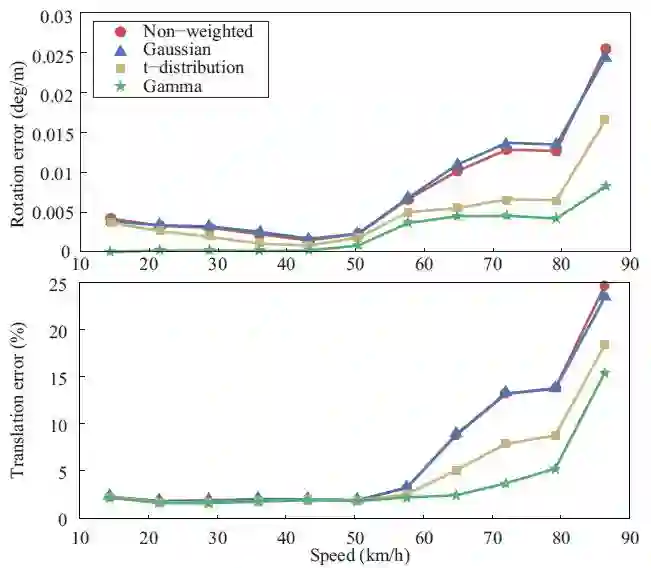

使用迭代重加权最小二乘法,可以将(5)转化为(6)式

其中w(ri(ξ))的定义如下

主要结果

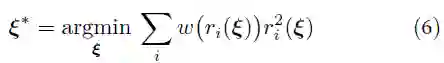

1、合成数据集上的测试

图1 使用不同的损失函数来描述特征点数量与旋转、平移误差的关系,其中红色为非加权方法,蓝色为高斯加权,黄色为Student T分布,绿色为Gamma分布

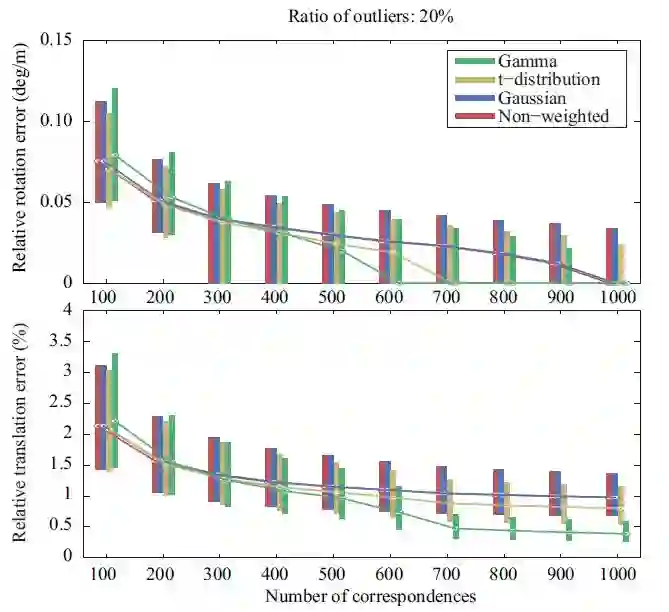

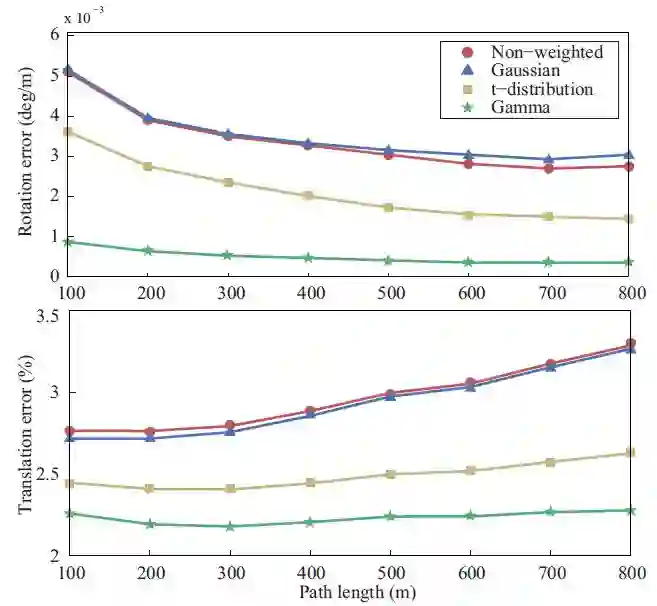

2、KITTI数据集上的测试

图2 使用不同的损失函数来计算KITTI数据集中给定长度子序列的旋转和平移误差,红色为非加权方法,蓝色为高斯加权,黄色为Student T分布,绿色为Gamma分布

图3 使用不同的损失函数来计算KITTI数据集中给定长度子序列的平均旋转和平移误差,红色为非加权方法,蓝色为高斯加权,黄色为Student T分布,绿色为Gamma分布

图4 使用不同的损失函数来描述KITTI数据集中在给定速度下的平均旋转、平移误差

Abstract

Point-based stereo visual odometry systems typically estimate the camera motion by minimizing a cost function of the projection residuals between consecutive frames. Under some mild assumptions, such minimization is equivalent to maximizing the probability of the measured residuals given a certain pose change, for which a suitable model of the error distribution (sensor model) becomes of capital importance in order to obtain accurate results. This paper proposes a robust probabilistic model for projection errors, based on real world data. For that, we argue that projection distances follow Gamma distributions, and hence, the introduction of these models in a probabilistic formulation of the motion estimation process increases both precision and ac-curacy. Our approach has been validated through a series of experiments with both synthetic and real data, revealing an improvement in accuracy while not increasing the computational burden.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号。

点击阅读原文,即可获取本文下载链接。

欢迎来到泡泡论坛,这里有大牛为你解答关于SLAM的任何疑惑。

有想问的问题,或者想刷帖回答问题,泡泡论坛欢迎你!

泡泡网站:www.paopaorobot.org

泡泡论坛:http://paopaorobot.org/forums/

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com