论文浅尝 | DEKR: 一个基于描述增强知识图谱的机器学习方法推荐系统

笔记整理:刘尧锟,天津大学硕士

链接:https://dl.acm.org/doi/pdf/10.1145/3404835.3462900

动机

面对大量的机器学习(ML)方法,为给定的数据集和任务选择合适的方法是一个挑战。一般来说,ML方法或数据集的名称相当简洁,缺乏具体的解释,ML实体之间丰富的潜在关系没有得到充分的探索。在本文中,我们提出了一种基于描述增强的机器学习知识图谱的方法DEKR,来为给定的ML数据集推荐合适的ML方法。所提出的知识图谱(KG)不仅包含实体之间的连接,还包含数据集和方法实体的描述。DEKR将结构信息与知识图谱中实体的描述信息相融合,是一个深度混合的推荐框架,融合了基于知识图谱和基于文本的方法,克服了以往基于知识图谱的推荐系统忽略描述信息的局限性。

亮点

DEKR的亮点主要包括:

1.构造了一个描述增强的机器学习知识图谱,它不仅考虑了机器学习实体之间的丰富联系,还考虑了查询实体(即数据集和方法)的描述信息;2.提出了DEKR模型,该模型结合了基于知识图谱和基于文本的方法,克服了传统的基于知识图谱的方法忽略实体描述信息的局限性;

概念及模型

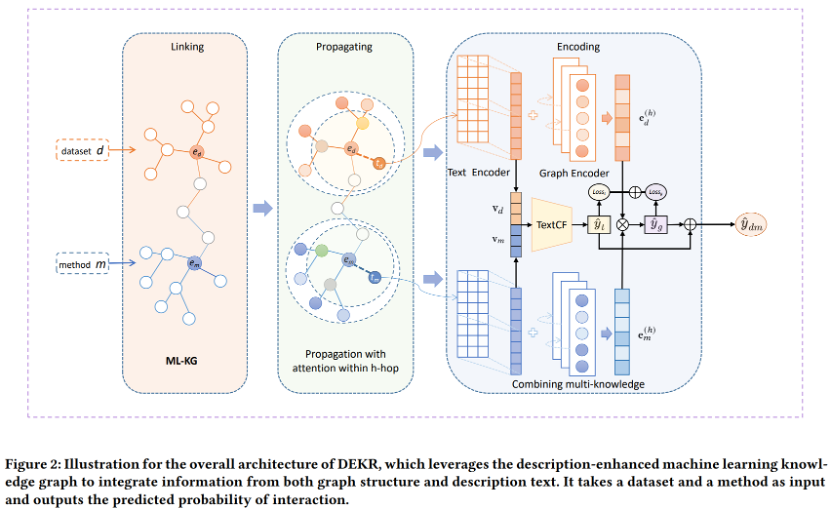

DEKR有两个关键组成部分:

1.图神经网络,它通过允许两个种子(即数据集和方法)实体在知识图上传播来探索高阶连接性,用邻居的信息丰富它们自己的表示2.基于深层文本的协同过滤网络,通过从描述特征中捕捉线性和非线性交互,得出基于文本的交互概率。

模型整体框架如下:

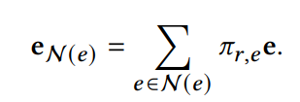

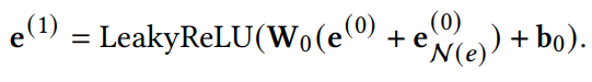

•Knowledge Graph Neural Network (KGNN)

基于采样的邻点N(e) 以及相应的注意力权重

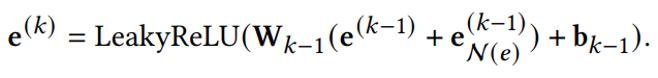

并相应得到了节点 𝑒 通过将其邻点的表示聚合为自己的one-hop表示公式以及multi-hop表示公式,如下:

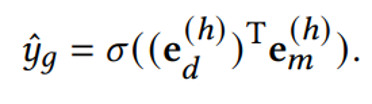

在分别在数据集端和方法端传播h hop后,最终表示

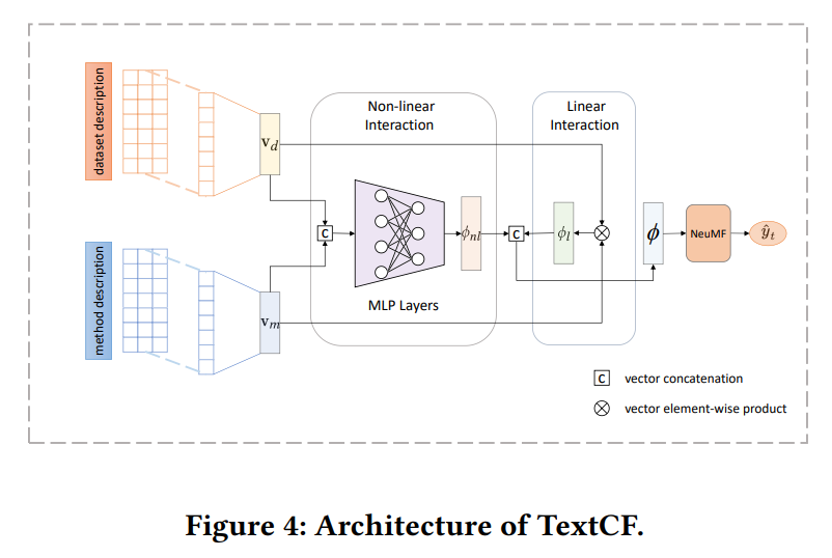

•Text-based Collaborative Filtering (TextCF)

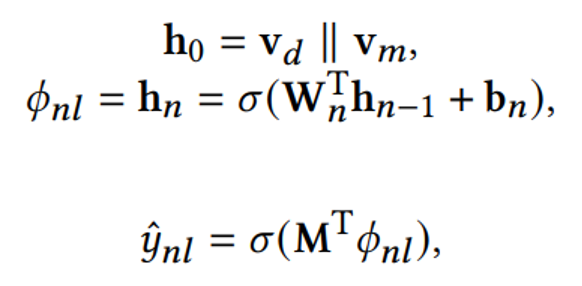

TextCF模型结构如下图所示:

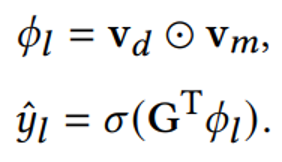

其中通过嵌入得到

非线性交互公式如下:

最终输出:

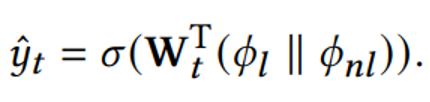

•组合KGNN和TextCF

KGNN和TextCF分别学习了数据集和方法在结构和描述特征方面的嵌入表示。我们让模型分别学习和优化这两种表示,然后结合它们预测的概率,生成最终的交互概率,如下所示:

理论分析

实验

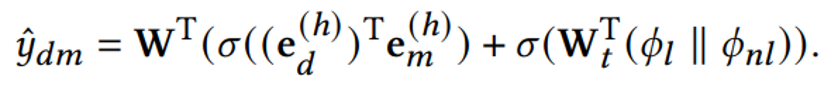

作者从开放学术平台收集数据,搜索与机器学习(ML)相关的数据集、方法及其属性,以及其他相关实体进行实验。首先是有效性实验。

DEKR在CTR预测任务上的表现优于所有baseline模型,平均提高了15%以上。此外,DEKR在top-𝐾 任务上也表现出色。同时几乎所有基于知识图谱的模型都在推荐任务上优于传统模型,这表明在知识图谱中引入丰富的关系和信息极大地提高了推荐的有效性。

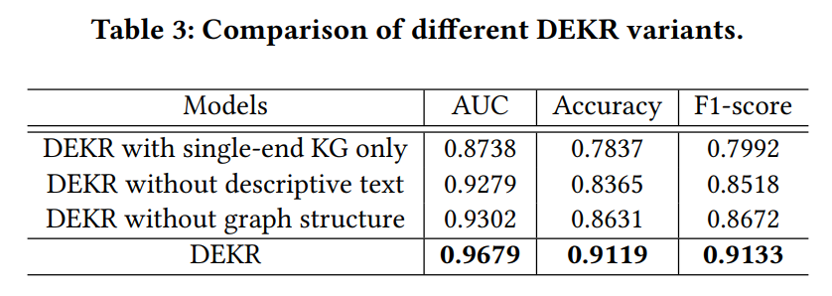

此外选择使用不同的模型组成部分进行实验,实验结果如下图:

可以看出,不使用知识图谱的结构或描述性信息的性能不如同时使用两者。此外,仅在知识图的一端使用边信息比在两端使用边信息弱,这表明引入更多边信息将提供更多特征表征。

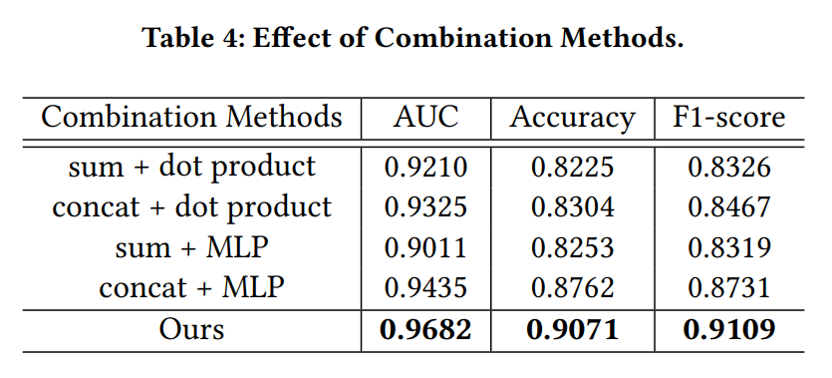

表4总结了不同组合方法的实验结果,验证了相比之下本文的组合方法最优。此外,求和设置的性能弱于串联设置。一个可能的原因是,两个特征表示有异构性,它们属于不同的语义空间。

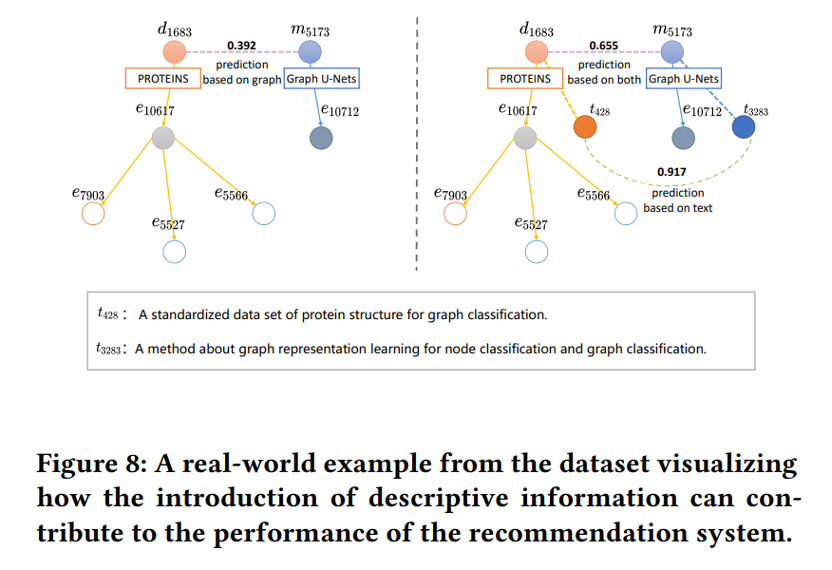

最后实验可视化了描述性信息的引入如何有助于推荐系统的性能。

总结

在本文中,我们提出了一个基于描述增强知识图谱的机器学习方法推荐系统DEKR,它可以为给定的机器学习数据集推荐合适的方法。我们构建了一个描述增强的机器学习知识图谱,定义了图谱中的主要实体和关系,并添加了与推荐任务相关的两个核心实体(即数据集和方法)的描述信息。DEKR有两个关键组成部分:

1.KGNN,它从数据集和方法端开始,在知识图谱上传播,扩展到高阶邻域,然后丰富其自身的表示;2.TextCF,捕捉文本特征的线性和非线性交互。通过结合这两种信息来源,DEKR能够提出高度准确和高效的建议。在真实数据集上进行的大量实验证明了模型的有效性。

OpenKG

OpenKG(中文开放知识图谱)旨在推动以中文为核心的知识图谱数据的开放、互联及众包,并促进知识图谱算法、工具及平台的开源开放。

点击阅读原文,进入 OpenKG 网站。