CVPR2020 | 参数量减半,北大开源全新高效空域转换模块,还原图像逼真细节

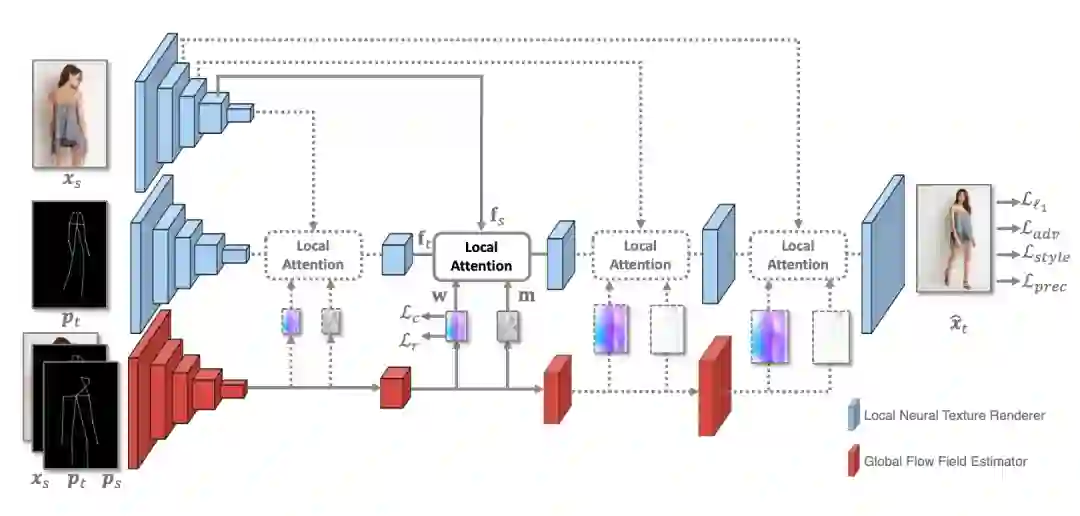

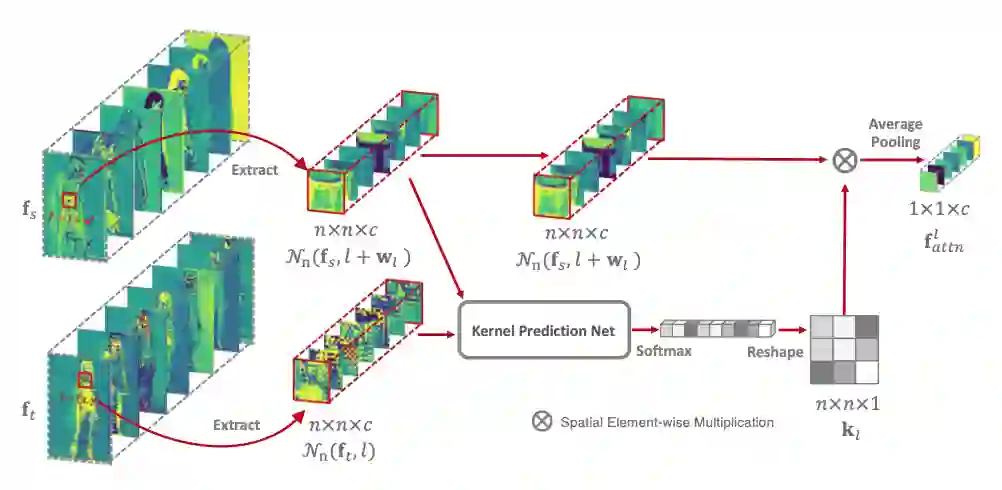

很多图像生成任务都需要在空域对输入图像进行移动和重新排列。然而,卷积神经网络难以进行高效的空域转换操作。近日,来自北大和鹏城实验室的研究者们提出了一种全新的空域转换模块 Global-Flow Local-Attention 。这一模块将光流和注意力机制结合起来,通过首先提取源图像与目标图像之间的整体相关性,得到全局的光流图。然后利用光流图,采样局部的特征块以进行局部的注意力操作。

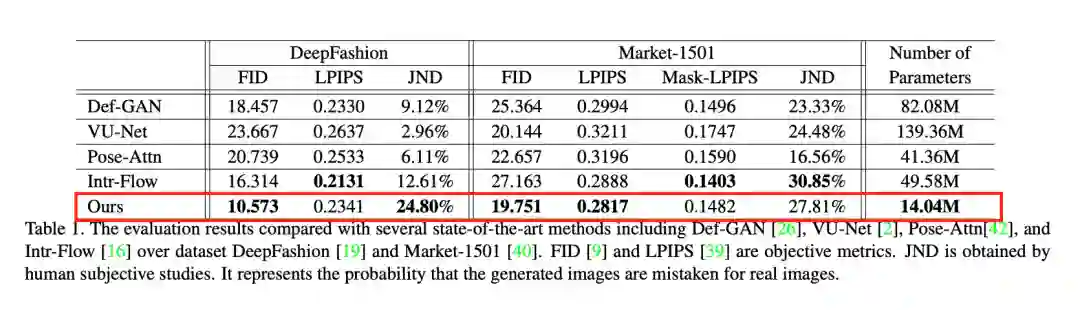

他们在人体姿态转换任务上测试了提出模型的优越性。实验结果证明模型可以对输入图像进行准确高效地空域转换:输出结果图像保持了输入图像中逼真的细节纹理;同时,模型的参数量不足现有主流方法的一半。

Global-Flow Local-Attention模型简介

那么算法的实际效果如何呢?

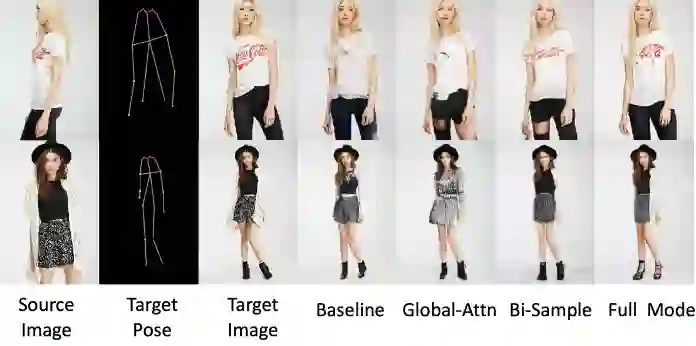

从不同算法的结果图像中可以看出文章所提出的算法不仅能够生成正确的姿势,同时还能够还原出结果图像逼真的纹理信息,例如:衣服上的图案花纹、鞋带的样式等等。

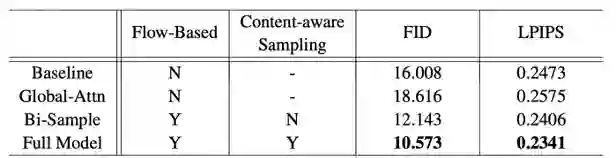

此外,文章还进行了详尽的消融实验来验证假设的正确性。对比的模型包括:不使用任何Attention模块(Baseline);使用传统的Global Attention模块(Global-Attn);使用光流模块,但是采用双线性插值进行采样(Bi-sample)以及完整的模型(Full Model)。可以看出,采用完整Global-Flow Local-Attention模块的模型(Full Model)取得了最好的性能。

通过分析消融实验的主观结果图像可以进一步地为这一结论寻找可能的解释。Baseline难以恢复细节信息,因为它使用一种先将原始信息抽象,后扩散至局部的方式来生成结果图像。Global-Attn将某一特征与全部的特征计算相似度并采样。这样的采样方式并不符合该任务的需求,因此结果图像无法恢复逼真的细节信息。Bi-sample会因为错误的采样而导致性能下降。Full Model维持了良好的结构和细节信息。

传递门

登录查看更多

相关内容

Attention机制最早是在视觉图像领域提出来的,但是真正火起来应该算是google mind团队的这篇论文《Recurrent Models of Visual Attention》[14],他们在RNN模型上使用了attention机制来进行图像分类。随后,Bahdanau等人在论文《Neural Machine Translation by Jointly Learning to Align and Translate》 [1]中,使用类似attention的机制在机器翻译任务上将翻译和对齐同时进行,他们的工作算是是第一个提出attention机制应用到NLP领域中。接着类似的基于attention机制的RNN模型扩展开始应用到各种NLP任务中。最近,如何在CNN中使用attention机制也成为了大家的研究热点。下图表示了attention研究进展的大概趋势。