Nature大型调查:当AI遭遇电车难题,它将拯救谁?

新智元报道

新智元报道

来源:the Verge

编辑:三石,肖琴

【新智元导读】随着自动驾驶汽车的普及,其安全性问题被社会广泛关注。人类在遇到车祸时会本能的对“先救谁”进行选择,而若是以编程形式让自动驾驶汽车也具有这样的功能,道德决策又将如何选择?今日,MIT在Nature上便发表了题为“道德机器(the Moral Machine)实验”的论文,对该问题进行了研究与探讨。

“我和你的老母亲同时掉进水里,你先救谁?”

这道世纪难题令多少英雄好汉竞折腰,那么如果让自动驾驶汽车通过程序自行判断,结果又将如何呢?

让我们先来回顾近期惨不忍睹的自动驾驶车祸事故:

2018年3月18日,Uber自动驾驶汽车冲撞一路人女子,该女子不幸身亡;

2018年1月10日,福特投资的Argo AI发生交通事故,导致车内两人受伤;

2016年5月7日,特斯拉Model S与挂车相撞,驾驶员不幸身亡;

2016年1月20日,京港澳高速,特斯拉轿车撞上作业车,驾驶员不幸身亡;

......

随着自动驾驶的普及,人们在享受便利与高效的同时,也必须考虑自动驾驶的安全性问题。这对社会来说也无疑是增添了一份负担:对汽车进行编程,在发生交通事故的时候,使其具备优先拯救哪些生命的能力。

在这种情况下,人类驾驶员肯定会本能地去选择先救谁,但是对于算法来说,这道选择题应当是提前就有答案了的。那么汽车公司和政府又会做出怎样的选择呢?救老人还是孩子?救多数人还是少数却很特殊的人?

今天,MIT发表了一篇论文,探讨了公众对这些问题的看法,并整理了2016年启动的一个名为the Moral Machine(道德机器)的在线测试数据。

The Moral Machine实验

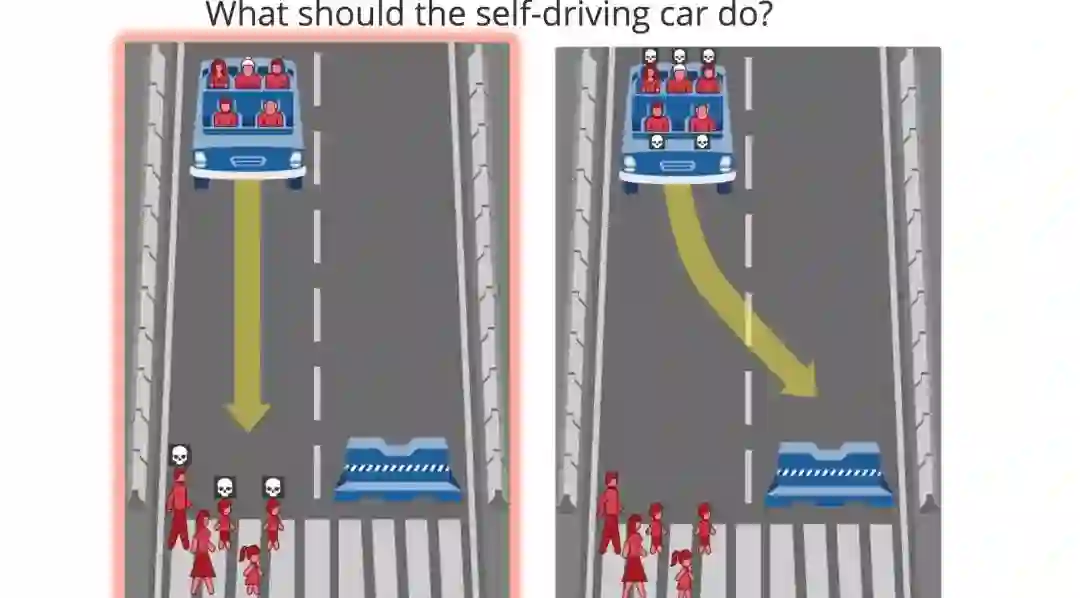

它要求用户对虚拟的车祸做出一系列道德决策,类似于著名的“电车难题(trolley problem)”。

“电车难题(Trolley Problem)”是伦理学领域最为知名的思想实验之一,其内容大致是:一个疯子把五个无辜的人绑在电车轨道上。一辆失控的电车朝他们驶来,并且片刻后就要碾压到他们。幸运的是,你可以拉一个拉杆,让电车开到另一条轨道上。然而问题在于,那个疯子在另一个电车轨道上也绑了一个人。考虑以上状况,你是否应拉杆?

研究人员对9个不同的因素进行了测试,其中包括用户更倾向撞到男性还是女性,选择拯救多数人还是少数人,牺牲年轻人还是老人,普通行人还是横穿马路的行人,甚至还会在地位低和地位高的人之间做出选择。

The Moral Machine中的一个场景示例:用户应该撞向路人还是障碍物?

来自233个国家和地区的数百万用户参加了测验,共计制定了4000万个道德决策。 根据这些数据,该研究的作者发现了一些较为一致的全球偏好(global preference):更倾向于拯救人类而不是动物、拯救多数人牺牲少数人、优先拯救儿童。

因此,他们认为,在为自动驾驶汽车制定法律时,这些因素应被视为政策制定者的“基石”。 但作者同时也强调,这项研究的结果绝不是算法决策的模板。

论文的协作者Edmond Awad说:“我们试图展示的是描述性伦理,即人们在道德决策中的偏好,但是,如果涉及到标准的道德规范时,该如何做出选择,这应该由专家来决定。”

数据还显示,不同国家的道德偏好存在显著差异。这与许多因素有关,包括地理位置(例如,欧洲和亚洲国家之间的差异)和文化(个人主义社会和集体主义社会)。

值得注意的是,虽然在未来的某个时间必须开展这些决策相关的工作,但自动驾驶技术仍有很长的路要走。 自主性仍然处于起步阶段,自动驾驶汽车仍然是原型,而不是产品。 专家们还说,虽然目前尚不清楚这些决定将来会以什么样的编程方式与车辆进行结合,但显然还是需要进行公众咨询和辩论的。

加州理工大学伦理+新兴科学小组主任Patrick Lin说:“由于自动驾驶汽车是第一个大规模融入社会的AI产物,所以在自动驾驶方面所发生的一些列事情都将为其它人工智能和机器人技术定下基调。”

Moral Machine调查得出的结果表明,在涉及到这些道德困境时,有一些共同的原则。但该论文的作者还发现了一些偏好上的差异,这些差异遵循着一定的分类。这些差异没有一个是违背核心原则的(例如少数服从多数的原则)但它们确实在一定程度上有所不同。

研究人员发现,在亚洲和中东的一些国家,比如中国、日本和沙特阿拉伯,“保全年轻人而非年长者”的倾向“不那么明显”。与来自欧洲和北美的人相比,这些国家的人也相对较少地关心保全“高净值”个人。

这项研究的作者认为,这可能是由于个人主义文化和集体主义文化之间的差异。前者强调每个人作为个体的独特价值,“更倾向于保全更多数量的人。”与此相反,在保全年轻人方面更弱的偏好可能是集体主义文化的结果,“强调对社区中年长成员的尊重。”

作者认为,这些差异表明,“地理和文化上的接近可能会让不同国家的人在机器伦理方面有一致的偏好。”

然而,还有其他因素与这些差异相关,不一定是地理上的。例如,不那么富裕的国家,它的人均国内生产总值(GDP)较低,民间机构较弱,更可能撞守规矩过马路的人而不是乱穿马路的人,“大概是因为他们遵守规则的经验较少,对不守规则的惩罚也较轻”。

不过,作者强调, Moral Machine的结果绝不是对不同国家的道德偏好的最终评估。

首先,这个测试是自选的,参与者都是相对懂技术的人。测试的结构也消除了细微的差异。参与者只有两个明确的选择:杀死这些人,或杀死那些人。在现实生活中,这些决定都是概率性的,每个人都会在不同严重程度的结果中做选择。(“如果我令这辆卡车突然转向,很有可能以低速撞到那个行人”,等等。)

尽管如此,专家们表示,这并不意味着这样的测试无关紧要。Patrick Lin说,这些困境的人为性质是“特征,而不是bug”,因为它们消除了“混乱的变量,以便集中于我们感兴趣的特定变量”。

他补充说,即使汽车不会经常在撞到物体X或物体Y之间做出选择,它们仍然需要权衡相关的决定,比如给这些东西留出多宽的空间。这仍然是“一个基本的道德问题,”Lin说,“所以我们现在需要讨论这个问题。”

一台摄像机透过谷歌自动驾驶汽车的格栅窥视。Photo by Sean O’Kane / The Verge

但在这些问题上,我们离需要立法还有多远?公司什么时候开始将道德决策编码到自动驾驶汽车里?

对第二个问题的回答是,现在已经有了。这是真的,因为每一个算法都会做出某种决定,其中一些会产生伦理上的后果。但从更具体的角度来看,即使相关公司不愿意公开谈论这些算法偏好,也很可能会编码粗略的偏好。

例如,早在2014年,Google X的创始人 Sebastian Thrun就表示,公司的原型自动驾驶汽车将在发生碰撞时选择撞击两个物体中的较小者。在2016耐能,谷歌的Chris Urmson表示,该公司的无人车将“尽量避免撞倒无保护的道路使用者:骑自行车的人和行人”。同年,据报道,梅赛德斯-奔驰的一名经理表示,该公司的自动驾驶汽车将优先考虑撞车事故中乘客的生命安全,但该公司后来否认了这一说法。

公司不愿意公开这些决策是可以理解的。一方面,自动驾驶系统还不够复杂,无法区分年轻人和老年人。最先进的算法和传感器可以区分明显不同的东西,比如松鼠和骑自行车的人,但它们无法区分比这更细微的东西。此外,公司不管说他们优先考虑谁的生命——人或动物、乘客或行人——都是会让某些人感到不安的决定。这就是为什么说这些都是道德困境:没有简单的答案。

欧洲政策研究中心(Centre for European Policy Studies)高级研究员Andrea Renda表示,私营企业在这些问题上做的工作最多。“私营企业正在对此采取行动,但政府可能发现这还不够,”Renda说。在欧洲,欧盟正在制定道德准则,并可能通过“命令和控制立法,或通过认证和联合监管”来执行这些准则。在美国,国会已经公布了两党共同制定的潜在监管原则,但联邦监管可能会缓慢进行,目前尚不清楚议员们是否想要深入车祸的道德偏好这一泥沼。

Renda 警告说,尽管公众需要参与到这些辩论中来,但“仅仅依靠自下而上的协商将是极其危险的。”他说,各国政府和专家需要做出选择,重申人权。

但在德国,我们已经看到了新的问题。德国是目前唯一一个对自动驾驶汽车的伦理选择提出官方指导方针的国家。议员们试图剖析电车问题的棘手之处,指出所有人的生命都应该被平等对待,任何基于个人特征的区别,如年龄或性别,都应该被禁止。

但正如MIT的研究人员指出的那样,如果这一选择得以实施,将有悖于公众倾向于拯救年轻人多于老年人的偏倚。他们会问,如果政府推出这项政策,它将如何应对这种集体反对,“当自动驾驶汽车在道德困境中选择牺牲儿童的那一天,这种抵制将不可避免地发生。”

Awad说,这种冲突是“不可避免的”,但必须成为这个过程的一部分。“重要的是要让这些决定变得透明,”他说,“要公开说明正在做什么。如果这一切都发生在幕后,只对人们说’相信我们’,我认为这是不会被接受的。每个人都需要参与到这些决策中来。”

原文链接:

https://www.theverge.com/2018/10/24/18013392/self-driving-car-ethics-dilemma-mit-study-moral-machine-results

新智元AI WORLD 2018

世界人工智能峰会全程回顾

新智元于9月20日在北京国家会议中心举办AI WORLD 2018世界人工智能峰会,邀请机器学习教父、CMU教授 Tom Mitchell,迈克思·泰格马克,周志华,陶大程,陈怡然等AI领袖一起关注机器智能与人类命运。

全程回顾新智元 AI World 2018 世界人工智能峰会盛况:

爱奇艺

上午:https://www.iqiyi.com/v_19rr54cusk.html

下午:https://www.iqiyi.com/v_19rr54hels.html

新浪:http://video.sina.com.cn/l/p/1724373.html