由你投票选出的NeurIPS 2022论文直播分享拍了拍你

(本文阅读时间:9分钟)

备受关注的人工智能国际顶会 NeurIPS 2022 于昨天正式拉开帷幕。在此前的系列文章中,我们从人工智能的五大热点话题与大家分享了微软亚洲研究院入选 NeurIPS 2022 的论文,包括人工智能大一统与理论研究,赋能产业界的人工智能,以及有创造力又负责任的人工智能。每篇文章末尾的投票结果现已诞生!

被大家所 pick 的人气论文们,将于12月2日(本周五)14:00登录“微软中国视频中心”的 B 站直播间,与大家在云端零距离见面!欢迎多发弹幕参与互动,在每篇论文分享结束后,讲者将在问答环节中解答弹幕中提出的问题!

直播时间:

2022年12月02日14:00-16:00

直播地址:

B 站账号“微软中国视频中心”直播间

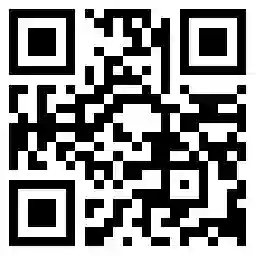

扫码直达 B 站直播间

付强

微软亚洲研究院

高级研究员

付强博士毕业于清华大学电子工程系,现任微软亚洲研究院高级研究员,主要从事机器学习、深度神经网络、图神经网络等方面的算法、理论及应用研究。此前,付强博士任微软(美国)搜索广告部高级应用科学家,从事信息检索、自然语言理解、图像处理等方面的算法研究及其在搜索广告产品中的应用。付强博士在机器学习、数据挖掘、计算机系统等领域的国际顶级会议及期刊上共发表论文40余篇,并持有多项美国专利。

论文题目:

稳定的神经元响应会提升模型泛化性能

Neuron with Steady Response Leads to Better Generalization

论文摘要:

能否探寻到统摄不同任务和网格结构的本质共性来提高多种网络的泛化性能,是本文的研究切入点。本文从神经元级别的细粒度出发,仔细分析了单个神经元在神经网络训练和测试中的响应特性,发现提升神经元对同类输入样本响应的稳定性能够有效地提高神经网络的泛化性能。据此,本文提出了一种通用的正则项,用于控制神经元在激活状态下响应的类内方差。该正则项简单高效,能在不同领域的多个数据集(ImageNet, CIFAR10, PubMed, WikiCS)以及多种网络结构 (MLP, CNN, GNN)上普遍地提升模型的泛化性能。

论文链接:

https://www.microsoft.com/en-us/research/publication/neuron-with-steady-response-leads-to-better-generalization/

王希廷

微软亚洲研究院

高级研究员

王希廷,微软亚洲研究院社会计算组高级研究员,研究兴趣为可解释、负责任的人工智能。她的研究成果发表在 ICML、KDD 等顶级会议期刊上,并在多个产品中落地应用。她曾两次获得 CCF-A 类期刊 TVCG 封面论文奖,获 AAAI 2021 Best SPC 奖,正担任 IJCAI 领域主席。

论文题目:

基于逻辑规则推理的自可解释深度学习框架

Self-explaining deep models with logic rule reasoning

论文摘要:

本文提出的框架把给定黑盒模型升级成自可解释深度模型,在没有人工规则标注的情况下自动提取逻辑规则。生成的解释和人推理逻辑相似性高,升级后的模型预测准确性不降低、对噪音更鲁棒,同时容易融入用户反馈。

论文链接:

https://www.microsoft.com/en-us/research/publication/self-explaining-deep-models-with-logic-rule-reasoning/

孙宇冲

中国人民大学

博士生

孙宇冲,中国人民大学高瓴人工智能学院直博三年级,研究兴趣包括自然语言多模态理解、多模态交互等。

论文题目:

基于多模态时序对比学习的长视频-语言预训练

Long-Form Video-Language Pre-Training with Multimodal Temporal Contrastive Learning

论文摘要:

本文探索了直接从长视频-语言中学习表征以帮助许多长视频-语言理解任务。本文提出了 Long-Form VIdeo-LAnguage 预训练模型(LF-VILA),并在大规模长视频和段落数据集 LF-VILA-8M 上进行了训练。本文还提出了一种多模态时序对比学习(MTC)损失和一种分层时间窗口注意力(HTWA)机制,以有效的端到端的方式更好地对齐视频和语言。LF-VILA 在多个长视频-语言及长视频理解任务上取得了最好的性能。

论文链接:

https://www.microsoft.com/en-us/research/publication/long-form-video-language-pre-training-with-multimodal-temporal-contrastive-learning/

赵宇澄

中国科学技术大学

博士生

赵宇澄,中国科学技术大学的三年级博士生,导师是查正军教授。他于2018年从中国科学技术大学取得了学士学位。他是微软亚洲研究院智能多媒体组的研究实习生,研究方向为自监督表征学习和计算机视觉,已经在 IJCAI、AAAI、NeurIPS 和 ICCV 等会议上发表多篇论文。

论文题目:

周边视觉注意力网络

Peripheral Vision Transformer

论文摘要:

人类拥有周边视觉这种特殊的视觉处理系统,我们的整个视野可以根据到凝视中心的距离被划分为多个轮廓区域,而周边视觉使我们能够感知不同区域的各种视觉特征。受此启发,微软亚洲研究院的研究员们探索了在深度神经网络中模拟周边视觉进行视觉识别的方法。

论文链接:

https://www.microsoft.com/en-us/research/publication/peripheral-vision-transformer/

宋晓壮

微软亚洲研究院

机器学习组实习生

宋晓壮,在北京邮电大学和南方科技大学分别获得本科与硕士学位,作为研究实习生在微软亚洲研究院从事应用驱动的人工智能解决方案相关的研究,研究兴趣为多任务学习、机器学习、图学习等。

论文题目:

面向多任务分组学习的元学习框架

Efficient and Effective Multi-task Grouping via Meta Learning on Task Combinations

论文摘要:

为应对任务组合爆炸增长的挑战,在本文中研究员们为多任务分组学习提出了一套元学习框架来实现有效的任务分组。结果显示在几乎同等的计算开销下,相对于现有的最佳方案,本文提出的方法获得了几乎翻倍的性能提升。

论文链接:

https://openreview.net/forum?id=Rqe-fJQtExY

卢佩玲

微软亚洲研究院

研发工程师

卢佩玲,微软亚洲研究院研发工程师,主要研究方向为音乐生成、音乐理解和唱歌合成。她对于利用深度学习模型进行音乐结构建模、歌词到旋律的生成、编曲、配乐、唱歌声音合成有一定的研究,先后在 NeurIPS、EMNLP、ISMIR、Interspeech 发表过相关工作。

论文题目:

Museformer: 结合粗/细粒度注意力机制的音乐生成模型

Museformer: Transformer with Fine- and Coarse-Grained Attention for Music Generation

论文摘要:

为了更好地建模音乐长序列,本文提出 Museformer,它包含一种新颖的细粒度和粗粒度相结合的注意力机制,更加切合音乐序列的特点:序列长(超过10000个token),以及具有重复结构。Museformer 既能精准编码音乐结构相关信息,又能以较小代价保留其他重要信息,且相较于全注意力模型,在32GB显存下,Museformer 能够编码超过其3倍长度的序列,并且训练速度在长序列场景下也提升显著。

论文链接:

https://arxiv.org/abs/2210.10349

请锁定 B 站账号“微软中国视频中心“,精彩讲解与您不见不散!

你也许还想看: