【NeurIPS2020提交论文】通用表示Transformer层的小样本图像分类

A Universal Representation Transformer Layer for Few-Shot Image Classification

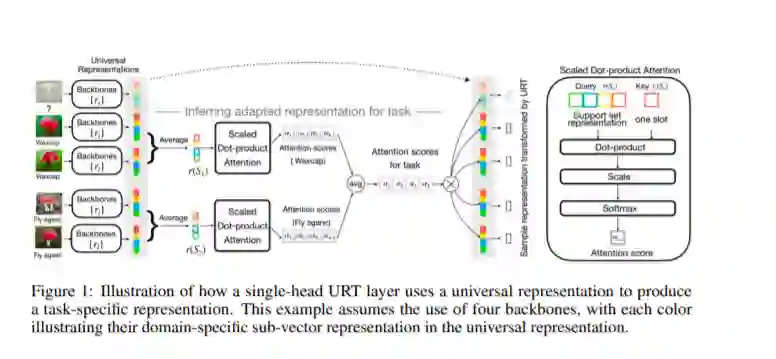

小样本分类的目的是在只有少量样本的情况下识别不可见的类。我们考虑了多域小样本图像分类的问题,其中不可见的类和样例来自不同的数据源。人们对这个问题越来越感兴趣,并激发了元数据集等基准的开发。在这种多领域设置的一个关键挑战是有效地整合来自不同训练领域集的特征表示。在这里,我们提出了一个通用表示转换器(URT)层,该元学会通过动态地重新加权和组合最合适的特定于领域的表示来利用通用特性进行小样本分类。在实验中,我们表明,URT在元数据集上设置了一个新的最先进的结果。具体来说,它在三个数据源上的性能超过了之前最好的模型,或者在其他数据源上也有相同的性能。我们分析了城市轨道交通的各种变体,并给出了一个可视化的注意力分数热图,以阐明该模型是如何执行跨领域泛化的。我们的代码可以在https://github.com/liulu112601/URT获得

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“URTL” 可以获取《[NeurIPS2020提交论文】通用表示Transformer层的小样本图像分类》专知下载链接索引

登录查看更多