You Only Watch Once:实时人体动作定位网络

加入极市专业CV交流群,与6000+来自腾讯,华为,百度,北大,清华,中科院等名企名校视觉开发者互动交流!更有机会与李开复老师等大牛群内互动!

同时提供每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流。关注 极市平台 公众号 ,回复 加群,立刻申请入群~

今天跟大家介绍一篇YOLO风格浓郁的论文,来自慕尼黑工业大学的学者受人类视觉的启发,提出一种快速实时的视频动作定位方法You Only Watch Once(YOWO),达到了目前最好的效果,而且代码将开源。

下面为作者信息:

视频动作定位是在视频中定位出正在执行动作的主体并识别出动作的问题。

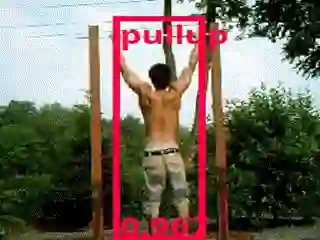

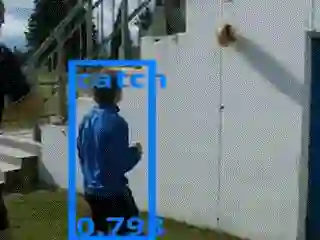

请看下面这幅动图:

很显然该问题包括:在多帧中定位主体和动作分类。

在对关键帧(当前帧)进行动作分类时,很显然要考虑之前的数据。

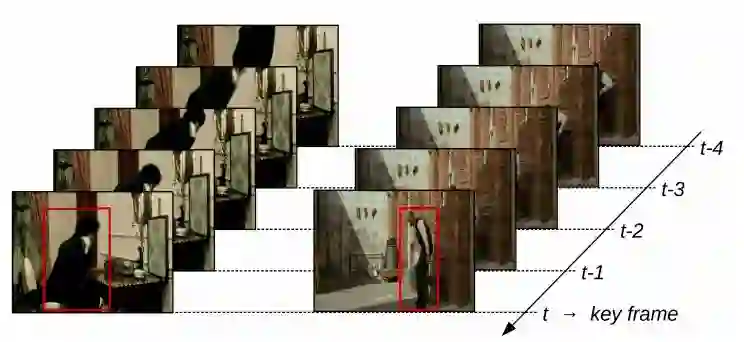

作者提出的算法正是在这一观察下,结合3D-CNN 提取时空信息和2D CNN 提取位置信息再特征融合,并参考YOLO检测方法提出来的。

不同于以往类似Faster R-CNN两阶段方法,先生成大量proposals,再进行分类和位置提精,YOWO在一个网络中实现了时空信息的提取和融合,易于训练,精度高,而且速度也很快。

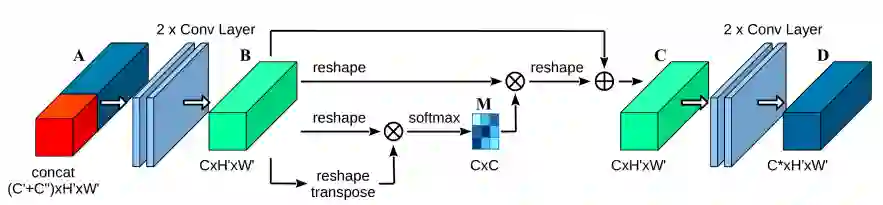

算法架构

下图为YOWO从数据输入到输出的整个过程:

使用3D CNN对视频片段提取时空信息,使用2D CNN对关键帧提取空间信息,对得到的两部分特征进行注意力机制和通道融合(CFAM)的特征聚合,后面的过程与YOLO一样,卷积后进行分类和包围框回归。

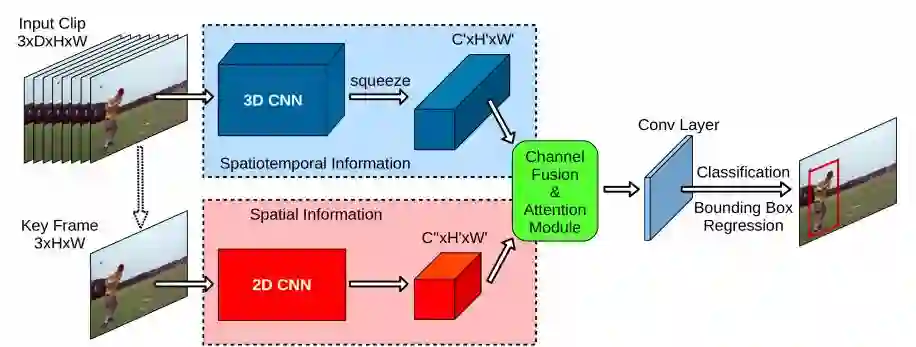

作者提出的CFAM特征聚合方法:

开始处,红色和深蓝色代表前一阶段的两个分枝的特征拼合在一起。

实验结果

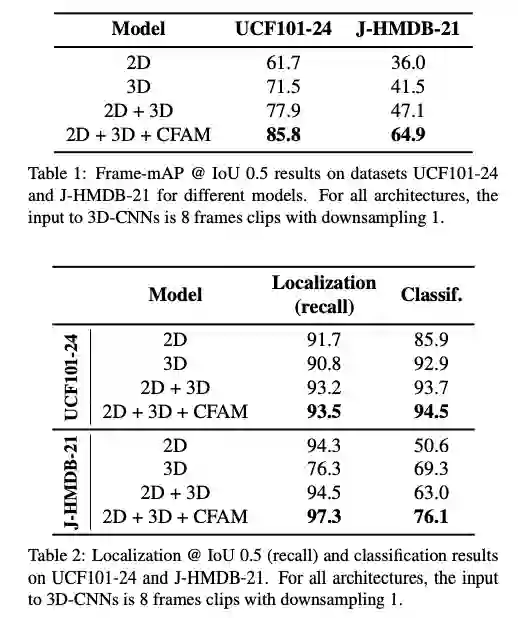

作者在UCF101-24 和 J-HMDB-21数据集上进行了实验,验证了算法各部分的有效性,并在与state-of-the-art算法的比较上,取得明显的精度改进。

上图展示了在两种度量标准下,作者提出的算法各部分都取得了精度增益。

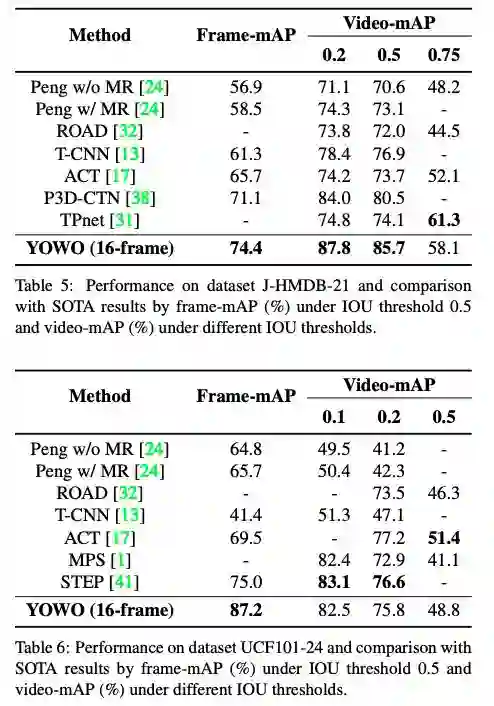

在两个数据集上与SOTA算法的结果比较:

在Frame-mAP的度量标准下,YOWO达到了更高的精度,分别比之前的最好结果提高了3.3 和12.2 个百分点。

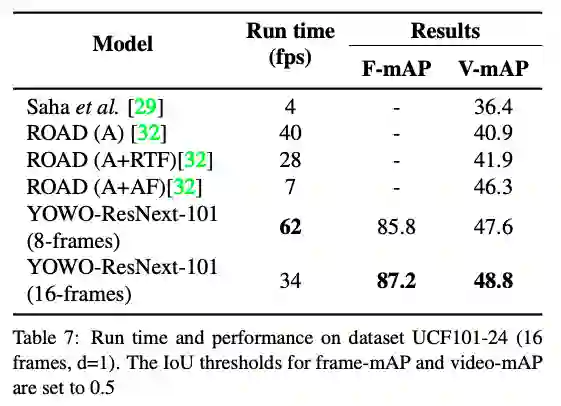

与其他算法相比,速度更是一大亮点:

在Titan xp GPU上,YOWO 可达到 62 fps!

以下是作者给出的一些结果:

这个问题还是蛮有意思的,把YOWO用在“打架识别”,应该很有前途^_^

论文地址:https://arxiv.org/pdf/1911.06644.pdf

项目地址:https://github.com/wei-tim/YOWO(还未开源,但已经引起了很多人关注!)

-End-

*延伸阅读

CV细分方向交流群

添加极市小助手微信(ID : cv-mart),备注:研究方向-姓名-学校/公司-城市(如:目标检测-小极-北大-深圳),即可申请加入目标检测、目标跟踪、人脸、工业检测、医学影像、三维&SLAM、图像分割、OCR、姿态估计等极市技术交流群(已经添加小助手的好友直接私信),更有每月大咖直播分享、真实项目需求对接、干货资讯汇总,行业技术交流,一起来让思想之光照的更远吧~

△长按添加极市小助手

△长按关注极市平台

觉得有用麻烦给个在看啦~