【紫冬新知】 想改进你的卷积神经网络?点开本文了解一下!

【写在前面】

2012年以来,卷积神经网络成为了人工智能领域研究的热点之一,并被成功应用在语音、图像、视频等诸多领域。自动化所常建龙博士提出一种新型的结构感知卷积网络,并在诸多实验中证明其鲁棒性、迁移性均优于传统的卷积神经网络。

近年来,深度学习可以说是模式识别与机器学习界最热的研究内容之一了。而深度学习中的热点,非卷积神经网络莫属。通过有效的参数共享方式,卷积神经网络可以在保证模型的性能大量地减少模型参数,并因此逐渐发展成了深度学习的一个重要分支。

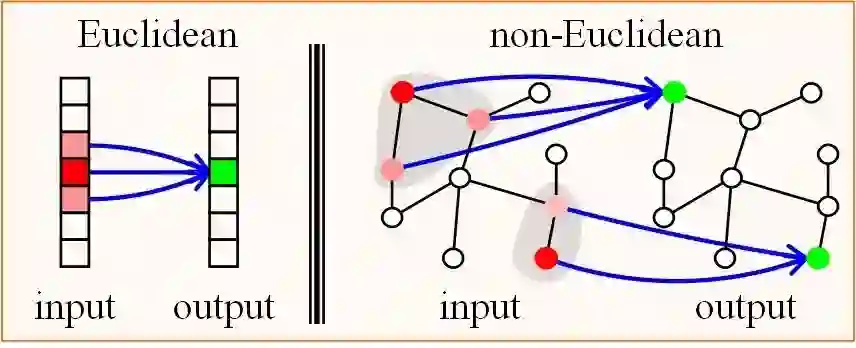

图1简单概括了一些常见的卷积操作。根据卷积的应用范围,我们将卷积分为欧几里得空间卷积和非欧几里得空间卷积。更为精细地,欧几里得空间的卷积可以分为手工设计的卷积和可学习的卷积;在非欧几里得空间的卷积可以分为谱域的卷积和空域的卷积。总的来说,所有的卷积都是在探讨如何对局部数据按照某一个操作聚合,不同的操作方式就对应于不同的卷积。

2012年以来,卷积神经网络成为了人工智能领域研究的热点之一,并被成功应用在语音、图像、视频等诸多领域。但是卷积神经网络也有其无法施展其优势的领域。

图2. 常见的非欧几里得空间数据(来自网络)

实际中遇到的数据不仅仅是语音、图像、视频等处于欧几里得空间的数据,更多的是一些处于非欧几里得空间的,例如图2中的社交网络中的关系数据、三维点云数据、分子结构数据、基因数据和交通数据等等。由于局部输入的无序性和维度的可变性,传统卷积网络很难处理这种处于非欧几里得空间的数据。为此,我们一般化了传统卷积操作,使得新的卷积神经网络可以应用到一般结构的数据上,而不是仅局限于处理欧几里得空间的数据。

▼ 数据=特征+结构 ▼

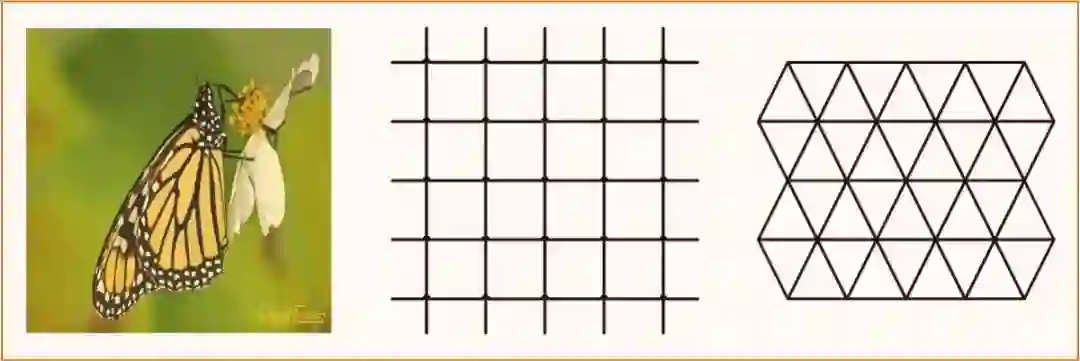

图3. 每个顶点表示像素点。中间图为4邻域,右图为6邻域。

例如对图像而言,特征为像素值,结构为规则的格子空间。值得注意的是,虽然我们经常默认为图像的“十”字形的格子空间,其实“米”字形的格子空间也是可以表示图像的,即周围有6个邻域,而非4邻域,如图3所示。

▼ 卷积,其本质是局部数据的一个聚合操作 ▼

图4. 欧几里得空间卷积和非欧几里得空间卷积。

如图4所示,学习卷积核的过程其实是学习局部聚合参数的过程,并且每个局部的参数是可共享的。学习的过程即是确定这种聚合方式的过程。

下面就是重头戏了

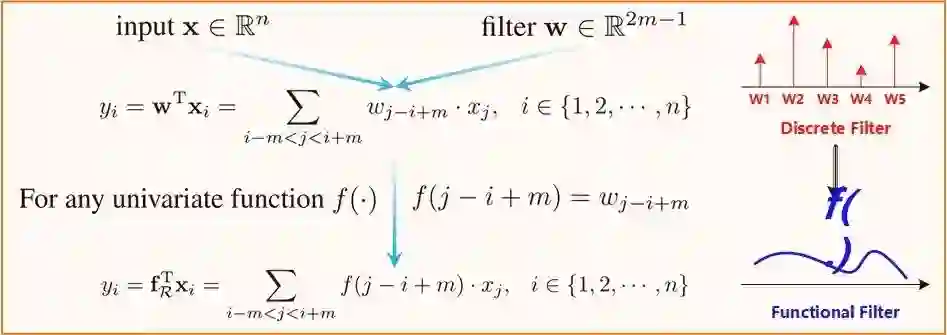

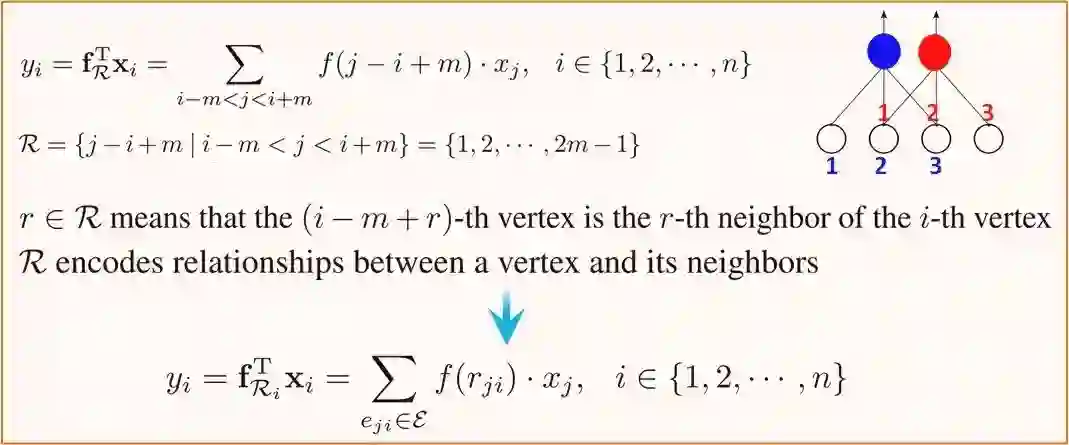

在传统卷积中,卷积核被表示为离散的向量。为了可以聚合任意维的局部输入,我们将离散的有限维卷积核一般化为连续的无穷维卷积核,即单变量函数。根据这一直观的泛化,有图5最后的表示。

图5. 结构感知卷积之卷积核泛化

通过考虑局部输入的数据结构,我们将结构信息建模到了结构感知卷积中。如图6所示,传统的卷积操作隐式地对数据的局部结构进行了建模。也就是说,传统卷积默认了“输入的第i-m+r个节点都是第i个节点的第r个邻居”。这种关系描述了一种很强的局部结构,但是仅仅适应于描述欧几里得空间数据。为了可以处理一般性的数据,我们对这种局部结构描述进行泛化,即用一个可学习的参数rji去替换原来的j-i+m来建模和学习局部的结构。此流程如图6所示。

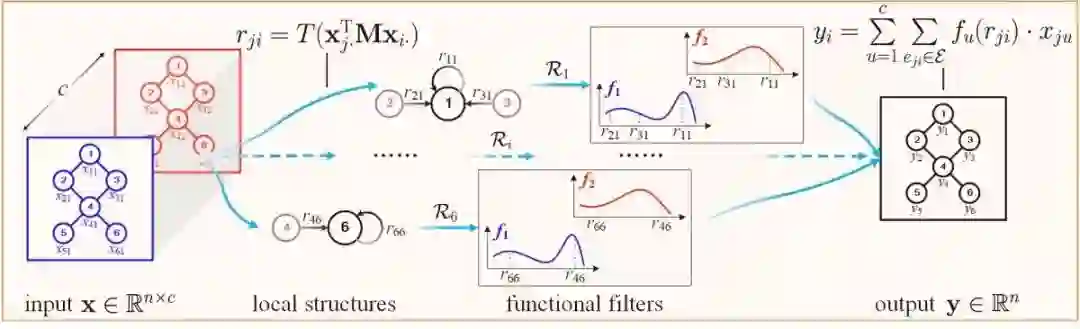

图7给出了一个输入为两个通道、输出为一个通道的结构感知卷积。首先通过相似度估计,估计出两两节点之间的相似度rji,即关系或者结构。然后再用卷积核f和结构rji对每个节点周围的数据进行聚合,即最后的式子。

图7. 结构感知卷积网络,输入为两个通道,输出为一个通道

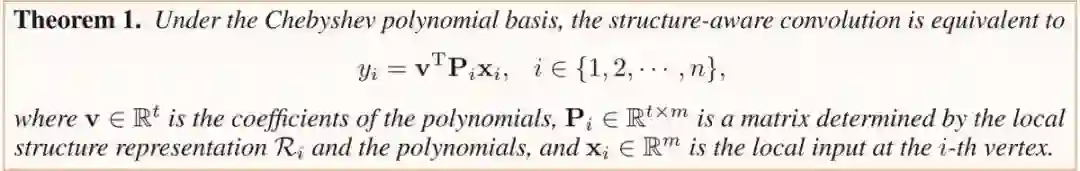

该定理直观表明结构感知卷积由局部结构确定的一个映射矩阵和全局共享的可学习的多项式系数构成。因此,在实际中结构感知卷积可通过局部结构得到一个映射矩阵,将任意维度的输入变换为固定维数,进而通过一个可共享的局部聚合操作来实现对任意结构的聚合。

值得注意的是,定理1虽然表明结构感知卷积是由两个部分组成,但是这在实际中运行效率很低。为了使得模型可以更高效地在GPU上运行,我们基于函数逼近理论用切比雪夫多项式来拟合新提出的函数滤波器,最终使结构感知卷积操作可以高效地且有效地在GPU上运行。这是因为,切比雪夫多项式的n阶基函数(n>1)都可以由n-1阶基函数和n-2阶基函数表示,所以函数滤波器的学习可以分解为一系列矩阵的迭代加法运算。因为GPU上适合执行矩阵运算,所以使得模型可以在实际中更高效地执行。

为什么是【结构感知卷积网络】

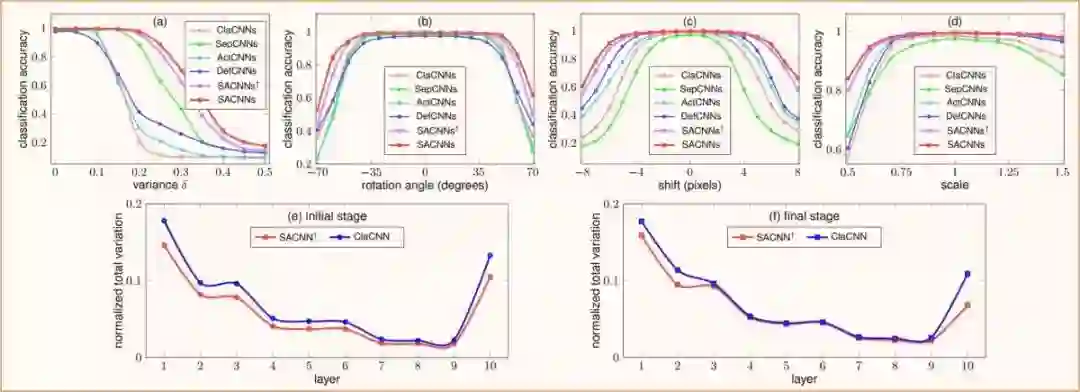

图8. 结构感知网络的稳定性

如图8所示,相对于传统的卷积网络,结构感知卷积对高斯噪声、旋转、平移和尺度变化更鲁棒。这是因为我们学习的卷积核来自于一个连续的函数,卷积核中的所有元素之间都是相关的,这使得卷积核的方差更小、更光滑,最后获得更高的鲁棒性。

图9. 结构感知网络消融实验。(a) 基函数个数影响,(c)网络的可迁移性。

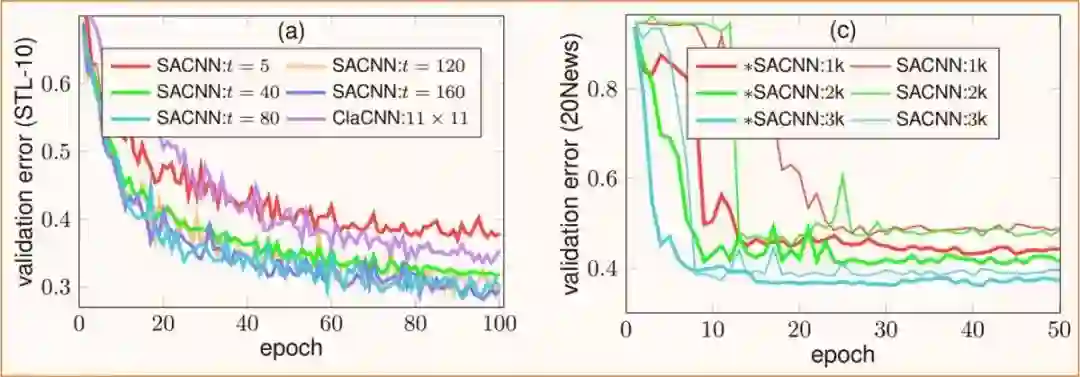

基函数个数的影响

不同阶数的基函数去用来拟合不同复杂度的函数卷积核。我们在STL-10数据库上建立不同的网络来证明基函数个数对结构感知卷积网络的影响。其中基准网络中卷积核大小为11*11,在结构感知卷积中基函数个数为t={5,40,80,120,160}。如图9(a)所示,当t为5的时候,结构感知卷积网络性能最差。随着t的增大,结构感知卷积网络的性能会优于传统卷积网络的性能,并且当t>40时已经有此优势了。这就意味着,传统的离散卷积核中的参数是有冗余的。也就是说,不仅仅高维的数据是嵌入在一个低维流形里面的,神经网络的海量参数也是嵌入在一个低维流形里面的(神经网络可以压缩的原因)。

具备可迁移性

我们在两个相似的图数据库(Reuters和20News)上做实验来证明学习得到的结构感知卷积网络是具备迁移性的。为此,我们首先在Reuters数据库上训练得到一个结构感知卷积网络,然后将其参数直接迁移到新的网络*SACNN上来完成对20News的分类。如图9(c)所示,借助于迁移得到的参数,我们的网络可以学习得更稳定、更快,并最终取得更好的性能。

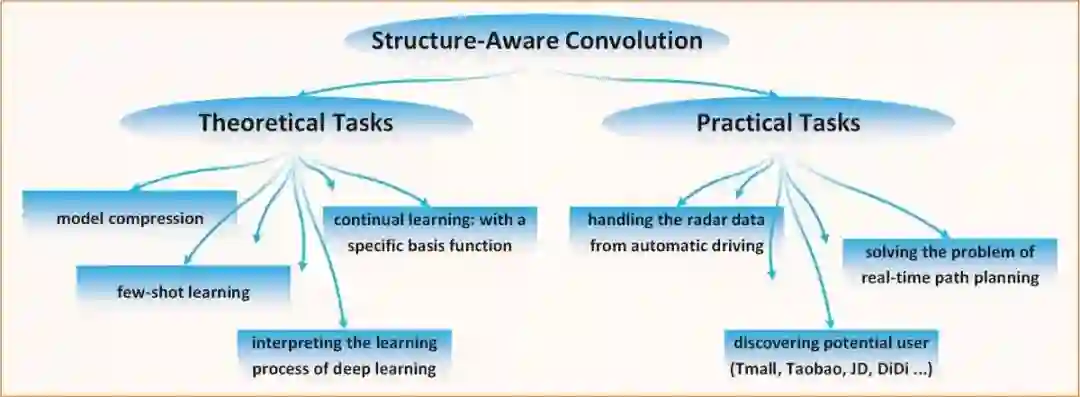

如图10所示,具有结构信息的函数卷积核可望在不同领域的多类型任务中得到应用。(包括并不局限于图中所示案例)。

图10. 结构感知卷积可以被应用的一些场景。

数学的优势在于能将复杂的问题用几个很简单的字母表示出来,例如经典的网络结构残差网络为y=F(x)+x、物理学中的质能方程为E=mc2等等。虽然看似简单,但是如何从更深刻的、更本质的角度去思考、归纳和建模,使得模型conceptually intuitive yet powerful是难点所在。

作者:常建龙,中国科学院自动化所潘春洪研究员博士生,研究兴趣为深度图网络,深度无监督学习和多智能体强化学习。欢迎志同道合的朋友与作者交流讨论!(jianlong.change@gmail.com)

更多精彩内容,欢迎关注

中科院自动化所官方网站:

http://www.ia.ac.cn

欢迎后台留言、推荐您感兴趣的话题、内容或资讯,小编恭候您的意见和建议!如需转载或投稿,请后台私信。

作者:常建龙

审稿:向世明

排版:亚岱尔

编辑:鲁宁

中科院自动化研究所

微信:casia1956

欢迎搭乘自动化所AI旗舰号!