腾讯优图8篇论文入选ECCV 2020,涵盖目标检测/跟踪/Re-ID/人脸等领域

点击上方“CVer”,选择加"星标"置顶

重磅干货,第一时间送达

本文转载自:腾讯优图

近日,计算机视觉方向的三大国际顶级会议之一的ECCV 2020公布论文获奖结果。本次ECCV 2020有效投稿5025篇,最终被接受发表论文1361篇,录取率为27%,较上届有所下降。其中,oral的论文数为104篇,占提交总量的2%;spotlight的数目为161篇,占提交总量的5%;其余论文均为poster。

ECCV (European Conference on Computer Vision,即欧洲计算机视觉国际会议)是国际顶尖的计算机视觉会议之一,每两年举行一次。随着人工智能的发展,计算机视觉的研究深入和应用迅速发展,每次举行都会吸引大量的论文投稿,而今年ECCV的投稿量更是ECCV 2018的两倍还多,创下历史新高。在竞争越来越激烈的情况下,本次ECCV 腾讯优图实验室共入选8篇论文,涵盖目标跟踪、行人重识别、人脸识别、人体姿态估计、动作识别、物体检测等热门及前沿领域,再次展示了腾讯在计算机视觉领域的科研及创新实力。

以下为部分腾讯优图入选ECCV 2020的论文:

01

链式跟踪器:基于目标对回归的端到端联合检测跟踪算法

Chained-Tracker:

Chaining Paired Attentive Regression Results for

End-to-End Joint Multiple-Object Detection and Tracking

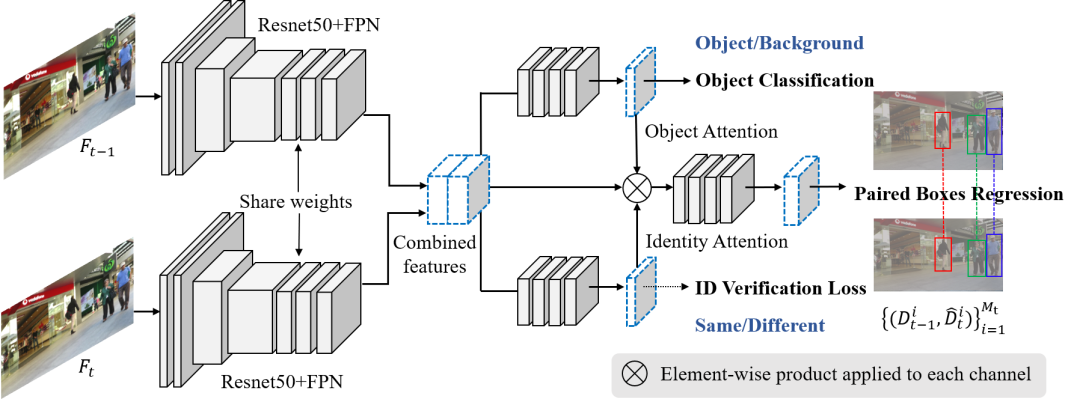

现有的多目标跟踪(MOT)算法大多是基于传统的先检测后跟踪的框架,包含目标检测、特征提取、目标关联这三个模块,还有少数MOT算法将三个模块中的某两个融合实现部分端到端跟踪,本文提出了一种链式跟踪算法Chained-Tracker(CTracker),业内首创两帧输入模式,可将上述三个模块集成至单个网络中,实现端到端联合检测跟踪,是第一个将跟踪算法中的目标关联问题转化为两帧检测框对(Box pair)回归问题的算法。网络的输入为相邻两帧,称之为节点(Chain node),网络的输出为表示同一个目标在相邻两帧中的检测框对,相邻节点的检测框对可通过共同帧关联。为进一步提高跟踪效果,我们还设计了联合注意力模块来突出检测框对回归中的有效信息区域,包括目标分类分支中的目标注意力机制和身份验证分支中的身份注意力机制。在不引入额外数据的情况下,CTracker在MOT16和MOT17上均获得了SOTA的结果,MOTA分别为67.6和66.6。

算法框架图:

网络结构图:

02

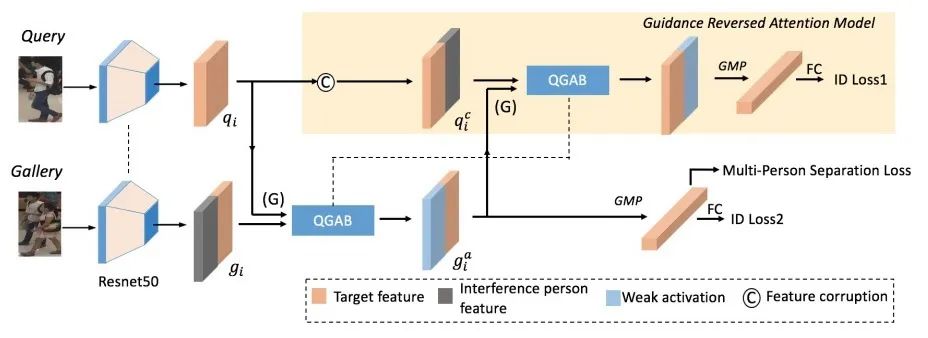

请别来打扰我:在其他行人干扰下的行人重识别

Do Not Disturb Me:

Person Re-identification Under the Interference of Other Pedestrians

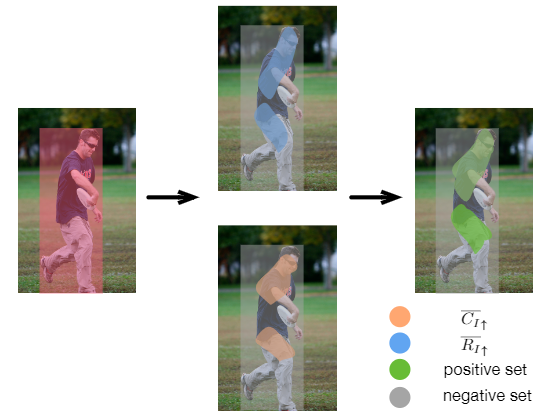

传统的行人重识别假设裁剪的图像只包含单人。然而,在拥挤的场景中,现成的检测器可能会生成多人的边界框,并且其中背景行人占很大比例,或者存在人体遮挡。从这些带有行人干扰的图像中提取的特征可能包含干扰信息,这将导致错误的检索结果。为了解决这一问题,本文提出了一种新的深层网络(PISNet)。PISNet首先利用Query图片引导的注意力模块来增强图片中目标的特征。此外,我们提出了反向注意模块和多人分离损失函数促进了注意力模块来抑制其他行人的干扰。我们的方法在两个新的行人干扰数据集上进行了评估,结果表明,该方法与现有的Re-ID方法相比具有更好的性能。

03

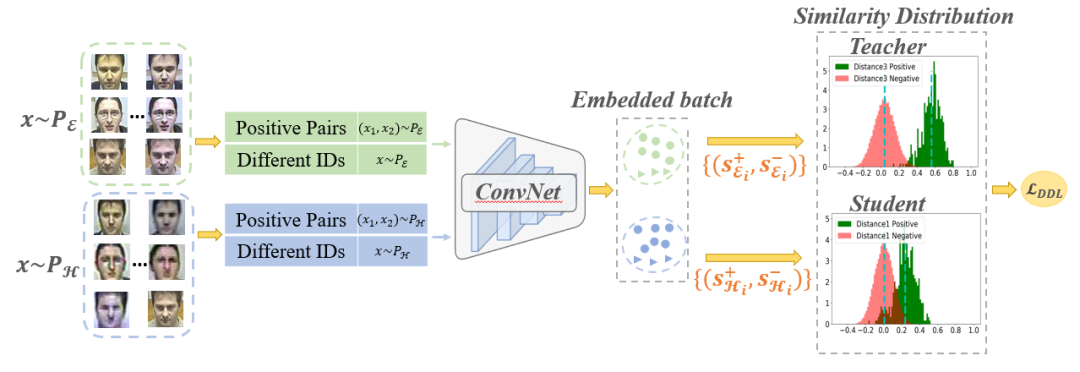

通过分布蒸馏损失改善人脸识别中的困难样本

Improving Face Recognition

from Hard Samples via Distribution Distillation Loss

https://arxiv.org/abs/2002.03662

目前基于深度学习的人脸识别算法已经可以较好的处理简单样本,但对于困难样本(低分辨率、大姿态等)仍表现不佳。目前主要有两种方式尝试解决这一问题。第一种方法是充分利用某种需要处理的人脸畸变的先验信息,设计特定的结构或损失函数。这种方式通常不能方便地迁移到其他畸变类型。第二种方法是通过设计合适的损失函数,减小类内距离,增大类间距离,得到更具辨别能力的人脸特征。这种方式一般在简单和困难样本上存在明显的性能差异。为了提升人脸识别模型在困难样本上的性能,我们提出了一种基于分布蒸馏的损失函数。具体来说,我们首先通过一个预训练的识别模型构造两种相似度分布(从简单样本构造的Teacher分布和从困难样本的Student分布),然后通过分布蒸馏损失函数使Student分布靠近Teacher分布,从而减小Student分布中的同人样本和非同人样本的相似度重合区域,提高困难样本的识别性能。我们在常用的大规模人脸测试集和多个包含不同畸变类型(人种、分辨率、姿态)的人脸测试集上进行了充分的实验,验证了方法的有效性。

04

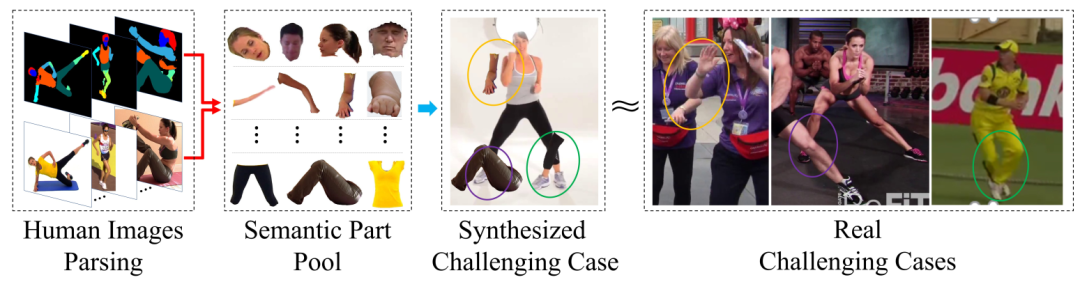

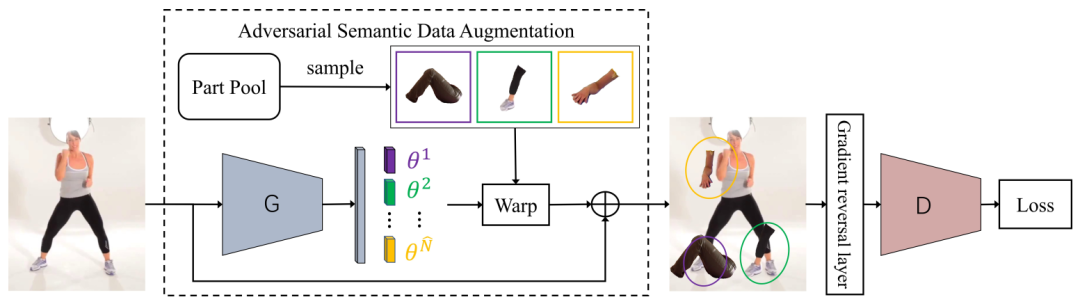

基于对抗语义数据增强的人体姿态估计

Adversarial Semantic Data Augmentation

for Human Pose Estimation

人体姿态估计主要目的是定位人体的关键点坐标。目前的SOTA方法在严重遮挡、旁人干扰、对称相似三种困难场景中表现仍有待提升。一个主要的原因是这三种困难场景的训练数据较少。之前的方法主要是利用scale、rotation、translation等global spatial transform的方法去进行训练数据增强。这类常规的数据增强方法并不能对上述三种困难场景有提升和帮助。本文提出了一种Adversarial Semantic Data Augmentation(对抗语义数据增强方法)。该方法把人体分成多个有语义的部件,并对这些人体部件在不同的细粒度上进行重组,从而去模拟出上述三种困难场景。在重组人体部件的过程中,有多个空间变换参数来调节每一个人体部件,从而灵活的组合旁人遮挡、手臂交叉、复杂动作等情况。为了让人体姿态估计网络能更好的学习到对这些困难场景的鲁棒性,我们设计了另外一个生成网络(G)用于控制每个人体部件的空间变换参数,人体姿态估计网络作为判别网络(D)从G生成的困难样本里面去学习。G和D在训练过程中互相对抗。G网络不断的生成各种困难样本,以迷惑人体姿态估计网络。而人体姿态估计网络从这个对抗过程中也不断提升了自己对困难场景的预测准确性。

05

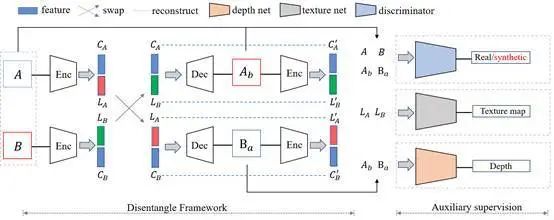

基于特征解耦的人脸活体检测

Face Anti-Spoofing via

Disentangled Representation Learning

活体检测技术用于在身份验证场景中确定对象是否为真人,以防御照片、面具、屏幕翻拍等多种方式的攻击,保证人脸识别安全。目前基于RGB图像的活体检测方法往往从图片中直接提取判别性特征,但该特征可能包含了光照、背景或ID等与活体任务无关的信息,影响方法实际使用的泛化性。针对泛化性问题,本文从特征解耦角度出发,提出以下创新点:

1、设计解耦框架将图片特征解耦成活体相关特征和活体无关特征两部分,并利用活体相关特征进行真假判别。

2、结合底层纹理特征约束和高层深度特征约束,进一步促进活体特征的解耦。

3、探索并展示了影响活体特征的因素,例如攻击介质、采集设备等,进一步深入理解活体任务本质。

本文在多个学术数据集上证明了基于辅助约束的特征解耦方法在活体任务上的有效性。

06

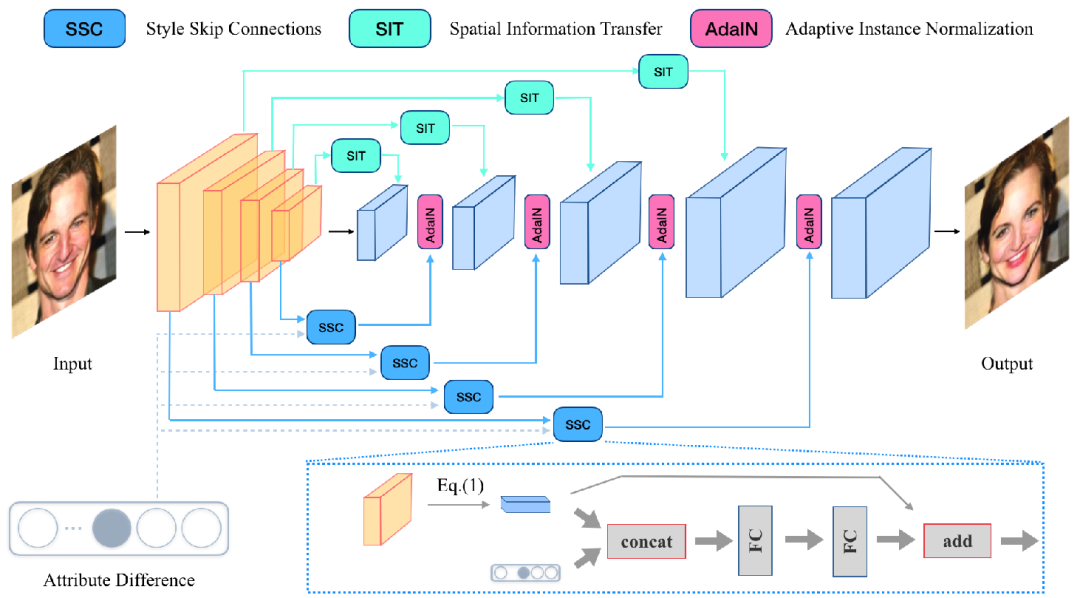

SSCGAN:基于风格跳跃连接的人脸属性编辑

SSCGAN:

Facial Attribute Editing via Style Skip Connections

现有的人脸属性编辑方法通常采用编码器-解码器结构,其中属性信息被表达成一个one-hot向量然后与图像或特征层拼接起来。然而,这样的操作只学到了局部的语义映射而忽略了全局的人脸统计信息。我们在本文提出通过修改通道层面的全局信息(风格特征)来解决这个问题。我们设计了一个基于风格跳跃连接的生成对抗网络(SSCGAN)来实现精准的人脸属性操纵。具体来说,我们在编码器和解码器之间的多个风格跳跃连接路径上注入目标属性信息。每个连接会抽取编码器中的隐藏层的风格特征,然后做一个基于残差的映射函数来将这个风格特征迁移到目标属性的空间。接下来,这个被调整过的风格特征可以用作输入来对解码器的隐藏层特征做实例归一化。此外,为了避免空间信息的损失(比如头发纹理或瞳孔位置),我们进一步引入了基于跳跃连接的空间信息传递模块。通过对全局风格和局部空间信息的操纵,本文提出的方法可以得到在属性生成准确率和图像质量上都更好的结果。实验结果表明本文的算法和现有的所有方法相比都有优越性。

07

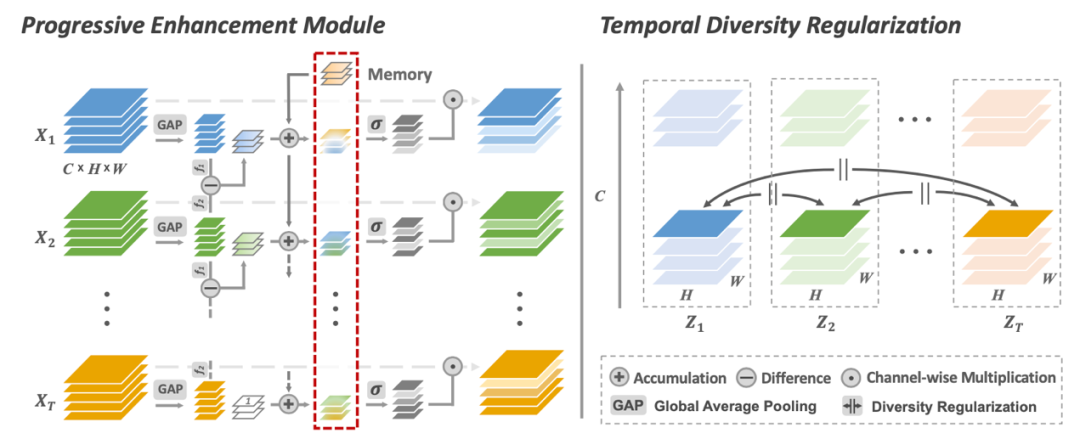

基于时序性差异表征的动作识别

Temporal Distinct Representation Learning

for Action Recognition

https://arxiv.org/abs/2007.07626

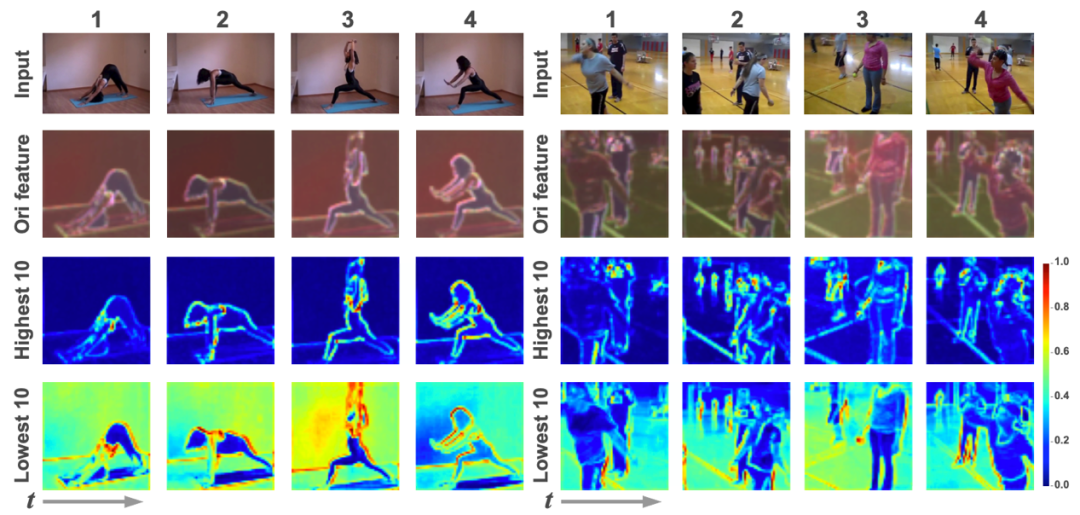

2D卷积神经网络已经广泛应用于图像识别当中并取得成功,研究人员现在在尝试利用2D卷积神经网络来对视频进行建模。然而利用2D卷积的局限性在于视频的不同帧共享参数,会导致重复、冗余的信息提取,尤其是空间语义层面会忽略帧间的重要变化。在这篇工作中,我们尝试通过两种方式来解决这一问题:

一是设计了一种通道层面的序列化注意力机制PEM来逐步地激活特征中有区分性的通道,从而避免信息的重复提取;

二是设计了一种时序多样性损失函数(TD Loss)来强制卷积核关注并捕捉帧间的变化而不是表观相似的区域。

在时序性较强的数据集something-something V1和V2上,我们的方法取得了SOTA效果;另外在时序性较弱但规模较大的Kinetics数据集上,我们的方法也取得了可观的精度提升。

结构示意图:

效果示意图:

08

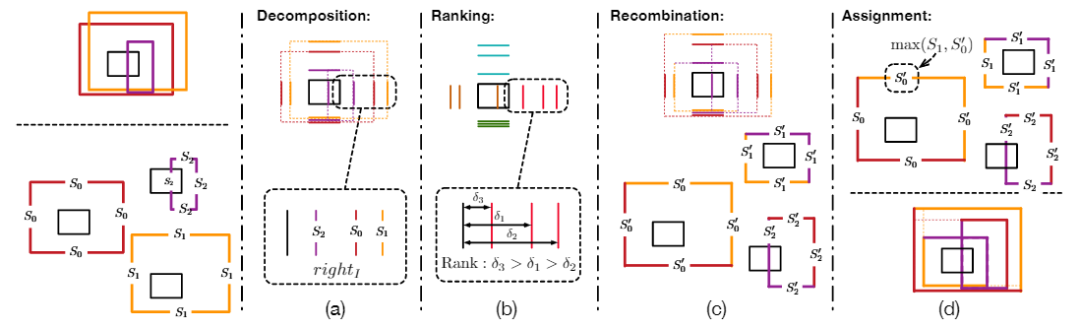

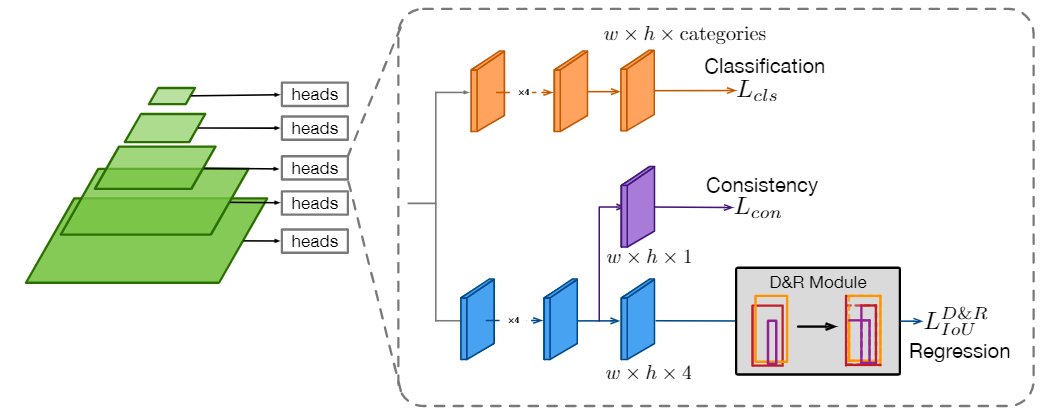

物体检测中检测框学习的深入优化

Dive Deeper Into Box for Object Detection

无锚框检测模型现已成为具有最高检测水准的最新方法,归因于准确的边界框估计。然而无锚框检测在边界定位上还有不足,对于具有最高置信度的边界框仍有很大的改进空间。在这项工作中,我们采用了一种边界重排序的边界框重组策略,使得在训练中能够产生更优的边界框, 从而对物体有更好的贴合。此外,我们观察到现有方法在边界框分类与位置回归学习中存在语义不一致性,所以我们对训练过程中分类与回归目标进行了筛选,从而给出了语义一致性的学习目标。实验证明我们的优化方法上对于检测性能的提升十分有效。

方法示意图

下载1

在CVer公众号后台回复:OpenCV书籍,即可下载《Learning OpenCV 3》书籍和源代码。注:这本书是由OpenCV发起者所写,是官方认可的书籍。其中涵盖大量图像处理的基础知识介绍,虽然API还是基于OpenCV 3.x,但结合此书和最新API,可以很好的学习OpenCV。

下载2

在CVer公众号后台回复:CVPR2020,即可下载CVPR2020 2020代码开源的论文合集

在CVer公众号后台回复:ECCV2020,即可下载ECCV 2020代码开源的论文合集

重磅!CVer-论文写作与投稿交流群成立

扫码添加CVer助手,可申请加入CVer-论文写作与投稿 微信交流群,目前已满2000+人,旨在交流顶会(CVPR/ICCV/ECCV/ICML/ICLR/AAAI等)、顶刊(IJCV/TPAMI等)、SCI、EI等写作与投稿事宜。

同时也可申请加入CVer大群和细分方向技术群,细分方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch和TensorFlow等群。

一定要备注:研究方向+地点+学校/公司+昵称(如论文写作+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲长按加微信群

▲长按关注CVer公众号

整理不易,请给CVer点赞和在看!