如何在黎曼流形上避开鞍点?本文带你了解优化背后的数学知识

机器之心原创

在一篇名为《Escaping from saddle points on Riemannian manifolds》的论文中,来自华盛顿大学、加州大学伯克利分校的研究人员深入探索了优化问题的细节,这对理解机器学习底层的数学知识非常重要。本文是对该论文的解读。

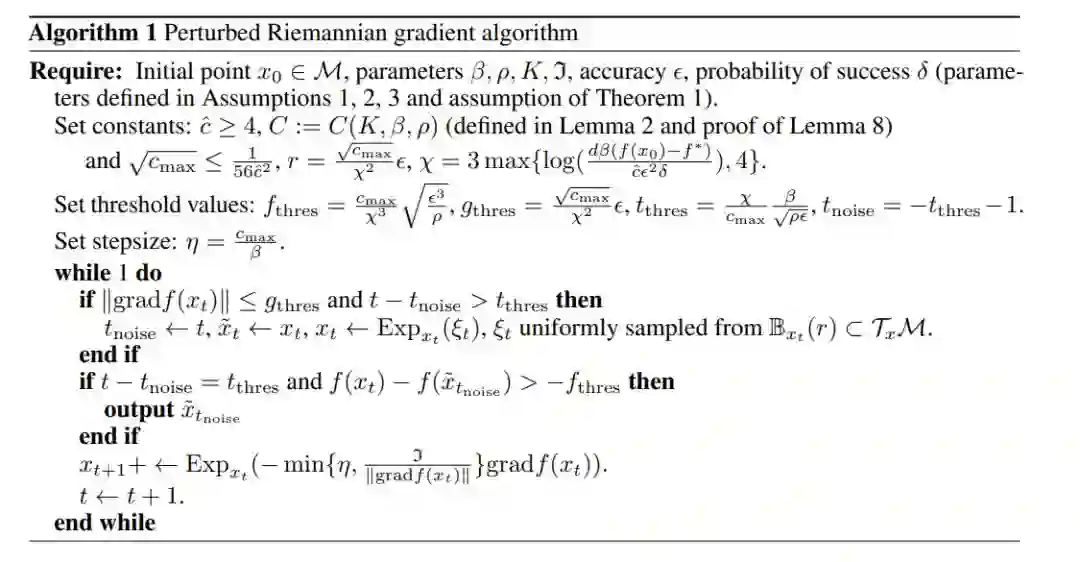

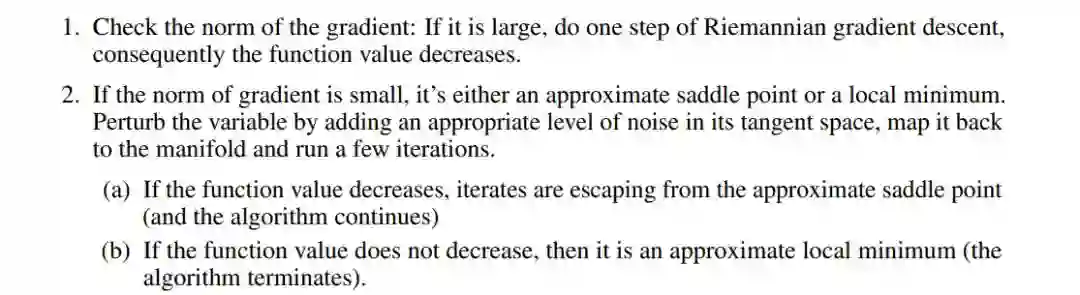

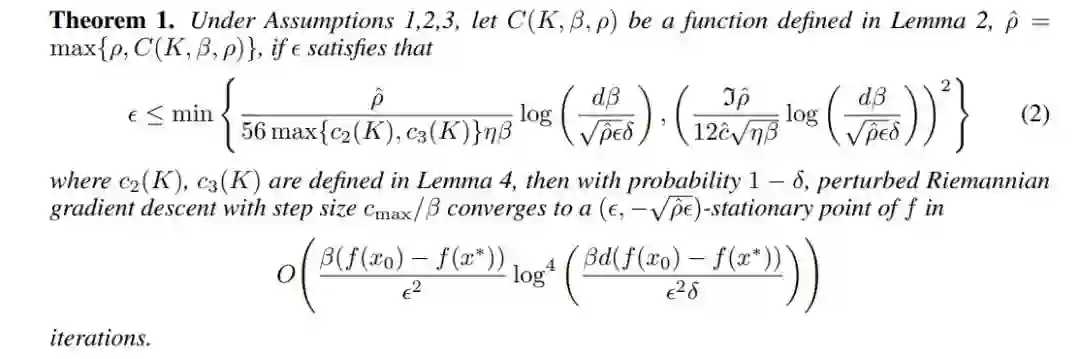

大 O 符号和步长规则都与 β 相关,就此我们可以得出:梯度的利普希茨常数 β 越大,算法收敛时间就越长。

ρ 与参数 ϵ 直接相关,扰动后的黎曼梯度下降(perturbed Riemannian gradient descent)算法将以 1/(2 ϵ^2) 的速率避开鞍点。

流形的维度是影响 ϵ 的另一个参数。我们可以看到 d 以对数的方式影响收敛速率。

登录查看更多