全能王 ORB_SLAM3 它来了!新增VIO、多地图、鱼眼!

点击上方“计算机视觉life”,选择“星标”

快速获得最新干货

在2015年,Juan D. Tardos等人发布了ORB_SLAM2.

2020年暑假,全新 ORB_SLAM3上线啦!!

大脑又要充实啦!

论文地址

https://arxiv.org/abs/2007.11898

代码地址

https://github.com/UZ-SLAMLab/ORB_SLAM3系统组成

数据集测试

官方给了六个视频,这里分享一下

概要

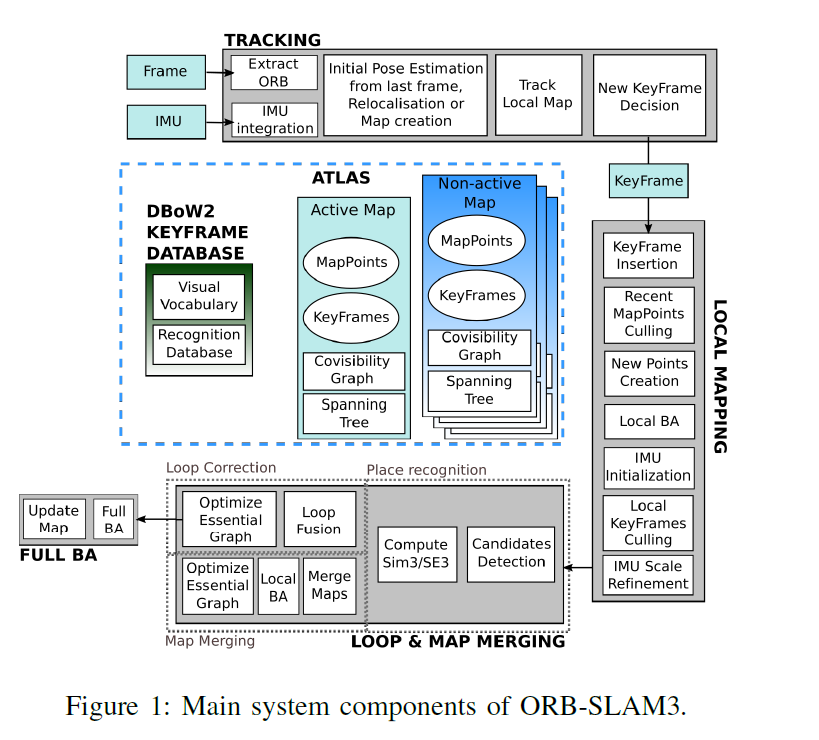

本文介绍了ORB-SLAM3,这是第一个能够用单目、立体和RGB-D相机,使用针孔和鱼眼镜头模型进行视觉、视觉惯性和多地图SLAM的系统.

第一个主要的创新是一个基于特征的紧密集成视觉惯性SLAM系统,它完全依赖于最大后验概率MAP估计,甚至在IMU初始化阶段也是如此.其在小型和大型,室内和室外环境中都能稳定地运行,并且比以前的方法精确2到5倍.

第二个主要的创新是一个多地图系统(multi-map),它依赖于一种新的位置识别方法和改进的召回,多亏了它,ORB_SLAM3能够在长时间的恶劣视觉信息下生存;当它丢失时,它会启动一个新的地图,当重新访问地图区域时,它将与以前的地图无缝地合并.

与只使用最后几秒信息的视觉里程计系统相比,ORB_SLAM3是第一个能够在所有算法阶段重用所有先验信息的系统.这允许包含BA调整共视关键帧,这些关键帧提供了高视差观测,提高了精度.

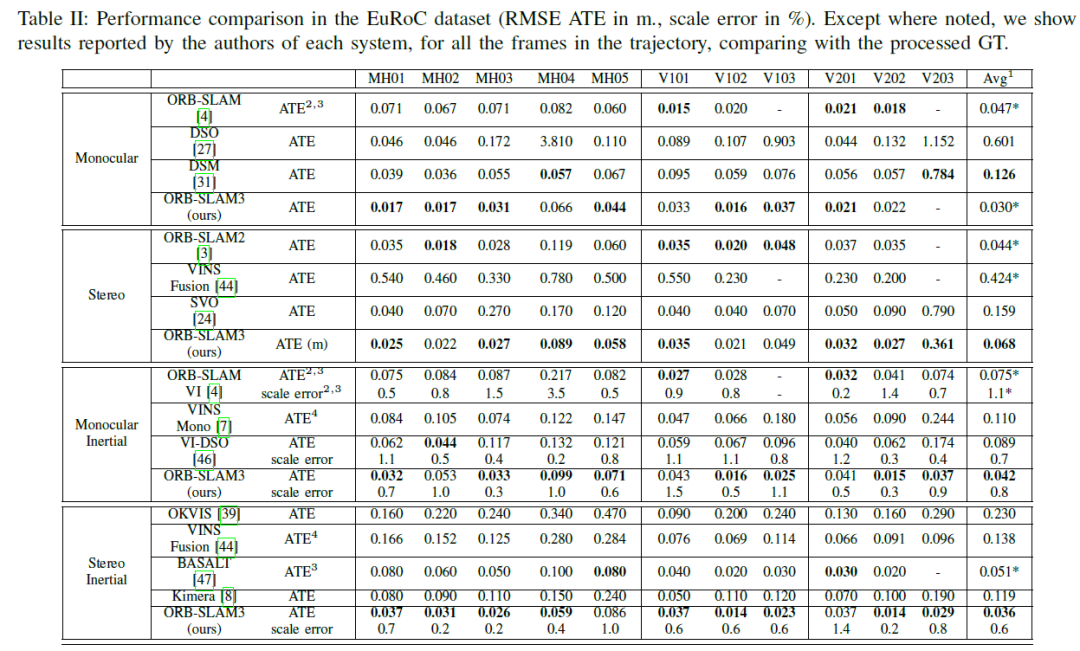

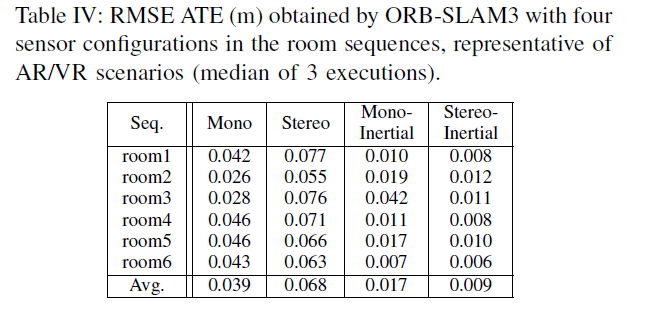

我们的实验表明,在所有的传感器配置中,ORB_SLAM3与文献中可用的最佳系统一样鲁棒,并且更精确.值得注意的是,我们的立体惯性SLAM在EuRoC无人机上的平均精度为3.6cm,在TUM-VI数据集(AR/VR场景的一个典型设置)中,快速手持移动时的平均精度为9mm,最后,我们开源了代码.

实验结果

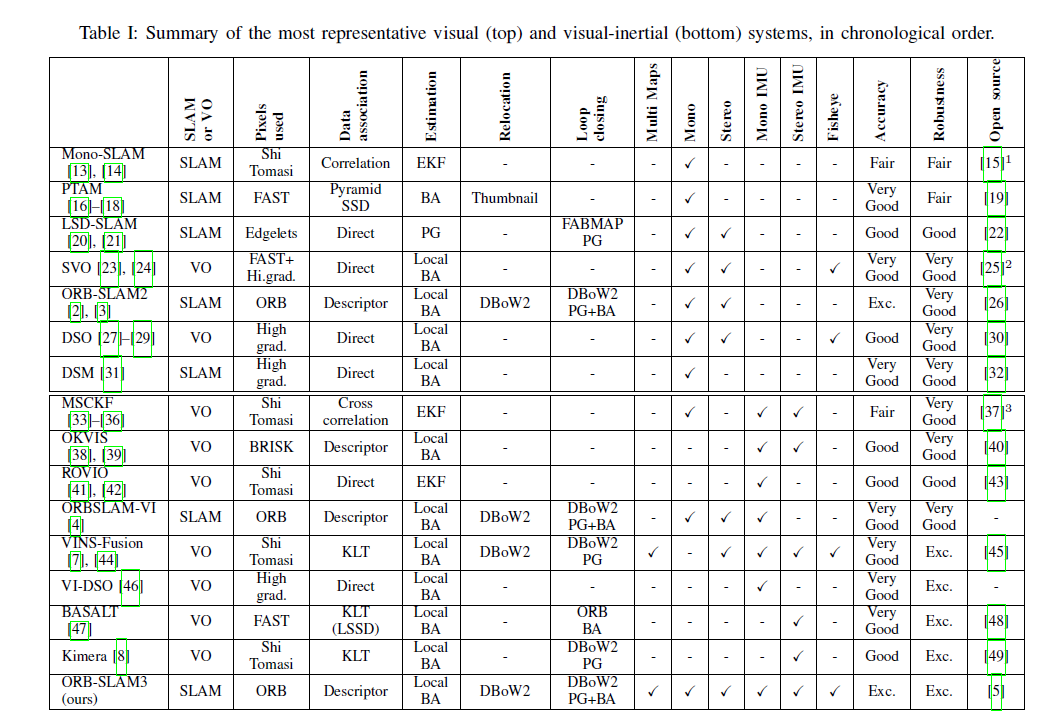

按时间顺序总结的最具代表性的视觉和视觉惯性系统

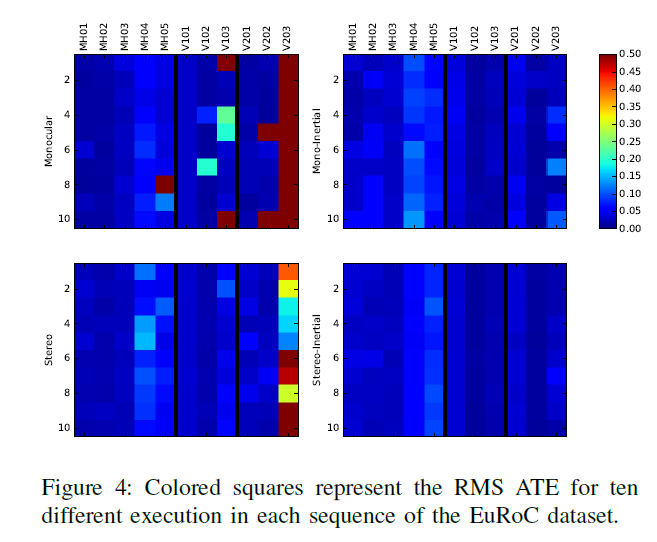

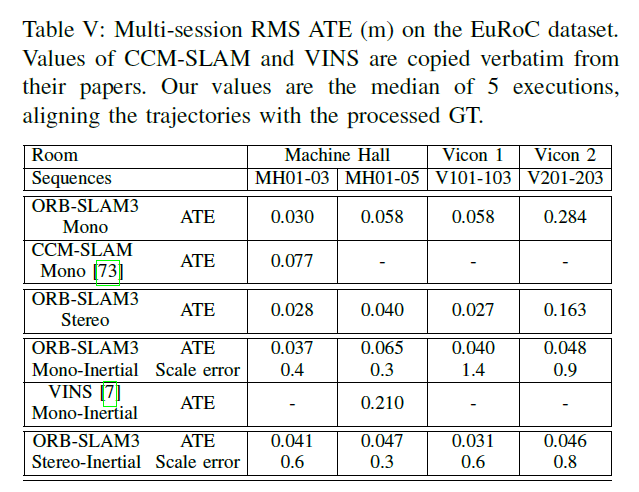

下图为EuRoC数据集的性能比较:

除特别说明外,我们展示了每个系统的作者报告的结果,对轨迹中的所有帧与处理后的GT进行比较.

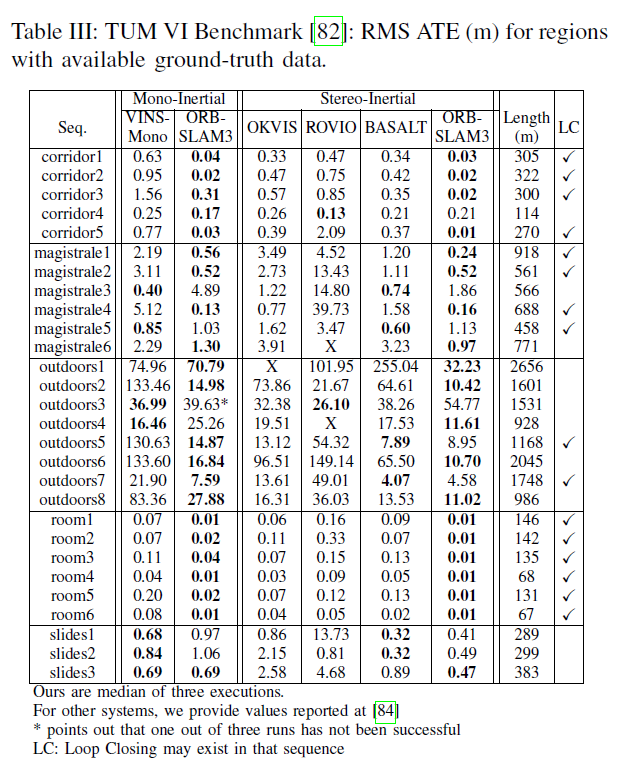

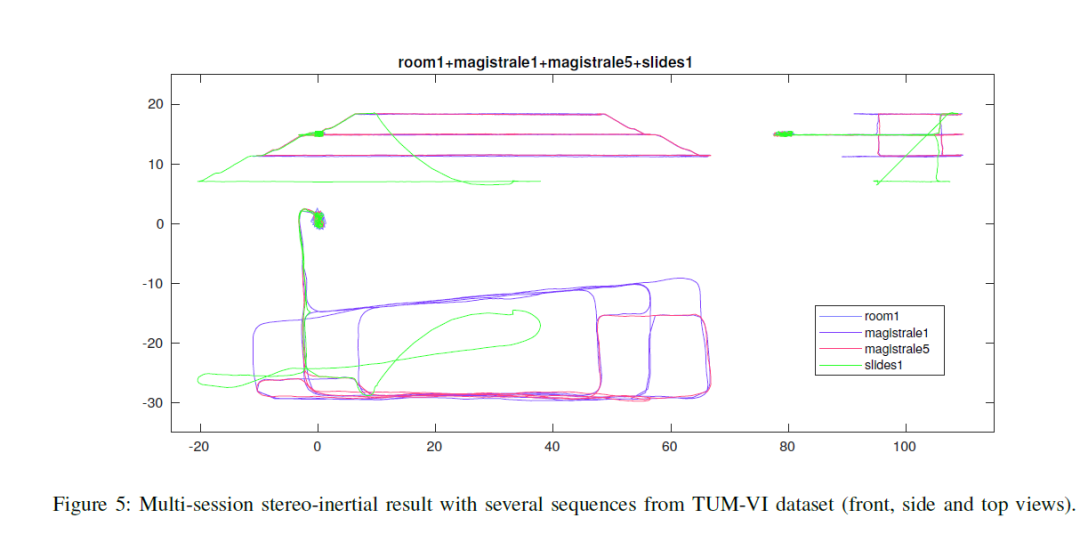

其他结果

从0到1学习SLAM,戳↓

目前ORB-SLAM2逐行代码视频讲解已经到17讲~

交流群

欢迎加入公众号读者群一起和同行交流,目前有SLAM、三维视觉、传感器、自动驾驶、计算摄影、检测、分割、识别、医学影像、GAN、算法竞赛等微信群(以后会逐渐细分),请扫描下面微信号加群,备注:”昵称+学校/公司+研究方向“,例如:”张三 + 上海交大 + 视觉SLAM“。请按照格式备注,否则不予通过。添加成功后会根据研究方向邀请进入相关微信群。请勿在群内发送广告,否则会请出群,谢谢理解~

投稿、合作也欢迎联系:simiter@126.com

长按关注计算机视觉life