AI即将拥有自我意识?Facebook推「Ego4D 」开启元宇宙大门

![]()

新智元报道

新智元报道

来源:Facebook AI

编辑:小咸鱼 好困

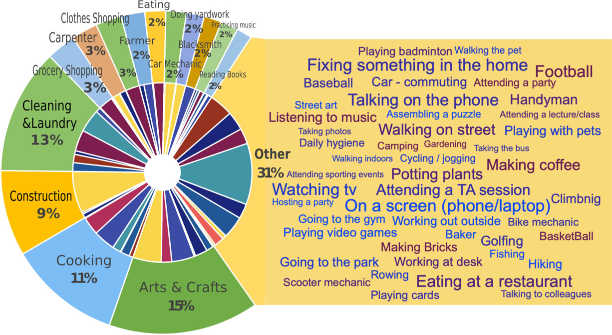

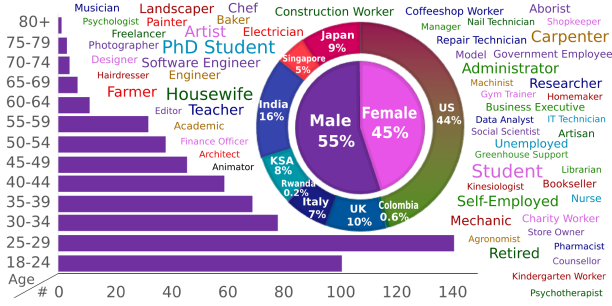

【新智元导读】今年11月,Facebook将开源让AI拥有以第一人称视角与世界进行交互的能力的Ego4D(Egocentric 4D Perception)计划。其中包含超过3025小时的第一人称视频,包括来自73个城市的700多名参与者的日常生活。

「Ego4D」计划

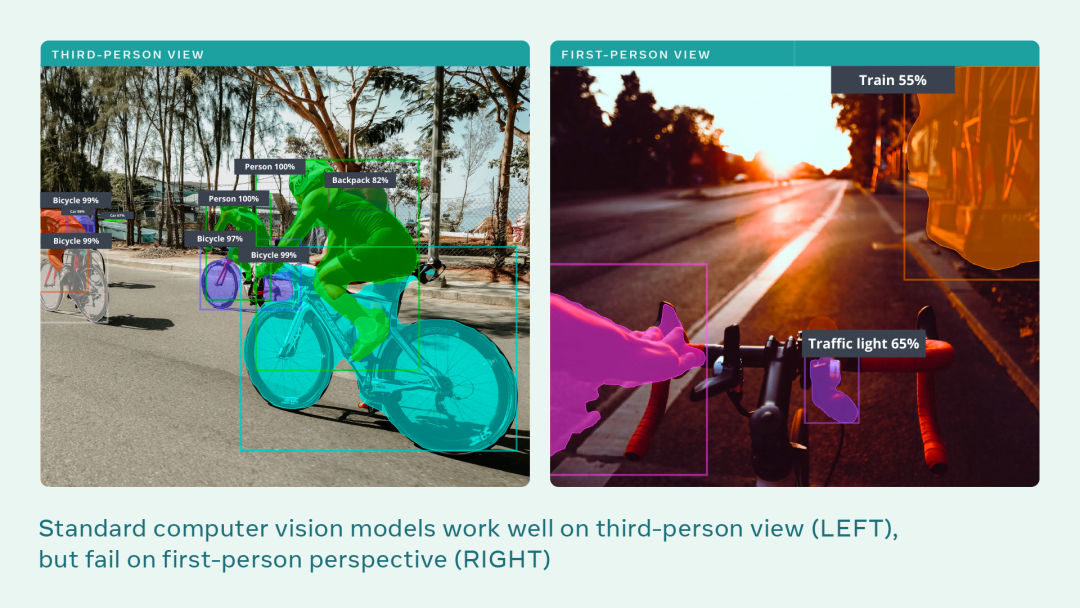

2021年,Facebook AI正在宣布开展「Ego4D」(Egocentric 4D Perception)计划, 这是一个雄心勃勃的长期项目,为的就是解决以第一人称视觉为中心的感知领域的研究挑战。

让AI也体验「第一人称视角」

哎,你看到我的手机了吗?我又找不着我的手机了!

坏了,接下来我要做什么来着?

我在做什么,该怎么做?

刚刚他说了什么,他什么时候说的?

我正在与谁互动,如何互动?

一个又大又干净的数据集

下一步是什么?

参考资料:

登录查看更多

相关内容

Arxiv

0+阅读 · 2022年4月20日

Arxiv

0+阅读 · 2022年4月19日