https://news.nus.edu.sg/nus-facebook-world-class-universities-teach-ai-to-understand-the-world-through-our-eyes/

论文:https://arxiv.org/abs/2110.07058

从第三视角看世界,和从第一视角和世界互动,有显著差异。比如说,看别人坐过山车和自己坐过山车,体验完全不同。

图1. 左:同一场景在第一视角和第三视角下;右:第一视角视频采集设备

为了开启下一波AI技术浪潮,为增强现实 (AR) 和智能机器人赋能,AI需要从现在的第三视角转换成第一视角的全新范式。这是因为在第一视角的世界中,常有实时的运动变化,手与物体的交互,多种感官的信息融合。

为此,Facebook联合新加坡国立大学 (NUS) 、MIT等世界各地的13所大学组成了一个学术联盟,致力于开展一个长期项目——

Ego4D

(第一视角的 4D 实时感知 )。

来自NUS研究团队的Principal Investigator(主要负责人),助理教授Mike寿政说:“在过去十年里,我们见证了AI在理解图像方面的变革,这是建立在 ImageNet 等数据集所奠定的基础上的。类似的,我相信我们的 Ego4D 数据集,将为第一视角的视频研究打好基础,从而推动智能感知在 AR 和机器人方面的快速发展。”

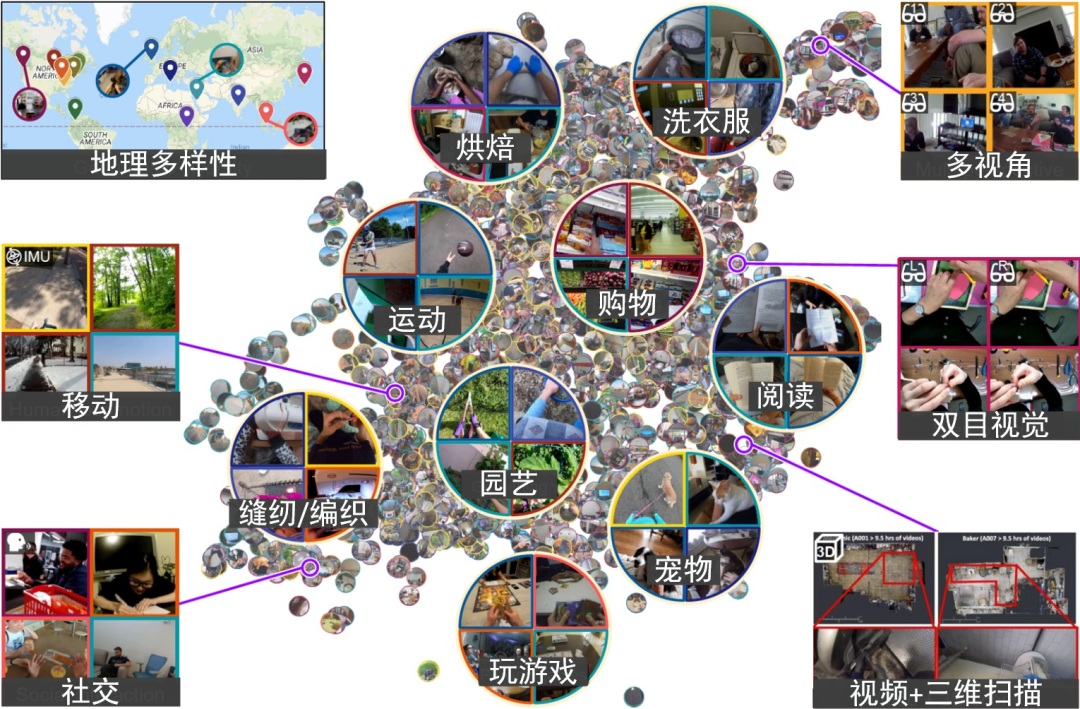

图 2. Ego4D 是目前最大的第一视角的日常活动视频数据集

大多数AI系统需要大量数据进行训练,现有的大规模视频数据集通常以第三视角为主;而现有的第一视角数据集在规模、多样性和复杂性上都很有限。因此,该学术联盟推出了 Ego4D 数据集:

● 大规模:研究人员分发头戴式相机或者AR眼镜给数据采集者,从而收集了累计3,000 小时的、日常活动中的第一视角视频;

● In-the-wild:包含了人们的日常生活的数百种不同活动,记录了相机佩戴者在关注什么,用手和面前的物体做什么,以及他们是如何与其他人互动的;

● 多样性:涵盖全球 73 个地点、9个国家,700 多名不同背景、种族、职业、年龄的数据采集者,囊括不同的文化和地理差异;

● 抽好的特征:所有视频,均有预先抽好的SlowFast特征,方便大家进行实验;

● 授权公

开:这些数据将于 2021 年 11 月公开,视频中的所有可见人脸和可听懂的语音均已获得参与者的授权。

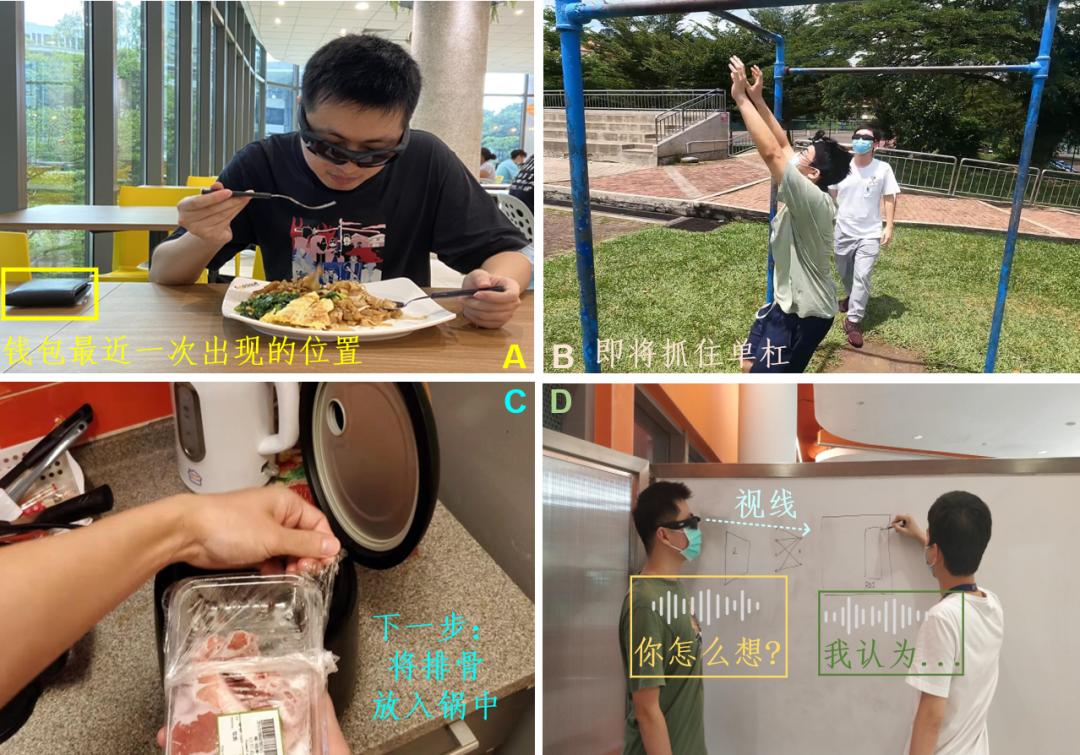

图3. 通过采集的第一视角视频数据,Ego4D团队可以开发AI模型来解决新的任务

与数据收集同样重要的是,定义正确的任务,进行严格的人工标注,来引导新技术的研发。

为此,Ego4D 学术联盟联合构建了五个全新的、具有挑战性的任务:

(1) 情景记忆:什么时候发生了什么?如图3A, 告诉我钱包最近一次出现的位置。

(2) 预测未来:我接下来要做什么?如图3B, 他即将跳起来抓住单杠。

(3) 手与物体交互:我在做什么以及如何做?如图3C, 告诉我下一步的操作。

(4) 视觉+听觉:多人场景下,谁在什么时候说了什么?如图3D, 生成会议内容的总结。

(5) 社交交互:人与人如何交互?如图3D, 我注视着他,而他正在对我说话。

“我们NUS研究团队主要为其中两个关键任务开发模型:

一是,利用声音和视觉线索帮助AI识别“谁在什么时候说了什么”;

二是,开发具有社交智能的 AI,检测当下谁在对谁说话,谁在关注谁,”同样来自NUS团队的Co-PI李海洲教授如是说。

有第一视角感知能力的AI,将赋能AR眼镜、智能机器人等等同样是第一视角的设备,将在我们的日常生活和工作中发挥更大作用。想象一下:在对着新菜谱做菜时,不必再来来回回地看菜谱,你的AR 眼镜就可以实时地同步指导你执行每个步骤;对于有阿尔茨海默症等健康问题的人,AR眼镜可以帮助他们回忆钱包放在哪里了。

Ego4D数据集只是起点,研发第一视角AI技术,进而赋能智能机器人、AR眼镜,将在不远的将来,改变我们的生活、工作、娱乐方式,带给我们前所未有的、虚拟与现实交融的体验。

公众号后台回复“CVPR21检测”获取CVPR2021目标检测论文下载~

备注:姓名-学校/公司-研究方向-城市(如:小极-北大-目标检测-深圳)

即可申请加入极市目标检测/图像分割/工业检测/人脸/医学影像/3D/SLAM/自动驾驶/超分辨率/姿态估计/ReID/GAN/图像增强/OCR/视频理解等技术交流群

每月大咖直播分享、真实项目需求对接、求职内推、算法竞赛、干货资讯汇总、与 10000+来自港科大、北大、清华、中科院、CMU、腾讯、百度等名校名企视觉开发者互动交流~

觉得有用麻烦给个在看啦~

![]()