AI在斯坦福阅读测试中胜过人类,但TA真的看懂了吗

自公众号千读(ID:QianduSV)

2018年伊始,人工智能又迎来一个里程碑。1月3日和5日,微软和阿里巴巴开发的人工智能在斯坦福阅读理解测试中并列第一,在答案的精确匹配度上比人类高出几个基点。

AI已经在国际象棋和围棋上打败我们,并且合写了一张欧洲流行乐(Europop)专辑。现在,电脑又进军一个非常人性的领域:阅读理解测试,这是世界各地学生的苦难源头。

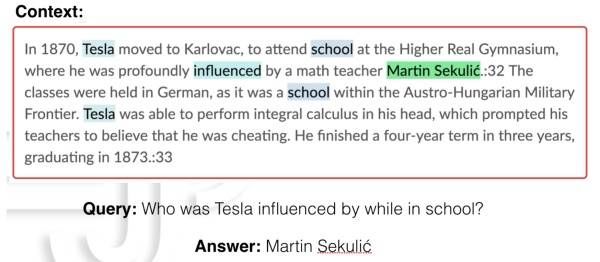

阿里巴巴周一宣布,其人工智能在一项全球阅读理解测试中表现优于人类。该项测试提出的艰深问题包括:「尼古拉•特斯拉(Nikola Tesla)是什么种族的人」,以及「亚马逊雨林有多大?」

尽管微软和阿里巴巴的AI以微小优势胜出,在回答的精确匹配度上仅比人类的82.3%高出几个基点,但它们并列首位,这是美国和中国正在进行的人工智能军备竞赛很好的象征。

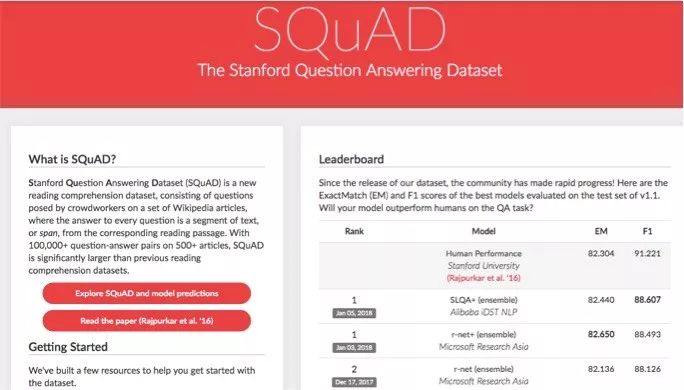

在上周进行的测试中,参赛公司让各自的人工智能系统解答斯坦福问答数据集(Stanford Question Answering Dataset)的提问,该数据集评估阅读理解能力。计算机的答案被与普通人的答覆进行比较,然后据此排名。

由斯坦福大学发起的 SQuAD(Stanford Question Answering Dataset)挑战赛,被认为是目前全球最高水平的AI阅读理解赛事。

SQuAD官网显示,阿里巴巴 iDST NLP 团队提交的 SLQA +模型,1月5日在精确匹配(Exact Match)项目上获得了82.440的分数,刷新了微软亚洲研究院R-NET模型刚刚于1月3日创造的纪录。而这两个模型的成绩都超过了人类在该项目上的得分——82.304。

SQuAD阅读理解赛事是以超过500篇维基百科文章为基础,包含了超过10万个问题-答案组合,是目前世界最大的AI阅读理解数据集。

而且跟CNN/DM,CBT等自然语言处理类数据集相比,过往的数据集往往只是“完形填空”的形式,即要求AI将一个词语填写到文章空白处。而SQuAD则是真正的阅读理解,需要AI先读完一段文章,然后回答一个根据文章提出的问题。

据微软方面介绍,得益于SQuAD所提供的庞大数据规模,参与该项挑战赛的选手不断地对成绩进行刷新,SQuAD挑战赛也逐步成为行业内公认的机器阅读理解标准水平测试。

在今年的ACL大会(自然语言处理领域最顶尖的会议之一)的投稿里,有非常多的论文就是关于这项挑战赛的研究,其影响力可见一斑。从ACL 2017论文主题的可视分析中可以看到,“reading comprehension(阅读理解)”是今年ACL录取论文中最热门的关键词和任务,广受自然语言处理领域研究人员的关注。

微软亚洲研究院机器阅读团队成员(从左至右:崔磊、韦福如、周明、杨南)

SQuAD评分分为精确匹配(Exact Match)和模糊匹配(F1-score)两种,人类在这两项的得分分别是 82.3 和 91.2。上述两个模型目前只是在精确匹配项目上超过人类,而在模糊匹配上仍有大约2.5分的差距。

阿里已将技术用于客服

司罗是阿里巴巴数据科学研究院(iDST)的自然语言处理首席科学家,他把机器取得的这个胜利称为一个里程碑,称该技术有很多用途,从客户服务、博物馆讲解,到医疗查询,其中有一些在全球范围已经由聊天机器人处理。

实事上,这项技术已经在阿里巴巴内部被广泛使用。比如,每年双11都会有大量的顾客对活动规则进行咨询。阿里小蜜团队通过使用司罗团队的技术,让机器直接对规则进行阅读,为用户提供规则解读服务,是最自然的交互方式。

再比如,顾客还会针对单个商品询问大量的基础问题,而这些问题其实在商品详情页都是有答案的。现在通过机器阅读理解技术,能够让机器对详情页中的商品描述文本进行更为智能地阅读和回答,降低服务成本的同时提高购买转化率。

由司罗领导的自然语言处理团队支撑了阿里巴巴整个生态的技术需求。由他们研发的AliNLP自然语言技术平台每日调用1200亿+次,Alitranx 翻译系统提供20个语种在线服务日调用量超过7亿+次。

此前曾在2016年ACM CIKM 个性化电商搜索、2017年IJCNLP中文语法检测CGED评测、2017年年美国标准计量局TAC评比英文实体分类等大赛中取得全球第一的成绩。

中国多个团队排名前列

尽管阿里和微软是目前仅有的两个超过人类得分的团队,但是在自然语言处理领域,其实各方研究者的实力相当接近,竞争一直很激烈。

从SQuAD官网发布的榜单来看,去年11月和12月,得分纪录已经多次被刷新,其中来自中国和美国的团队占据了最前列的位置,包括腾讯、哈工大&科大讯飞等中国团队都取得了不错的成绩,一些欧洲、韩国和以色列的研究者同样榜上有名。

微软亚洲研究院副院长、自然语言计算组负责人周明博士表示:“祝贺中国的自然语言理解研究已经走在世界前列!整个领域的进步需要大家共同的努力和投入来推动。自然语言处理长路漫漫,让我们共勉。”

AI在斯坦福阅读测试中胜过人类,但TA真的看懂了吗?

AI阅读技术依赖于精读文本,比如维基百科(Wikipedia)的文章,以学习和模仿信息。类似的技术已被用于买家提出的常见问题(比如「我的包裹在哪里?」)。在阿里巴巴的光棍日购物节期间,这类问题会大量涌入。

但这并不表明AI真正像人类一样读懂了文章的内容。就像AI可以找到美国超级碗SuperBowl比赛中场的乐队是哪一家,但它并不知道英国摇滚乐队Coldplay究竟是什么。

AI要真正看懂人类看的书,目前还很有挑战,让我们看看TA的阅读理解能力,未来进步会多快。

- 本文来自MIT Tech Review, 观察者