南邮提出实时语义分割的轻量级网络:LEDNET,可达 71 FPS!70.6% class mIoU!即将开源

点击上方“CVer”,选择加"星标"或“置顶”

重磅干货,第一时间送达

前戏

之前 CVer 推了几篇关于语义分割的论文,大多在于提高 mIoU,但追求实时性的比较少。本文要介绍的 LEDNet(Light Encoder-Decoder Network)是由南京邮电大学和天普大学联合提出的用于实时语义分割的轻量级网络。

LEDNet 能够在单个GTX 1080Ti GPU中以超过71 FPS的速度运行。实验表明,该算法在 CityScapes 数据集的速度和准确性权衡方面取得了SOTA。

目前 LEDNet 论文已被 ICIP 2019 录用,官方已经提供该算法的 github 链接,但并没有上传测试/训练源码,估计还在准备中。

LEDNet

《LEDNet: A Lightweight Encoder-Decoder Network for Real-Time Semantic Segmentation》

arXiv: https://arxiv.org/abs/1905.02423

github: https://github.com/xiaoyufenfei/LEDNet

作者团队:南京邮电大学和天普大学

注:2019年05月08日刚出炉的paper

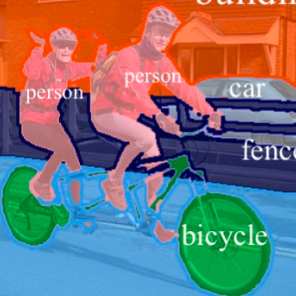

Abstract:算力负担限制了移动设备中CNN在密集估计任务中的使用。在本文中,我们提出了一个轻量级网络来解决这个问题,即 LEDNet,它采用非对称(asymmetric)编码器 - 解码器架构来进行实时语义分割。更具体地说,编码器采用 ResNet 作为骨干网络,其中有两个新操作:channel split and shuffle,被应用在每个残余块中,以大大降低计算成本,同时保持更高的分割精度。 另一方面,在解码器中采用注意力金字塔网络(APN,attention pyramid network)以进一步减轻整个网络的复杂性。我们的模型参数不到1M,并且能够在单个GTX 1080Ti GPU中以超过71 FPS的速度运行。全面的实验表明,我们的方法在 CityScapes 数据集的速度和准确性权衡方面取得了SOTA。

本文算法(LEDNet)流程图:不对称结构

本文三个创新点:

(1)LEDNet的不对称结构(asymmetrical architecture),如上图所示,使得网络参数大大减少,加速了推理过程;

(2)残差网络中的 Channel split and shuffle 有强大的特征表示。此外, Channel shuffle 是differentiable,可以嵌入网络结构中进行端到端训练。

(3)在 decoder 端,采用特征金字塔的注意力机制来设计APN,进一步降低了整个网络的复杂性。

带有 Split and Shuffle Operations的残差模块

由下图可知,LEDNet引入:split-shuffle-bottleneck(SS-bt),其中可以看到整体结构还是ResNet,但额外引入 Channel Split、Concat层和 Channel Shuffle。

Channle Split 将输入分离成两个 lower-dimensional 分支(即各自一半channel),通过设计的3x1 和 1x3卷积,在将两个分支 Concat一起,并最后利用 ShuffleNet中的 Channel Shuffle操作。

APN Decoder

来直观看看 LEDNet 的参数设计:

实验结果

表 2 和表 3 直观的说明了对比结果,LEDNet 在准确性和效率方面实现了最佳可行的 trade-off,如 LEDNet 达到 70.6% class mIoU 和 87.1% category mIoU,并且 71 FPS,不到 1M参数。(测试GPU:单个GTX 1080ti)

官方已经给出LEDNet的github链接,期待早点将源码放出来~

arXiv: https://arxiv.org/abs/1905.02423

github: https://github.com/xiaoyufenfei/LEDNet

CVer-图像分割交流群

扫码添加CVer助手,可申请加入CVer-图像分割交流群。一定要备注:图像分割+地点+学校/公司+昵称(如图像分割+上海+上交+卡卡)

▲长按加群

这么硬的论文分享,麻烦给我一个在在看

▲长按关注我们

麻烦给我一个在看!