【深度】DeepMind 最新研究:通过删除神经元理解深度学习

来源:新智元

【导读】深度神经网络由许多个体神经元组成,具有很高的复杂性。这种复杂性使其难懂,被认为是看不透的黑匣子。DeepMind最新发表针对对单一方向泛化的重要性的研究,采用来自实验神经科学的启发的方法,即通过探索删除神经元带来的影响确定深度神经网络中神经元小组的重要性。

理解深度神经网络的运作机制对于帮助我们解释它们的决定,以及构建更强大的系统起到了至关重要的作用。例如,试想在不了解个体齿轮如何啮合的情况下去构建时钟会有多么的困难。在神经科学和深度学习中,理解神经网络的一种方法是调查个体神经元所扮演的“角色”,尤其是那些易于解释的神经元。

我们对单一方向泛化的重要性的研究(On the importance of single directions for generalization)即将在第六届国际学习表征会议 (ICLR)上问世,该研究采用的方法受到数十年实验神经科学的启发– 通过探索删除神经元带来的影响 – 来确定深度神经网络中神经元小组的重要性,以及相对容易解释的神经元是否对神经网络的计算更为重要?

我们通过删除单个神经元以及神经元小组对其所在的网络性能的损害来研究它们的影响力。我们的实验带来了两个令人惊讶的发现:

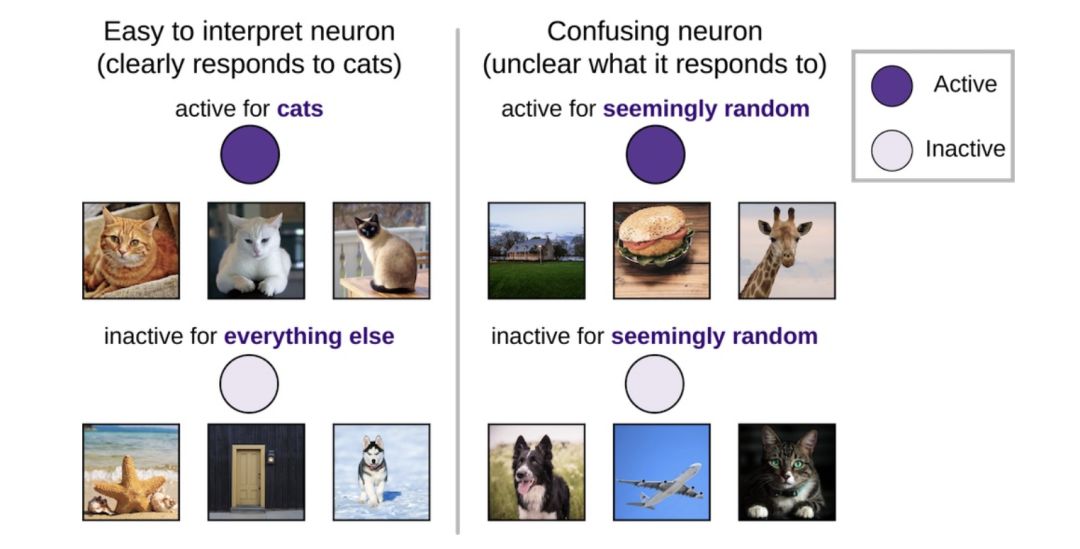

虽然以前的许多研究都集中于解读易解释的单个神经元(例如,“猫神经元”,或深层网络隐藏层中只对猫的图像有反应的神经元),但是我们发现这些可解释的神经元相对于难懂的,难以解释其活动的神经元来说并没有更加重要。

能够对未知图像进行正确分类的网络比只能对已知图像进行正确分类的神经网络更能适应神经元的删除。换句话说,泛性好的网络比那些记忆网络更少依赖单一方向的输入。

在神经科学和深度学习中,对单个输入类别的图像(例如狗)作出响应的易于解释的神经元(“选择性”神经元)已经得到了广泛的研究。在深度学习中,这导致了对猫神经元,情绪神经元和括号神经元的强调;在神经科学,有詹妮弗安妮斯顿神经元研究,等等。然而,这些少数高选择性神经元相对于大多数具有低选择性、更难懂,难以解释其活动的神经元的重要性仍然未知。

具有明显响应模式(例如,对猫活跃,对其他所有活动不活跃)的神经元比看到随机图像活跃和不活跃的神经元更容易解释。

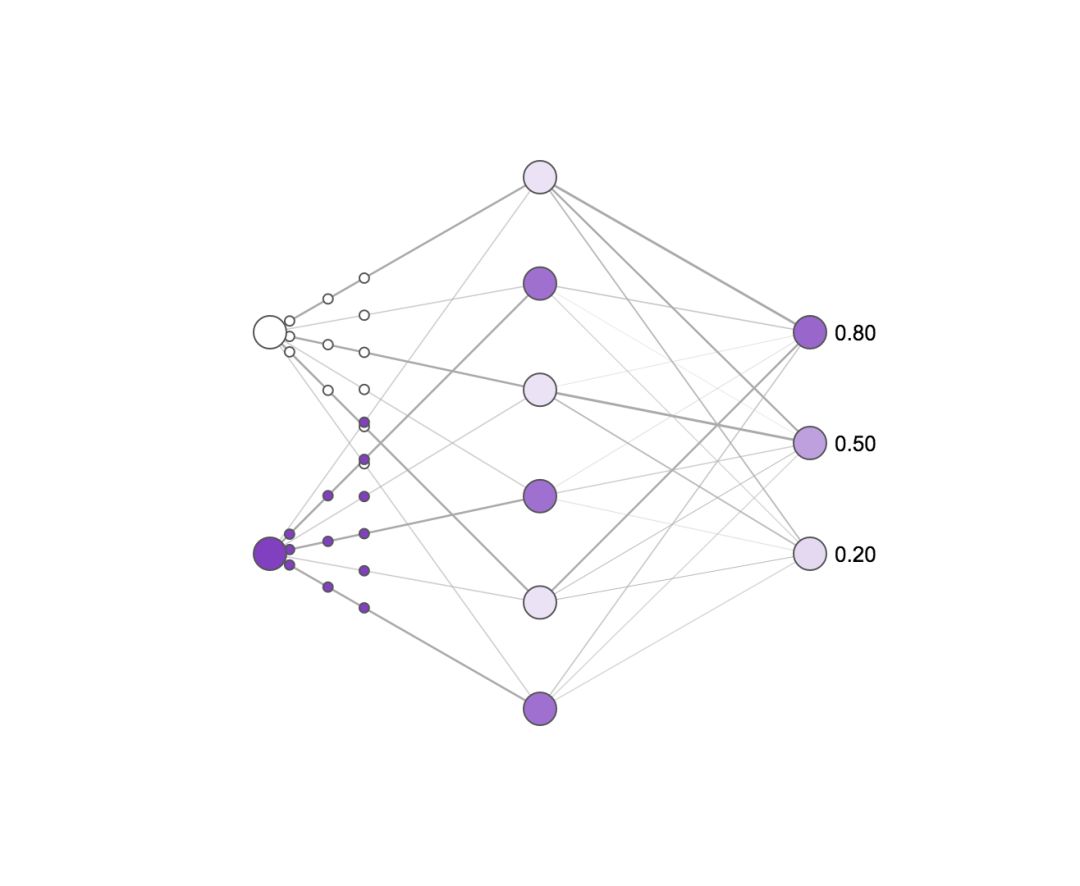

为了评估(某个)神经元的重要性,我们测量了当该神经元被删除时,神经网络在图像分类任务上的表现变化。如果一个神经元是非常重要的,删除它应会对神经网络产生高度的破坏性,大大降低该网络的性能;相反地,删除一个不重要的神经元则应该无法对神经网络构成很大影响。神经科学家经常进行类似的实验,然而他们很难达到这些实验所需的精度,而这精度在人工神经网络中恰恰容易获得。

删除神经元对简单神经网络影响的直观图示。颜色较深的神经元更加活跃。尝试点击隐藏层中的神经元并删除它们,观察输出神经元的活动会如何改变。请注意,删除一个或两个神经元对输出影响很小,而删除大部分神经元则会对输出影响很大,并且一些神经元比其他神经元更重要!

令人惊讶的是,我们发现选择性强的神经元和重要性之间几乎没有关系。换句话说,“猫神经元”并不比难懂神经元更加重要。这一发现与最近在神经科学方面的工作相互呼应,即难懂神经元实际上可以提供很多信息。我们需将视野拓展到最易于解释的神经元以外来了解深度神经网络。

“猫神经元”可能更易解释,但它们并不比难懂的没有明显偏好的神经元更重要。尝试点击上图的二维线画图函数,看看重要性和易解释性之间的关系!

尽管可解释的神经元在直觉上更容易理解(“它喜欢狗”),但它们并不比难懂的,没有明显偏好的神经元更重要。

越泛化的神经网络,越难被打破

对于我们正在努力构建的智能系统来说,只有当这种系统能够推广到对新的情况进行解读时,我们才能称之为智能系统。例如,一个图像分类网络如果只能对以前看过的特定狗的图像进行分类,而不能对同一只狗的新的图像进行分类的话,那么它是无用的。只有当它可以对新的例子进行智能分类时,这个系统才能展现了它的效用。 一篇由Google Brain,Berkeley大学和DeepMind最近在ICLR 2017上获得最佳论文的合作论文表明,深度网络可以简单地记住它们接受过培训的每个图像,然而却不能以类人类的方式对图像进行学习(例如,了解抽象的“狗”概念)。

通常我们不知道网络是否已经学会了一种能够推广到新情况的解决方案。通过逐渐删除越来越大的神经元组,我们发现,相比起对以前训练期间看到的图像进行简单记忆的网络,泛化良好的网络在应对删除时表现出的稳健性要强得多。换句话说,泛化好的网络很难被打破(尽管它们肯定还是会被打破的)。

随着越来越多的神经元组被删除,泛化的网络性能的下降速度远远低于记忆网络的性能。

通过以这种衡量网络的稳健性的方式,我们可以评估一个网络是否在利用记忆来进行“欺骗”。了解网络在进行记忆时的变化将有助于我们建立新的网络,这种网络记忆较少,泛化较强。

受到神经科学启发的分析

总之,这些发现证明了使用受实验神经科学启发的技术对理解神经网络的重要作用。通过这些方法,我们发现选择性强的个体神经元并不一定比不具选择性的神经元更加重要,并且,单个神经元对泛化的网络的影响比其对单纯依靠记忆数据训练出来的网络更小。这些结果意味着单个神经元的重要性可能比你乍看上去的要低。

试图了解所有神经元,而不仅仅是那些易于理解的神经元的作用可以帮助我们更好地理解神经网络的内部工作,更加重要的是,我们可以利用这种理解来构建更加智能和应用广泛的系统。

这项工作由Ari S Morcos,DavidGT Barrett,Neil C Rabinowitz和MatthewBotvinick合作完成。

可视化图像由Paul Lewis,AdamCain和Doug Fritz创建。

原文链接:https://deepmind.com/blog/understanding-deep-learning-through-neuron-deletion/

☞【学界】OpenPV:中科院研究人员建立开源的平行视觉研究平台

☞【征稿通知】IEEE IV 2018“智能车辆中的平行视觉”研讨会

☞【学界】ParallelEye:面向交通视觉研究构建的大规模虚拟图像集

☞【CFP】Virtual Images for Visual Artificial Intelligence

☞【最详尽的GAN介绍】王飞跃等:生成式对抗网络 GAN 的研究进展与展望

☞【智能自动化学科前沿讲习班第1期】王飞跃教授:生成式对抗网络GAN的研究进展与展望

☞【智能自动化学科前沿讲习班第1期】王坤峰副研究员:GAN与平行视觉

☞【重磅】平行将成为一种常态:从SimGAN获得CVPR 2017最佳论文奖说起

☞【动态】何恺明团队最新力作:群组归一化(Group Normalization)

☞【深度】AI版“双手互搏”有多牛?对抗性神经网络凭啥入选MIT2018十大突破性技术?

☞【征稿】神经计算专刊Virtual Images for Visual Artificial Intelligence