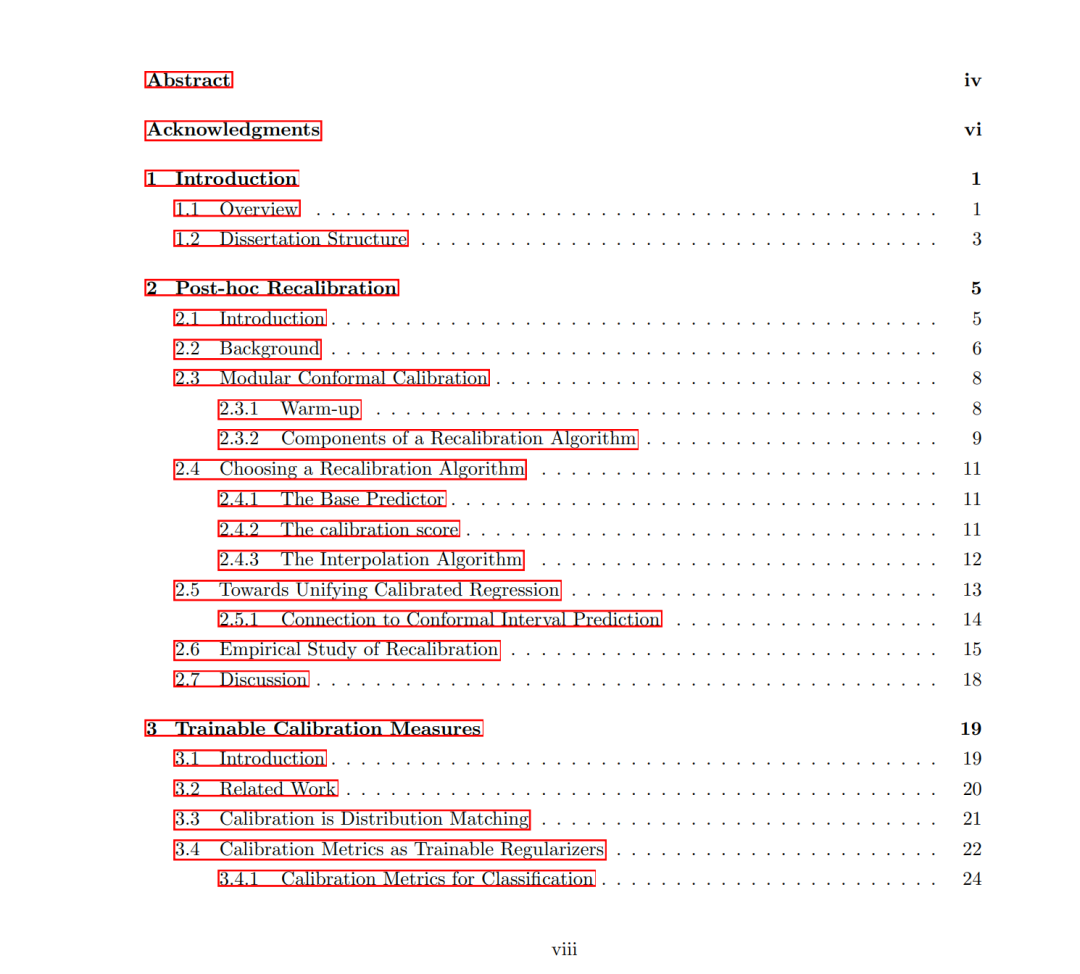

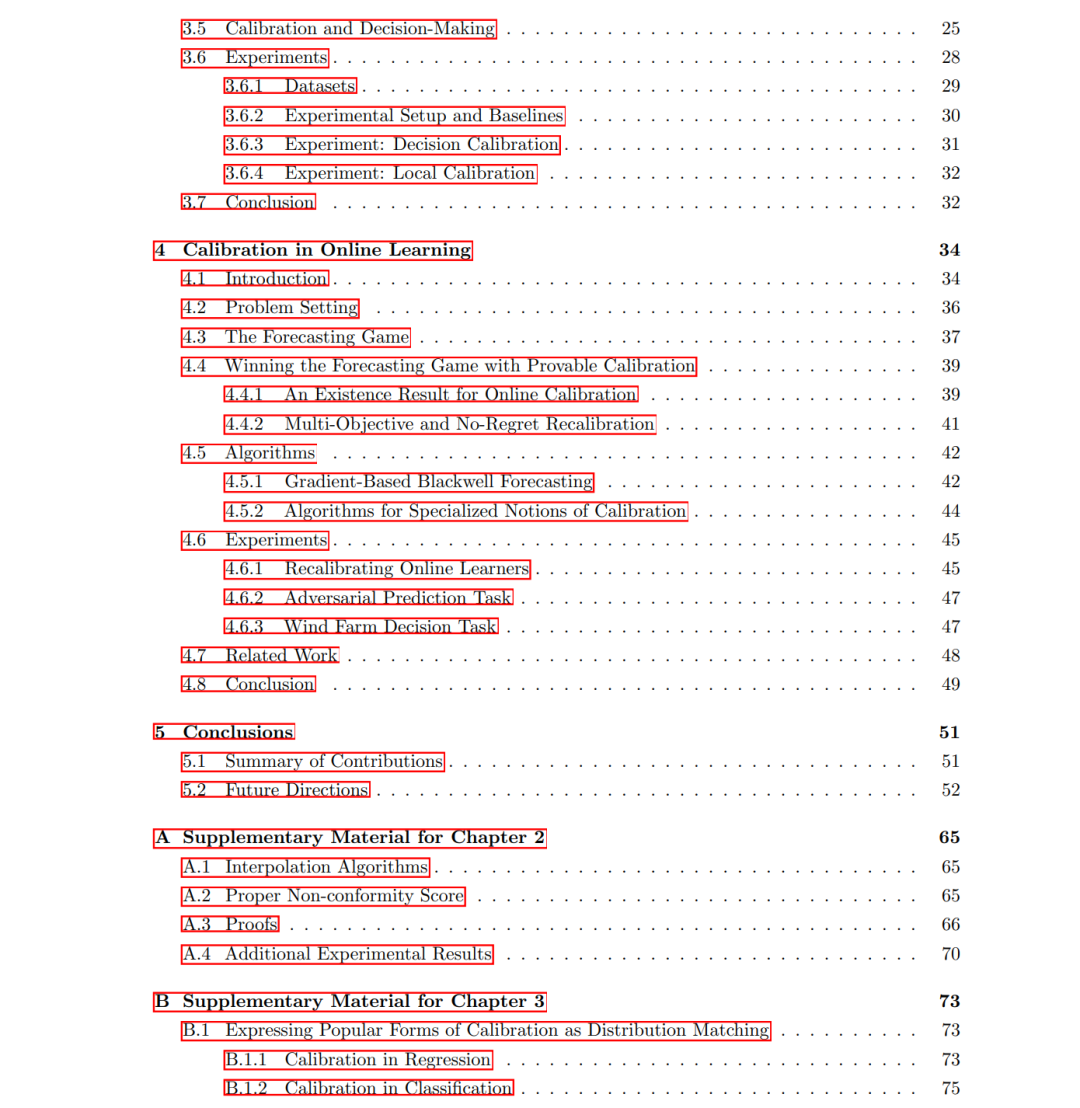

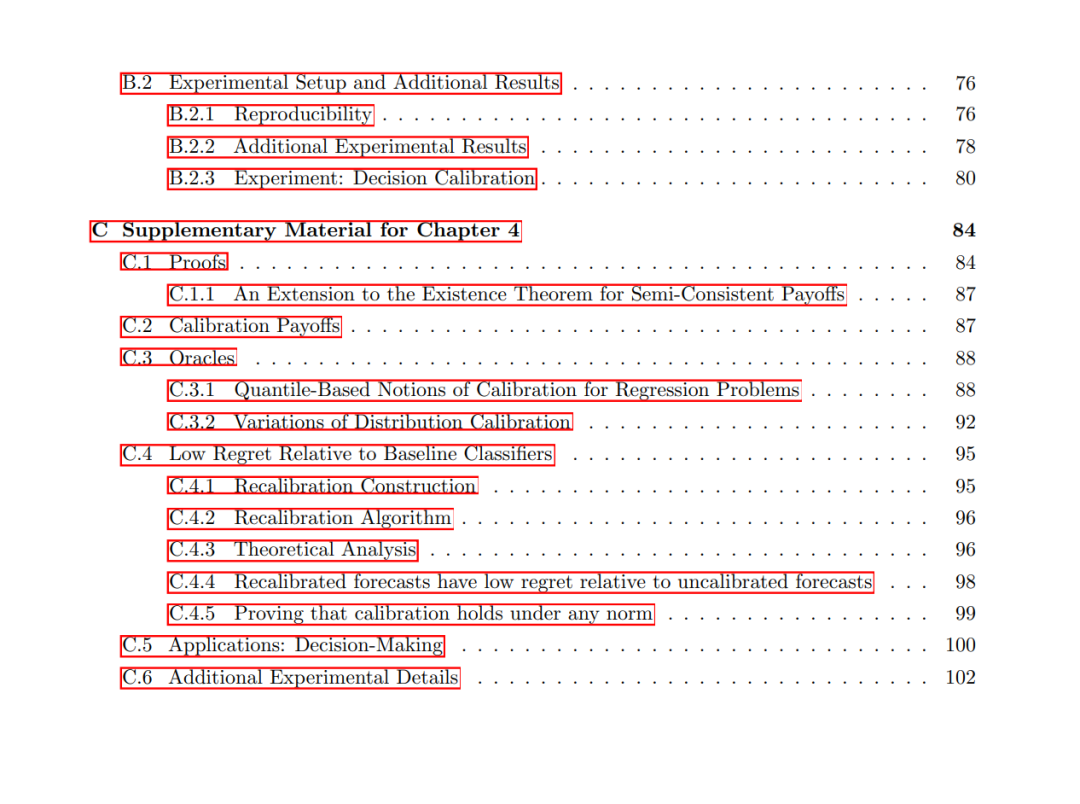

在高风险环境中部署机器学习系统时,预测结果将直接影响从医学诊断到基础设施管理以及科学发现等关键决策,因此,对不确定性的可靠量化至关重要。本文围绕概率预测开展研究,重点在于通过实现校准(calibration)来提升不确定性估计的可信度——即预测概率应与事件的经验频率保持一致,例如:置信度为90%的区间应有90%的概率覆盖实际观测结果。 我提出了贯穿整个模型生命周期的多种干预方法,用于提升模型的校准性能:包括在训练阶段设计优化目标以鼓励校准、在后处理阶段修正误校准的方法,以及在部署阶段于非平稳环境中自适应保持校准的在线技术。 论文第一部分聚焦于后验重校准(post-hoc recalibration)。我提出了模块化保序校准(modular conformal calibration)这一通用框架,它涵盖并扩展了现有的后验不确定性量化方法,如保序回归(isotonic regression)和保序预测(conformal prediction)。该框架明确了重校准策略的设计空间,并为使用这些策略重校准后的任意模型提供有限样本下的校准保证。这一框架使实践者能够在计算开销、概率解释性、确定性行为与校准强度之间进行权衡。 第二部分关注训练阶段的校准策略,目标是在保持预测“锐度”(即预测结果的自信度与信息量)的同时增强模型的校准性。我提出了一类可微分的校准度量,可作为正则化目标嵌入到训练过程中,使校准性与锐度得以联合优化。这些目标函数覆盖了许多用于回归与分类任务的主流校准指标,这些指标此前往往仅在训练后进行施加。该方法还支持任务定制的校准目标,使得模型的不确定性估计在统计上保持一致性,并能够契合下游决策场景的实际需求。 第三部分探讨了分布漂移(distribution shift)下的校准问题,这是现实部署中的核心挑战之一。我研究了一个在线预测设置,其中数据可能随时间演化或由对手策略生成。基于Blackwell可达性理论(Blackwell approachability theory),我提出了一种通用策略,可在最小假设下针对任意观测序列实现校准保证。该框架支持多种校准概念,包括分布校准与决策校准,并提供基于oracle的方法与可计算的算法。我进一步提出了基于梯度的松弛算法,在扩大适用范围的同时,部分放宽了理论保证。实验证明,这些方法在保持校准预测的同时,对比专家预测器可获得渐进无悔(vanishing regret)。 总的来说,本论文提出了一套系统化的、理论支撑的策略,用以提升概率模型在整个开发流程中的不确定性估计灵活性与可靠性。通过在模型生命周期的各阶段强制实现多种形式的校准,本文为实际应用中高风险决策提供了稳健可信的模型支持。