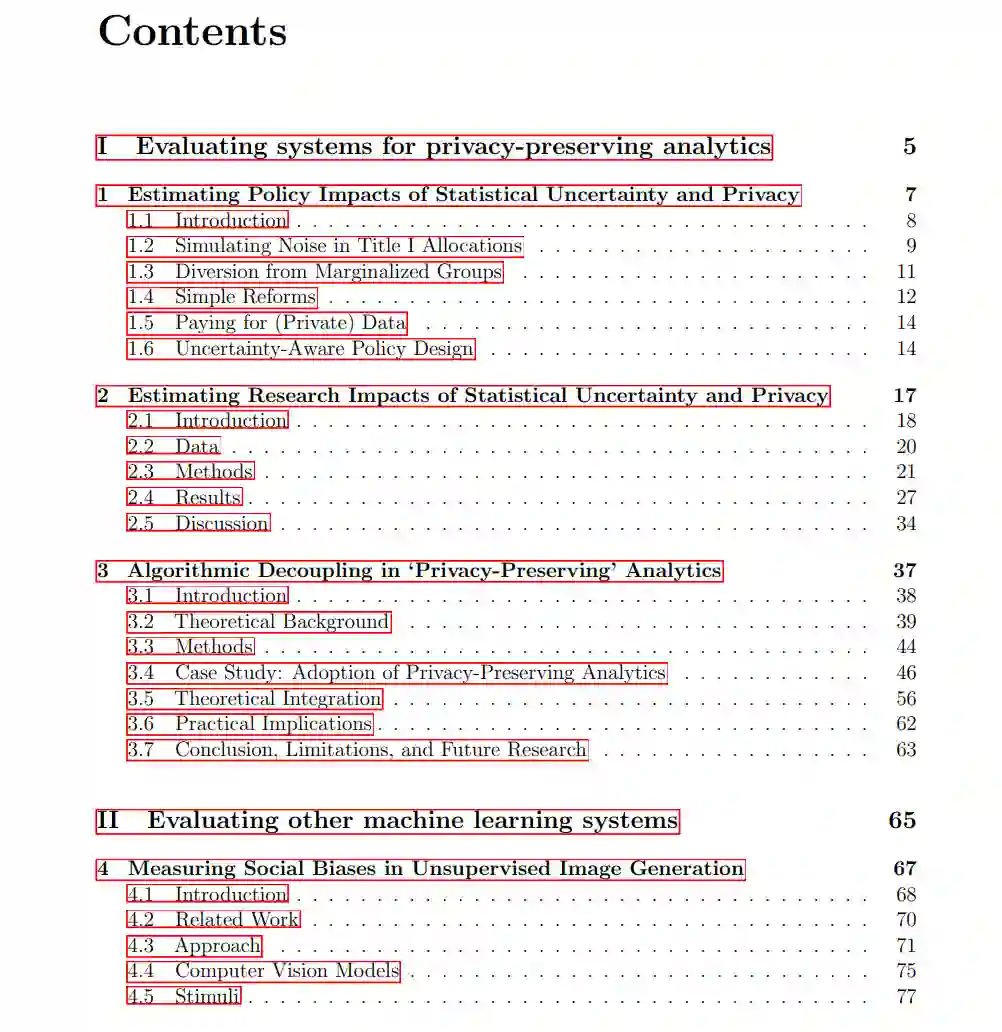

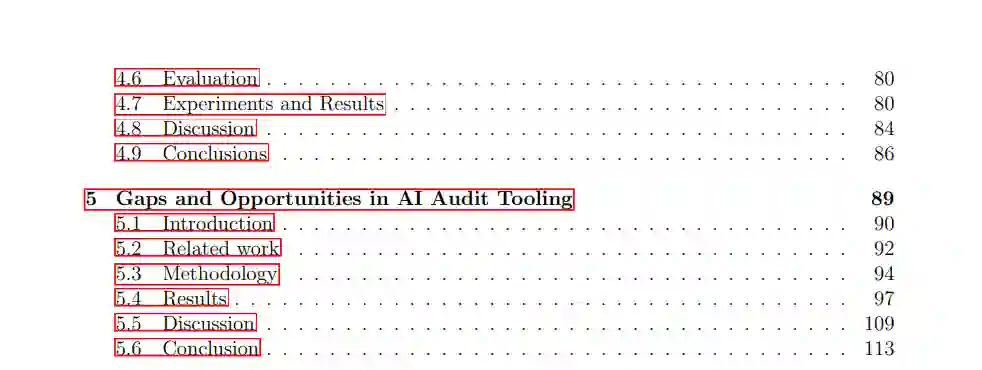

机器学习算法及其他统计技术被广泛应用于利用个人信息进行推断,但为此目的构建的系统可能对隐私和社会公平造成不利影响。近期研究提出了旨在在保护个人隐私的同时完成这些推断的技术。本文综述旨在:1)开发评估机器学习系统及“隐私保护”分析方法社会影响的途径;2)理论化这些评估在追究机器学习系统设计者和运营者责任中的作用。 第一部分聚焦于旨在保护隐私的机器学习及其他分析系统技术的影响。第一章评估了差分隐私公共人口普查统计数据对基于证据的政策的影响,发现尽管统计不确定性导致教育资金分配上的不平等,但为保护隐私而注入的噪声可能远小于现有数据误差的影响(Steed, Liu 等,2022)。第二章量化了噪声对大量社会科学研究关键发现的影响。第三章基于定性访谈,构建了隐私保护分析方法采纳的扎根理论,揭示了采纳组织如何可能将对隐私的认知与其具体实施细节相分离的过程(Steed & Acquisti,2025)。 第二部分探讨了评估机器学习系统社会公平性的途径,以及将评估作为问责机制的应用。第四章提出了一种量化图像嵌入中刻板印象关联的方法,并展示了无监督图像生成模型自动学习到种族、性别及交叉偏见(Steed & Caliskan,2021)。第五章对人工智能(AI)审计工具的数据集进行了分类,并访谈了35位审计从业者,发现从业者在AI问责所需工具——包括危害发现与倡导工具——方面资源较为匮乏(Ojewale 等,2025)。 算法系统,尤其是机器学习(ML)系统,在隐私和社会公平方面引发了严重的社会关注。这些系统被用于金融、刑事司法、医疗保健以及内容审核等重要决策领域;但往往,这些系统无法正常运行(Raji, Kumar 等,2022)。它们基于通过大规模社会经济监控机制收集的海量个人数据,对个体进行统计推断(Zuboff,2019;Cohen,2019;FTC工作人员,2024);这一安排持续加剧了歧视、不平等及其他社会危害(Benjamin,2020;Skinner-Thompson,2020)。面对隐私问题,组织纷纷采用更多算法技术以在执行统计分析的同时保护个人隐私;虽然理论上具有前景,但这些“隐私保护”技术的实际影响尚不确定。 防止和纠正算法系统的不利影响部分依赖于持续且有影响力的实证评估。本文综述旨在:1)开发评估机器学习系统及“隐私保护”分析方法社会影响的途径;2)理论化这些评估在追究机器学习系统设计者和运营者责任中的作用。 本文的研究成果融合了当代技术政策中的两个关键领域:数据隐私和“人工智能”(AI)问责。成熟的信息隐私和数据保护机制——尤其是在欧盟——侧重于通过限制组织处理个人数据的方式来维护个人隐私权。各行各业及政府部门正率先部署差分隐私、联邦学习等方法,以协调依赖统计推断的商业模式与现代隐私法规及消费者对隐私的诉求。但这些技术在理论和实施上均较为复杂,其在隐私和数据保护政策中的角色仍未明朗。第一部分探讨了这些“隐私保护”系统的采用及其影响。 相比之下,专门针对AI系统社会影响的监管尚不成熟。但政策关注度显著提升,尤其是在应对使用机器学习技术生成文本和图像的产品热度时。美国和欧洲最近的政策提案及已实施的立法,特别强调将独立评估算法系统作为问责机制:即根据社会期望对算法系统性能作出重要判断的能力(Birhane 等,2024)。第二部分聚焦于AI审计的实践。