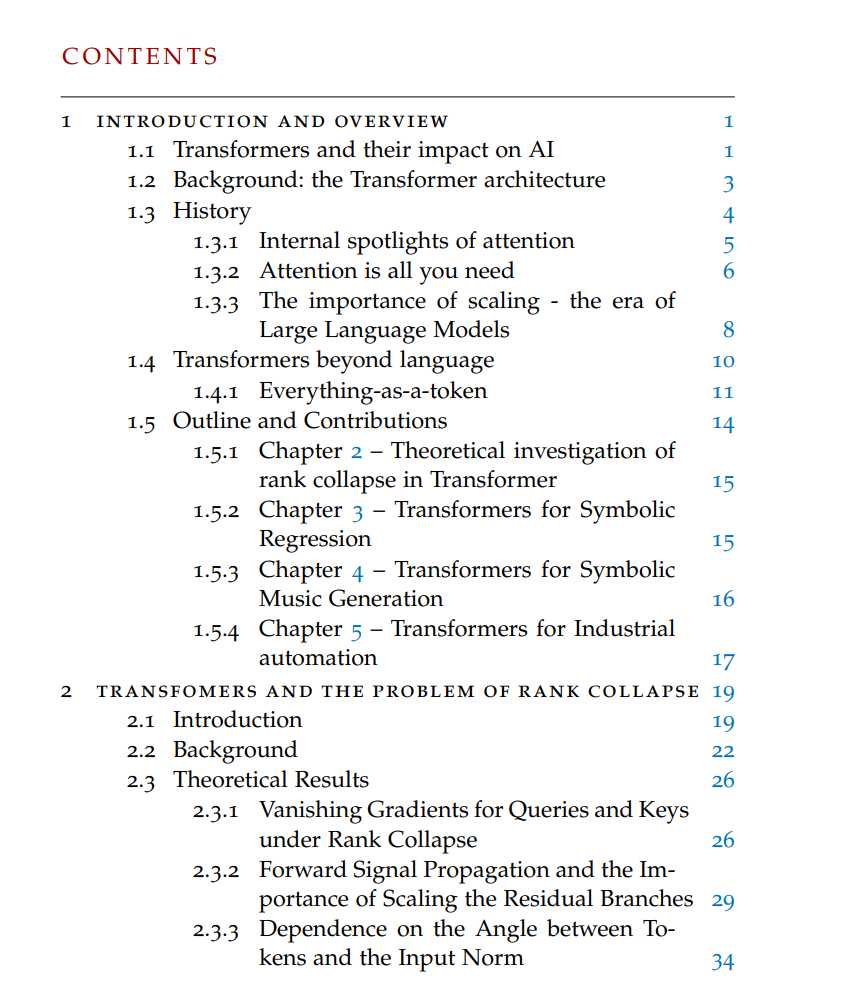

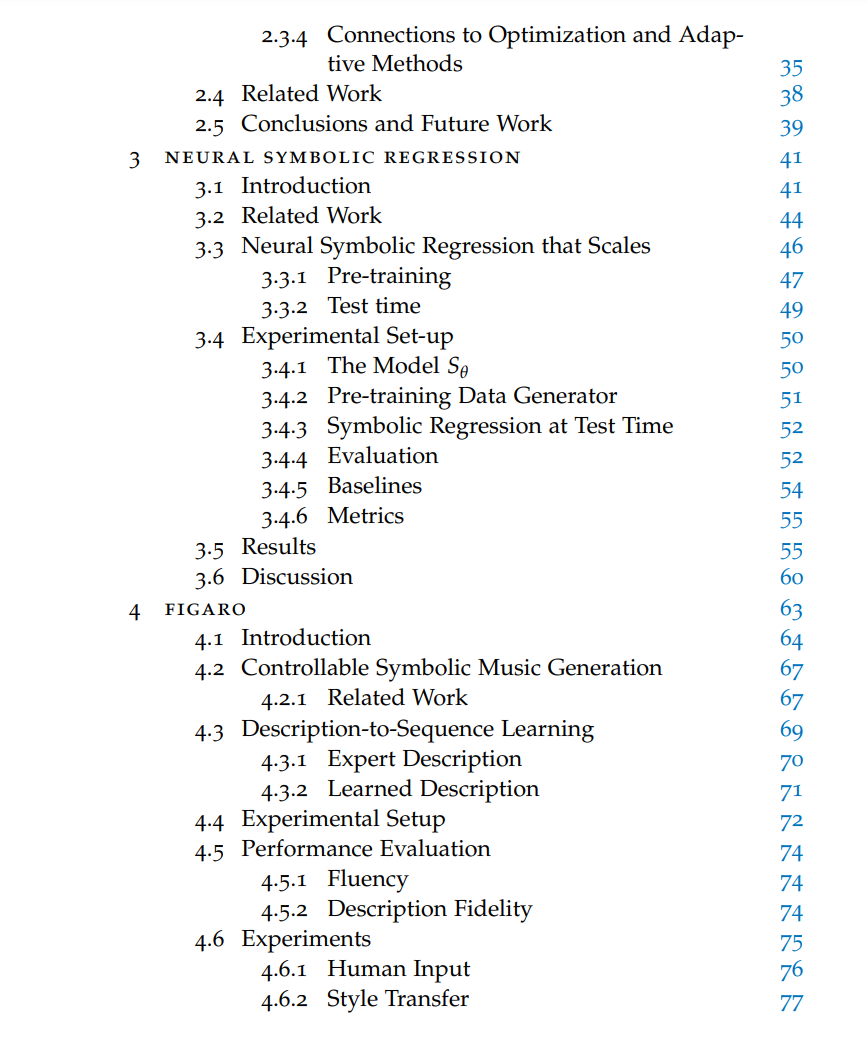

自2017年引入以来,Transformers在深度学习领域产生了深远的影响,对当前人工智能(AI)的发展格局施加了强大的影响,并塑造了未来几年的研究议程。特别值得注意的是,它们在现代大型语言模型(LLMs)中的核心作用,这些模型在各种自然语言处理任务中取得了前所未有的成功,有效地推动了AI能力的边界。就像十年前卷积神经网络(CNNs)的深远影响一样,Transformers在其应用中经历了指数级的增长,超越了它们最初的领域,并在不同领域取得了显著成果。尽管这些模型被广泛使用,但从许多方面来看,它们的内部工作机制仍然是不透明的,包括但不限于它们的优化方式以及它们如何通过隐藏层传递输入数据。本论文的目标是探究这些模型在不同领域中的潜力,并对它们架构的特性和内在偏见进行一些阐释。首先,我们仔细研究Transformers如何以其原始形式通过层级结构处理输入数据。在前期研究的基础上,该研究识别了作为这种模型特定病理的等级崩溃,我们解构了Transformer架构的前向传递,并设计策略以缓解这一不良现象。随后,我们分别探讨了Transformers在科学发现、音乐生成和工业自动化等三个不同领域的应用。我们的结果进一步证明了这种模型的高度灵活性,并展示了其在自然语言处理之外的各个领域的卓越能力。

成为VIP会员查看完整内容

相关内容

Arxiv

223+阅读 · 2023年4月7日

Arxiv

85+阅读 · 2023年3月21日