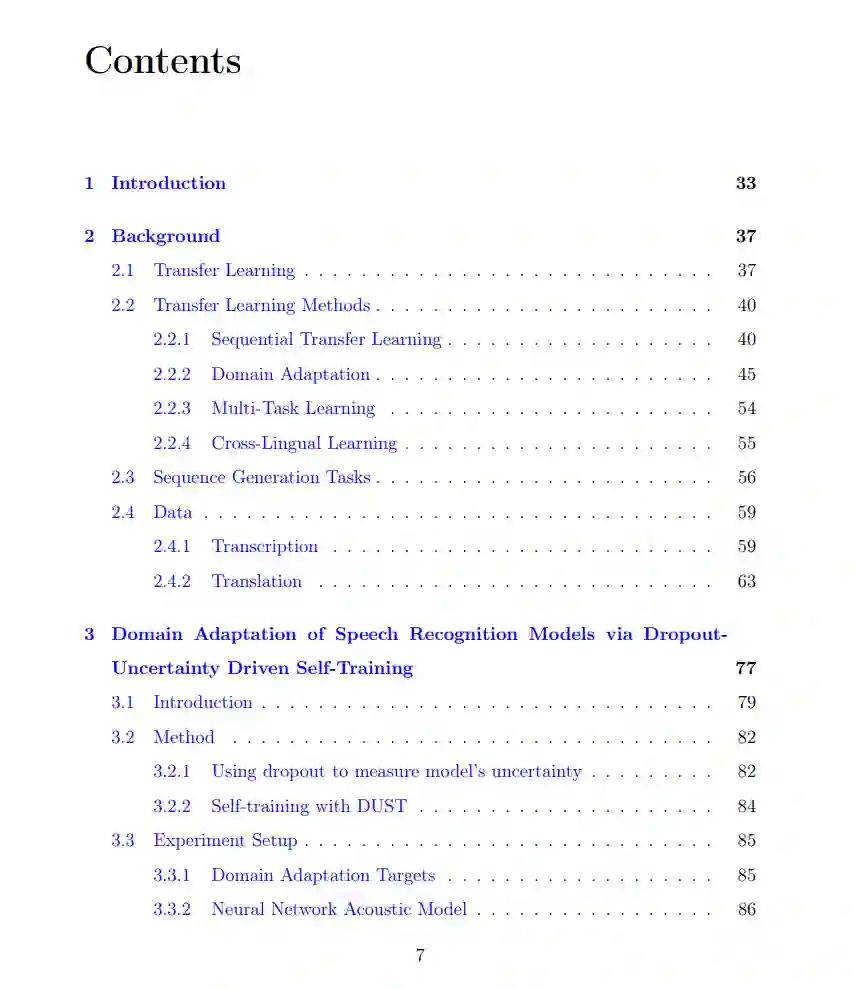

这篇论文开发了用于口语处理应用的迁移学习范式。特别地,我们处理了在自动语音识别(ASR)背景下的领域适应问题,以及在自动语音翻译(AST)中的跨语言学习问题。论文的第一部分开发了一种针对端到端ASR模型的无监督领域适应算法。近年来,由于有了大量的标注语料库和新颖的神经网络架构,ASR的性能得到了显著的提升。但是,当训练数据的分布与模型在部署时遇到的分布(目标领域)不匹配时,ASR的性能会大幅下降。一个简单的解决方法是在目标领域收集标记的数据并重新训练源领域的ASR模型。但是,收集标记的样本往往很昂贵,而未标记的数据则更容易获得。因此,有必要开发无监督领域适应方法。为此,我们开发了一个简单但有效的适应算法,称为Dropout不确定性驱动的自我训练(DUST)。DUST重新利用了经典的自我训练(ST)算法,使其适应领域适应问题。

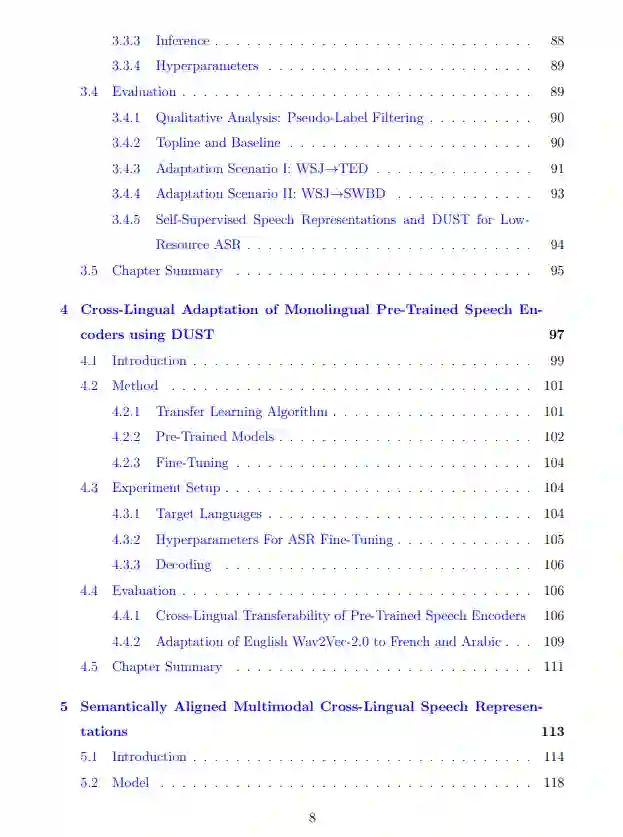

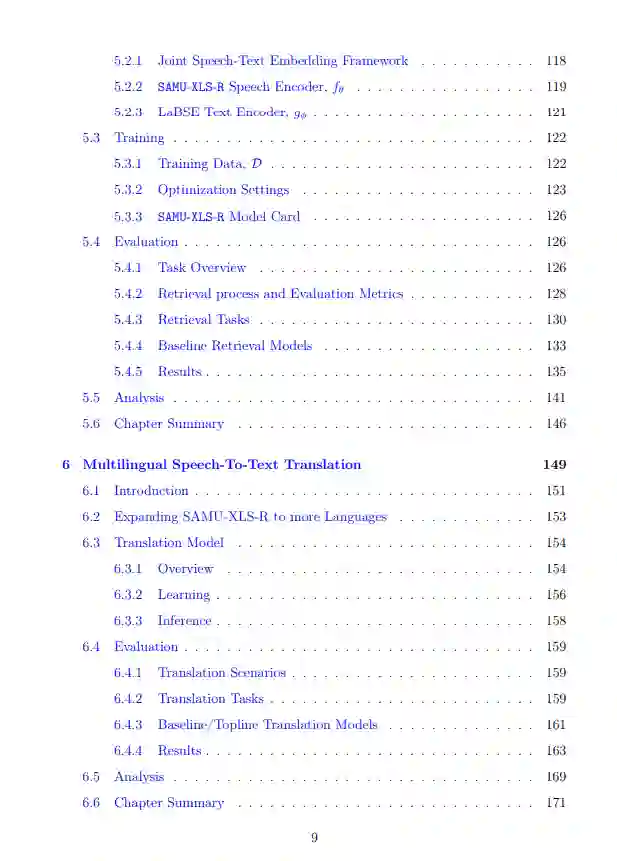

论文的第二部分开发了一个Transformer神经网络编码器,该编码器将多种语言的语音嵌入到一个共享的、语义对齐的联合语音-文本嵌入空间中。为了学习这种多模态语义嵌入空间,我们提出了一个教师/学生学习框架,在这个框架中,我们使用来自预先训练过的多语言语义文本编码器(教师)的语义监督来微调一个预先训练过的多语言语音编码器(学生)。我们展示了,通过使用我们的语音编码器学习到的语义表示构建多语言的语音到文本翻译技术,我们可以从在训练期间看到的高资源口语语言实现显著的零样本跨语言任务转移,转移到在训练期间未看到的低资源口语语言。

这项工作提出了几种方法来解决语音处理应用中的迁移学习问题。迁移学习是指将从解决源领域中的一个任务中获得的知识转移到一个目标领域中的不同但相关的目标任务的问题。多种学习框架可以被视为迁移学习的一个实例。例如,从大量未标记数据中学习以便用有标记的样本进行少样本学习是顺序迁移学习的一个实例,在这种学习中,我们首先使用自监督学习在未标记的数据上预训练一个模型,然后在少量的手工注释的有标签数据上进行微调。上述顺序迁移学习的著名例子包括自然语言处理中的BERT (Devlin等人, 2019)和语音处理中的Wav2vec2.0 (Baevski等人, 2020)(Zoph等人, 2020)。

在实际应用中部署语音处理模型时,经常可以观察到对高效迁移学习的需求。通常,训练数据(源领域)与模型在部署期间遇到的数据分布(目标领域)之间存在不匹配。一个简单的解决办法是在目标领域收集标记的样本以重新训练ASR模型。但是,收集手工注释的数据既耗时又昂贵。相比之下,收集未标记的数据相对便宜。因此,存在对无监督领域适应方法的需求。这篇论文的第一部分(第3-4章)关注端到端自动语音识别模型的无监督领域适应问题。我们关注一个古老的算法——自我训练(ST),该算法近年来在机器翻译(He等人,2019)、语音识别(Q. Xu等人,2020;Jacob Kahn, A. Lee和Hannun,2020)、语音翻译(Pino等人,2020a)和视觉对象检测中都有所回归。我们对ST进行了改进,使其更适合领域适应问题(第3章)。第4章展示了我们修改过的ST算法在高效构建低资源语言的ASR模型方面的有趣应用。

我们的工作的第二部分(第5-6章)关注跨语言迁移学习。第5章提出了一种新的多语言语音编码器,称为语义对齐的多模态跨语言语音表示(SAMU-XLS-R)。与其他多语言语音表示学习框架(Conneau, Baevski等人,2020; Babu等人,2021; Bapna, Cherry等人,2022a)不同,SAMU-XLS-R是一个联合语音-文本嵌入学习框架,它在其学习到的语音表示中编码了语义信息,而其他框架通常编码的是不太可转移的低级语言知识。由于语义知识不受语言限制,因此在学习到的语义表示的基础上构建多语言语音处理模型应该可以提高模型的跨语言可移植性。我们在第6章中展示,使用SAMU-XLS-R语音编码器构建的多语言语音翻译模型,与其他非语义语音编码器相比,能够更好地将任务特定的知识从高资源语言迁移到低资源语言。因此,我们在几个公开的基准测试中显著提高了多语言语音到文本的翻译性能。