谈到人工智能,我们可以抛弃数据集吗? 一项研究表明,使用合成数据训练的用于图像分类的机器学习模型可以与在真实事物上训练的机器学习模型相媲美。

一、研究成果

-

研究成果在ICLR 2022上发表

-

论文标题:Generative Models As A Data Source For Multiview Representation Learning

-

论文作者:Ali Jahanian, Xavier Puig, Yonglong Tian, Phillip Isola

-

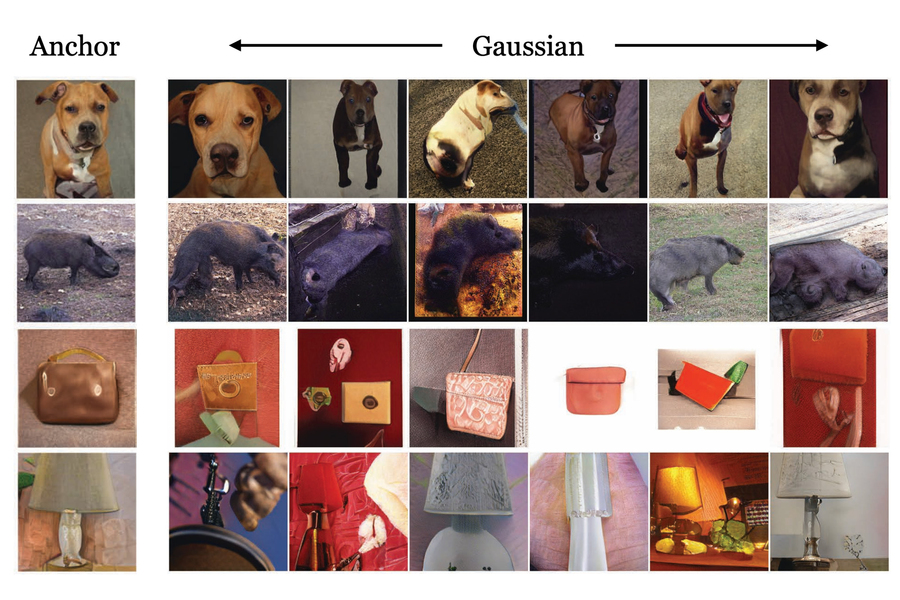

论文摘要:生成模型现在能够生成高度逼真的图像,这些图像看起来与训练它们的数据几乎没有区别。这就提出了一个问题:如果我们有足够好的生成模型,我们还需要数据集吗?我们在从黑盒生成模型而不是直接从数据中学习通用视觉表示的设置中研究这个问题。给定一个现成的图像生成器,无法访问其训练数据,我们从该生成器输出的样本中训练表示。我们比较了几种可以应用于此设置的表示学习方法,使用生成器的潜在空间来生成相同语义内容的多个“视图”。我们表明,对于对比方法,这种多视图数据自然可用于识别正对(在潜在空间中靠近)和负对(在潜在空间中相距较远)。我们发现得到的表示可以与直接从真实数据中学习到的表示相媲美,甚至优于那些表示,但是良好的性能需要在应用的采样策略和训练方法中小心。生成模型可以被视为数据集的压缩和有组织的副本,我们设想未来会有越来越多的“模型动物园”激增,而数据集变得越来越笨重、缺失或私有。本文提出了几种未来处理视觉表示学习的技术。

二、论文解读

需要大量数据来训练机器学习模型来执行图像分类任务,例如识别自然灾害后卫星照片中的损坏。然而,这些数据并不总是那么容易获得。如果一开始就存在可用数据,那么生成数据集可能需要花费数百万美元,即使是最好的数据集也经常包含对模型性能产生负面影响的偏差。

为了规避数据集带来的一些问题,麻省理工学院的研究人员开发了一种训练机器学习模型的方法,该方法不是使用数据集,而是使用一种特殊类型的机器学习模型来生成极其逼真的合成数据,这些数据可以训练另一个模型下游视觉任务。

他们的结果表明,仅使用这些合成数据训练的对比表示学习模型能够学习与从真实数据中学习到的视觉表示相媲美甚至优于那些的视觉表示。

这种特殊的机器学习模型被称为生成模型,与数据集相比,存储或共享所需的内存要少得多。使用合成数据也有可能回避一些关于隐私和使用权的担忧,这些担忧限制了一些真实数据的分发方式。还可以编辑生成模型以删除某些属性,例如种族或性别,这可以解决传统数据集中存在的一些偏见。

“我们知道这种方法最终会奏效;我们只需要等待这些生成模型变得越来越好。但是,当我们证明这种方法有时甚至比真实方法做得更好时,我们感到特别高兴,”计算机科学和人工智能实验室 (CSAIL) 的研究科学家、该论文的主要作者 Ali Jahanian 说。

Jahanian 与 CSAIL 研究生 Xavier Puig 和 Yonglong Tian 以及资深作者、电气工程与计算机科学系助理教授 Phillip Isola 共同撰写了这篇论文。该研究将在国际学习代表大会上发表。

生成合成数据

一旦生成模型在真实数据上进行了训练,它就可以生成非常逼真的合成数据,几乎与真实数据无法区分。训练过程包括向生成模型展示数百万张包含特定类别对象(如汽车或猫)的图像,然后它会学习汽车或猫的外观,以便生成类似的对象。

Jahanian 说,基本上通过拨动开关,研究人员可以使用预训练的生成模型来输出稳定的独特、逼真的图像流,这些图像基于模型训练数据集中的图像。

但他说,生成模型甚至更有用,因为它们学习如何转换训练它们所依据的基础数据。如果模型在汽车图像上进行训练,它可以“想象”汽车在不同情况下的外观——在训练期间没有看到的情况——然后输出以独特姿势、颜色或尺寸显示汽车的图像。

拥有同一图像的多个视图对于称为对比学习的技术很重要,其中机器学习模型显示许多未标记的图像以了解哪些对是相似的或不同的。

研究人员将预训练的生成模型与对比学习模型连接起来,使这两个模型能够自动协同工作。Jahanian 解释说,对比学习器可以告诉生成模型生成对象的不同视图,然后学习从多个角度识别该对象。

“这就像连接两个积木。因为生成模型可以为我们提供对同一事物的不同观点,它可以帮助对比方法学习更好的表示,”他说。

比真实数据还要好

研究人员将他们的方法与其他几个使用真实数据训练的图像分类模型进行了比较,发现他们的方法与其他模型一样好,有时甚至更好。

使用生成模型的一个优点是,理论上它可以创建无限数量的样本。因此,研究人员还研究了样本数量如何影响模型的性能。他们发现,在某些情况下,生成更多的独特样本会带来额外的改进。

“这些生成模型的酷之处在于,其他人为你训练了它们。您可以在在线存储库中找到它们,因此每个人都可以使用它们。而且你不需要干预模型来获得良好的表示,”Jahanian 说。

但他警告说,使用生成模型存在一些限制。在某些情况下,这些模型可以揭示源数据,这可能会带来隐私风险,如果没有经过适当的审计,它们可能会放大他们所训练的数据集中的偏差。

他和他的合作者计划在未来的工作中解决这些限制。他们想要探索的另一个领域是使用这种技术来生成可以改进机器学习模型的极端案例。极端案例通常无法从真实数据中学习。例如,如果研究人员正在为自动驾驶汽车训练计算机视觉模型,真实数据不会包含狗和它的主人在高速公路上奔跑的例子,因此该模型永远不会知道在这种情况下该怎么做。综合生成这种极端情况数据可以提高机器学习模型在某些高风险情况下的性能。

他说,研究人员还希望继续改进生成模型,以便他们可以合成更复杂的图像。

这项研究得到了麻省理工学院-IBM 沃森人工智能实验室、美国空军研究实验室和美国空军人工智能加速器的部分支持。