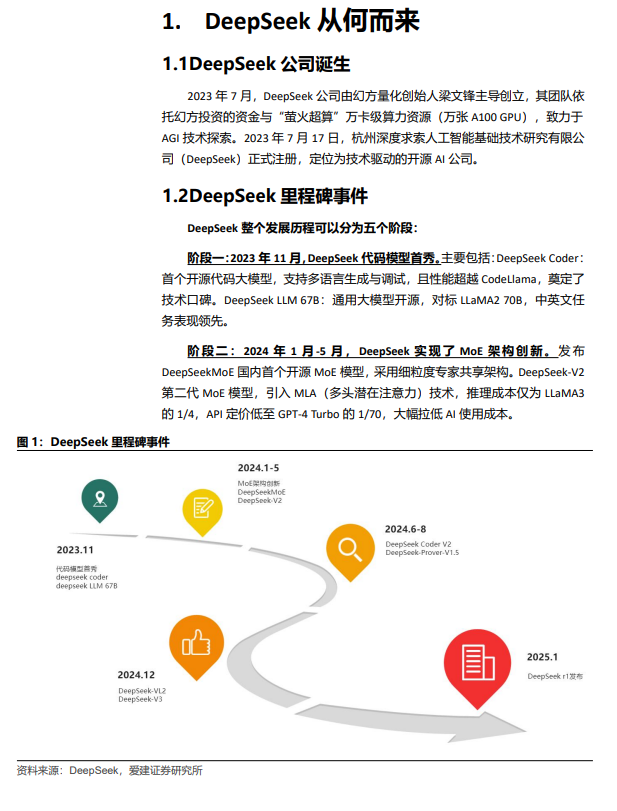

2025年1月20日,DeepSeek发布自研模型R1在全球科技行业引起的震动,被西方媒体称为“DeepSeekShock”。DeepSeek不仅在媒体圈迅速爆火,同样也成为了资本市场的宠儿,其概念指数仅仅诞生10日后板块成交金额就超过了全部A股成交额的20%。这一切现象究其原因,是因为DeepSeek通过技术微创新,以更低的硬件成本和更短的时间实现了可以与市场领先产品竞争的能力。更重要的是,DeepSeek打破了行业“限制中国企业对于最先进GPU获取,将能够阻止中国AI技术发展”的一贯认知。 本文有别于市场上大部分研究报告冗长的技术细节描述,我们针对投资人短时间内客观理解DeepSeek的需求,加入了不同于市场的思考和量化的分析比较。以下是报告的核心观点: DeepSeek的技术创新在哪里?1)首创DeepSeekMoE架构,专门设计用于实现终极专家专业化。DeepSeekMoE通过降低激活参数比例,实现了训练效率3.6X的提升和训练吞吐量3.6X的提升。2)通过引入MLA机制,DeepSeek-V2实现了显著增强的性能,节省了42.5%的训练成本、减少了93.3%的KV缓存、并将最大生成吞吐量提升至5.76倍。 DeepSeek-V3实际开发成本几何?公司官宣正式训练成本为580万美元,但是并没有披露隐性成本。DeepSeek-V3是建立在前期模型基础上开发的,前期研发投入约为2000-3000万美元。其他数据获取成本和硬件折旧成本未披露,实验试错成本约为500万美元,因此预计实际总成本超过4000万美元。实际成本虽然高达公开口径成本的7倍左右,但是仍然相对Llama3-405B降低了约69%;相对于GPT-4o降低了95%。 未来GPU算力需求会大幅下降吗?短期内云服务大厂资本开支持续处于上升通道,这是由于ScalingLaw导致行业对于算力军备竞赛的恐慌性投资仍然存在。但是ScalingLaw中,数据资源同样限制着模型性能的提升。根据EPOCHAI预测,到2028年人类生成的公共文本数据总有效库存量约为300Ttoken将被全部耗尽。换句话说,在现有模型框架和数据资源供给下,2028年之后单纯算力提升将难以继续推动模型性能的升级。 核心结论: 给予行业“强于大市”评级。随着DeepSeek的横空出世,低成本高性能的模型训练部署成为可能。我们预计接入DeepSeekAPI的细分领域推理服务商将会快速涌现,同时终端设备将会能够实现蒸馏小模型的本地部署能力,包括服务器,智能手机和智能驾驶系统都将会迎来新一轮的升级浪潮。我们看好以下细分板块在DeepSeek推动下的未来发展: 先进算力芯片制造产业链:算力芯片设计,先进制程晶圆代工,先进封测等等。 专业咨询服务:包括AI+医疗,法律,金融,会计,教育,政务等咨询服务领域。 2C智能终端:AI+智能手机,智驾汽车等终端产业链。 2B本地部署设备:服务器OEM及产业链。