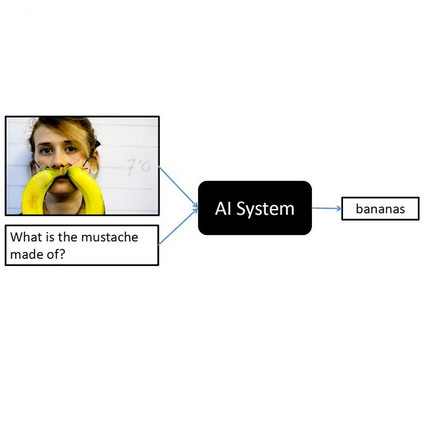

这篇论文主要研究视觉问题回答(VQA)的任务:即对图像提出的文字问题给予回答。我们探讨了此任务中的快捷学习:文献报告了模型学习表面关联的倾向,这使它们在大多数情况下能得到正确答案,但在遇到非常规输入数据时可能会失败。

首先,我们提出两种减少VQA上的快捷学习的方法。第一种方法,我们称之为“减少单模式偏见”(Reducing Unimodal Biases,简称RUBi),它由一个额外的损失组成,以鼓励模型从最困难和最少偏见的示例中学习,即那些不能仅仅从问题中得到答案的示例。我们证明了我们的方法可以减少现有VQA模型中基于问题的快捷方式,尤其是在数据分布发生偏移时。接下来,我们提出了一个更为特定的视觉计数任务的模型,这是VQA的一个子集,仅包括计数问题。我们设计了一个空间计数网络(Spatial Counting Network,简称SCN),这是一个模型,它结合了旨在使其对分布偏移更加鲁棒的架构先验。我们展示了SCN在与现有模型相比的分布之外的基准上具有卓越的性能。然后,我们研究了VQA数据集中多模式快捷方式的存在。我们表明,快捷方式不仅基于问题和答案之间的关联,还可以涉及图像信息。我们设计了一个评估基准,以衡量模型对多模式快捷方式的鲁棒性。我们展示了现有模型容易受到多模式快捷学习的影响。当模型在分布之外的环境中被评估时,这些快捷方式的学习尤为有害。因此,评估VQA模型的可靠性,即评估其对给定答案的信心的能力,是非常重要的。我们提出了一种提高VQA模型可靠性的方法,即它们在信心太低时放弃回答的能力。这包括训练一个外部的“选择器”模型来预测VQA模型的信心。为了避免在训练集上过拟合,但仍然使用所有可用的数据,该选择器使用类似交叉验证的方案进行训练。我们展示了我们的方法可以提高现有VQA模型的可靠性,无论是在分布内还是在分布外的设置中。

深度学习 —— 利用大量数据训练的深度神经网络 —— 已经在许多领域取得了重大突破,如计算机视觉 (Krizhevsky 等, 2012a) 和自然语言处理 (Mikolov 等, 2013)。这推动了研究者探索结合视觉和文本模态的多模态任务 (Kiros 等, 2015b; Karpathy 和 Fei-Fei 2015; C. Lu 等, 2016; Das 等, 2017b; Vries 等, 2017)。在这些任务中,VQA 受到了越来越多的关注。VQA 任务的目标是回答关于图像的问题。它要求对视觉场景和问题有高度的理解,并链接问题中的词汇与图像中的区域,充分利用这两种模式。研究 VQA 的重要性有两个原因。首先,它是一个富有挑战性的任务,需要复杂地处理场景和问题才能正确回答。它被称为视觉图灵测试 (Geman 等, 2015)。它是多模态理解和推理进展的重要基准。其次,解决 VQA 任务可能对实际应用产生直接和巨大的影响,例如帮助视觉受损的用户了解他们的物理和在线环境 (Gurari 等, 2018),通过自然语言界面搜索大量的视觉数据,或甚至使用更有效和直观的界面与机器人交流。社区提出了多个数据集,包括CLEVR这样的合成数据集 (Justin Johnson 等, 2017a),像 VQA v1 和 v2 这样的大规模真实数据集 (Antol 等, 2015a; Goyal 等, 2017a),专注于视觉受损用户的数据集 (Gurari 等, 2018),或针对医学领域的数据集 (Abacha 等, 2019)。

视觉问题回答已经使用深度学习方法来解决:这些是巨大的统计模型,经过大量示例训练,根据这些示例输出所需的答案。然而,这些模型对被称为快捷学习 (Shortcut Learning) (Geirhos 等, 2020) 特别敏感:它们会找到输入数据与答案之间的最简单关联。这通常是一个期望的属性,但当这些关联不是因果关系时,它也可能导致模型产生偏见。例如,如果模型在一个数据集上进行训练,其中“天空的颜色是什么?”的所有答案都是蓝色,那么模型的最简单行为将是对这个问题始终输出蓝色。这是一个问题,因为如果天空不是蓝色,它将不能正确回答。此外,当在具有相同分布的测试集上评估模型时,使用这些快捷方式将导致高准确率。但是,当在现实世界中使用模型时,它可能导致灾难性的失败。快捷学习是一个不特定于VQA的问题,但在这个任务中它尤为重要,因为它结合了多种模态,并需要对场景和推理有高度的理解才能正确回答。

在这篇论文中,我们在VQA的背景下探讨快捷学习的问题。我们建议探讨与VQA中的快捷学习相关的各种方向:策略来减轻快捷学习,通过使用归纳偏见来影响模型的首选解决方案,方法来检测VQA数据集中的快捷方式,以及模型在分布之外的设置中的可靠性。目标是更好地理解VQA中的快捷学习问题,并提出解决方案来减轻它,使模型更接近实际使用。