无人飞行器(UAV)图像的目标分类对于军事侦察和监视越来越重要。深度神经网络(DNN)是改进无人飞行器图像目标分类的一项很有前途的技术。然而,DNNs 可能由大量参数组成,这使得操作人员难以理解 DNNs 在目标分类中使用了哪些图像特征。这种缺乏透明度的情况对于将 DNNs 应用于目标分类的军事应用来说是一个挑战,因为由于武器交战的高风险,操作员最终要对所有决策负责。因此,操作人员也需要 DNN 分类的解释,以评估其可靠性。

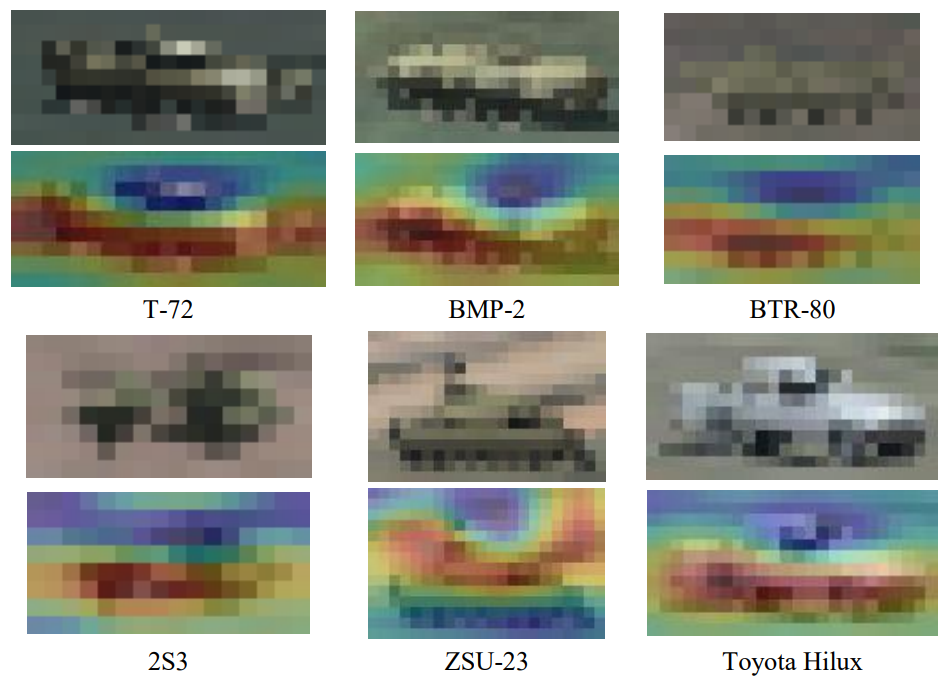

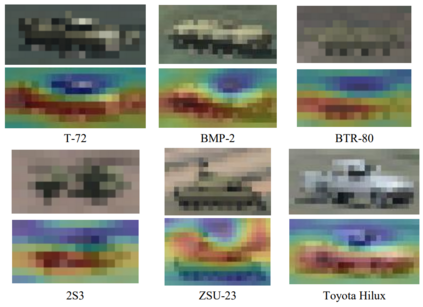

本报告介绍了一项实验,参与者在实验中对低空无人机图像中的军用车辆进行目标分类。实验的目的是评估对 DNN 分类的支持和对 DNN 分类的突出图解释(突出 DNN 分类最重要的特征)的支持是否能提高目标分类的准确性。显著性地图解释是用随机输入采样解释(RISE)方法生成的。受试者在三种不同的条件下完成目标分类任务:无 DNN 分类支持、有 DNN 分类支持和有 DNN 分类的 RISE 显著性地图解释支持。

结果表明,与预期相反,在有 DNN 分类支持的情况下,参与者的目标分类准确率会降低,而在有 RISE 突出图解释支持的情况下,准确率会进一步降低。在 DNN 分类和 RISE 突出图解释的支持下,参与者的目标分类准确率较低,这可能是由两个原因共同造成的:对自动决策辅助工具的依赖和难以评估 DNN 的可靠性。结果表明,当 DNN 分类正确时,参与者对其依赖性不足;而当 DNN 分类不正确时,参与者对其依赖性过高。

实验的结论是,要提供 DNN 分类和 DNN 分类解释,以实际支持操作员的目标分类,并非易事。如何呈现 DNN 分类信息,以及其他有前途的 XAI 方法是否能改善操作员的目标分类,还需要进行更多的实验。

第 2 章从参与者、车辆图像、DNN 分类和突出图解释等方面介绍了实验方法。第 3 章从调查因素如何影响目标分类性能、响应时间和对 DNN 分类的依赖性等方面介绍了实验结果。第 4 章总结了实验结果,并描述了取得目标分类性能的可能原因。第 5 章介绍了实验结论,并提供了一些用于图像分类的 XAI 方法建议,以便在未来的实验中进行评估。

图 2 车辆类别示例(上排)和 DNN 对车辆类别分类的 RISE 突出图解释(下排)。