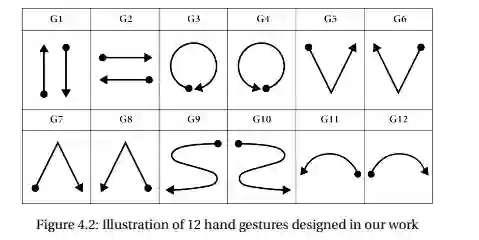

近年来,手势识别(HGR)已经取得了巨大的成功,并在人机交互领域开辟了一个新的趋势。然而,一些现有的手势识别系统在实际应用中的部署仍然遇到一些挑战,如传感器的可测量范围有限;由于使用单一的模式,缺乏重要的信息;由于复杂的深度模型的训练,通信成本高,延迟和隐私负担。本项目旨在克服这些主要问题,通过开发边缘智能技术,使用可穿戴多模态传感器(如加速度计和摄像头)进行手势识别,并减少注释工作。在这个项目中,我们设计了一个可穿戴式多模态原型,能够捕捉多模态信息,如RGB和运动数据。然后我们设计了一套在人机交互中常用的12种动态手势。我们使用所设计的原型在不同的环境条件下对50名受试者收集了此类手势的数据集。据我们所知,这个数据集可以被认为是研究界从腕戴式多模态传感器识别手势的第一个基准数据集。我们部署了各种最先进的CNN模型,对使用RGB和运动数据的手势识别进行了比较研究。实验结果显示了该基准的挑战,以及现有模型的最佳性能和未来的改进空间。此外,在该项目框架内,我们改进了带有时间信息的手部姿势估计和连续手势识别的算法。我们还对用于时间序列预测的混合CNN-LSTM模型中的形状分析和贝叶斯推理进行了基础研究。我们引入了一个框架,便于研究联邦学习。该原型和研究成果已在12个国际会议上发表,并提交给一个IEEE传感器杂志。

成为VIP会员查看完整内容

相关内容

专知会员服务

32+阅读 · 2022年10月21日

专知会员服务

66+阅读 · 2022年4月7日

Arxiv

1+阅读 · 2023年6月12日

Arxiv

0+阅读 · 2023年6月9日