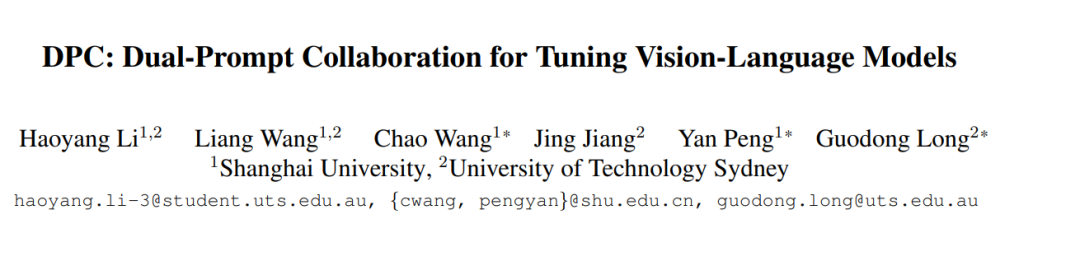

基础-新类别权衡(BNT)问题在基于 CLIP 的提示调优(Prompt Tuning)优化过程中普遍存在,表现为对基础(目标)类别的持续微调会同时导致模型在新(未见)类别上的泛化能力下降。现有方法尝试通过添加约束来调节提示调优过程,以平衡 BNT 问题。然而,这些约束作用于同一目标提示,无法完全避免基础类别和新类别优化方向之间的互斥性。针对这一挑战,我们提出了一种即插即用的双提示协作(Dual-Prompt Collaboration, DPC)框架,首次在提示级别上解耦基础任务和新任务的优化过程。具体而言,我们基于骨干提示(backbone prompt)克隆了一个可学习的并行提示,并引入了一个加权解耦框架(Weighting-Decoupling Framework),以独立控制针对基础任务或新任务的双提示优化方向,从而避免泛化冲突。同时,我们提出了一种动态硬负样本优化器(Dynamic Hard Negative Optimizer),利用双提示为基础类别构建更具挑战性的优化任务,以增强模型性能。为了增强可解释性,我们证明了提示向量在优化过程中的特征通道不变性,为 DPC 的加权解耦提供了理论支持。在多个骨干模型上的广泛实验表明,DPC 能够在不引入任何外部知识的情况下,显著提升模型在基础类别上的性能,同时保持对新类别的泛化能力。代码已开源,可在以下链接获取:https://github.com/JREion/DPC。

成为VIP会员查看完整内容