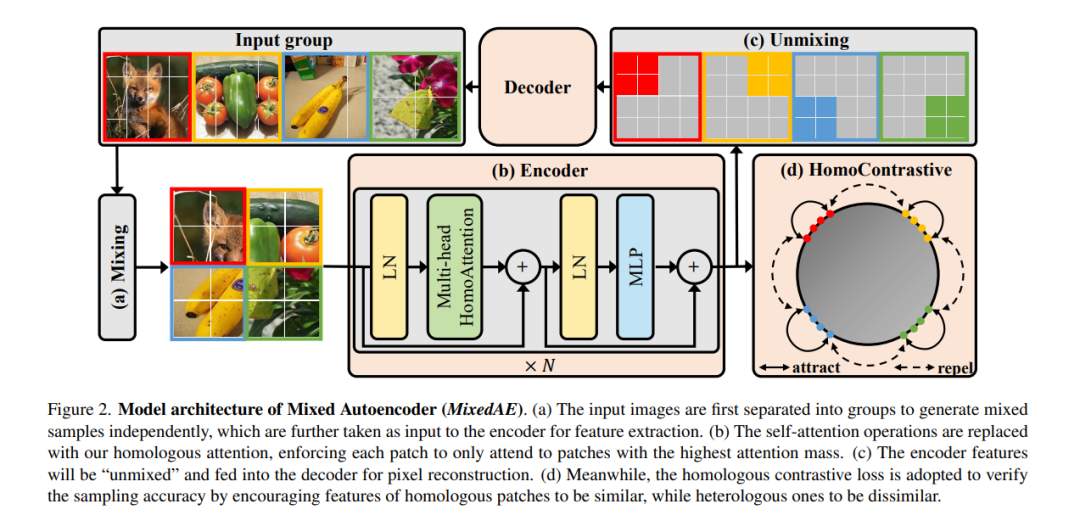

掩码自编码器(MAE)通过随机掩码图像块和重建,在各种视觉任务上表现出优越的性能。然而,MAE的有效数据增强策略仍然是开放问题,不同于作为最重要部分的对比学习中的策略。研究了主流的MAE混合增广算法。**本文首先证明,由于互信息(MI)的增加,朴素的混合会使模型性能退化。本文提出同源识别,一种辅助的前置任务,不仅通过明确要求每个块识别同源块来缓解MI的增加,而且还进行目标感知的自监督预训练,以获得更好的下游密集感知性能。**通过广泛的实验,所提出的混合自编码器(MixedAE)在不同的下游任务上实现了最先进的掩码图像建模(MIM)增强之间的迁移结果,效率显著。所提出的MixedAE在ImageNet-1K、ADE20K和COCO上使用标准vite - base分别比MAE提高了+0.3%的精度,+1.7 mIoU和+0.9 AP。此外,MixedAE的训练速度提高了2倍,超过了结合实例判别的强MIM方法iBOT。据我们所知,这是第一项从前置任务设计的角度考虑MIM混合的工作。代码将被提供。

成为VIP会员查看完整内容

相关内容

CVPR 2023大会将于 6 月 18 日至 22 日在温哥华会议中心举行。CVPR是IEEE Conference on Computer Vision and Pattern Recognition的缩写,即IEEE国际计算机视觉与模式识别会议。该会议是由IEEE举办的计算机视觉和模式识别领域的顶级会议,会议的主要内容是计算机视觉与模式识别技术。

CVPR 2023 共收到 9155 份提交,比去年增加了 12%,创下新纪录,今年接收了 2360 篇论文,接收率为 25.78%。作为对比,去年有 8100 多篇有效投稿,大会接收了 2067 篇,接收率为 25%。

Arxiv

0+阅读 · 2023年5月18日

Arxiv

11+阅读 · 2021年12月16日