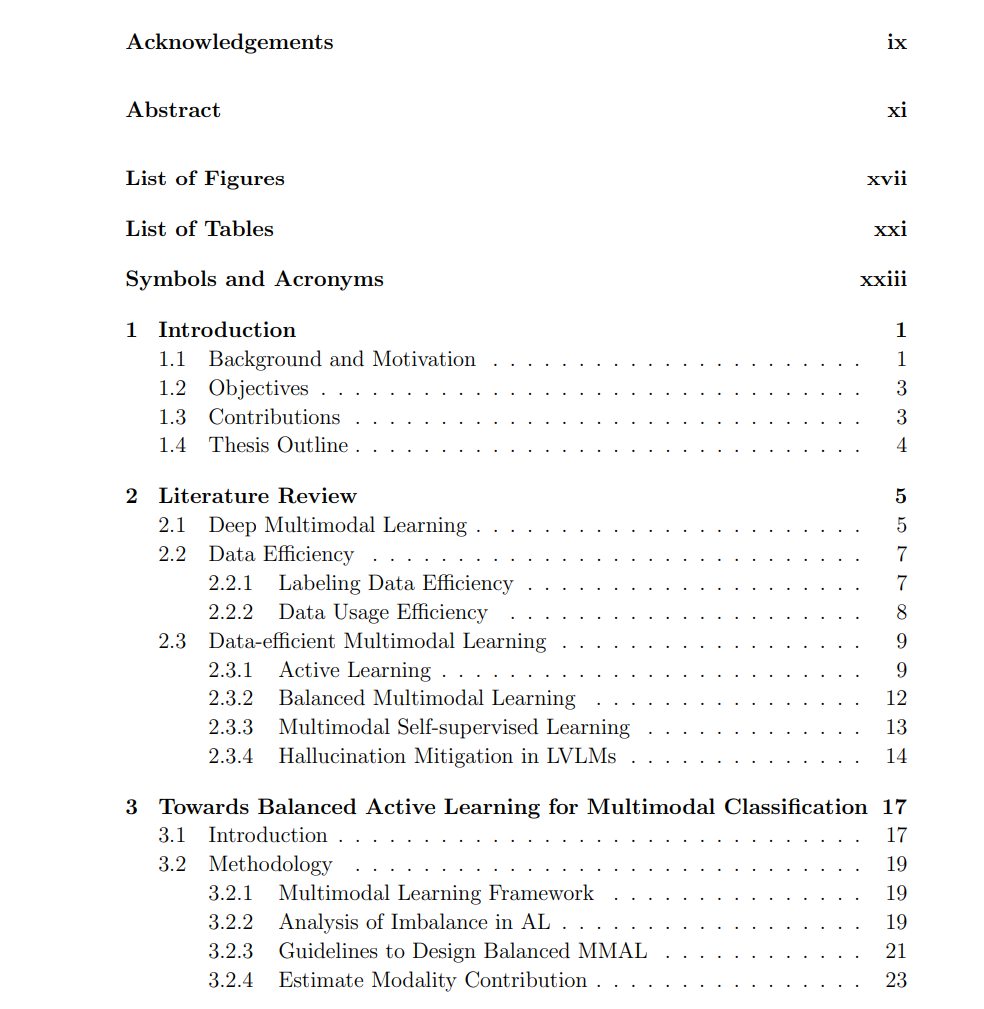

多模态学习使神经网络能够处理和整合来自不同感知模态(如视觉、语言和声音)的信息,在情感计算、医疗健康和高级多模态聊天机器人等应用中日益重要。尽管多模态学习具有广阔的潜力,但仍面临诸多挑战,尤其是在数据效率方面。构建高质量的大规模多模态数据集的需求构成了巨大的障碍,限制了大规模多模态模型的可扩展性和可获取性。 本论文研究了数据高效的深度多模态学习中的关键问题,重点关注不均衡的多模态数据选择、多模态主动学习中的冷启动问题,以及大型视觉-语言模型(VLMs)中的幻觉问题。 首先,我们分析了传统主动学习策略的局限性,这些策略往往偏向于主导模态,导致模型在训练过程中忽略较弱的模态,从而形成不平衡的多模态表示。为了解决这一问题,我们提出了一种梯度嵌入调制(gradient embedding modulation)方法,以确保数据选择过程中对不同模态的公平性,从而提升模型对强模态和弱模态的均衡利用能力。 基于我们在热启动(warm-start)主动学习方面的研究,我们进一步研究了多模态主动学习中的冷启动(cold-start)问题,即在没有初始标注数据的情况下如何有效进行数据选择。为此,我们提出了一种两阶段方法:

- 多模态自监督学习:通过使用单模态原型(unimodal prototypes)来统一不同模态的表示,从而缩小模态间的表示差距。

- 数据选择阶段:引入正则化项以最大化模态对齐度,在不增加数据量的前提下提升模型性能,相较于现有方法取得了更优结果。

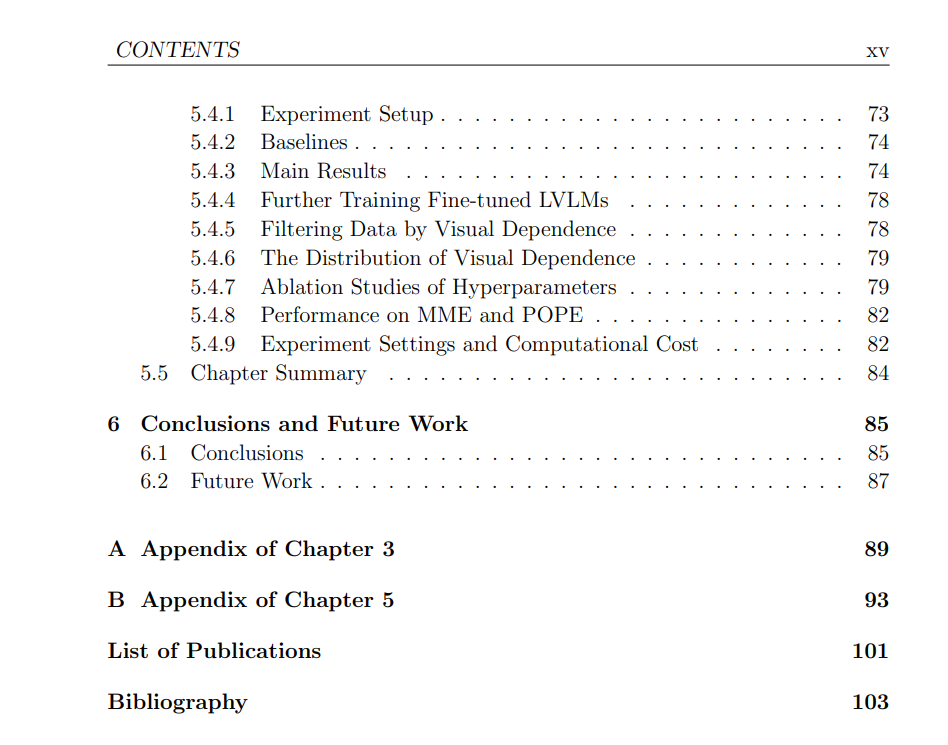

在从数据选择扩展到训练数据利用的研究中,我们进一步探讨了大型视觉-语言模型(VLMs)中的幻觉(hallucination)问题,即模型在生成内容时产生与输入图像上下文不符的错误信息。我们研究了幻觉现象与视觉依赖性(visual dependence)之间的关系,揭示了某些特定 token 对幻觉的贡献远高于其他 token。基于这一发现,我们提出了一种训练权重调整策略,根据 token 的视觉依赖性来调整训练过程中的权重分配,从而在无需额外训练数据或推理成本的情况下有效降低幻觉率。 本论文的贡献在于推动数据高效的多模态学习,通过优化多模态数据选择、解决冷启动问题,以及减少大型视觉-语言模型中的幻觉,本研究为更实用、可扩展的多模态学习系统奠定了基础,使其在降低数据和计算成本的同时提升模型性能。