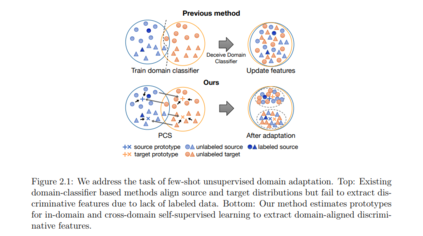

深度神经网络在学习给定数据集上的表示方面取得了巨大的成功。然而,在许多情况下,学习到的表示是依赖于数据集的,不能转移到具有不同分布的数据集,即使是对于相同的任务。如何处理域漂移是提高模型泛化能力的关键。域适应提供了一个潜在的解决方案,允许我们将具有丰富标签的源域转移到只有有限标签或没有标签的目标域。

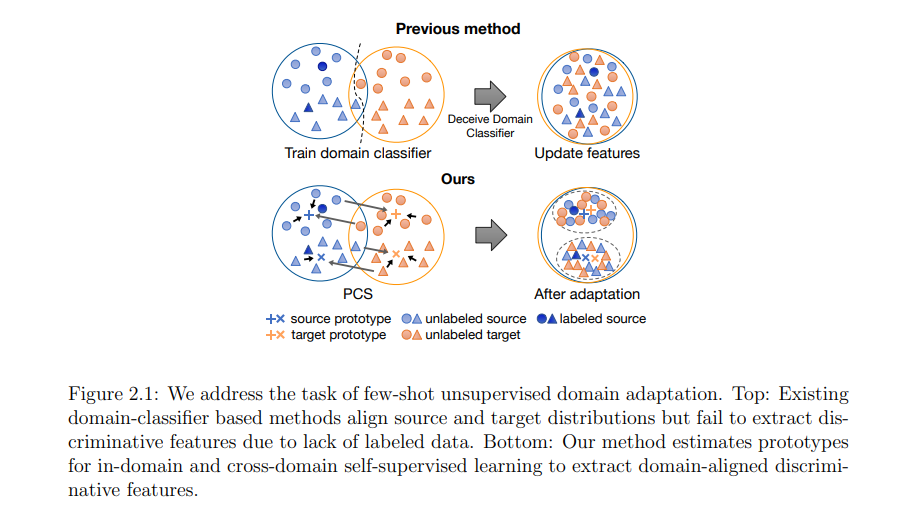

在本论文中,我将介绍在不同场景下学习可迁移表示的许多方法,包括1) 当源域只有有限的标签,甚至每个类只有一个标签时,2) 当有多个标记源域时,3) 当有多个未标记的目标域时。这些方法在不同的数据模态(如视觉和语言)中是通用的,并且可以很容易地组合起来解决其他类似的领域转移设置(如从具有有限标签的多个源适应),使模型能够泛化到源域之外。许多工作将知识从模拟数据转移到真实数据,以减少对昂贵的手动注释的需求。最后,介绍了我们在构建LiDAR 点云模拟器方面的开创性工作,进一步实现了LiDAR 点云分割的大量领域适配工作。

https://www2.eecs.berkeley.edu/Pubs/TechRpts/2022/EECS-2022-213.html

成为VIP会员查看完整内容

相关内容

加州大学伯克利分校(University of California, Berkeley),是美国最负盛名且是最顶尖的一所公立研究型大学,位于旧金山东湾伯克利市的山丘上。创建于1868年,是加州大学十个分校中历史最悠久的一所。加州大学伯克利分校在世界范围内拥有崇高的学术声誉,拥有丰富的教学资源,研究水平非常坚厚,与斯坦福大学、麻省理工学院等一同被誉为美国工程科技界的学术领袖。

Arxiv

0+阅读 · 2022年10月5日