题目: Generative Teaching Networks: Accelerating Neural Architecture Search by Learning to Generate Synthetic Training Data

摘要:

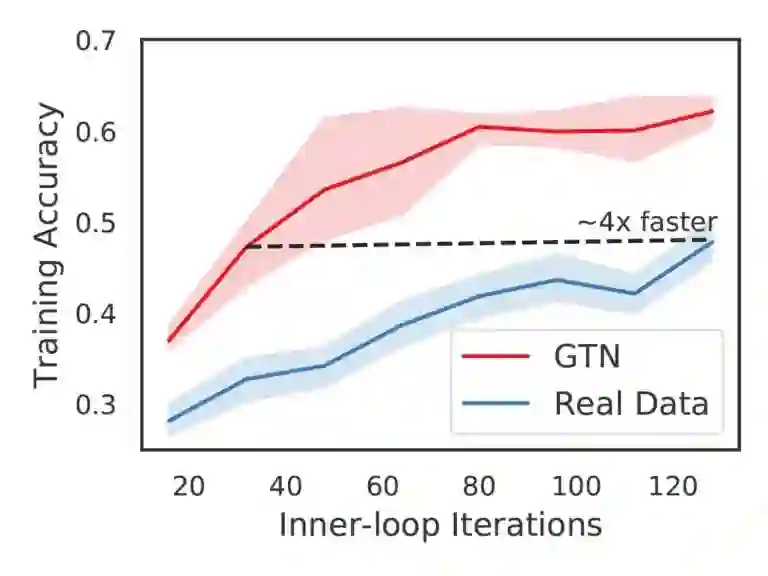

这篇论文探讨了一个有趣的问题,即我们是否可以创建自动生成训练数据、学习环境和课程的学习算法,以帮助人工智能智能体快速学习。我们证明了这种算法可以通过生成式教学网络(GTNs)来实现,生成式教学网络是一种理论上适用于有监督、无监督和强化学习的通用方法,尽管我们的实验只关注有监督的情况。GTNS是生成数据和训练环境的深度神经网络,学习者(例如,一个新初始化的神经网络)在对目标任务进行测试之前需要进行几个SGD步骤的训练。然后,我们通过元梯度来区分整个学习过程,更新GTN参数,以提高目标任务的性能。GTNS的有益特性是,理论上它们可以生成任何类型的数据或培训环境,从而使它们的潜在影响很大。本文介绍了GTNS,讨论了它们的潜力,并展示了它们可以极大地加速学习。我们还演示了一个实际的和令人兴奋的应用:加速评估候选架构的神经架构搜索(NAS),这是由这种评估的速度限制,使大量的加速在NAS。GTN-NAS改进了NAS的状态,在控制搜索建议机制时可以找到性能更好的架构。GTN-NAS还可以与现有的最先进的方法相竞争,这些方法在使用比典型NAS方法少几个数量级的计算量的情况下获得最佳性能。展望未来,GTNs可能代表着朝着算法的宏伟目标迈出的第一步,算法可以生成自己的训练数据,并在此过程中打开各种有趣的新研究问题和方向。

作者简介:

Felipe Petroski Such是一位专注于深度神经进化、强化学习和高性能计算的科学家。在加入Uber AI实验室之前,他获得了RIT的BS/MS学位,在那里他开发了图形应用和ICR的深度学习架构,以及使用fpga的硬件加速。

Aditya RawalAditya Rawal是Uber AI实验室的研究科学家。他的兴趣在于两个研究领域的融合——神经进化和深度学习。在此之前,Aditya在奥斯汀的德克萨斯大学获得了计算机科学的硕士/博士学位,在他的博士期间,他开发了神经进化算法来进化序列预测问题的递推架构,并构建了合作、竞争和交流的多主体系统。

Joel Lehman之前是哥本哈根IT大学的助理教授,研究神经网络、进化算法和强化学习。