来源:自动化学报,中国科学院自动化研究所微信公众号

机器学习技术成功地应用于计算机视觉、自然语言处理和语音识别等众多领域。然而,现有的大多数机器学习模型在部署后类别和参数是固定的,只能泛化到训练集中出现的类别,无法增量式地学习新类别。在实际应用中,新的类别或任务会源源不断地出现,这要求模型能够像人类一样在较好地保持已有类别知识的基础上持续地学习新类别知识。近年来新兴的类别增量学习研究方向,旨在使得模型能够在开放、动态的环境中持续学习新类别的同时保持对旧类别的判别能力(防止“灾难性遗忘”)。

中科院自动化所刘成林研究员等对类别增量学习方法进行了详细综述。根据克服遗忘的技术思路,将现有方法分为基于参数正则化、基于知识蒸馏、基于数据回放、基于特征回放和基于网络结构的五类方法,对每类方法的优缺点进行了总结。此外, 团队在常用数据集上对代表性方法进行了实验评估,并通过实验结果对现有算法的性能进行了比较分析。最后,对类别增量学习的研究趋势进行展望。文章发表于《自动化学报》创刊60周年专刊。

全文导读

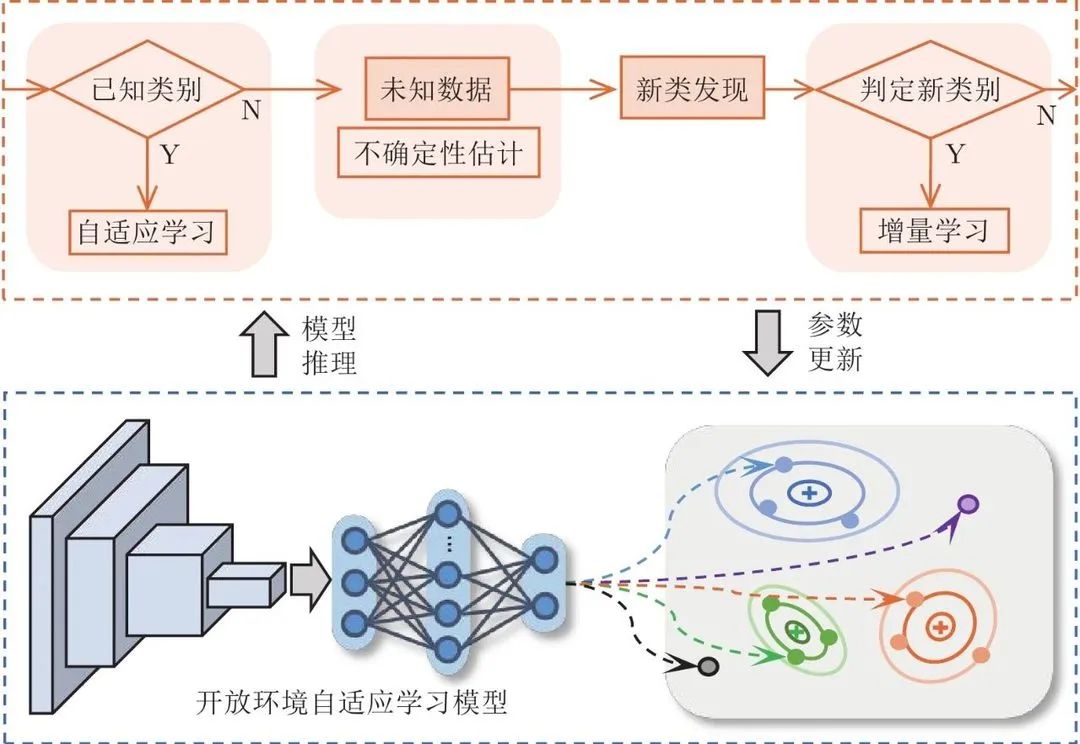

近年来,机器学习技术快速发展,在图像[1]、视频[2]、语音[3]等领域有着广泛的应用。特别地,在围棋[4]、游戏[5]、目标识别[6]等单个任务上的表现已经超越了人类的水平。但是,这种优越性能往往是基于封闭世界假设[7-8],即模型在测试阶段只会见到已知类别,且假设了训练和测试数据独立同分布。这种预定义和固定类别数量的假设在当前的机器学习系统中很常见,主要有以下两个原因。首先,这将使数据收集和标注过程更容易执行和控制。其次,这是大多数分类模型的要求。例如,深度神经网络的最后一层通常被视为类别节点,需要固定它们的数量以使模型能够正常训练。然而,真实世界的环境是复杂、开放和动态变化的[9-10]。封闭世界假设,即训练和测试数据来自相同且固定的类别,在实际应用中通常是不合理的。事实上,新的类别会不断出现,模型需要不断更新以获得对新类别的判别能力。 图1展示了真实开放环境中机器学习系统的工作流程,主要包括三个关键步骤。第一步是未知拒识,这要求系统能够准确识别来自已知类别的样本,同时还能够基于不确定性估计检测未知样本[11]。第二步是在缓冲区中标记收集到的未知类别样本(即新类发现),这一过程可以由人工或自动系统完成[12]。最后,当新发现的类别有较多数据时,模型必须通过扩展多类分类器来增量式地学习新的类别[13]。对未知类别拒识和新类发现感兴趣的读者可以参考文献[12, 14]了解前沿进展。本文主要关注上述流程中的最后一步,即类别增量学习。通过类别增量学习,机器学习系统能够扩展并适应动态和开放的环境。换句话说,部署后的机器学习系统依然可以在开放环境中持续和交互地学习。实际应用中有许多这样的需求:一个智能物流配送系统需要随着物品的流行期,不断地识别新出现的产品品种[15];再比如,人机对话系统也应该具有在部署后持续学习的能力[16],即在与用户的对话过程中不断地、交互式地学习新知识,随着时间的推移提高自身性能。

图 1 真实开放环境中机器学习系统的工作流程 面对开放和动态的实际环境,基于封闭世界假设的静态学习范式遇到严峻的挑战。具体地,在静态的学习范式下,模型只能泛化到已知类别。面对来自新类别或其他分布差异较大的测试样本,模型的泛化能力会严重退化[17]。如果使用新类别的数据更新模型,又会导致对旧类别判别能力的灾难性遗忘[18-19]。这些问题严重制约了机器学习模型在实际中的应用潜力。相比之下, 人类具有很好的增量学习能力。例如, 一个学会汉语的人在学习外语之后,仍然具备汉语能力。虽然人类在持续学习的过程中也会缓慢遗忘一些已有知识,但是不会出现如当前机器学习模型一样的灾难性遗忘现象。

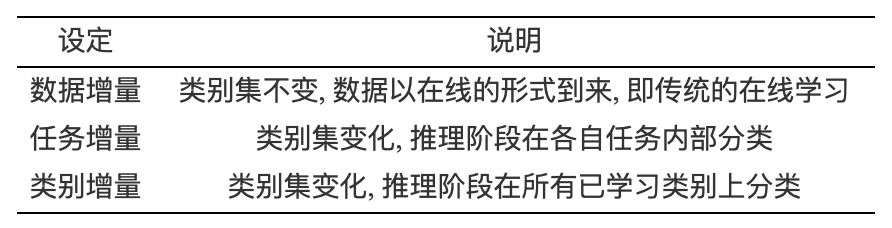

增量学习旨在使得模型能够不断更新来学习新类别或任务,同时又能较好地保持在已学习类别或任务上的性能。早期的增量学习主要是数据增量学习,也叫做在线学习[20]。在这种设定中,训练数据动态增加,但是类别集保持不变。例如,一些研究工作关注如何使支持向量机[21]或决策树[22]从动态数据流中学习。文献[20]详细地综述了在线学习方面的相关进展。与上述数据增量学习不同,文献[23]关注类别集动态增加的增量学习,提出了基于最近类别均值分类器来快速学习新类别。Ristin等[24]提出了一种可扩展的随机森林算法,使得模型能够不断地学习新出现的类别。

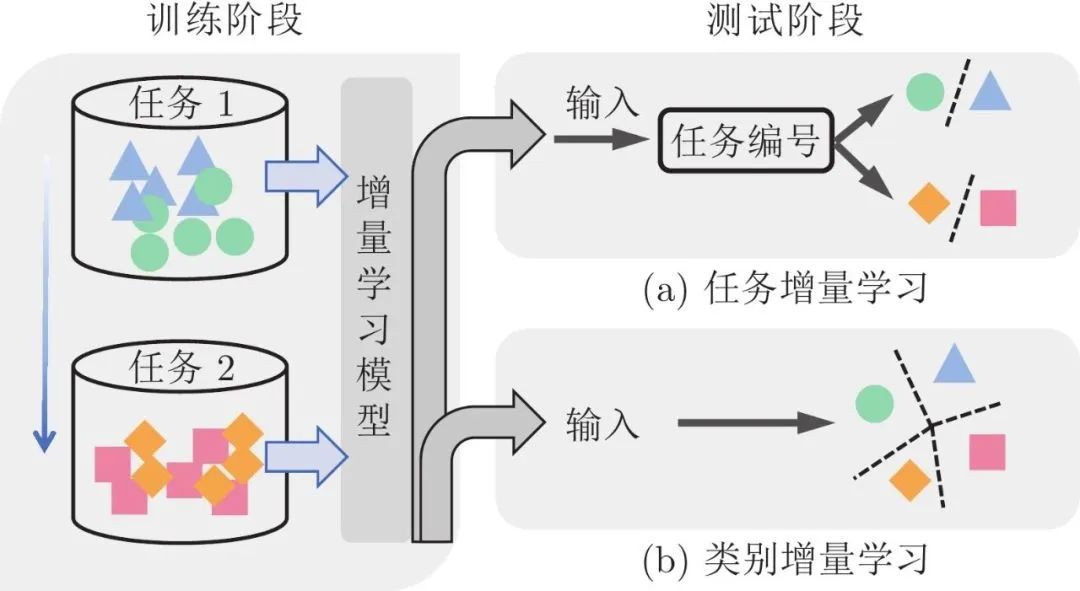

近年来,基于深度学习的增量学习得到了广泛关注。在场景设定方面,目前的增量学习主要有两大类,即任务增量学习[25-28]和类别增量学习[13, 29-31],如图2所示,在任务增量学习场景中,不同的任务共享相同的特征提取器。每学习一个任务,模型需要增加一个输出分类层。由于不同任务的分类层之间互不影响,因此任务增量学习场景中遗忘现象主要发生在特征提取器部分。在测试阶段,模型需要在事先已知当前测试样本所属的任务编号的基础上,在该任务所对应的分类层内部进行分类。与任务增量学习不同,类别增量学习场景中所有类别共享一个分类层,该分类层会随着学习类别的增加而增加类别节点。在测试阶段,不需要预先指定测试样本所属类别就可以对所有已知类别进行分类。在类别增量学习中,不同类别之间会相互影响。因此,特征提取器和分类层都存在遗忘现象。相比任务增量学习,类别增量学习更接近实际应用场景,但也更有挑战性。表1对不同的增量学习设定进行了总结和比较。

表 1 不同增量学习设定对比

图 2 任务和类别增量学习示意图 (本文关注类别增量学习)

随着对增量学习研究的深入,众多研究成果不断涌现,近年也有一些综述性工作出现。例如,文献[10]从生物学的角度综述了大脑在动态环境中持续学习的机理,以及一些早期的受生物学启发的持续学习方法。文献[32]对任务增量学习方法进行了系统地综述和详细地实验评估。本文与文献[32]的区别主要体现在两个方面:在任务层面,文献[32]关注任务增量学习,而本文关注类别增量学习。在方法层面, 文献[32]中每类方法包含的具体技术大多为任务增量学习设计(这些方法在类别增量学习任务上往往表现差),与本文综述的类别增量学习方法不同。文献[33]综述了一些类别增量学习方法。相比之下,本文对已有方法总结地更加细致和全面。例如,本文加入了近期发展起来的两类重要方法,即特征回放类方法和网络结构类方法。这两类方法是当下广为关注和具有较大研究潜力的方向。此外,文献[33]只评估了保存样本的方法,而本文细致地评估了非保存样本的方法如基于特征回放类的方法,并从多个角度与保存样本类方法进行了对比。文献[34]总结和评估了一些方法在在线持续学习场景下的表现。文献[35]介绍了一些典型的持续学习模型,主要包含了早期的一些任务增量学习方法。文献[36]从类脑持续学习机制的角度,综述了基于脑启发的持续学习方法。总之,上述综述文章大多注重任务增量学习方法,较少涉及类别增量学习,且没有包含最新的研究进展。此外,当前的综述文章中缺少对类别增量学习的性能比较。因此,本文主要关注类别增量学习,对已有的类别增量学习方法在图像分类任务上进行了详细的综述,对代表性方法进行了细致的实验评估。最后展望了类别增量学习的未来研究趋势。

本文整体结构如下:第1节介绍类别增量学习的定义、评价指标和序列任务划分方式。第2节根据不同的技术思路,将现有类别增量方法分为基于参数正则化、基于知识蒸馏、基于数据回放、基于特征回放和基于网络结构的五类方法,并对每类方法的优缺点进行了总结。第3节介绍了类别增量学习的公用数据集,对代表性方法进行了系统的实验评估,并通过实验结果对现有算法的性能进行了比较。第4节展望了类别增量学习未来研究方向。最后,第5节对全文进行了总结。

- 类别增量学习介绍 1.1 问题定义 1.2 评价指标 1.3 类别任务划分 1.4 类别增量学习应用场景

- 类别增量学习研究进展 2.1 基于参数正则化的方法 2.1.1 参数重要性估计 2.1.2 子空间投影 2.2 基于知识蒸馏的方法 2.2.1 重要特征蒸馏 2.2.2 样本关系蒸馏 2.2.3 辅助数据蒸馏 2.3 基于数据回放的方法 2.3.1 真实数据回放 2.3.2 新旧偏差校准 2.3.3 生成数据回放 2.4 基于特征回放的方法 2.4.1 真实特征回放 2.4.2 类别原型回放 2.4.3 生成特征回放 2.5 基于网络结构的方法

- 实验对比分析 3.1 常用数据集 3.2 实验设定 3.3 结果对比分析 3.3.1 同类方法内部对比分析 3.3.2 不同类方法之间对比分析

- 未来研究展望

- 结束语

**部分文献 **

[1] He K M, Zhang X Y, Ren S Q, Sun J. Deep residual learning for image recognition. In: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, USA: IEEE, 2016. 770−778 [2] Feichtenhofer C, Fan H Q, Malik J, He K M. SlowFast networks for video recognition. In: Proceedings of the IEEE/CVF International Conference on Computer Vision (ICCV). Seoul, Korea (South): IEEE, 2019. 6201−6210 [3] Qian Y M, Bi M X, Tan T, Yu K. Very deep convolutional neural networks for noise robust speech recognition. IEEE/ACM Transactions on Audio, Speech, and Language Processing, 2016, 24(12): 2263-2276 doi: 10.1109/TASLP.2016.2602884 [4] Silver D, Schrittwieser J, Simonyan K, Antonoglou I, Huang A, Guez A, et al. Mastering the game of go without human knowledge. Nature, 2017, 550(7676): 354-359 doi: 10.1038/nature24270 [5] Wurman P R, Barrett S, Kawamoto K, MacGlashan J, Subramanian K, Walsh T J, et al. Outracing champion Gran Turismo drivers with deep reinforcement learning. Nature, 2022, 602(7896): 223-228 doi: 10.1038/s41586-021-04357-7 [6] Redmon J, Divvala S, Girshick R, Farhadi A. You only look once: Unified, real-time object detection. In: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Las Vegas, USA: IEEE, 2016. 779−788 [7] Geng C X, Huang S J, Chen S C. Recent advances in open set recognition: A survey. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2021, 43(10): 3614-3631 doi: 10.1109/TPAMI.2020.2981604 [8] Zhang X Y, Liu C L, Suen C Y. Towards robust pattern recognition: A review. Proceedings of the IEEE, 2020, 108(6): 894-922 doi: 10.1109/JPROC.2020.2989782 [9] Hadsell R, Rao D, Rusu A A, Pascanu R. Embracing change: Continual learning in deep neural networks. Trends in Cognitive Sciences, 2020, 24(12): 1028-1040 doi: 10.1016/j.tics.2020.09.004 [10] Parisi G I, Kemker R, Part J L, Kanan C, Wermter S. Continual lifelong learning with neural networks: A review. Neural Networks, 2019, 113: 54-71 doi: 10.1016/j.neunet.2019.01.012 [11] Hendrycks D, Gimpel K. A baseline for detecting misclassified and out-of-distribution examples in neural networks. In: Proceedings of the 5th International Conference on Learning Representations (ICLR). Toulon, France: OpenReview.net, 2017. [12] Han K, Rebuffi S A, Ehrhardt S, Vedaldi A, Zisserman A. AutoNovel: Automatically discovering and learning novel visual categories. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 44(10): 6767-6781 [13] Zhu F, Zhang X Y, Wang C, Yin F, Liu C L. Prototype augmentation and self-supervision for incremental learning. In: Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Nashville, USA: IEEE, 2021. 5867−5876 [14] Yang J K, Zhou K Y, Li Y X, Liu Z W. Generalized out-of-distribution detection: A survey. arXiv preprint arXiv: 2110.11334, 2021. [15] She Q, Feng F, Hao X Y, Yang Q H, Lan C L, Lomonaco V, et al. OpenLORIS-object: A robotic vision dataset and benchmark for lifelong deep learning. In: Proceedings of the IEEE International Conference on Robotics and Automation (ICRA). Paris, France: IEEE, 2020. 4767−4773 [16] Liu B, Mazumder S. Lifelong and continual learning dialogue systems: Learning during conversation. In: Proceedings of the 35th AAAI Conference on Artificial Intelligence. AAAI, 2021. 15058−15063 [17] Wang Y Q, Yao Q M, Kwok J T, Ni L M. Generalizing from a few examples: A survey on few-shot learning. ACM Computing Surveys, 2021, 53(3): Article No. 63 [18] Goodfellow I J, Mirza M, Xiao D, Courville A, Bengio Y. An empirical investigation of catastrophic forgetting in gradient-based neural networks. arXiv preprint arXiv: 1312.6211, 2013. [19] McCloskey M, Cohen N J. Catastrophic interference in connectionist networks: The sequential learning problem. Psychology of Learning and Motivation, 1989, 24: 109-165 [20] Hoi S C H, Sahoo D, Lu J, Zhao P L. Online learning: A comprehensive survey. Neurocomputing, 2021, 459: 249-289 doi: 10.1016/j.neucom.2021.04.112 [21] Cauwenberghs G, Poggio T. Incremental and decremental support vector machine learning. In: Proceedings of the 13th International Conference on Neural Information Processing Systems. Denver, USA: MIT Press, 2000. 388−394 [22] Shrestha P. Incremental learning strategies with random forest classifiers. In: Proceedings of the 32nd WIC Symposium on Information Theory. Brussels, Belgium: WIC, 2011. 1-6 [23] Mensink T, Verbeek J, Perronnin F, Csurka G. Distance-based image classification: Generalizing to new classes at near-zero cost. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2013, 35(11): 2624-2637 doi: 10.1109/TPAMI.2013.83 [24] Ristin M, Guillaumin M, Gall J, Van Gool L. Incremental learning of random forests for large-scale image classification. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2016, 38(3): 490-503 doi: 10.1109/TPAMI.2015.2459678 [25] Kirkpatrick J, Pascanu R, Rabinowitz N, Veness J, Desjardins G, Rusu A A, et al. Overcoming catastrophic forgetting in neural networks. Proceedings of the National Academy of Sciences of the United States of America, 2017, 114(13): 3521-3526 doi: 10.1073/pnas.1611835114 [26] Li Z Z, Hoiem D. Learning without forgetting. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2018, 40(12): 2935-2947 doi: 10.1109/TPAMI.2017.2773081 [27] Zenke F, Poole B, Ganguli S. Continual learning through synaptic intelligence. In: Proceedings of the 34th International Conference on Machine Learning (ICML). Sydney, Australia: PMLR, 2017. 3987−3995 [28] Aljundi R, Babiloni F, Elhoseiny M, Rohrbach M, Tuytelaars T. Memory aware synapses: Learning what (not) to forget. In: Proceedings of the 15th European Conference on Computer Vision (ECCV). Munich, Germany: Springer, 2018. 144−161 [29] Rebuffi S A, Kolesnikov A, Sperl G, Lampert C H. iCaRL: Incremental classifier and representation learning. In: Proceedings of the IEEE Conference on Computer Vision and Pattern Recognition (CVPR). Honolulu, USA: IEEE, 2017. 5533−5542 [30] Hou S H, Pan X Y, Loy C C, Wang Z L, Lin D H. Learning a unified classifier incrementally via rebalancing. In: Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Long Beach, USA: IEEE, 2019. 831−839 [31] Zhao B W, Xiao X, Gan G J, Zhang B, Xia S T. Maintaining discrimination and fairness in class incremental learning. In: Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR). Seattle, USA: IEEE, 2020. 13205−13214[32] De Lange M, Aljundi R, Masana M, Parisot S, Jia X, Leonardis A, et al. A continual learning survey: Defying forgetting in classification tasks. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2022, 44(7): 3366-3385[33] Masana M, Liu X L, Twardowski B, Menta M, Bagdanov A D, van de Weijer J. Class-incremental learning: Survey and performance evaluation on image classification. IEEE Transactions on Pattern Analysis and Machine Intelligence, to be published[34] Mai Z, Li R W, Jeong J, Quispe D, Kim H, Sanner S. Online continual learning in image classification: An empirical survey. Neurocomputing, 2022, 469: 28-51 doi: 10.1016/j.neucom.2021.10.021[35] 韩亚楠, 刘建伟, 罗雄麟. 连续学习研究进展. 计算机研究与发展, 2022, 59(6): 1213-1239 doi: 10.7544/issn1000-1239.20201058Han Ya-Nan, Liu Jian-Wei, Luo Xiong-Lin. Research progress of continual learning. Journal of Computer Research and Development, 2022, 59(6): 1213-1239 doi: 10.7544/issn1000-1239.20201058[36] 杨静, 李斌, 李少波, 王崎, 于丽娅, 胡建军, 等. 脑启发式持续学习方法: 技术、应用与发展. 电子与信息学报, 2022, 44(5): 1865-1878 doi: 10.11999/JEIT210932Yang Jing, Li Bin, Li Shao-Bo, Wang Qi, Yu Li-Ya, Hu Jian-Jun, et al. Brain-inspired continuous learning: Technology, application and future. Journal of Electronics & Information Technology, 2022, 44(5): 1865-1878 doi: 10.11999/JEIT210932

作者简介

朱飞,中国科学院自动化研究所博士研究生,2018年获得清华大学学士学位。主要研究方向为模式识别和机器学习。 张煦尧,中国科学院自动化研究所副研究员。2008年获得武汉大学学士学位,2013年获中国科学院大学博士学位。主要研究方向为模式识别,机器学习和文字识别。 刘成林,中国科学院自动化研究所研究员。主要研究方向为图像处理,模式识别,机器学习,文档分析,文字识别。

全文下载:

朱飞, 张煦尧, 刘成林. 类别增量学习研究进展和性能评价. 自动化学报 2023, DOI: 10.16383/j.aas.c220588 http://www.aas.net.cn/cn/article/doi/10.16383/j.aas.c220588