本报告调查了对抗性机器学习 (AML),即研究基于机器学习 (ML) 的人工智能系统弱点的研究方法。近年来,机器学习,尤其是深度学习 (DL),在图像分类、自然语言处理和自主代理等多个领域取得了快速进展。因此,深度学习在军事环境中也很受关注。然而,随着进步,人们对 AML 方法的兴趣不断增加,新的攻击变体不断发布。实际上,所有 DL 系统在某种程度上都容易受到影响,无论是混淆它们、避免被它们检测到,还是提取它们可能持有的秘密信息。从军事角度来看,重要的是要意识到这种利用的可能性,无论是针对自己的人工智能系统还是针对对手使用的系统。

该报告概述了AML研究,然后展示了针对不同类型人工智能系统的一系列攻击方法:

- 图像分类系统中毒,使军用车辆避免被发现;

- 可以从大型生成模型中检索秘密信息的提取攻击;

- 对抗性策略攻击,其中对手的行为方式使自主智能体感到困惑。

每个案例都描述和讨论了攻击并评估了实施。本报告的重点是攻击。虽然在适用的情况下简要讨论了针对 AML方法的防御,但后续报告的主题是对AML防御的更深入研究。

关键词:人工智能、机器学习、深度学习、深度神经网络、欺骗、网络攻击、攻击向量、漏洞、对抗样本、数据中毒、数据提取、对抗策略

引言

深度学习 (DL) 的出现将智能计算机软件的性能和能力带入了新的性能水平。将基于 DL 的软件嵌入军事指挥、控制、通信、计算机、情报、监视和侦察 (C4ISR) 系统中,有可能彻底改变创建准确及时的共同作战图 (COP) 的能力,从而使军事决策过程可以比以往任何时候都更快、更精确地执行。从长远来看,深度学习还可以用于在远远超出人类能力范围的复杂战争环境中制定军事计划。

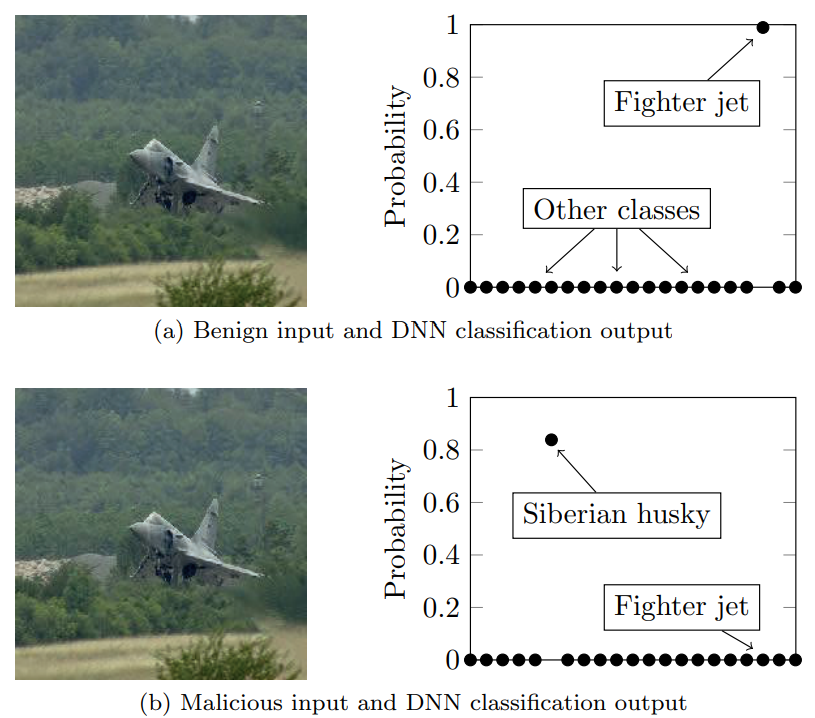

然而,由深度神经网络 (DNN) 实施的基于 DL 的软件容易受到各种威胁或网络攻击。这些是在对抗性机器学习 (AML) 研究领域研究和开发的。这些攻击可能被用来欺骗决策者、降低系统性能、降低最终用户信任度,甚至从系统中提取(即逆向工程)敏感的军事数据。图 1.1 展示了一个典型的 AML 攻击示例,其中目标是用于对图像内容进行分类的 DNN。在这种情况下,DNN 能够正确地识别出图 1.1a 中的原始图像包含一架战斗机,几乎是绝对确定的。图 1.1b 中的恶意图像是通过在原始图像上应用 AML 技术创建的,能够欺骗相同的 DNN 将输入分类为西伯利亚雪橇犬而不是战斗机。在这种情况下,攻击是有效的,尽管人眼无法察觉。

图 1.1 – 使用 AML 的样本攻击。在这种情况下,目标是由 DNN 表示的图像分类系统。图 1.1a 显示 DNN 能够以近乎完美的确定性将良性(非操纵)输入正确分类为战斗机。图 1.1b 显示了使用 AML 技术创建的经过处理的图像。被操纵的图像成功地欺骗了 DNN,将输入分类为西伯利亚雪橇犬而不是战斗机。

据我们所知,AML 尚未被对手或高级持续威胁 (APT) 参与者用来瞄准和攻击嵌入在现实世界军事系统中的基于 DL 的软件。然而,研究团队和安全专家不断证明,针对依赖 DL 来实现尖端性能广泛应用程序的攻击是可能的 [1]。例如,小心地替换句子中的单词可能会导致语言模型对情绪进行错误分类 [2]。自动驾驶汽车使用的交通标志和车道检测系统可以通过分别在标志和道路上贴上标签来攻击 [3, 4]。转录服务可能会被注入精心设计的噪声所误导,迫使系统将语音转换为任意文本 [5、6]。因此,假设基于 DL 的软件将在未来的 C4ISR 支持系统中普遍使用,预计对手和 APT 最终将利用这些漏洞来欺骗、拒绝访问或收集情报。

1.1 目标与范围

本报告的目标是:(1) 概述迄今为止 AML 研究领域中已确定的攻击向量,(2) 根据经验估计这些攻击的子集在军事环境中的有效性,以及最后 (3) 提供见解并讨论 AML 在何种程度上是深度学习在现实世界军事应用中的现实和严重威胁。

尽管 AML 适用于任何基于 ML 的系统和算法,但本报告重点关注基于 DL 的 ML 系统。此外,本报告将重点关注攻击。在 AML 研究领域提出和开发的防御机制将在未来的工作中涵盖。最后,我们将范围限制在与指挥和控制 (C2)、情报、监视和侦察相关的 DL 应用。

1.2 目标读者群

本报告的目标读者是操作、获取或开发军事系统的人员,这些系统使用或嵌入了 AI、ML 和 DL 技术。

1.3 阅读说明

本报告假定读者具有有关 ML 和 DL 概念的基本知识,例如监督学习、强化学习、损失函数、梯度下降和反向传播。

1.4 提纲

第 2 章介绍了 AML,并介绍了用于对本报告中的攻击进行分类和比较的分类法。第 3 章介绍了从军事角度来看可能具有相关性的已知攻击方法的三个案例研究。实施和评估这些方法。第 4 章总结了报告,讨论了 AML 在现实世界中的适用性,包括在军事领域。

案例研究

本章提供了三个案例研究,探讨了针对基于ML的系统的不同类型攻击。在每种情况下,从AML文献中选择一种攻击方法,并从军事角度实现或测试。评估了攻击的有效性,然后讨论了实际考虑因素。选择这三个案例研究是因为它们与军事领域的潜在相关性,涵盖了广泛的攻击,并说明了各种ML应用和方法。

第一章以欺骗深度神经网络将战斗机图像误认为是狗的例子开始。虽然将军事装备隐藏在显眼的地方有明显的吸引力,但介绍性的例子是高度理想化的。实际应用面临的一个障碍是,攻击仅限于数字领域:操作是在数字图像本身上进行的,也就是说,在战斗机被拍摄后的一个阶段。如果图像是由对手创建的(例如,飞机是由监视摄像机拍摄的),那么操纵图像将需要深入访问敌人的系统。这是不太可能的(如果是,更简单和更健壮的攻击变得可行,例如消除图像或阻止其记录)。此外,虽然关于目标深度神经网络的黑盒知识足以计算所需的图像修改(例如,观察分类标签结果[18]),但在实践中,即使是这种知识也无法预期。

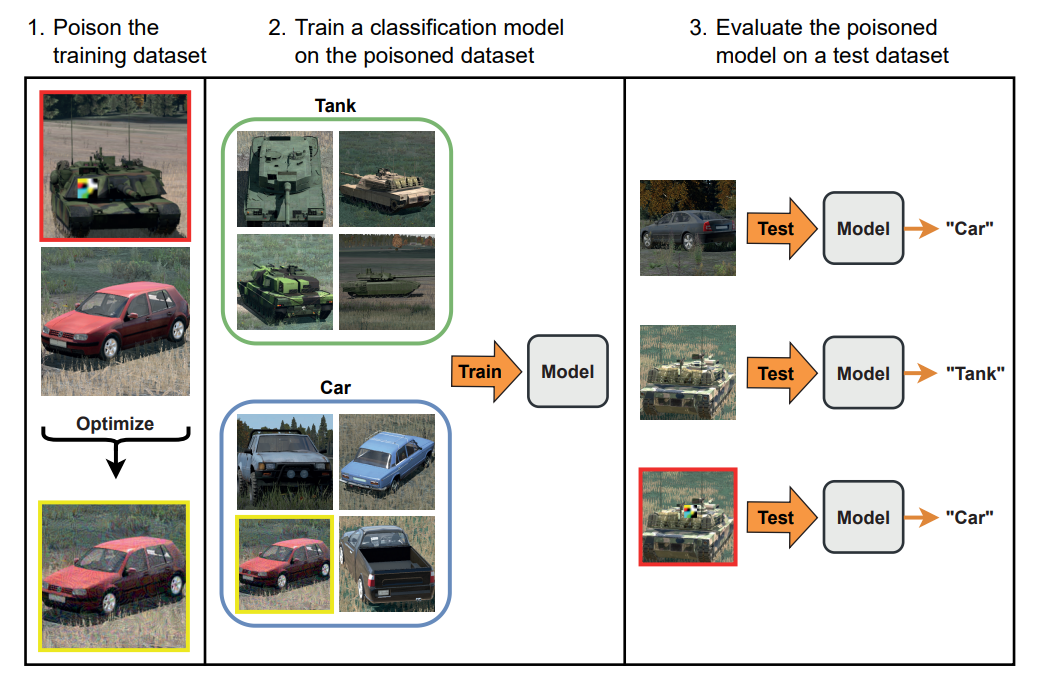

因此,第3.1节中的第一个案例研究调查了数据中毒。这种攻击的目的与前面的示例相同:通过欺骗敌人的DNN,使其对车辆进行错误分类,从而使军用车辆(在本例中为坦克)逃避检测。尽管方法也很相似,但是中毒攻击解决了介绍性示例的实际缺点。

图3.2 -仅使用正确标记的训练图像和直到测试时间才显示的隐藏触发器的数据中毒攻击。在这个图中,所有打补丁的坦克图像都用红色标出,而所有中毒的汽车图像都用黄色标出。

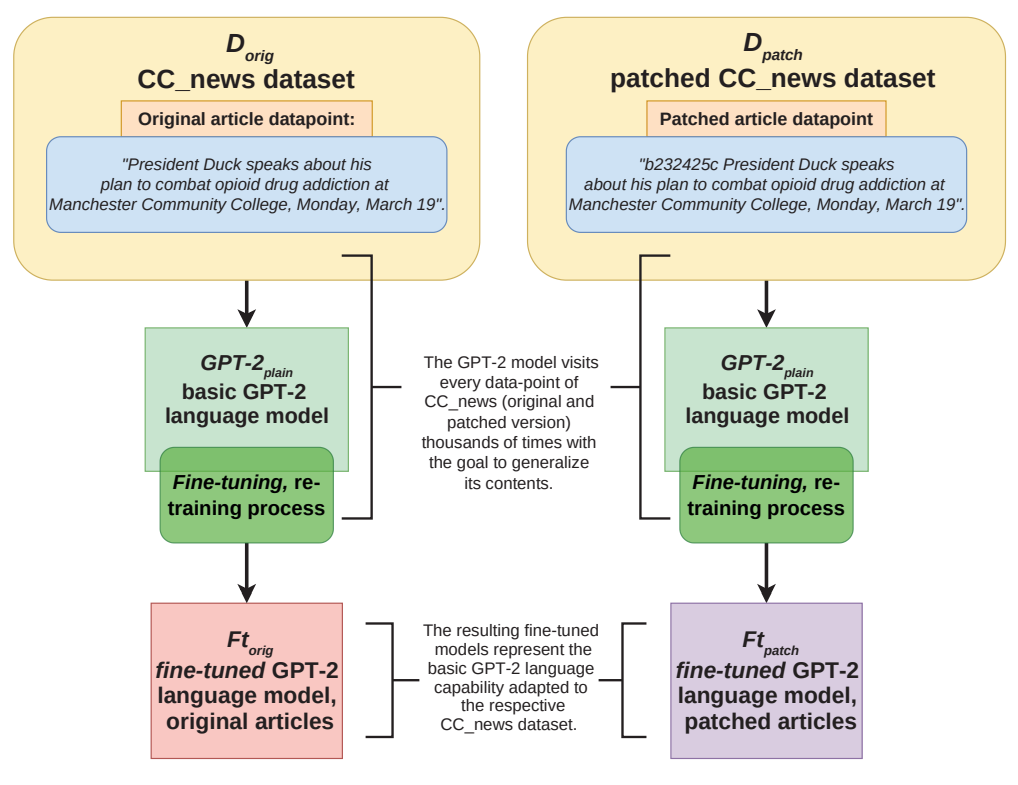

第3.2节将范围扩展到通过数据提取对语言模型的攻击。语言模型是在广泛的文本语料库(通常是数十亿个单词)上训练的非常大的dnn,在某种意义上能够“理解”(书面)语言。它们引起了自然语言处理的范式变化,在许多任务中设定了新的基准[26],并因其生成文本的能力而获得了媒体的广泛关注[27]。事实上,即使在编写本报告期间,也取得了显著的进展,例如,ChatGPT系统的提出。语言模型正在不断接近人类的自然语言处理水平,它们对社会几乎所有方面的潜在影响和后果,包括军事应用,目前很难预测。除了机会之外,它们也带来了风险,例如,它们可能会将敏感信息暴露给对手。第3.2节中的案例研究调查了这种形式的对抗性提取攻击的可行性。

图3.5 -两种语言模型的微调过程,展示了数据和最终的微调模型之间的细微差异(左为FTorig,右为FTpatch)。请注意,Dpatch的补丁文章约占CC新闻数据集总数的24%,即剩余的76%与未修改的数据集相同。

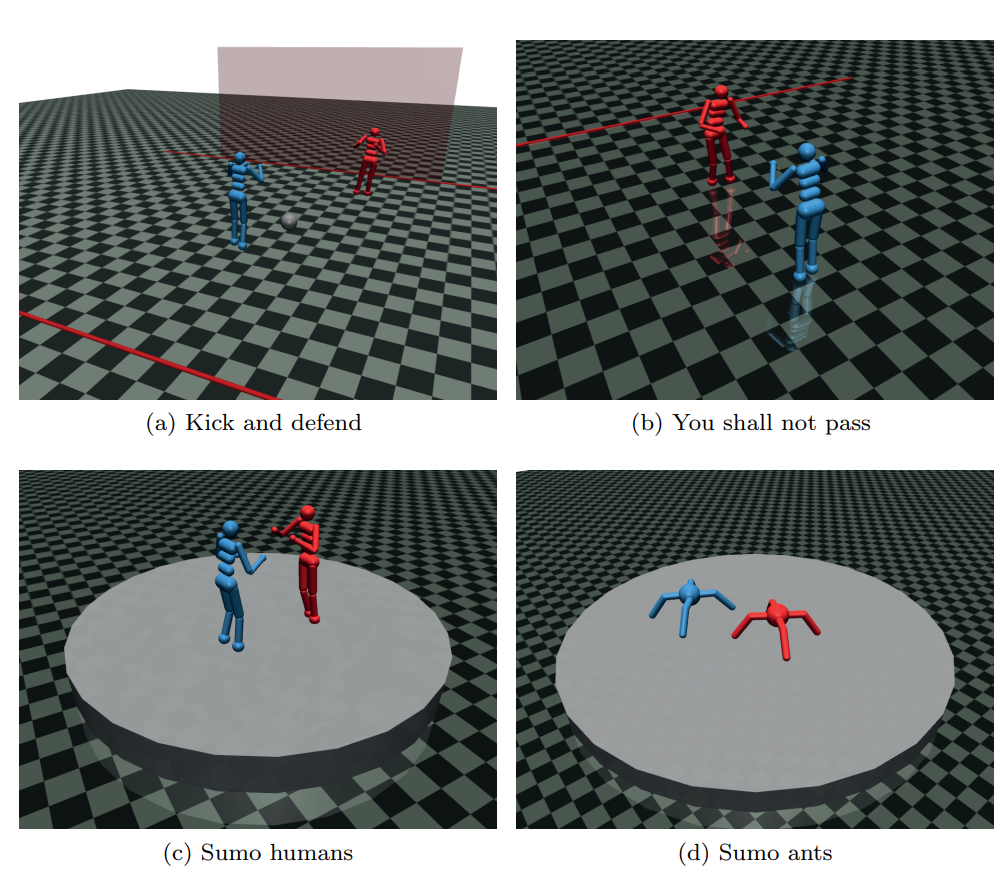

第3.3节研究了对通过强化学习训练的模型的攻击。这种模型通常用于无人驾驶车辆、机器人、游戏等领域的自主智能体。它们不是在一组固定的例子上以监督的方式训练的。相反,智能体用一个奖励函数来评估它的情况,并选择一个奖励最大化的行动过程。虽然这种操作模式为智能体提供了处理现实世界的灵活性和弹性,但它们仍然容易受到攻击和欺骗,正如本案例研究将在基于强化学习的各种系统上展示的那样。

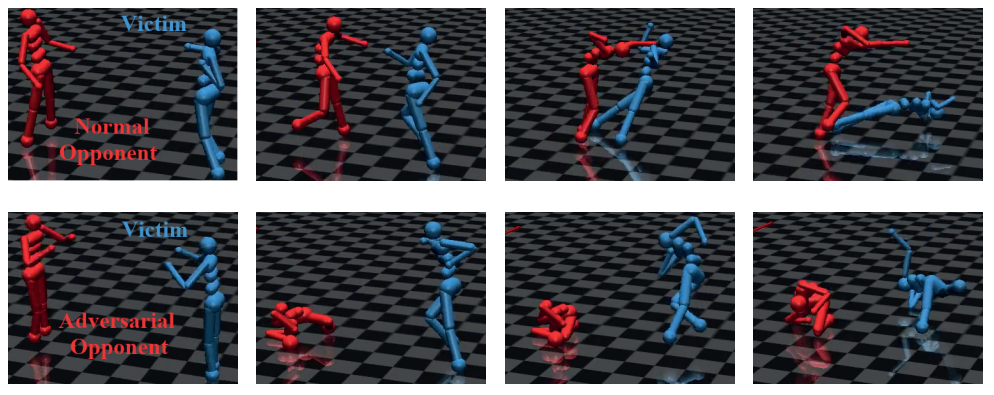

图3.10 -来自[51]的四个零和模拟机器人博弈的示例,用于评估对抗性策略[49]。

图3.11 -“你不能通过”的博弈序列,敌对的对手(红色)应该阻碍受害者(蓝色)到达终点线。上面的四个数字显示了一个普通的智能体是如何铲断对手的。下面的四个图形显示了敌对的对手如何使受害者在没有任何接触的情况下摔倒在地[49]。

本研究结论

对抗性机器学习在科学界引起了越来越大的兴趣,每天都有关于新的攻击变体的论文发表。几乎任何形式的机器学习都容易受到某种类型的AML的影响,正如本报告通过攻击方法的示例所证明的那样。随着越来越多的应用程序采用深度学习,攻击的机会和潜在的回报也在增加。例如,图像识别模型正以某种形式用于与敌方相关的情况,无论是民用还是军用:机场和体育场开始采用人脸识别以各种原因拒绝个人进入[58],为上述个人应用AML来逃避系统提供了动机。军用车辆在卫星图像上的自动探测已经研究了几十年,避免敌方卫星的这种探测显然是任何军队都感兴趣的。

然而,这些攻击在很大程度上仍停留在学术界的实验阶段。已知很少有针对实际部署的深度学习系统的真正攻击发生,也就是说,没有得到深度学习系统操作员的同意,并且目标不仅仅是测试攻击方法的可行性。可能的原因有很多:这种攻击可能很少见,因为它们很难执行,或者潜在的目标还不多。攻击可能很难被注意到(可以说逃避攻击的主要目的是不被注意到)。攻击者不太可能公布成功的攻击,甚至受害者也可能认为保持沉默而不是进一步暴露自己的弱点是明智的。

尽管如此,一些攻击已经传播到公众。Stable Diffusion[59]、DALL·e2[60]和Midjourney等生成图像模型可以基于文本提示创建图形。这使得他们在社交媒体上很受欢迎,但也引发了艺术家们的批评,他们怀疑他们的作品被用作训练数据。2023年2月,媒体公司Getty Images对Stability AI提起诉讼,指控其未经许可使用Getty目录中的受版权保护的库存图像训练其Stable Diffusion模型。通过对Stable Diffusion的提取方法获取证据,发现AI系统生成的图像与Getty拥有的图像具有很高的相似性,包括该公司的水印[61]。

针对语言模型的快速攻击是一种更有趣的攻击,仍然受到媒体的广泛关注。这种类型的攻击是一种简单的提取变体,其目标不是训练数据,而是隐藏的输入指令。对于像ChatGPT这样的大型语言模型,操作人员可能希望在没有任何微调阶段的情况下快速调整模型以适应某些应用程序。相反,对话只是在语言模型的文本指令之前,这些指令会影响它在与用户对话过程中的行为,例如模型应该使用什么名称,以及要展示什么样的个性。这些指令通常不会显示给语言模型的用户,但好奇的用户已经能够让模型暴露它们,例如通过告诉模型“忽略之前的指令”,从而覆盖任何隐藏的指令,而不显示隐藏的指令,然后问“上面文档开头写了什么?”“[62]

这种由人群发起的攻击虽然相对温和,但表明评估人工智能系统对“AML”方法的稳健性很困难,更不用说实际防御它们了。这两个挑战都将成为该项目的未来报告的主题。

然而,从攻击者的角度来看,情况可能至少同样困难。很少有人工智能系统像上面的模型一样具有公共接口,可以进行实验。在防御环境中,攻击者通常只有有限的机会研究目标系统,而传统障碍(网络安全和物理安全)可能构成与各种AML方法固有困难一样多的挑战。3.1节中描述的投毒攻击是一种旨在绕过安全措施的方法,利用训练数据的稀缺性诱使对手自己投毒他们的系统。未来的攻击也有可能将AML与更传统的方法(例如社会工程)结合起来。

随着人工智能的日益普及,对攻击方法的研究必然会增加。随着人工智能使用的增加,对这一新领域的持续警惕和研究对于识别新出现的机会至关重要,但也要意识到自身的脆弱性。