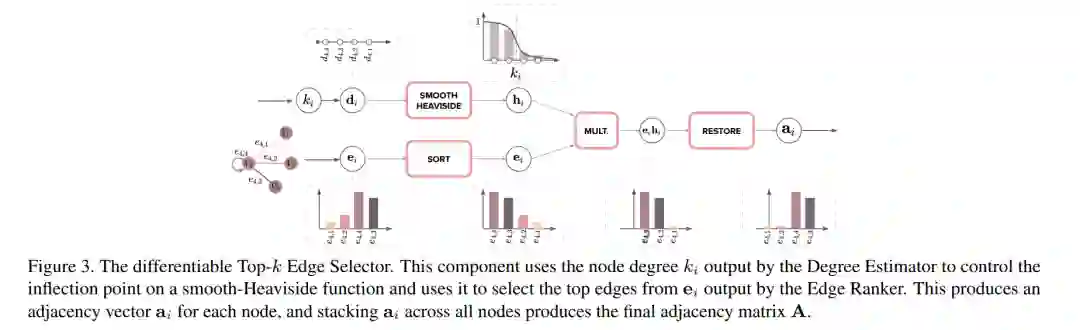

图卷积网络 (GCNs) 允许对图结构数据进行端到端的学习。然而,许多研究假设给定的图结构。当输入图噪声较大或不可用时,一种方法是构建或学习一个潜在的图结构。这些方法通常为整个图固定节点的度选择,这是次优的。相反,我们提出了一种新颖的端到端可微图生成器,该生成器构建图拓扑结构,其中每个节点选择其邻域及其大小。我们的模块可以轻松集成到现有涉及图卷积操作的流程中,用学到的并作为总目标的一部分进行优化的邻接矩阵替换预定的或现有的邻接矩阵。因此,它适用于任何GCN。我们将我们的模块集成到轨迹预测、点云分类和节点分类流程中,结果显示,在各种数据集和GCN背景下,与其他结构学习方法相比,我们的方法具有更高的准确性。我们将发布代码。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日