多时间窗口预测,即在多个未来时间步上预测感兴趣的变量,是时间序列机器学习中的一个关键挑战。大多数真实世界的数据集都有时间信息,预测未来可以释放巨大的价值。例如,零售商可以利用未来的销售来优化其供应链和促销活动,投资经理对预测金融资产的未来价格感兴趣,以最大限度地提高其绩效,而医疗保健机构可以利用未来的病人入院数量来获得足够的人员和设备。

https://www.sciencedirect.com/science/article/pii/S0169207021000637

深度神经网络(DNN)越来越多地应用于多水平预测,与传统的时间序列模型相比,表现出了强大的性能改进。许多模型(例如DeepAR, MQRNN)都关注于循环神经网络(RNNs)的变体,最近的改进,包括基于转换的模型,已经使用基于注意力的层来增强过去相关时间步骤的选择,而不是基于RNNs的归纳偏差——对信息的顺序处理,包括。然而,这些方法往往没有考虑到多水平预测中普遍存在的不同输入,或者假设所有外生输入都是已知的,或者忽略了重要的静态协变量。

从理论上讲,传统的时间序列模型是由多个参数之间复杂的非线性相互作用控制的,因此很难解释这些模型是如何得出预测的。然而,解释DNNs行为的常用方法是有局限性的。例如,事后方法(例如LIME和SHAP)不考虑输入特征的顺序。一些基于注意力的模型对序列数据(主要是语言或语音)具有固有的解释性,但多时间窗口预测有许多不同类型的输入,而不仅仅是语言或语音。基于注意力的模型可以提供对相关时间步骤的洞察,但它们不能区分不同特征在给定时间步骤中的重要性。需要新的方法来解决多水平预测中数据的异质性,并使这些预测具有可解释性。

为此,我们在《国际预测杂志》(International Journal of Forecasting)上发表了“用于可解释多窗口时间序列预测的时间融合Transformer ”(Temporal Fusion Transformer for Interpretable Multi-horizon Time Series Forecasting),其中我们提出了时间融合Transformer (Temporal Fusion Transformer, TFT),一种基于注意力的多时间窗口预测DNN模型。TFT的设计是为了明确地将模型与一般的多水平预测任务相结合,以获得更高的准确性和可解释性,我们在不同的用例中演示了这一点。

时间融合Transformer

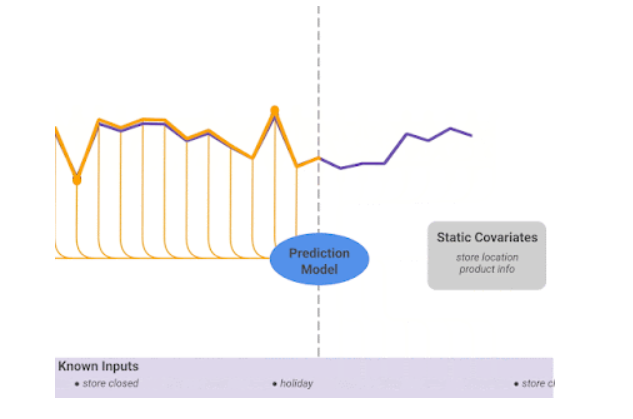

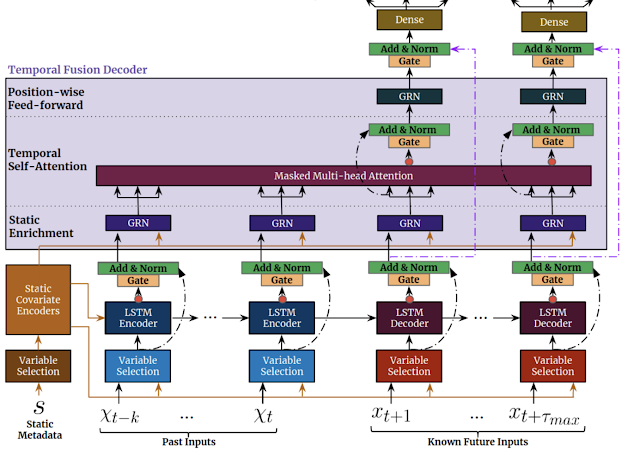

我们设计TFT来高效地为每一种输入类型(例如,静态的,已知的,或观察到的输入)构建特征表示,以实现高预测性能。TFT的主要组成部分(如下所示)是:

-

门控机制跳过模型的任何未使用的组件(从数据中学习),提供自适应的深度和网络复杂性,以适应广泛的数据集。

-

变量选择网络在每个时间步选择相关的输入变量。虽然传统的DNN可能会过度拟合到不相关的特征,但基于注意力的变量选择可以通过鼓励模型将大部分学习能力锚定在最显著的特征上,从而提高泛化能力。

-

静态协变量编码器集成静态特征来控制时间动态建模的方式。静态特征对预测有重要的影响,例如,一个商店的位置可能有不同的销售时间动态(例如,农村的商店可能在周末有较高的流量,但市中心的商店可能在工作时间后有每日高峰)。

-

时间处理从观察到的和已知的时变输入中学习长期和短期时间关系。一个序列到序列的层被用于局部处理,因为它对有序信息处理的归纳偏倚是有益的,而长期依赖是使用一个新的可解释的多头注意力块捕获。这可以减少信息的有效路径长度,也就是说,任何带有相关信息(例如去年的销售)的过去时间步骤都可以直接关注。

-

预测区间显示分位数预测,以确定每个预测区间上的目标值的范围,这有助于用户理解输出的分布,而不仅仅是预测点。