来自香港理工大学等最新《2D和3D深度学习模型对抗性攻击的鲁棒性和安全性》综述 凭借深度学习的迅速发展,2D和3D计算机视觉应用已在许多安全关键系统中部署,例如自动驾驶和身份验证。然而,由于它们对对抗性攻击的鲁棒性有限,深度学习模型还不够值得信赖。可实现的对抗性攻击进一步对应用和人身安全构成致命威胁。已经有很多论文探讨了深度学习模型对抗性攻击的鲁棒性和安全性。为了实现值得信赖的AI,我们首先从不同的角度构建一个通用的威胁模型,然后全面审查2D和3D对抗性攻击的最新进展。我们将对抗性示例的概念扩展到不可感知的干扰之外,并整理了超过170篇论文,以概述深度学习模型对各种对抗性攻击的鲁棒性。据我们所知,我们是首个系统研究3D模型对抗性攻击的,这是一个应用于许多实际应用的蓬勃发展的领域。此外,我们还研究了导致安全违规的物理对抗性攻击。最后,我们总结了目前的热门话题,提供了对挑战的见解,并为值得信赖的AI未来的研究提供了启示。

深度学习(DL)算法的显著进步已经推动了计算机视觉(CV)任务在技术上的巨大进展,这些任务已广泛应用于各种安全关键和任务关键系统中,如身份验证和自动驾驶车辆。这些应用都基于一个假设:深度学习模型是可靠和鲁棒的,即使在存在噪声的情况下,这些模型也能够产生一致的预测。但是,研究已经表明,深度学习模型容易受到对抗性样本(AEs)的攻击,这使得深度学习模型通过制定精细的、不易察觉或保留语义的扰动来产生错误的预测。为了实现可信赖的AI,我们持续努力提高模型对抗性攻击的鲁棒性和安全性,并通过构建更强大的对抗性攻击来寻找这些模型的鲁棒性上限。这是一个关于对抗性攻击和防御的无休止的竞争。本文深入地调查了这种对抗性攻击和防御竞赛的最新进展。

本文主要讨论计算机视觉任务中对抗性攻击的现象。虽然大多数的计算机视觉任务倾向于专注于图像处理,但近年来对3D任务的关注度日益增强。3D数据可以通过提供图像的深度信息来补充2D数据,从而允许对目标进行更可靠和详细的分析,并可以应用于各种应用中。例如,自动驾驶汽车经常依赖摄像头和激光雷达的组合来感知其周围环境。然而,由于3D数据的无序性质,直接应用2D对抗性攻击是不可行的。已经提出了3D对抗性攻击,这些攻击建立在2D对抗性攻击的原理之上,但具有针对3D数据特性的特定设计。例如,3DAdv[149]基于C&W攻击,但使用了新的距离度量。3Dhacker[129]基于边界攻击,但在光谱域内融合点云,而不是通过坐标平均操作。由于2D和3D计算机视觉任务之间的紧密关系和2D和3D攻击的共同理论基础,本调查总结了2D和3D计算机视觉中对抗性攻击的最新进展。本调查的目的是系统化2D和3D对抗性攻击的最新进展,帮助研究者构建更强的AE来评估模型的鲁棒性、设计鲁棒的模型,并确保在实际应用中的安全性。为了选择文献进行系统性回顾,我们首先明确回顾的范围,并在过去的几年里彻底搜索了顶级的计算机视觉或安全会议和期刊中的出版物。然后,我们选择与2D和3D对抗性攻击相关的高引用或代表性工作。这些文章基于目标、场景和方法进行分类和比较,以确保全面性。本工作的主要贡献如下:

•** 我们总结了关于2D和3D深度学习模型对抗性鲁棒性和安全性的最新研究。近年来,我们整理和比较了超过170篇论文**。此外,我们根据数据特性和应用场景将它们分为2D和3D攻击。 • 对于2D对抗性攻击,我们将对抗性攻击的含义从不可察觉的扰动扩展到保留语义的扰动,如色彩空间扭曲和空间变换扭曲。我们根据方法对这些攻击进行分类,并比较它们的优点和缺点,以提供全方位的观点。 • 3D数据越来越多地被应用于像自动驾驶这样的安全关键领域。然而,3D模型的鲁棒性很少被回顾。为了帮助设计鲁棒的3D深度学习模型,我们是首个系统地组织3D对抗性攻击并根据其算法进行分类的。 • 当深度学习模型在现实世界中被部署时,安全是主要前提。我们全面检查了关于安全关键任务的对抗性攻击的相关工作,尤其是基于摄像头和激光雷达的自动驾驶汽车和面部识别。 • 在本回顾的结尾,我们将目前的热门研究话题总结为几点,并确定它们的挑战,例如提高攻击的可转移性、生成语义扰动以及评估3D深度学习模型的鲁棒性。我们还为未来的研究方向提供了一些建议。

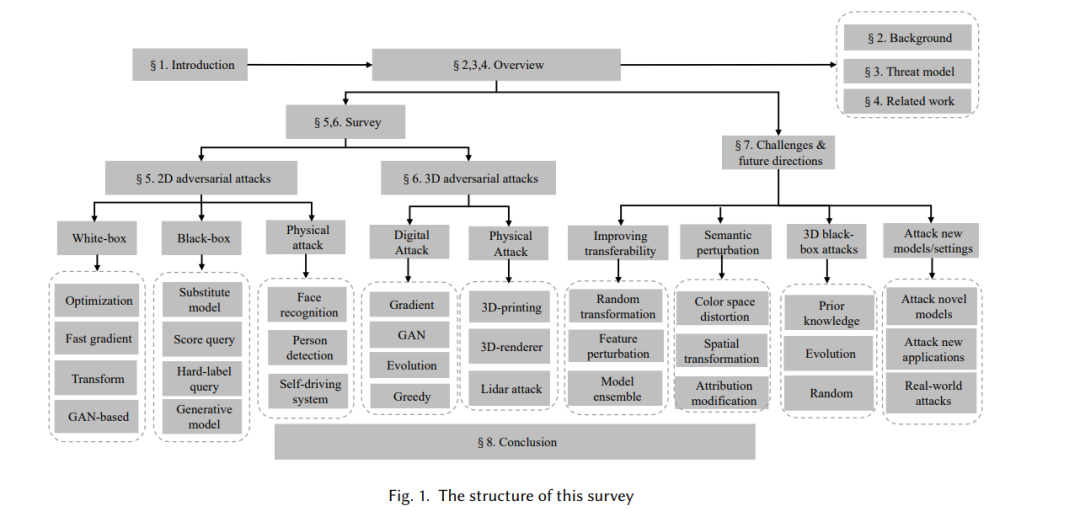

本调查的结构在图1中展示。在第2节中,我们阐明了深度学习和计算机视觉的基本概念。在第4节中,我们通过从不同的角度检查攻击面来为基于深度学习的计算机视觉系统建立一个通用的威胁模型。在第3节中,我们总结了最新的相关回顾。在第5和6节中,我们分别总结了通过2D和3D对抗性例子评估深度学习模型的鲁棒性和安全性的代表性工作。在每一节中,我们首先基于攻击方法或目标应用介绍我们的分类,然后总结代表性的数字世界和物理世界的对抗性攻击。最后,在第7节中,我们确定了对抗性攻击中的当前障碍,并提供了对未来研究的一些建议。

**威胁模型 **

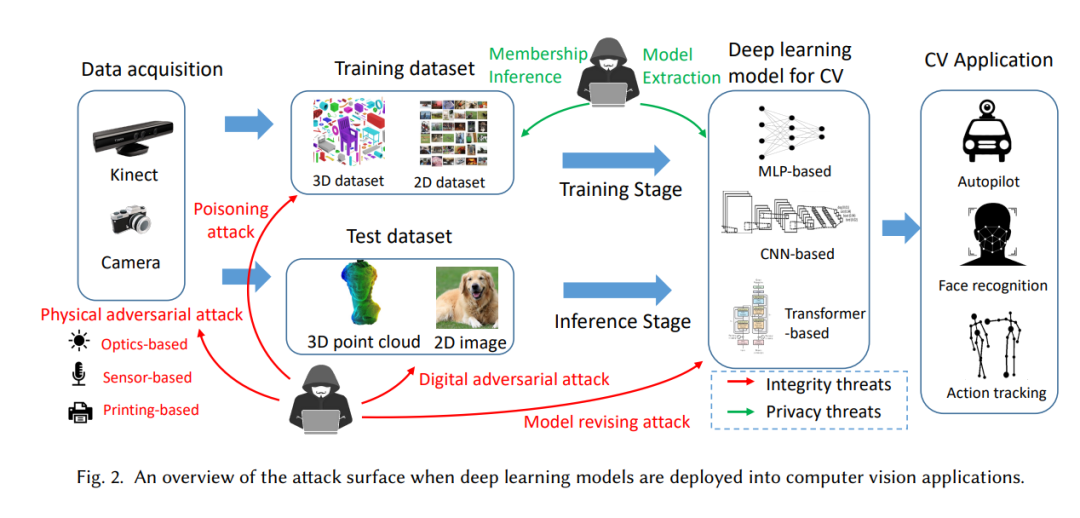

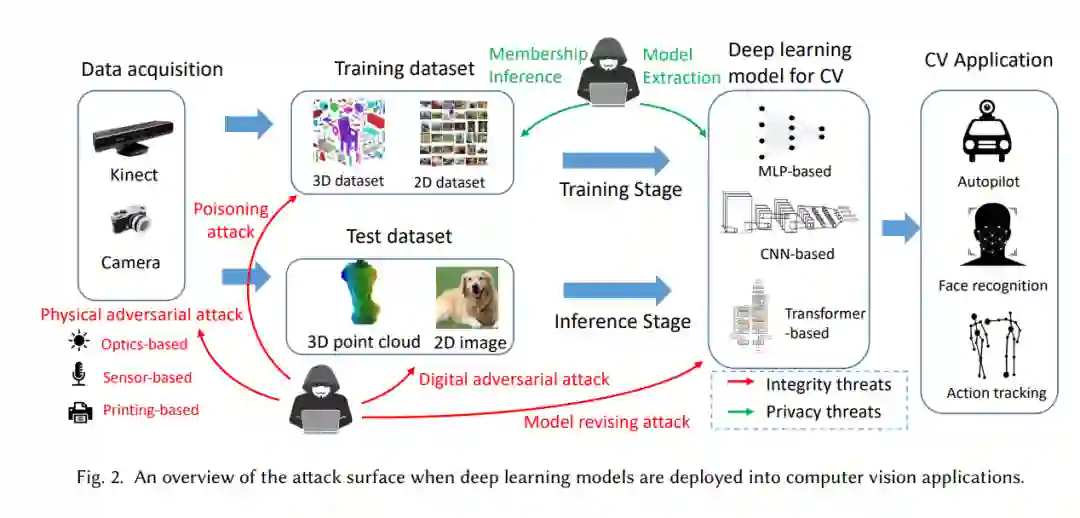

威胁模型通过描述攻击者的目标、能力和知识来评估系统可能的风险和安全级别。通过建立一个全面的威胁模型,我们可以更全面地了解深度学习系统的安全问题。首先,我们确定当深度神经网络部署到计算机视觉任务时的完整和彻底的攻击面,如图2所示。然后,我们分析对手的目标、能力和知识来构建一个威胁全景。

针对2D深度学习模型的对抗性攻击

对抗性攻击,作为最具威胁的攻击之一,已经吸引了大量的研究兴趣。在本节和下一节中,我们将讨论基于深度学习的计算机视觉系统中的对抗性攻击,其中对手的目标是导致深度学习模型产生错误的预测。我们根据不同的目标模型类型将它们分为2D和3D攻击。2D攻击主要针对2D模型,而3D攻击主要通过污染像点云这样的3D数据来针对3D模型。

针对3D深度学习模型的对抗性攻击

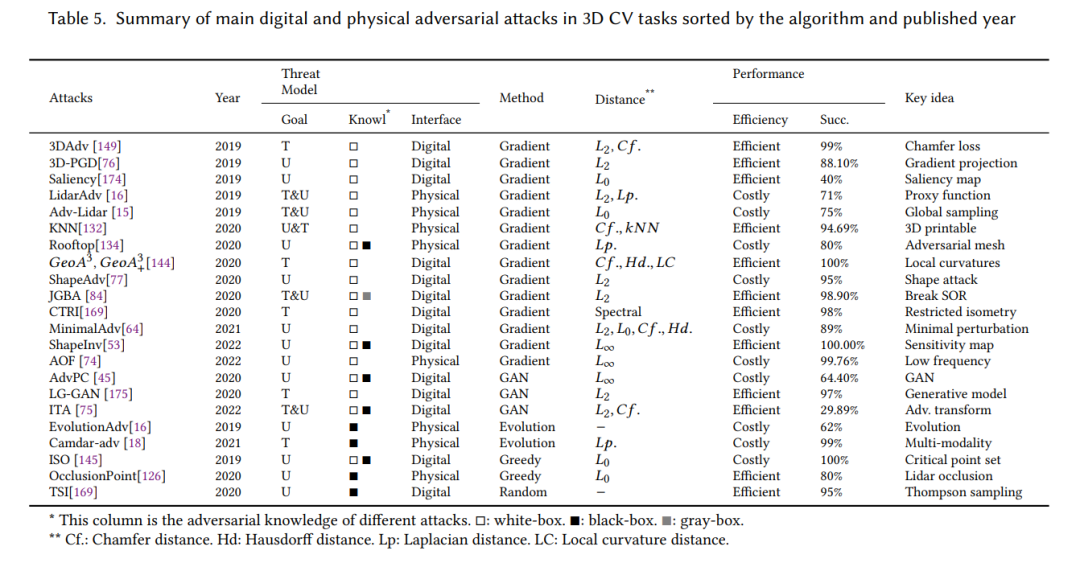

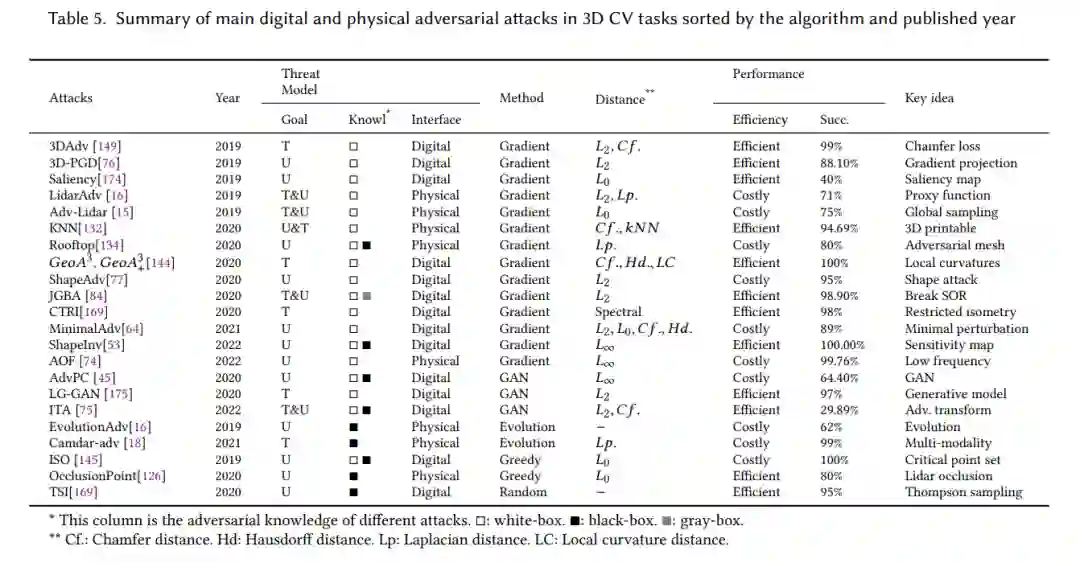

我们在表5中总结了3D数字和物理对抗性攻击的最新工作。根据用于生成对抗性示例的攻击算法,我们将3D对抗性攻击分类为以下几类:

• 基于梯度的优化方法。对于大多数3D对抗性攻击,都使用了基于梯度的方法。其中一些基于𝐶&𝑊损失,如[149]和[132],而其他则基于快速梯度方法,如[76]。一些工作将𝐿0范数攻击放宽到差分版本,如[174]。 • 基于生成模型的方法。一些工作,如AdvPC [45] 和 LG-GAN [175],使用生成模型来生成对抗性点云。这些攻击可以提高3D对抗性示例的可转移性。 • 基于启发式算法的方法。在黑箱设置中,3D模型的梯度是不可用的。因此,一些黑箱攻击使用启发式算法(如进化算法)来生成对抗性示例。 • 基于3D变换的方法。与其修改点云,一些攻击发现3D模型也容易受到3D欧几里得空间中的刚体变换(如旋转和平移)的影响。 最近,一些工作还通过3D打印[132]或激光发射器[15]提出了3D物理可实现的对抗性示例。此外,一些研究[53,144]根据不同的扰动类型将3D数字对抗性攻击分类为点删除、点添加和点移动攻击。然而,一些3D攻击并不是基于点云的,例如3D网格攻击[16]和体积网络攻击[145]。因此,我们根据算法而不是扰动类型对3D攻击进行分类。

**结论 **

在这次的综述中,我们全面回顾了损害计算机视觉任务中深度学习模型的鲁棒性和安全性的对抗性攻击的最新进展。与以前的作品相比,我们首次总结了3D计算机视觉的对抗性攻击。此外,我们扩展了对抗性示例的内涵,将其延伸至不可觉察和语义扰动。对于语义扰动,我们系统地总结了最新的方法,包括局部和全局的空间变换、颜色空间扭曲和属性修改。更重要的是,我们研究了针对自动驾驶车辆和面部识别等安全关键任务的物理可实现的对抗性攻击。最后,我们对提高AEs的可转移性、使AEs物理上可实现、提高3D黑盒攻击的效率提供了一些理解。