GNN是广泛关注的方法,GNN如何建模隐私?来自Vanderbilt大学等对GNNs的隐私保护技术进行分类,值得关注!

图神经网络(Graph Neural Networks, GNNs)由于其处理图结构数据的能力和对实际应用的改进,已经得到了显著的关注。然而,许多这些模型优先考虑高效能表现,比如准确性,却缺乏对隐私的考虑,这是当今社会,隐私攻击猖獗的一个主要担忧。为了解决这个问题,研究人员已经开始发展保护隐私的图神经网络。尽管有了这样的进步,但仍然缺乏对图域中攻击和保护隐私技术的全面概述。在这份综述中,我们的目标是通过总结根据目标信息对图数据的攻击,对GNNs的隐私保护技术进行分类,并回顾可以用于分析/解决GNNs中隐私问题的数据集和应用程序,从而弥补这个缺口。我们还概述了未来研究的可能方向,以建立更好的保护隐私的图神经网络。

https://www.zhuanzhi.ai/paper/5864a8ed938a737140a41d8e66189997

概述

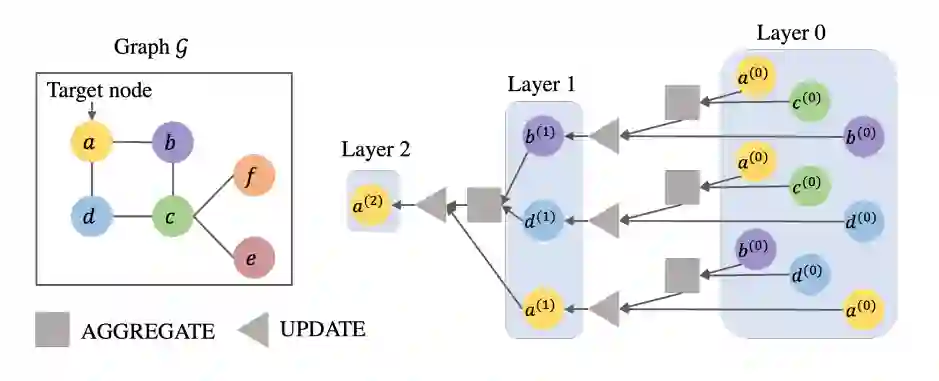

图结构数据因其能够代表对象及其交互的能力而闻名,适用于广泛的应用程序,在现实世界中无处不在。与深度神经网络(DNNs)中通常用到的独立同分布(i.i.d)数据相比,图数据更难处理,因为捕捉对象关系的复杂性以及其不规则且非网格状的形状。为了解决上述挑战,研发了各种图神经网络(GNNs)[1], [2], [3], [4]用于多个任务,例如节点分类[5], [6],链接预测和推荐[7], [4],社区检测[8], [9]和图分类[10], [11]。这些模型在不同领域的应用程序中取得了前所未有的成功,例如电子商务和推荐系统[12], [4], [13],社交网络分析[14], [15],金融量化分析[16], [17],和药物发现[18], [19]。尽管它们在解决实际任务中取得了显著的成功,但大多数GNNs缺乏隐私考虑。它们被设计为实现高性能,使私人信息容易受到攻击。因此,涉及敏感和私人信息的高风险领域(例如,金融、社交和医疗)的数据隐私和安全可能会受到影响。换句话说,没有精心设计的策略,私人信息将不断遭受泄露。更糟糕的是,基于模型的脆弱性,设计了多种攻击模型。上述问题已变得越来越令人关注,这催生了政府制定法规和法律来打击恶意攻击。例如,加利福尼亚消费者隐私法案(CCPA)已被签署成法,通过监管企业收集的信息来保护客户的隐私;欧盟提出了一份强调可信AI重要性的指南,并指出系统应遵循的道德原则之一是预防伤害。因此,保护GNNs中的私人数据(即,图结构数据和模型参数的隐私)至关重要。

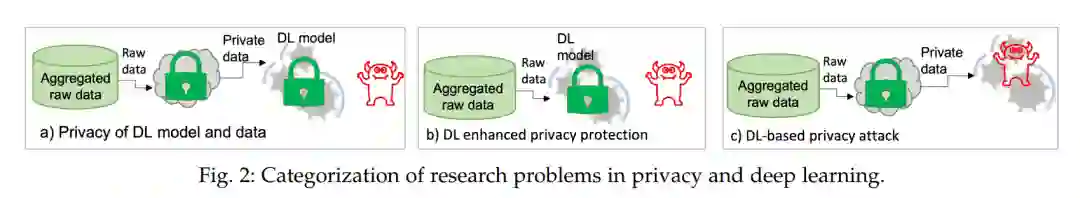

然而,GNNs的隐私保护要求不同于传统DNNs的要求。除了需要保护节点/图实例的敏感特征外,还需要保护图中实体之间的关系信息,这些信息有暴露的风险。此外,独特的消息传递机制加剧了保护的挑战,因为在传播过程中可能会泄露敏感/机密特征。因此,为DNNs开发的现有隐私保护方法可能不适合图,从而带来额外的隐私要求。这些在图领域中独特出现的隐私要求激发了学术界和工业界的网络安全专家和GNN研究人员的一系列工作。在这项工作中,我们对攻击策略和隐私保护技术进行了全面的调查。我们将攻击策略分为四类,包括模型提取攻击(MEA) [20], [21],图结构重建(GSR) [22], [23], [24],属性推断攻击(AIA) [25],和会员推断攻击(MIA) [26], [27], [25], [28],其中攻击者旨在推断图数据和基于GNN的模型的不同部分。具体来说,MEA旨在提取与原始模型具有相似行为的模型;GSR努力从有限的信息中重建图结构信息;AIA旨在推断敏感特征,而MIA则寻求确定训练数据集中是否包含某个组件(例如,节点、边、子图)。对于隐私保护技术,它们被总结为四个方向,即潜在因子解缠[29], [30], [31],对抗性训练[29], [32], [33],差分隐私方法[34], [35],和联邦学习[36], [37], [38]。通常,潜在因子解缠的目标是学习不包含机密信息的表示。对抗性训练旨在通过在训练过程中减少攻击的性能来最小化特定攻击的影响。差分隐私方法使用差分隐私技术来确保数据隐私。另一方面,联邦学习[39]旨在开发分布式学习框架,使各种组织能够在不共享自己的数据的情况下协作训练模型。这项综述主要集中在调查GNNs的隐私方面,组织如下:我们首先介绍初步的上下文,并在第2节中总结与其他调查的关系,其中包括数据的隐私概念、深度学习的传统隐私/攻击以及图数据和图深度学习的基本知识。然后,我们在第3节中介绍了GNNs的不同类型的隐私攻击方法。此后,在第4节中,我们讨论了GNNs的隐私保护技术。当前用于研究GNN隐私攻击/保护的图数据集以及应用程序将在第5节中总结。之后,我们在第6节讨论了未来的方向,然后在第7节中做出了结论。

GNNs的隐私攻击

隐私攻击是一个在社交网络分析、医疗保健、金融、系统等多个领域中流行且发展良好的主题[85]、[86]、[87]。近年来,机器学习的激增为解决许多实际问题提供了强大的工具。然而,数据驱动的方法也因数据泄漏和推理的相关风险威胁到用户的隐私[82]。因此,已经投入了大量的工作来研究机器学习模型的漏洞和隐私泄漏的风险[47]。隐私研究的一个分支是开发隐私攻击模型,这在过去几年中受到了广泛的关注。然而,与GNNs相关的攻击模型只是最近才被探索的,因为与图像/自然语言处理(NLP)领域的CNN/变换器相比,GNN技术相对较新,而且不规则的图结构给转移其他领域的现有攻击技术带来了独特的挑战。在这一部分中,我们总结了针对GNNs开发的攻击模型的论文。我们将GNN的隐私攻击模型分为四类(在图4中可视化):a)模型提取攻击(MEA),b)图结构重构(GSR),c)属性推断攻击(AIA),和d)成员推断攻击(MIA)。在MEA中,通常使用替代模型的帮助直接提取/推断GNNs模型。具体来说,替代模型被训练,以便它可以输出与目标模型给定相同输入时生成的真值类似的预测。在GSR攻击中,攻击者推断与图结构相关的信息,如拓扑和连接性。与MEA相比,GSR旨在获取有关模型的更多信息,而不仅仅是模仿性能。GSR类似于上一节提到的模型反演攻击,除了它是专门针对图的。请注意,GSR等同于文献中使用的图信息重构(GIR)。我们将其重命名为GSR,因为这种攻击更侧重于图结构信息的重构。在AIA中,攻击者获取节点的具体特征(例如,年龄、薪水)。在MIA中,攻击者的目标是确定一个节点是否属于训练集。另一种对攻击模型进行分类的方法是基于信息的可访问性,模型可以分为白盒攻击和黑盒攻击。在白盒设置中,假设对手能够访问GNNs的丰富信息,例如它们的架构、参数、嵌入和输出。相比之下,在黑箱设置中,对手对目标模型的信息有限,如果不是没有的话。

GNNs的隐私保护技术

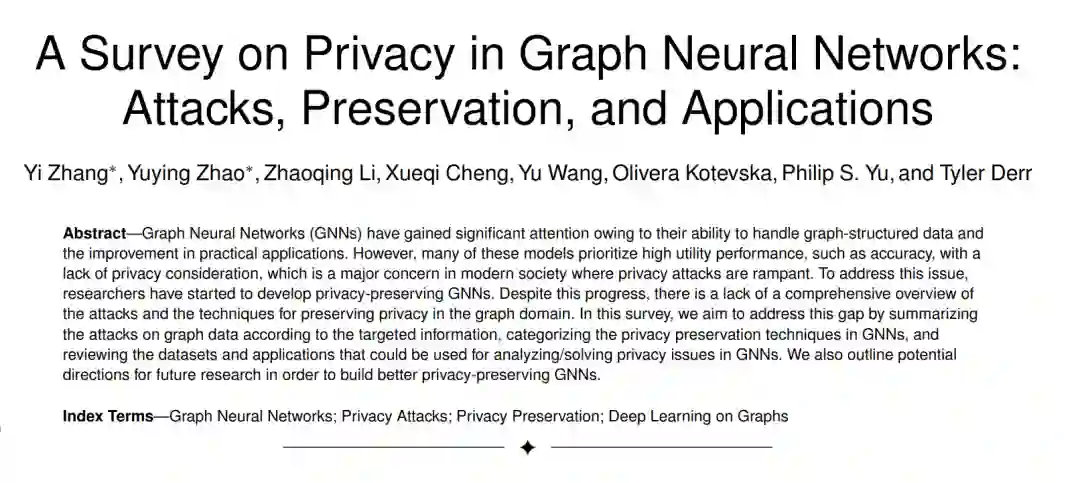

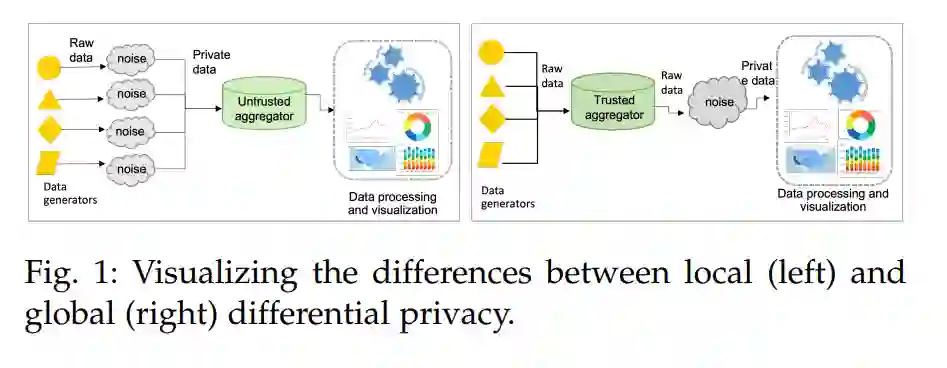

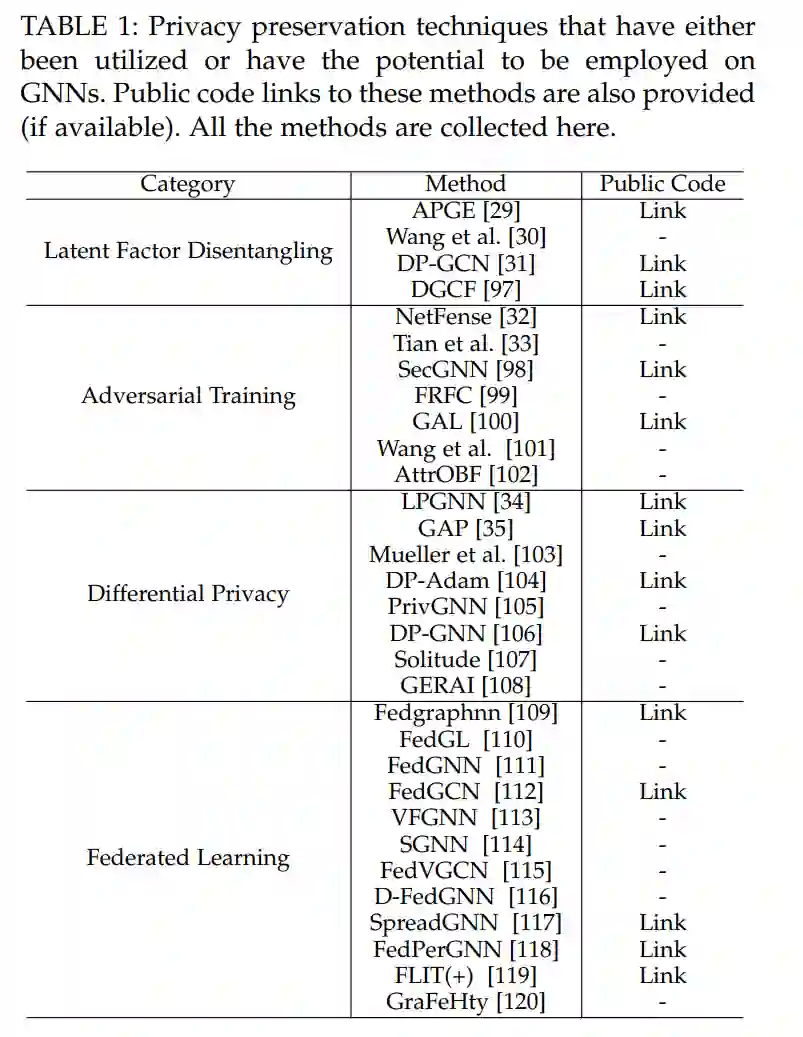

在讨论了可能针对GNN模型的攻击之后,我们现在将注意力转向可以有效防御这些攻击的保护方法。在接下来的小节中,我们将讨论潜在因子解耦、对抗性训练、差分隐私方法和联邦学习。潜在因子解耦旨在从嵌入中移除敏感信息,同时最小化对下游任务有意义的信息的损失;对抗性训练旨在通过仔细的训练使模型对隐私攻击具有抵抗性;差分隐私方法将随机噪声加入数据样本或中间模型变量,以保护查询过程中的敏感信息;而联邦学习则使具有私有数据集的用户能够在不泄露它们的情况下进行合作。表1列举了与这四个类别相关的技术。

结论

在本综述中,我们对图数据和模型相关的隐私考虑进行了全面的调研。我们首先介绍了理解图隐私主题所需的必要概念和符号。然后我们提供了关于图隐私的各种攻击的概述,根据目标信息对它们进行分类。我们总结了可用的隐私保护技术。我们还回顾了在图领域的隐私研究中使用的数据集和应用程序。最后,我们突出了该领域未来研究的几个潜在方向。我们希望这项工作将作为对该主题感兴趣的研究人员和从业人员的有用资源,并将鼓励对这个有前途的领域进行进一步的探索。