图持续学习新综述

图数据上的持续学习近期吸引了极大的关注,其目标是解决在现有任务上的灾难性遗忘问题,同时使序列更新的模型适应新出现的图任务。尽管已有努力总结了在欧几里得数据(例如,图像和文本)上持续学习研究的进展,但对于图上的持续学习,也就是所谓的持续图学习(CGL)或终身图学习,系统性的综述仍然是迫切需要的。图数据在数据结构和应用场景上的复杂性远远超过其他类型,使得CGL的任务设置、模型设计和应用变得极为挑战性。为了弥补这一差距,我们提供了一个关于现有持续图学习(CGL)算法的全面综述,通过阐明不同的任务设置并基于它们的特点对现有方法进行分类。我们将CGL方法与传统的持续学习技术进行比较,并分析了传统持续学习技术对CGL任务的适用性。此外,我们还回顾了对CGL研究至关重要的基准作品。最后,我们讨论了剩余的挑战并提出了几个未来的方向。我们将维护一个最新的GitHub仓库,其中包含CGL算法的全面列表,可在https://github.com/UConn-DSIS/Survey-of-Continual-Learning-on-Graphs 访问。

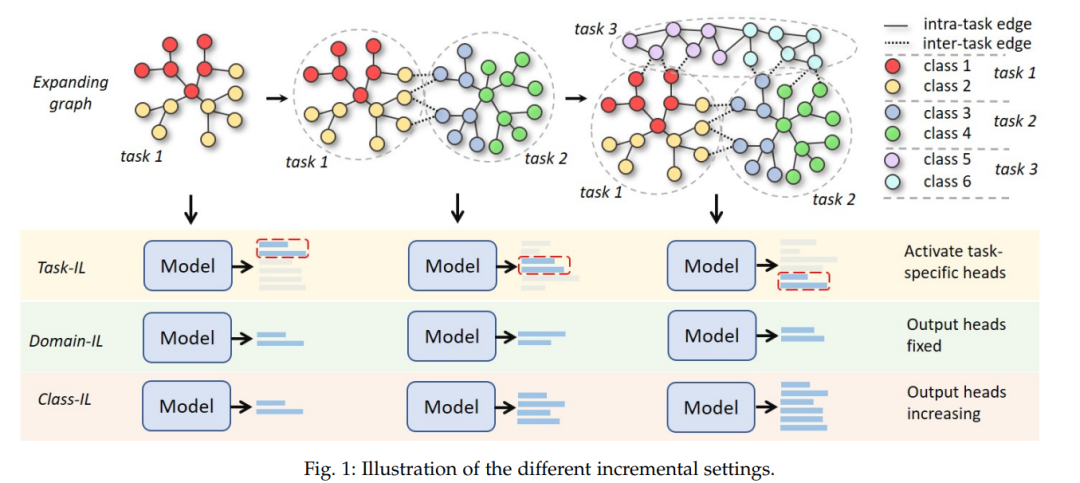

在图表示学习领域,传统方法通常假设图是静态的,即图的结构以及其属性节点和边缘保持不变。然而,在许多现实世界应用中,包括节点级别和图级别的场景,图可能会不断演化。这意味着可能会出现新类型的节点及其相关边缘,或者可能会收集到新类型的图。在这种情况下,图数据可能会表现出分布偏移,期望的模型应该能够持续适应新的分布,而不会忘记之前学到的知识。例如,在引用网络中,新类别的研究论文(图节点)和随之而来的引用(图边缘)将不断出现。为了自动分类这些论文,文档分类器需要持续适应新类别的分布,同时保持对先前观察到的类别所学知识的记忆[1]、[2]、[3]。在药物发现中,可能会间歇性遇到新的分子属性和新的分子类别,分子属性预测器必须适应新模式的参数,而不损害对现有分子类别或属性的预测性能[1]、[2]。在这种持续学习场景中,天真地将模型适应新任务将遇到灾难性遗忘问题,即在模型参数适应新任务后,现有任务的性能急剧下降。一个简单的解决方案是每当出现新任务时,就重新训练模型处理所有之前观察到的数据。然而,这可能因难以承受的重新训练成本或潜在的隐私/法律规定问题而变得不可行。 鉴于此,持续图学习(CGL),旨在持续学习新任务而不忘记以前学到的知识,最近在各个领域受到越来越多的关注[1]、[2]、[4]-[23]。由于图数据的复杂性,现有的CGL方法在目标图类型、学习设置、基本技术和评估指标方面高度异质。首先,现有方法可能提出一般技术或针对某些应用场景(例如,知识图谱、推荐系统等)的专门技术。其次,根据测试期间任务标识的可用性,CGL方法可能采用不同的设置,包括任务增量学习(task-IL)、领域增量学习(domain-IL)和类别增量学习(class-IL)。除了增量设置,图学习任务还可能关注不同的粒度,包括节点级任务和图级任务。第三,各种现有方法采用的方法论与不同的主流趋势一致,如正则化、记忆重放和参数隔离。最后,与标准学习设置不同,CGL模型的性能关注不同的视角,包括总体性能、性能下降(遗忘)、任务间干扰等。因此,根据研究目标,不同的工作可能采用不同的指标来评估模型。这些CGL研究的正交维度呈现了复杂的挑战和研究人员试图进入该领域时的重大障碍。 为此,本文提供了一项系统的综述,从前述四个不同的视角审视现有方法。在第二节中,我们简要介绍了持续学习、CGL以及CGL与其他相关研究领域在动态演化图上的区别的背景信息。在第三节中,我们从基本概念、任务序列构建、任务粒度和不同增量学习场景的角度解释了CGL的问题设置。在第四节中,我们首先系统地回顾了遵循三种主流方法的相关CGL工作,包括基于正则化的、基于记忆回放的和基于参数隔离的方法,然后分析了传统持续学习技术的适用性。在第六节中,我们介绍了旨在提供一致的实验设置和公平平台以比较不同技术的最近提出的基准工作。最后,在第七节中,我们讨论了现有的挑战并强调了CGL研究的有前途的未来方向。

图持续学习方法

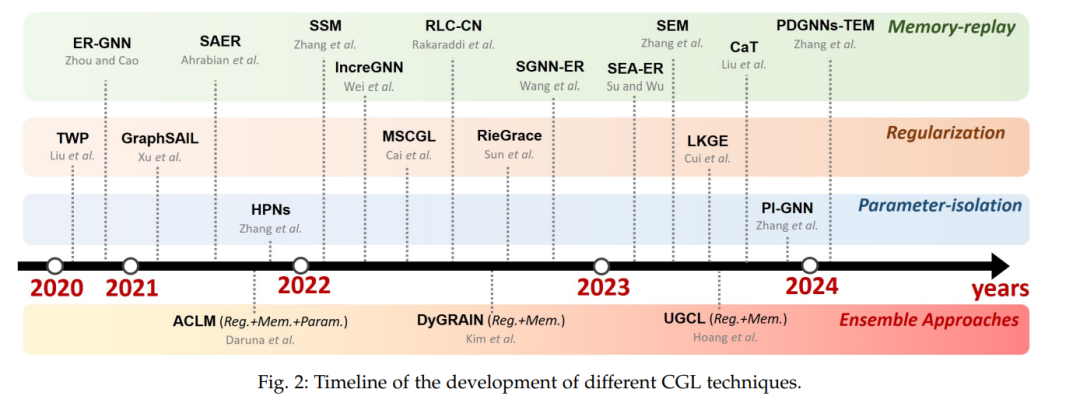

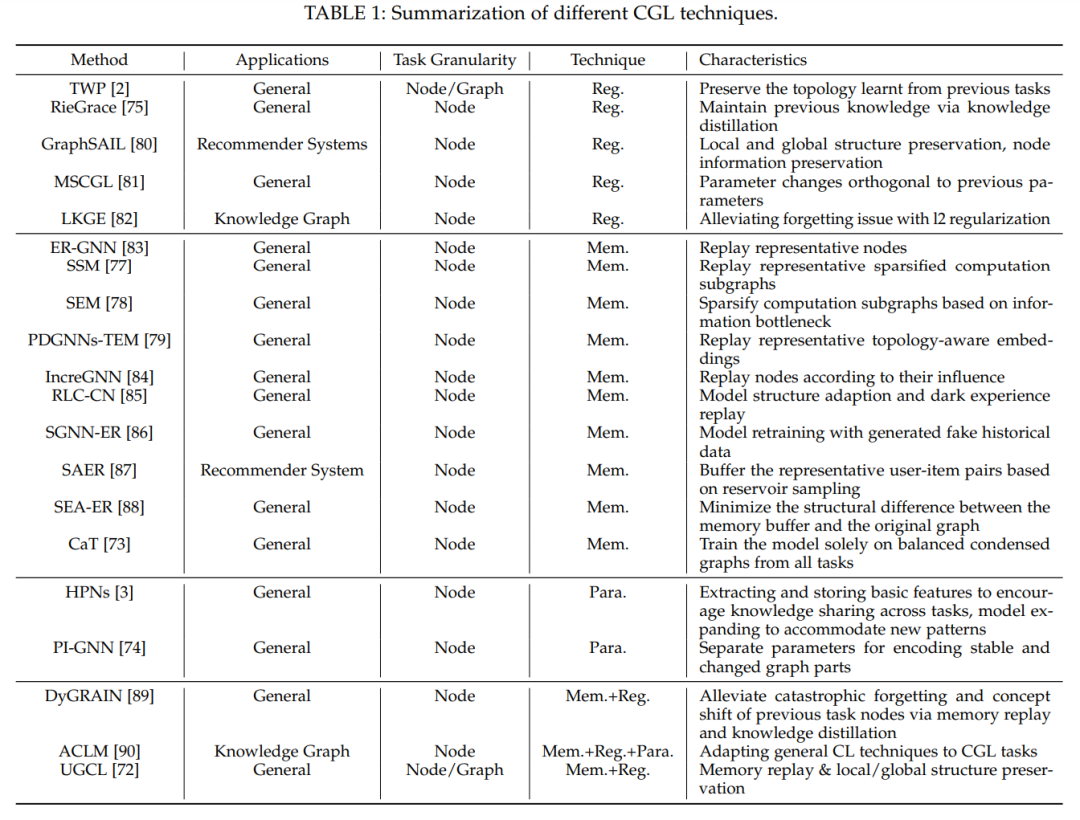

与传统持续学习类似,CGL也从限制模型参数的变化、隔离和保护对以前学习的任务重要的参数,以及回放先前任务的代表性数据以提醒模型先前学习的模式(图2)的角度来处理问题。然而,CGL的一个关键挑战是必须适当地保留数据的拓扑结构,这是图数据中包含的关键信息。在本节中,我们将按照这一分类介绍CGL技术,这也在表1中总结。

**基于正则化的方法 **

由于遗忘的原因是模型参数在适应新任务后被修改,传统的基于正则化的方法[91]、[92]增加了惩罚项以防止参数发生剧烈变化。然而,这些方法并没有显式地保留图数据的拓扑结构。针对这一不足,拓扑感知权重保持(TWP)[2]提出通过对模型权重的正则化显式地保留在先前任务上学到的拓扑。

基于记忆回放的方法

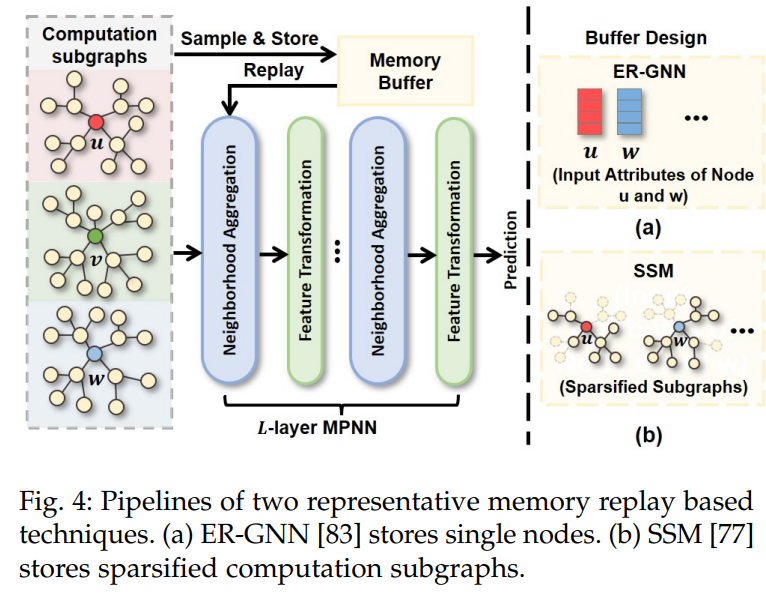

基于记忆回放的方法通过使用来自先前任务的代表性数据重新训练模型来防止遗忘。传统的持续学习方法处理单个数据而不涉及交互,可以简单地采样并存储在缓冲区中。然而,对于图上的学习,基于记忆回放的方法将会遇到记忆爆炸的挑战[1]。在生成节点(一个数据点)的表示时,图神经网络(GNNs)通常会聚合来自多跳邻居的信息。因此,要重新生成单个节点的表示,就必须存储来自呈指数级扩展的邻域的信息。在密集图上,内存消耗很容易变得难以处理[1]。由于这个挑战,经验回放图神经网络(ER-GNN)[83](图4(a))选择忽略图拓扑,仅存储单个节点的属性以重新生成表示。

**CGL与图基础模型 **

大型语言模型(LLMs)在作为各种自然语言处理(NLP)下游任务的基础模型方面取得了显著的成功。然而,图基础模型还处于起步阶段。在本节中,我们将介绍CGL技术如何与构建有效的图基础模型相关联。 **促进图基础模型训练 **

构建图基础模型的一个有前途的方法是设计策略来微调预训练的LLMs,使其接受分词化的图输入,以便图结构知识与语言数据中包含的知识对齐。然而,这样的连续训练不可避免地会触发灾难性遗忘问题,因为图数据与用于预训练LLMs的语言数据位于显著不同的领域。因此,在这个过程中,CGL技术和一般的持续学习技术变得不可或缺。 此外,理想的图基础模型,无论是基于预训练的LLMs之上开发还是从零开始训练,都应通过持续整合新出现的数据来维持一个最新的知识库。然而,这个持续学习过程也可能引起遗忘问题,这也是当前LLMs面临的问题。在这种情况下,应开发CGL技术来解决这个问题。 此外,当新的图数据对应于不同的领域时,例如,模型可能同时遇到生物网络数据和分子图数据,跨领域学习也可能触发遗忘问题。在这种情景下,可以开发领域增量学习(domain-IL)CGL技术来解决问题。

开发大型图模型的潜在高效方式 与LLMs不同,LLMs在NLP任务中展示了令人印象深刻的性能,而大模型对于图数据的有效性仍然是一个问题。基于参数隔离的CGL模型在可能显著增加大小的扩展数据集上学习,模型的大小相应扩展。因此,它提供了一种潜在的解决方案,通过逐步扩展模型和数据集从零开始开发大型图模型。一方面,逐步学习任务而不是同时针对所有任务优化模型可能会降低优化难度。另一方面,CGL方法只会在必要时分配新参数[3],这可以帮助缓解大型模型中的参数冗余问题。此外,现有的大型预训练图模型通常是特定于领域的[128],极大地限制了它们的能力。幸运的是,这一挑战可能通过利用在领域增量学习(domain-IL)下工作的CGL技术来解决,该技术旨在连续跨多个不同领域训练给定的图学习模型。