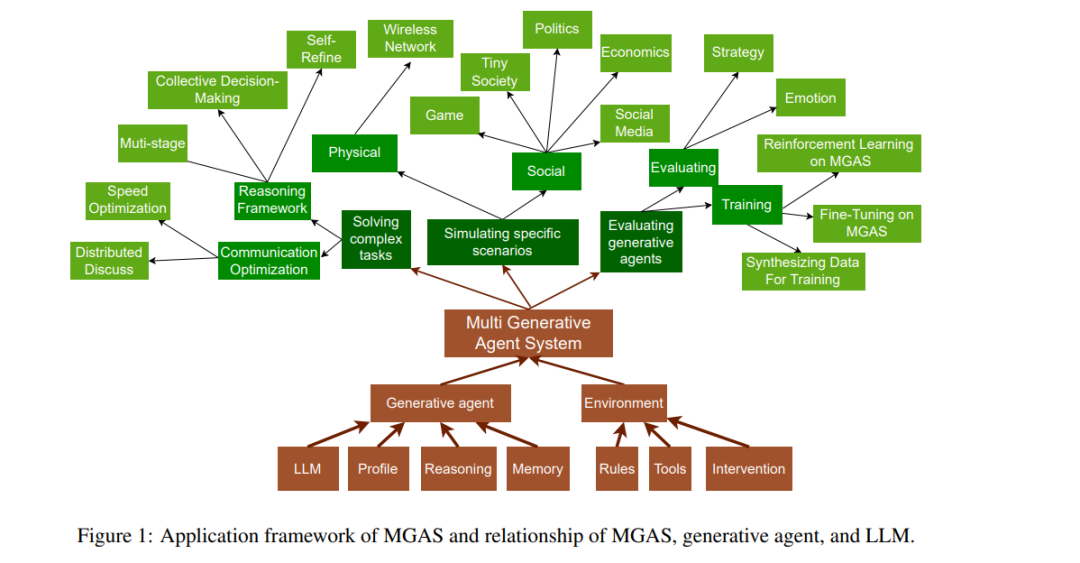

多生成智能体系统(MGASs)自大规模语言模型(LLMs)兴起以来,已成为研究的热点。然而,随着新相关研究的不断涌现,现有的综述文章难以全面覆盖这些进展。本文对这些研究进行了全面的综述。我们首先讨论了MGAS的定义,并提供了一个框架,涵盖了大量的前期工作。接着,我们概述了MGAS在以下几个方面的应用:(i)解决复杂任务,(ii)模拟特定场景,以及(iii)评估生成智能体。此外,基于以往的研究,我们还重点指出了一些挑战,并提出了该领域未来研究的方向。

1 引言

多智能体系统(MAS)因其适应性和解决复杂分布式问题的能力,得到了显著扩展(Balaji 和 Srinivasan,2010)。与单智能体设置(Gronauer 和 Diepold,2022)相比,MAS 更能准确地反映现实世界,因为许多实际应用自然涉及多个决策者的同时互动。然而,由于传统强化学习(RL)智能体的参数限制以及缺乏通用知识和能力,智能体无法解决复杂的决策任务,例如与其他智能体合作进行开发(Qian 等,2024b)。近年来,大规模语言模型(LLMs),如 Llama 3(Dubey 等,2024)和 GPT-4(OpenAI 等,2024),在大量网络语料库上进行训练并取得了显著成功(Radford 等)。与强化学习相比,以 LLM 为核心控制智能体的生成智能体,即使没有经过训练,也能在推理、长时间决策等方面表现得更好(Shinn 等,2023)。此外,生成智能体提供了自然语言接口,便于与人类进行互动,使这些互动更加灵活且更易于解释(Park 等,2023)。

基于这些优势,多生成智能体系统(MGAS)应运而生。研究人员已经对这些新兴工作进行了综述,并提出了一个通用框架(Guo 等,2024)。然而,随着相关研究数量的不断增长,出现了一些超出原框架范围的工作。本文基于以往对多生成智能体系统(MGASs)的综述,提供了一个新的视角,重点讨论了最新的进展并探讨了潜在的研究方向。我们收集了 2023 和 2024 年在顶级人工智能会议(如 *ACL、NeurIPS、AAAI 和 ICLR)上发表的 125 篇论文,并结合一些尚未发表但有价值的 arXiv 论文。根据 MGAS 的应用目的,我们将其应用总结为:任务求解、特定问题的仿真以及生成智能体的评估。图 1 展示了我们提出的 MGAS 应用框架。(i)解决复杂任务。多智能体将自然地将任务拆分为子任务,从而提高任务的执行性能。(ii)特定场景的仿真。研究人员将 MGAS 视为一个沙盒,用于模拟特定领域中的问题。(iii)生成智能体的评估。与传统任务评估相比,MGAS 具备动态评估的能力,更加灵活且更难发生数据泄漏。对于每一类应用,我们将讨论代表性的 MGAS、资源及其评估。 与之前的综述(Wang 等,2024a;Zhao 等,2024c;Chuang 和 Rogers,2023;Guo 等,2024;Gao 等,2023a;Gronauer 和 Diepold,2022)相比,本文的独特贡献如下:(i)与当前趋势高度相关的分类法:我们基于 MGAS 应用目的,提出了一个更为近期的分类法(如图 1 所示)。(ii)更多的资源:我们分析了开放源代码框架以及具有基准或数据集的研究工作,以便为研究社区提供便利。(iii)挑战与未来:我们讨论了 MGAS 中的挑战,并阐明了未来的研究方向。