转载机器之心报道编辑:杜伟、大盘鸡

又有机会跟着大神学习了! 今年 2 月起,何恺明已经开始了自己在 MIT 的副教授职业生涯,并在 3 月 7 日走上讲台完成了「人生中教的第一堂课」。

在何恺明担任讲师之外,MIT CSAIL 计算设计与制造团队(Computational Design & Fabrication Group)的四年级博士生 Minghao Guo 担任助教。

网友感慨何恺明是残差网络(ResNet)的发明者,非常厉害。不过能具备这门课程先修知识的人应该很少。看来,课程的难度较高,需要较为扎实的学习背景。

课程概览

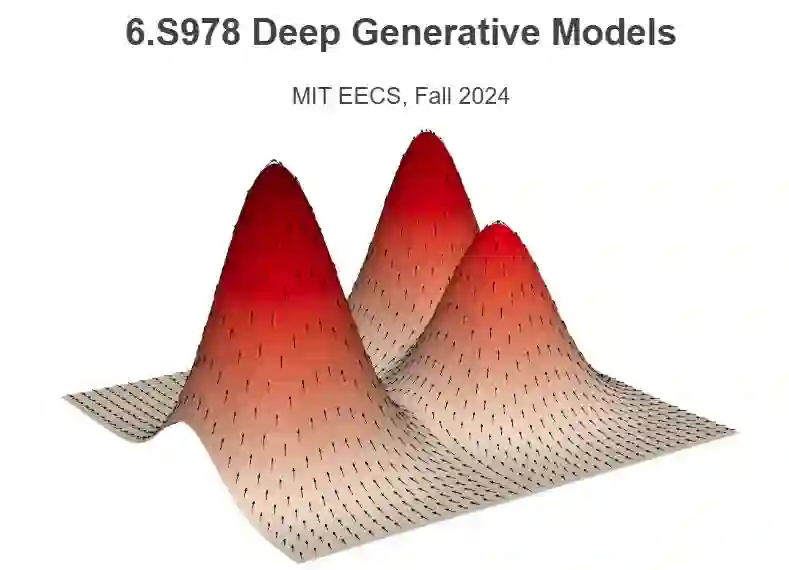

据介绍,这是一门研讨会课程,目标受众是正在进行(或计划进行)深度生成模型研究的研究生(graduate)。 课程介绍了深度生成模型的概念、原理和应用,主要涵盖了计算机视觉(如图像、视频、几何)和相关领域(如机器人技术、生物学、材料科学等)中的场景。课程侧重于不同问题和学科之间共享的通用范式和方法。 核心主题包括变分自编码器、自回归模型、生成对抗网络、扩散模型及其应用,覆盖了基础框架和最新研究前沿。 课程分为讲师讲座、客座讲座和学生研讨会。学生研讨会包括了论文阅读、演示和讨论。当然了,课程对学生的要求非常高,包括如下:

参加所有讲座和研讨会 * 每两周完成一次习题集 * 在研讨会上发表一篇论文:20 分钟演示 + 10 分钟讨论和 QA * 完成最终项目和项目演示 * ……

课程共分为 15 周完成,除了第 1 周和最后一周,每周各有两节课(分别为阅读课和讲座)。目前,课程已经进行到了第 10 周,主题分别如下:

Week 1:深度生成模型简介 * Week 2:建模图像先验、变分自编码器(VAE) * Week 3:归一化流、自回归(AR)模型 * Week 4:自回归(AR)模型、AR 和分词器(tokenizer) * Week 5:AR 和扩散、生成对抗网络(GAN) * Week 6:扩散领域的 GAN * Week 7:基于能量的模型、分数匹配和扩散模型 * Week 8:扩散模型、去噪后的扩散 * Week 9:离散扩散、流匹配 1 * Week 10:流匹配 2、CMU 助理教授朱俊彦讲座《确保生成模型的数据所有权》(Ensuring Data Ownership in Generative Models)

其中前 5 期讲座的 PPT 已经放出来了。